Microsoft AI presenta una strategia avanzata di ottimizzazione della comunicazione basata su ZeRO per un efficiente addestramento di modelli di grandi dimensioni, senza essere limitati dalle dimensioni del batch o dalla larghezza di banda.

Microsoft AI presenta una strategia avanzata di ottimizzazione della comunicazione basata su ZeRO per addestrare modelli di grandi dimensioni in modo efficiente, senza limiti di batch o larghezza di banda.

I ricercatori di Microsoft hanno introdotto un nuovo sistema chiamato ZeRO++ sviluppato per ottimizzare l’addestramento di grandi modelli di intelligenza artificiale, affrontando le sfide dell’elevato overhead di trasferimento dati e della larghezza di banda limitata. ZeRO++ si basa sulle ottimizzazioni esistenti di ZeRO e offre strategie di comunicazione migliorate per migliorare l’efficienza dell’addestramento e ridurre il tempo e il costo dell’addestramento.

L’addestramento di modelli di grandi dimensioni come Turing-NLG, ChatGPT e GPT-4 richiede risorse di memoria e di elaborazione sostanziali su più dispositivi GPU. ZeRO++, sviluppato da DeepSpeed, introduce strategie di ottimizzazione della comunicazione per superare le limitazioni di ZeRO in scenari con una piccola dimensione di batch per GPU o durante l’addestramento su cluster a bassa larghezza di banda.

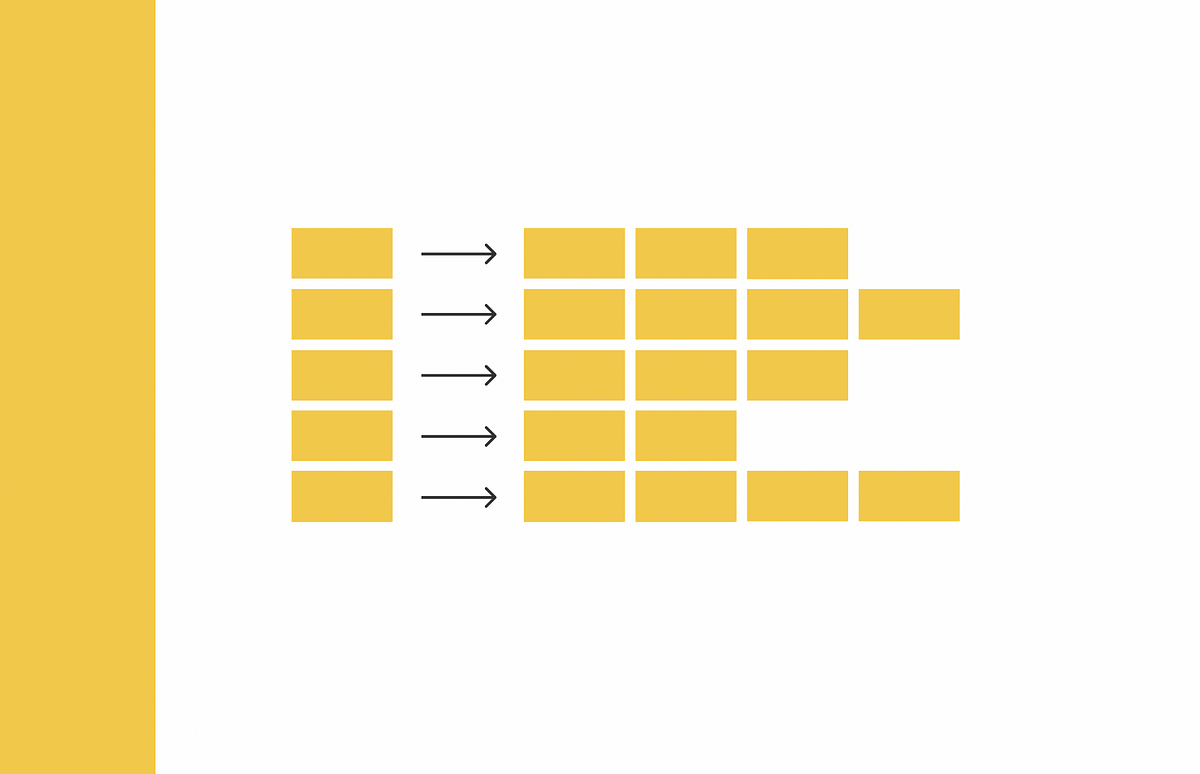

La famiglia di ottimizzazioni ZeRO, compresa ZeRO-Inference, consente la suddivisione degli stati del modello su GPU anziché la replicazione, utilizzando la memoria collettiva della GPU e la potenza di elaborazione. Tuttavia, ZeRO può comportare elevati overhead di comunicazione durante l’addestramento. ZeRO++ affronta questo problema incorporando tre insiemi di ottimizzazioni della comunicazione: la comunicazione dei pesi quantizzati (qwZ), la suddivisione gerarchica dei pesi (hpZ) e la comunicazione quantizzata dei gradienti (qgZ).

- Incontra CoDi un nuovo modello di diffusione cross-modale per la sintesi da qualsiasi sorgente a qualsiasi destinazione.

- L’AI inizia il doppiaggio per YouTube in molteplici lingue.

- Incontra vLLM Una libreria di inferenza e servizio LLM open-source che accelera HuggingFace Transformers del 24x.

Per ridurre il volume di comunicazione dei parametri, ZeRO++ utilizza la quantizzazione sui pesi, utilizzando la quantizzazione a blocchi per preservare la precisione dell’addestramento. Questo processo di quantizzazione ottimizzato è più veloce e preciso rispetto alla quantizzazione di base. Per ridurre l’overhead di comunicazione durante la propagazione all’indietro, ZeRO++ scambia la memoria GPU per la comunicazione mantenendo una copia completa del modello all’interno di ogni macchina. Per la comunicazione del gradiente, ZeRO++ introduce qgZ, un nuovo paradigma di comunicazione del gradiente quantizzato che riduce il traffico e la latenza tra i nodi.

Queste ottimizzazioni della comunicazione comportano una significativa riduzione del volume di comunicazione. ZeRO++ raggiunge una riduzione fino a 4 volte rispetto a ZeRO, migliorando la velocità e l’efficienza dell’addestramento. ZeRO++ offre un miglioramento del throughput del 28% al 36% rispetto a ZeRO-3 in cluster ad alta larghezza di banda quando si utilizzano piccole dimensioni di batch per GPU. ZeRO++ ottiene una velocità media fino a 2 volte superiore in cluster a bassa larghezza di banda rispetto a ZeRO-3, rendendo l’addestramento di modelli di grandi dimensioni più accessibile su una maggiore varietà di cluster.

ZeRO++ non è limitato a scenari di addestramento, ma si estende all’apprendimento per rinforzo dal feedback umano (RLHF) utilizzato nei modelli di dialogo. Integrando ZeRO++ con DeepSpeed-Chat, l’apprendimento RLHF può beneficiare di una migliore generazione e fasi di addestramento, ottenendo un throughput di generazione fino a 2,25 volte migliore e un throughput di addestramento fino a 1,26 volte migliore rispetto a ZeRO.

DeepSpeed ha rilasciato ZeRO++ per rendere l’addestramento di grandi modelli più efficiente e accessibile alla comunità dell’IA. Il sistema è progettato per accelerare l’addestramento, ridurre l’overhead di comunicazione e consentire batch di dimensioni maggiori, risparmiando tempo e risorse. I ricercatori e i professionisti possono sfruttare ZeRO++ per addestrare modelli come ChatGPT in modo più efficace ed esplorare nuove possibilità nell’ambito dell’IA.