Incontra CoDi un nuovo modello di diffusione cross-modale per la sintesi da qualsiasi sorgente a qualsiasi destinazione.

CoDi è un nuovo modello di sintesi che consente la diffusione cross-modale da qualsiasi sorgente a qualsiasi destinazione.

Negli ultimi anni si è assistito ad una notevole emergenza di modelli cross-modali robusti capaci di generare un tipo di informazione a partire da un altro, come la trasformazione di testo in immagini o audio. Un esempio è il notevole Stable Diffusion, che riesce a generare immagini sorprendenti da un prompt di input che descrive l’outcome atteso.

Nonostante i risultati realistici offerti, questi modelli incontrano limitazioni nella loro applicazione pratica quando molteplici modalità coesistono e interagiscono. Supponiamo di voler generare un’immagine da una descrizione di testo come “cucciolo carino che dorme su un divano di pelle”. Questo, tuttavia, non è sufficiente. Dopo aver ricevuto l’immagine di output da un modello di testo-immagine, vogliamo anche sentire come sarebbe una tale situazione con, ad esempio, il cucciolo che russa sul divano. In questo caso, avremmo bisogno di un altro modello per trasformare il testo o l’immagine risultante in un suono. Pertanto, sebbene sia possibile collegare più modelli generativi specifici in uno scenario di generazione a più fasi, questo approccio può essere complicato e lento. Inoltre, i flussi unimodali generati indipendentemente mancheranno di coerenza e allineamento quando combinati in modo post-processing, come la sincronizzazione di video e audio.

Un modello any-to-any completo e versatile potrebbe generare contemporaneamente video coerenti, audio e descrizioni di testo, migliorando l’esperienza complessiva e riducendo il tempo richiesto.

- L’AI inizia il doppiaggio per YouTube in molteplici lingue.

- Incontra vLLM Una libreria di inferenza e servizio LLM open-source che accelera HuggingFace Transformers del 24x.

- Rivoluzionare la rilevazione del cancro l’Università di Surrey lancia uno strumento di rilevamento oggetti basato su schizzi rivoluzionario nel campo del Machine Learning.

In cerca di questo obiettivo, è stato sviluppato Composable Diffusion (CoDi) per elaborare e generare contemporaneamente combinazioni arbitrarie di modalità.

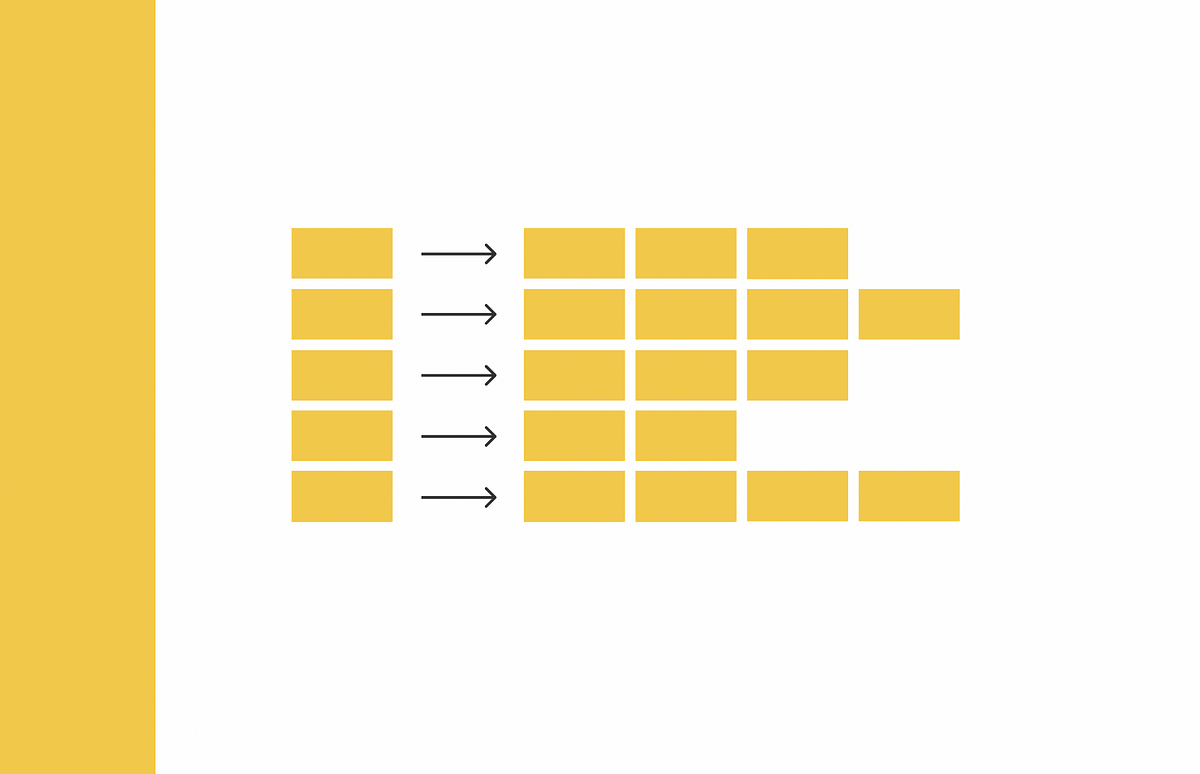

La panoramica dell’architettura è riportata qui di seguito.

Addestrare un modello per gestire qualsiasi miscela di modalità di input e generare flessibilmente varie combinazioni di output richiede significativi requisiti computazionali e di dati.

Ciò è dovuto alla crescita esponenziale delle possibili combinazioni di modalità di input e output. Inoltre, ottenere dati di addestramento allineati per molte gruppi di modalità è molto limitato e inesistente, rendendo impraticabile addestrare il modello utilizzando tutte le possibili combinazioni input-output. Per affrontare questa sfida, viene proposta una strategia per allineare molteplici modalità nella fase di condizionamento di input e diffusione di generazione. Inoltre, una strategia di “Bridging Alignment” per l’apprendimento contrastivo modella efficientemente il numero esponenziale di combinazioni input-output con un numero lineare di obiettivi di addestramento.

Per ottenere un modello in grado di generare qualsiasi combinazione e mantenere un’alta qualità di generazione, è necessario un approccio completo di progettazione e addestramento del modello, sfruttando diverse risorse di dati. I ricercatori hanno adottato un approccio integrato per la costruzione di CoDi. In primo luogo, addestrano un modello di diffusione latente (LDM) per ogni modalità, come il testo, l’immagine, il video e l’audio. Questi LDM possono essere addestrati indipendentemente e in parallelo, garantendo un’ottima qualità di generazione per ciascuna modalità individuale utilizzando i dati di addestramento specifici della modalità disponibili. Questi dati consistono di input con una o più modalità e una modalità di output.

Per la generazione condizionale cross-modalità, in cui sono coinvolti le combinazioni di modalità, come la generazione di immagini utilizzando promemoria audio e di linguaggio, le modalità di input vengono proiettate in uno spazio di funzionalità condiviso. Questo meccanismo di condizionamento multimodale prepara il modello di diffusione per condizionarsi su qualsiasi modalità o combinazione di modalità senza richiedere un addestramento diretto per impostazioni specifiche. L’LDM di output si concentra quindi sulle funzionalità di input combinate, consentendo la generazione cross-modalità. Questo approccio consente a CoDi di gestire efficacemente diverse combinazioni di modalità e generare output di alta qualità.

La seconda fase di addestramento in CoDi facilita la capacità del modello di gestire strategie di generazione many-to-many, consentendo la generazione simultanea di diverse combinazioni di modalità di output. Al meglio delle conoscenze attuali, CoDi è il primo modello AI ad avere questa capacità. Questo risultato è reso possibile dall’introduzione di un modulo di cross-attenzione per ogni diffusore e da un codificatore ambientale V, che proietta le variabili latenti da diversi LDM in uno spazio latente condiviso.

In questa fase, i parametri dell’LDM sono congelati e vengono addestrati solo i parametri di cross-attenzione e V. Poiché l’encoder di ambiente allinea le rappresentazioni di diverse modalità, un LDM può fare cross-attenzione con qualsiasi set di modalità co-generate interpolando la rappresentazione di output usando V. Questa integrazione senza soluzione di continuità consente a CoDi di generare combinazioni arbitrarie di modalità senza la necessità di addestrarsi su ogni possibile combinazione di generazione. Di conseguenza, il numero di obiettivi di addestramento si riduce da esponenziale a lineare, fornendo un’efficienza significativa nel processo di addestramento.

Di seguito vengono riportati alcuni campioni di output prodotti dal modello per ogni compito di generazione.

Questo è stato il riassunto di CoDi, un efficiente modello di generazione cross-modale per la generazione da qualsiasi a qualsiasi con una qualità all’avanguardia. Se sei interessato, puoi saperne di più su questa tecnica ai link sottostanti.