Come costruire un’intelligenza artificiale responsabile con TensorFlow?

'How to build responsible artificial intelligence with TensorFlow?'

Introduzione

L’Intelligenza Artificiale (AI) sta crescendo come mai prima d’ora, con centinaia di nuove app, funzionalità e piattaforme di AI rilasciate ogni settimana. Con il ritmo con cui si sta sviluppando l’AI, garantire che la tecnologia sia sicura è diventato sempre più importante. È qui che entra in gioco l’AI responsabile. L’AI responsabile si riferisce allo sviluppo e all’uso sostenibile dei sistemi di AI, seguendo etica, trasparenza e responsabilità. Mentre tutte le società di AI hanno le loro regole e liste di controllo per garantire ciò, piattaforme come TensorFlow e Microsoft offrono set di strumenti che chiunque può utilizzare per rendere responsabile la propria AI. Questo articolo presenta alcuni degli strumenti TensorFlow più essenziali utilizzati in ciascuna fase di implementazione del modello di apprendimento automatico.

Obiettivi di apprendimento:

- Capire come TensorFlow contribuisce alla creazione di applicazioni di AI responsabili fornendo una vasta gamma di strumenti e risorse.

- Scoprire le diverse fasi dell’implementazione del modello di apprendimento automatico.

- Esplorare i vari strumenti TensorFlow offerti in ciascuna fase del processo di implementazione del modello di apprendimento automatico.

Cos’è l’AI responsabile?

L’AI responsabile si riferisce allo sviluppo e all’uso dei sistemi di intelligenza artificiale (AI) in modo etico, trasparente e responsabile, in linea con i valori sociali come la privacy, l’equità, la sicurezza e la sostenibilità. L’AI responsabile è importante perché garantisce che i sistemi di AI siano progettati e utilizzati per beneficiare la società nel suo complesso anziché causare danni o perpetuare pregiudizi.

Alcuni principi chiave dell’AI responsabile includono la trasparenza, la responsabilità, l’equità, la privacy, la sicurezza e la sostenibilità. Gli sviluppatori possono applicare questi principi lungo l’intero ciclo di vita di un sistema di AI, dalla progettazione e sviluppo all’implementazione e al monitoraggio continuo.

- Microsoft AI presenta una strategia avanzata di ottimizzazione della comunicazione basata su ZeRO per un efficiente addestramento di modelli di grandi dimensioni, senza essere limitati dalle dimensioni del batch o dalla larghezza di banda.

- Incontra CoDi un nuovo modello di diffusione cross-modale per la sintesi da qualsiasi sorgente a qualsiasi destinazione.

- L’AI inizia il doppiaggio per YouTube in molteplici lingue.

Oggi vedremo come possiamo costruire applicazioni di AI responsabili con TensorFlow.

TensorFlow e il suo contributo verso l’AI responsabile

TensorFlow è una piattaforma open-source per la creazione e l’implementazione di modelli di apprendimento automatico. Sviluppato da Google, TensorFlow fornisce vari strumenti e risorse per la creazione di applicazioni di AI in vari domini, tra cui il riconoscimento di immagini e parole, l’elaborazione del linguaggio naturale e l’analisi predittiva.

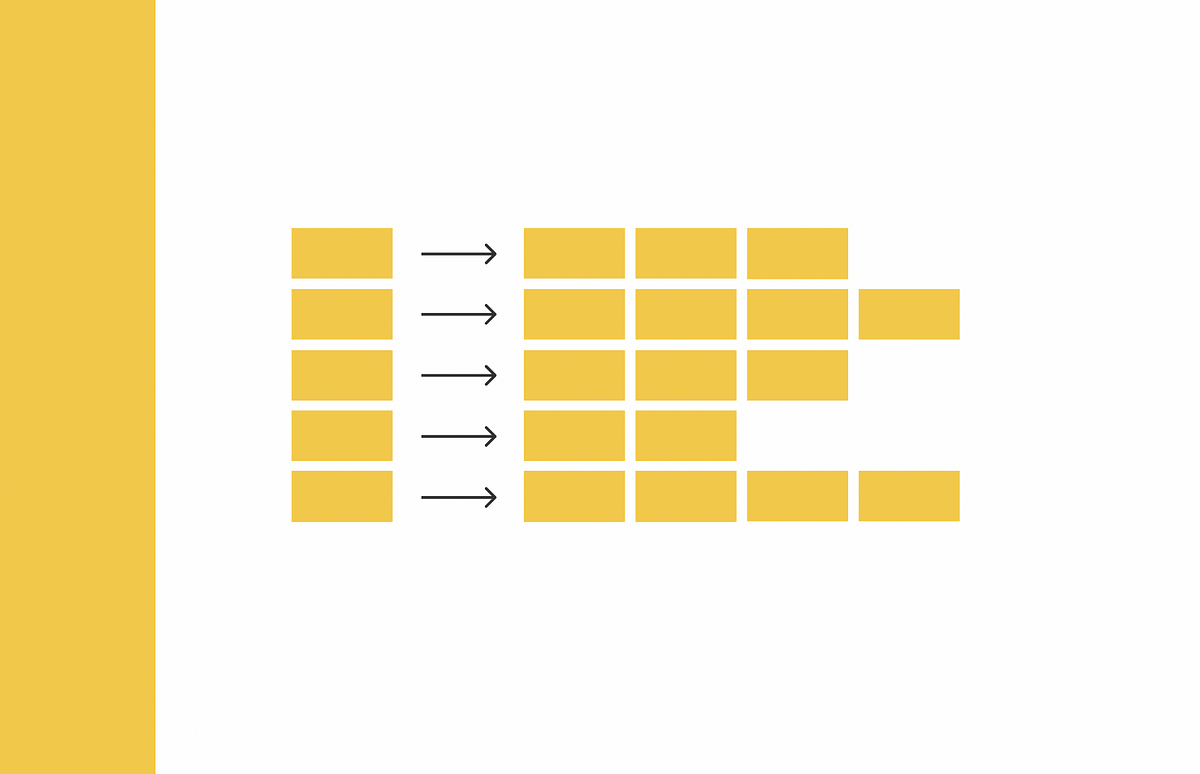

Poiché è open-source, la trasparenza e l’interpretabilità sono due componenti chiave di TensorFlow. Inoltre, la piattaforma ha anche rilasciato un set di strumenti e linee guida per la creazione di applicazioni di AI responsabili. Esploreremo alcuni strumenti utili utilizzati nelle diverse fasi dell’implementazione del modello di apprendimento automatico.

Fase 1: Definizione del problema

TensorFlow ha un set di strumenti per la fase di definizione del problema. Il libro guida di PAIR (People + AI Research) e gli esplorabili di PAIR possono assisterti nella pianificazione di applicazioni di AI. Le linee guida di TensorFlow includono strategie per la selezione di set di dati, la scelta di modelli e la valutazione delle prestazioni del modello. Seguendo queste linee guida si garantisce che la propria applicazione di AI sia accurata, affidabile ed efficace.

Il libro guida di PAIR offre una guida completa sulla progettazione di prodotti di AI che si allineano alle esigenze e ai valori degli utenti. Gli esplorabili di PAIR sono blog interattivi che aiutano designer e sviluppatori ad esplorare argomenti complessi legati all’AI responsabile, come gli algoritmi di apprendimento automatico e le considerazioni di equità.

Fase 2: Raccolta e preparazione dei dati

La seconda fase dell’apprendimento automatico prevede la raccolta e la preparazione dei dati. TensorFlow offre diversi strumenti per facilitare questa fase.

Validazione dei dati di TensorFlow (TFDV)

Uno degli strumenti più utili offerti da TensorFlow è la Validazione dei dati di TensorFlow (TFDV). TFDV è progettato per identificare anomalie nei dati di training e di servizio. Può anche creare automaticamente uno schema esaminando i dati. Questo componente può essere configurato per individuare diverse classi di anomalie nei dati.

TFDV esegue controlli di validità confrontando le statistiche dei dati con uno schema che codifica le aspettative dell’utente. Ciò aiuta gli utenti a garantire che i loro dati soddisfino determinati standard prima di essere utilizzati per la formazione o il testing. Inoltre, TFDV può rilevare la discrepanza tra training e servizio confrontando gli esempi nei dati di training e di servizio. Questo è importante poiché garantisce che il modello sia addestrato sui dati che rappresentano i dati che incontrerà durante la produzione.

Conosci i tuoi dati (KYD)

Un altro utile strumento offerto da TensorFlow in questa fase è Conosci i tuoi dati (KYD). KYD fornisce un’interfaccia semplice per comprendere la struttura e il contenuto dei propri dati. Consente agli utenti di esplorare e visualizzare rapidamente i propri dati per comprendere meglio le sue proprietà. La cosa più interessante di questo strumento è la sua GUI interattiva. Gli utenti possono anche creare nuovi gruppi nei set di dati in base alle loro etichette e ai vari attributi. Per ora, questo è in fase beta.

Fase 3: Costruzione e formazione

La terza fase del flusso di lavoro del machine learning consiste nella costruzione e nell’addestramento dei modelli. In questa fase, TensorFlow fornisce numerosi strumenti che utilizzano tecniche di preservazione della privacy e interpretative per addestrare i modelli in modo efficace.

TensorFlow Federated (TFF)

TensorFlow Federated (TFF) è un framework open-source progettato per il machine learning su dati decentralizzati. Questo approccio al machine learning, noto come Federated Learning, prevede l’addestramento di un modello globale condiviso tra molti client partecipanti che mantengono i propri dati di addestramento localmente. TFF consente un addestramento più efficiente preservando la privacy dei dati distribuendo il processo di addestramento su diversi dispositivi.

TensorFlow Lattice (TFL)

Un altro strumento utile per l’addestramento dei modelli in TensorFlow è TensorFlow Lattice (TFL). Questa libreria implementa modelli a griglia flessibili, controllati e interpretabili. TFL consente di aggiungere conoscenza di dominio al processo di apprendimento incorporando vincoli di forma basati sul buon senso o su politiche che soddisfano vincoli come la monotonicità, la convessità e la fiducia a coppie. Con TFL è possibile costruire modelli accurati e interpretabili, facilitando la comprensione del modo in cui il modello arriva alle proprie previsioni.

Fase 4: Valutazione del modello

In fase 4 di valutazione del modello, devono essere considerati diversi fattori per testare il modello addestrato. Questi fattori includono la privacy, l’equità, l’interpretabilità e la sicurezza. TensorFlow fornisce vari strumenti per valutare questi fattori per un determinato modello.

Fairness Indicators

Fairness Indicators è una libreria che facilita il calcolo facile di metriche di equità comunemente identificate per classificatori binari e multiclasse. Questa suite di strumenti confronta le prestazioni del modello tra i sottogruppi rispetto a una base o ad altri modelli. Utilizza anche gli intervalli di confidenza per evidenziare le disparità statisticamente significative e svolge la valutazione su più soglie.

What-If Tool (WIT)

Con WIT è possibile testare visivamente come cambia la performance del modello con la variazione di diverse variabili di input. Ciò consente di testare i modelli di IA per un insieme di scenari ipotetici, che è l’obiettivo principale di questo strumento.

TensorFlow Privacy Tests

TensorFlow Privacy Tests è un’altra libreria che valuta le proprietà di privacy dei modelli di classificazione. Consente di valutare le proprietà di privacy di un modello prima di distribuirlo in applicazioni reali.

Fase 5: Distribuzione e monitoraggio

Dopo aver preparato il modello di machine learning (ML) e intelligenza artificiale (AI), il passo successivo è distribuirlo. Tuttavia, distribuire un modello in produzione può comportare problemi imprevisti che ne influenzano le prestazioni. Pertanto, è necessario monitorare le prestazioni del modello dopo la distribuzione per identificare e risolvere eventuali problemi.

Model Card Toolkit (MCT)

È una libreria che semplifica la documentazione dei modelli. Le schede modello contengono tutte le informazioni necessarie sui modelli di ML e AI che sono stati costruiti. Queste informazioni possono includere la metodologia di addestramento, i set di dati utilizzati, il metodo di raccolta dei dati, ecc. Con MCT, la generazione di schede modello diventa snella e automatizzata, fornendo contesto e trasparenza nello sviluppo e nelle prestazioni di un modello.

ML Metadata (MLMD)

MLMD è un’altra libreria che registra e recupera metadati associati ai flussi di lavoro degli sviluppatori e dei data scientist di ML. È una parte integrante di TensorFlow Extended (TFX), ma è anche progettato per l’uso indipendente. Ogni esecuzione di un’elaborazione ML di produzione genera metadati contenenti informazioni sui vari componenti dell’elaborazione, le loro esecuzioni (ad esempio, esecuzioni di addestramento) e gli artefatti risultanti (ad esempio, modelli addestrati). In caso di eventuali comportamenti o errori inaspettati dell’elaborazione, questi metadati possono aiutare ad analizzare la linea di discendenza dei componenti dell’elaborazione e a risolvere i problemi. Pensate a questi metadati come l’equivalente della registrazione nello sviluppo software.

Conclusioni

La costruzione di applicazioni di IA responsabili assicura che i sistemi di IA siano progettati e utilizzati in modo etico e trasparente. TensorFlow è una piattaforma eccellente per la costruzione e la distribuzione di modelli di machine learning, fornendo numerosi strumenti e risorse per la creazione di applicazioni di IA responsabili in vari settori. Seguendo i principi di trasparenza, responsabilità, equità, privacy, sicurezza e sostenibilità durante l’intero ciclo di vita di un sistema di IA, gli sviluppatori possono assicurarsi che i loro modelli beneficino la società nel suo complesso, minimizzando i danni e perpetuando i pregiudizi. Con il set di strumenti di TensorFlow per la definizione del problema, la raccolta e la preparazione dei dati, la costruzione e l’addestramento, la valutazione del modello e la distribuzione e il monitoraggio, gli sviluppatori hanno accesso a tutto ciò di cui hanno bisogno per creare applicazioni di IA responsabili ed efficaci.

Lezione chiave:

- TensorFlow consente l’AI responsabile in diversi ambiti come il riconoscimento di immagini e di parole, l’elaborazione del linguaggio naturale e l’analisi predittiva con strumenti per la definizione del problema, la preparazione dei dati, la formazione, la valutazione, la distribuzione e il monitoraggio.

- Gli strumenti e le linee guida di TensorFlow promuovono la trasparenza, la responsabilità, l’equità, la privacy, la sicurezza e la sostenibilità per lo sviluppo di un’AI responsabile, consentendo l’applicazione efficace a beneficio della società.