Cosa succede se si esegue un modello Transformer con una rete neurale ottica?

Se si esegue un modello Transformer con una rete neurale ottica, cosa succede?

La scala di espansione esponenziale dei modelli di deep learning è una forza trainante nel progresso dello stato dell’arte e una fonte di preoccupazione crescente per il consumo di energia, la velocità e quindi la fattibilità del deep learning su vasta scala. Recentemente, i ricercatori di Cornell hanno parlato delle topologie Transformer, in particolare di come siano drasticamente migliori quando vengono scalate a miliardi o addirittura trilioni di parametri, portando a un aumento esponenziale dell’utilizzo del calcolo del deep learning. Questi Transformer su larga scala sono una soluzione popolare ma costosa per molte attività perché l’efficienza energetica dell’hardware digitale non è stata in grado di tenere il passo con i requisiti FLOP in continua crescita dei modelli di deep learning all’avanguardia. Inoltre, essi si comportano in modo sempre più impressionante in altri ambiti, come la visione artificiale, i grafi e le impostazioni multimodali.

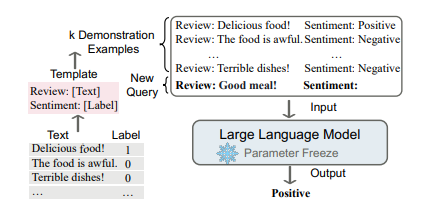

Inoltre, mostrano abilità di transfer learning, che permettono loro di generalizzare rapidamente a determinate attività, talvolta in un ambiente di prova zero senza ulteriori addestramenti richiesti. Il costo di questi modelli e le loro capacità generali di machine learning sono forze trainanti importanti nella creazione di acceleratori hardware per un’infusione efficace e rapida. L’hardware del deep learning è stato precedentemente sviluppato in modo estensivo nell’elettronica digitale, compresi i processori grafici (GPU), i chip acceleratori mobili, i FPGA e i sistemi di accelerazione dedicati all’IA su larga scala. Le reti neurali ottiche sono state suggerite come soluzioni che offrono una maggiore efficienza e latenza rispetto alle implementazioni di reti neurali sui computer digitali, tra le altre cose. Allo stesso tempo, c’è anche un interesse significativo nell’elaborazione analogica.

Anche se questi sistemi analogici sono suscettibili al rumore e all’errore, le operazioni delle reti neurali possono essere frequentemente eseguite in modo ottico a un costo molto inferiore, con il costo principale che di solito è l’overhead elettrico associato al caricamento dei pesi e dei dati ammortizzato in grandi operazioni lineari. L’accelerazione di modelli su larga scala come i Transformer è quindi particolarmente promettente. Teoricamente, la scalabilità è asintoticamente più efficiente per quanto riguarda l’energia per MAC rispetto ai sistemi digitali. Qui dimostrano come i Transformer utilizzino sempre di più questa scalabilità. Hanno campionato operazioni da un vero Transformer per il language modeling da eseguire su un sistema sperimentale a modulatore di luce spaziale reale. Hanno quindi utilizzato i risultati per creare una simulazione calibrata di un Transformer completo eseguito in modo ottico. Ciò è stato fatto per dimostrare che i Transformer possono funzionare su questi sistemi nonostante le loro caratteristiche di rumore e errore.

- Questo strumento di intelligenza artificiale spiega come l’IA vede le immagini e perché potrebbe confondere un astronauta con una pala.

- Cos’è un Field Programmable Gate Array (FPGA) FPGA vs GPU per l’Intelligenza Artificiale (IA)

- Google AI presenta i plugin di diffusione di MediaPipe che consentono la generazione controllabile di testo in immagini su dispositivo.

Nelle loro simulazioni utilizzando pesi e input ottenuti da questi test con errori sistematici, rumore e imprecisioni, hanno scoperto che i Transformer continuano a funzionare quasi allo stesso modo di quelli digitali. Ecco un riassunto dei loro principali contributi:

• Hanno creato regole di scalabilità per le prestazioni e i costi totali dell’energia dei Transformer ottici rispetto alla dimensione del modello e all’uso dell’energia ottica. Hanno dimostrato sperimentalmente che le operazioni lineari nei Transformer possono essere eseguite con precisione su hardware ottico reale, nonostante gli errori e il rumore.

• Utilizzando un design basato sulle loro simulazioni e test, hanno previsto il consumo di energia di un intero acceleratore ONN.

• Hanno calcolato che l’ottica consuma un ordine di grandezza inferiore rispetto ai processori all’avanguardia.

Anche se le loro simulazioni e test hanno utilizzato un determinato pezzo di hardware come esempio, il loro focus qui è più ampio. Vogliono sapere come la scalabilità dell’energia ottica e il rumore si relazionano alla costruzione e alle prestazioni dei Transformer. Di conseguenza, quasi tutte le loro conclusioni si applicano in generale ai processori ottici lineari, indipendentemente dai dettagli dell’implementazione hardware.