Google AI presenta i plugin di diffusione di MediaPipe che consentono la generazione controllabile di testo in immagini su dispositivo.

Google AI presenta i plugin di diffusione di MediaPipe per generare testo controllabile in immagini su dispositivi.

I modelli di diffusione sono stati ampiamente utilizzati con notevole successo nella generazione di testo-immagine negli ultimi anni, portando a miglioramenti significativi nella qualità delle immagini, nelle prestazioni di inferenza e nel campo delle nostre possibilità creative. Tuttavia, la gestione efficace della generazione rimane una sfida, soprattutto in condizioni difficili da definire a parole.

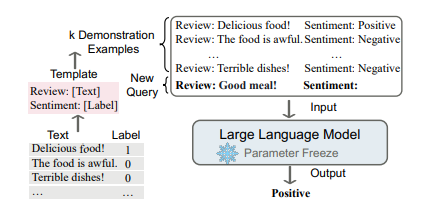

I plugin di dispersione di MediaPipe, sviluppati dai ricercatori di Google, rendono possibile l’esecuzione di una generazione di testo-immagine su dispositivo sotto il controllo dell’utente. In questo studio, estendiamo il nostro precedente lavoro sull’inferenza GPU per modelli generativi di grandi dimensioni sul dispositivo stesso, e presentiamo soluzioni a basso costo per la creazione programmabile di testo-immagine che possono essere integrate nei modelli di diffusione preesistenti e nelle loro variazioni di Low-Rank Adaptation (LoRA).

La denoising iterativa è modellata per la produzione di immagini nei modelli di diffusione. Ogni iterazione del modello di diffusione inizia con un’immagine contaminata dal rumore e termina con un’immagine della nozione target. La comprensione del linguaggio attraverso prompt di testo ha notevolmente migliorato il processo di generazione delle immagini. L’embedding del testo è collegato al modello per la produzione di testo-immagine attraverso strati di cross-attention. Tuttavia, la posizione e la posa di un oggetto sono due esempi di dettagli che potrebbero essere più difficili da comunicare utilizzando prompt di testo. I ricercatori introducono informazioni di controllo da un’immagine di condizione nella diffusione utilizzando modelli aggiuntivi.

- Salesforce presenta XGen-7B una nuova LLM (Lingua Naturale) addestrata su 7B (miliardi) di esempi con una lunghezza di sequenza fino a 8K (8.000) per 1,5T (trilioni) di token.

- Trasformazione dell’interazione AI LLaVAR si distingue nella comprensione visiva e basata su testo, segnando una nuova era nei modelli di istruzioni multimodali.

- LLM possono generare dimostrazioni matematiche che possono essere rigorosamente verificate? Scopri LeanDojo un playground AI open-source con toolkit, benchmark e modelli per i Large Language Models per dimostrare teoremi formali nell’assistente di proof Lean.

I metodi Plug-and-Play, ControlNet e T2I Adapter sono spesso utilizzati per generare output controllati di testo-immagine. Per codificare lo stato da un’immagine di input, Plug-and-Play utilizza una copia del modello di diffusione (860M parametri per Stable Diffusion 1.5) e un approccio di inversione del modello di diffusione di denoising implicito ampiamente utilizzato (DDIM) che inverte il processo di generazione da un’immagine di input per ottenere un input di rumore iniziale. Le caratteristiche spaziali con self-attention vengono estratte dalla diffusione copiata e iniettate nella diffusione di testo-immagine utilizzando Plug-and-Play. ControlNet costruisce una copia addestrabile dell’encoder di un modello di diffusione e lo collega tramite uno strato di convoluzione con parametri inizializzati a zero per codificare le informazioni di condizionamento che vengono poi passate ai livelli del decoder. Purtroppo, ciò ha comportato un significativo aumento delle dimensioni, circa 450M parametri per Stable Diffusion 1.5, la metà del modello di diffusione stesso. T2I Adapter offre risultati comparabili nella generazione controllata nonostante sia una rete più piccola (77M parametri). L’immagine di condizione è l’unico input per T2I Adapter e il risultato viene utilizzato da tutti i cicli successivi di diffusione. Tuttavia, questo tipo di adattatore non è adatto per i dispositivi mobili.

Il plugin di dispersione di MediaPipe è una rete autonoma che abbiamo sviluppato per rendere la generazione condizionata efficace, flessibile e scalabile.

- Si collega semplicemente a un modello di base addestrato; plug-and-play.

- La formazione a partire da zero significa che non sono stati utilizzati pesi del modello originale.

- È portatile perché può essere eseguito indipendentemente dal modello di base su dispositivi mobili con un costo aggiuntivo praticamente nullo.

- Il plugin è la sua rete, i cui risultati possono essere integrati in un modello esistente per convertire il testo in immagini. Lo strato di downscaling corrispondente del modello di diffusione (blu) riceve le caratteristiche recuperate dal plugin.

Un paradigma portatile on-device per la creazione di testo-immagine, il plugin di dispersione MediaPipe è disponibile come download gratuito. Prende un’immagine condizionata e utilizza l’estrazione di caratteristiche multiscala per aggiungere caratteristiche alle scale appropriate all’encoder di un modello di diffusione. Quando viene accoppiato con un modello di diffusione di testo-immagine, il modello del plugin aggiunge un segnale di condizionamento alla produzione di immagini. Intendiamo che la rete del plugin abbia solo 6M parametri, rendendola un modello relativamente semplice. Per ottenere un’inferenza rapida su dispositivi mobili, MobileNetv2 utilizza convoluzioni depth-wise e bottleneck invertiti.

Caratteristiche fondamentali

- Strutture di facile comprensione per l’apprendimento automatico self-service. Per modificare, testare, prototipare e rilasciare un’applicazione, utilizzare un’API a basso codice o uno studio senza codice.

- Approcci innovativi di apprendimento automatico (ML) per problemi comuni, sviluppati utilizzando l’esperienza di ML di Google.

- Ottimizzazione completa, compresa l’accelerazione hardware, pur rimanendo abbastanza piccolo ed efficiente da funzionare senza problemi su smartphone alimentati a batteria.