Salesforce presenta XGen-7B una nuova LLM (Lingua Naturale) addestrata su 7B (miliardi) di esempi con una lunghezza di sequenza fino a 8K (8.000) per 1,5T (trilioni) di token.

Salesforce introduces XGen-7B, a new Natural Language Model (LLM) trained on 7 billion examples with a sequence length of up to 8,000 tokens for 1.5 trillion tokens.

Con recenti progressi tecnologici nell’intelligenza artificiale, i Large Language Models, o LLMs in breve, sono diventati sempre più diffusi. Negli ultimi anni, i ricercatori hanno compiuto rapidi progressi nella risoluzione di diversi compiti complessi legati al linguaggio, addestrando questi modelli su enormi quantità di dati per comprendere modelli linguistici intricati, generare risposte coerenti, ecc. Una delle aree di ricerca che ha suscitato particolare interesse tra ricercatori e sviluppatori è l’applicazione dei LLMs nella gestione di contenuti di lunga durata per includere contesti più ampi. Alcuni esempi di questi compiti vanno da compiti relativamente semplici come la sintesi del testo e la generazione di codice a enunciati di problemi più complessi come la previsione della struttura delle proteine e il recupero delle informazioni. Le sequenze di testo lunghe sono costituite da informazioni in diverse forme, come paragrafi, tabelle, immagini, ecc.; quindi, i LLMs devono essere addestrati a elaborare e comprendere tali elementi. Inoltre, considerando efficacemente le dipendenze strutturali a lunga distanza, i LLMs possono identificare le connessioni tra diverse parti del testo e estrarre le informazioni più pertinenti. Pertanto, l’esposizione a una gamma più ampia di conoscenze consente ai LLMs di fornire risposte più accurate e pertinenti al contesto alle query degli utenti.

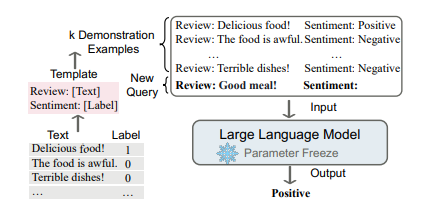

Tuttavia, nonostante le numerose possibili applicazioni, la maggior parte dei LLMs open-source disponibili, dal LLaMA di Meta ai modelli LLM di MosaicML’s MPT, è stata addestrata su sequenze con un massimo di 2K token. Questa limitazione rappresenta una sfida significativa quando si tratta di modellare sequenze più lunghe. Inoltre, ricerche precedenti sulla scalabilità del modello hanno dimostrato che modelli più piccoli addestrati su un numero maggiore di token superano i modelli più grandi quando viene fornito un budget computazionale fisso. Pertanto, ispirandosi al problema in questione e agli attuali progressi, Salesforce Research ha ottenuto risultati innovativi introducendo XGen-7B, una serie di LLMs da 7B addestrati su una lunghezza di sequenza di 8K per 1,5 trilioni di token. La serie di modelli include XGen-7B-4K-Base (con supporto per la lunghezza di sequenza di 4K), XGen-7B-8K-Base (con supporto per la lunghezza di sequenza di 8K) e XGen-7B-8k-Inst, che è stato ottimizzato per dati di istruzione di pubblico dominio (rilasciato solo per scopi di ricerca). La caratteristica sorprendente di questi LLMs è che su benchmark NLP standard, XGen ottiene risultati comparabili o migliori rispetto ad altri LLMs all’avanguardia di dimensioni simili come MPT, Falcon, LLaMA, ecc.

I modelli XGen-7b impiegati in questo studio sono stati addestrati utilizzando la libreria proprietaria JaxFormer di Salesforce, che consente un addestramento efficiente di LLMs utilizzando parallelismo di dati e modelli ottimizzato specificamente per l’hardware TPU-v4. Il processo di addestramento ha seguito le linee guida di LLaMA, integrate con due indagini aggiuntive. La prima esplorazione si è concentrata sulla comprensione dei “picchi di perdita”, in cui la perdita aumenta improvvisamente e temporaneamente durante l’addestramento senza una causa sottostante chiara. Sebbene la causa di questi picchi rimanga sconosciuta, i ricercatori hanno identificato fattori come “circuti sequenziali su paralleli”, “swish-GLU su GeLU” e “RMS-Norm su Layer-norm” come possibili contribuenti all’instabilità dell’addestramento. Il secondo aspetto affrontato è stato la lunghezza della sequenza. Poiché l’addestramento con sequenze più lunghe comporta costi computazionali significativamente più elevati a causa della complessità quadratica dell’auto-attenzione, è stato adottato un approccio di addestramento in più fasi. L’addestramento ha compreso inizialmente 800B token con una lunghezza di sequenza di 2k token, seguito da 400B token con lunghezza di 4k e infine 300B token con lunghezza di 8k.

- Trasformazione dell’interazione AI LLaVAR si distingue nella comprensione visiva e basata su testo, segnando una nuova era nei modelli di istruzioni multimodali.

- LLM possono generare dimostrazioni matematiche che possono essere rigorosamente verificate? Scopri LeanDojo un playground AI open-source con toolkit, benchmark e modelli per i Large Language Models per dimostrare teoremi formali nell’assistente di proof Lean.

- Baidu Ernie 3.5 si presenta come il campione dell’IA nel linguaggio cinese ma è davvero migliore di ChatGPT?

Per valutare le capacità del modello XGen-7b 8k nella comprensione di contesti più lunghi, i ricercatori hanno condotto valutazioni utilizzando tre compiti principali: generazione di dialoghi di lunga durata, sintesi del testo e domande e risposte. I ricercatori hanno utilizzato il modello ottimizzato per le istruzioni per le loro valutazioni relative alla difficoltà dei compiti in questione. Per quanto riguarda la generazione di dialoghi di lunga durata, i ricercatori hanno utilizzato tre compiti per la valutazione: sintesi delle riunioni AMI, ForeverDreaming e sintesi delle sceneggiature di TVMegaSite. Su tutte le metriche, il modello XGen-7B-inst ha ottenuto i punteggi più alti rispetto a diversi altri modelli ottimizzati per le istruzioni, dimostrando le sue prestazioni superiori.

Per quanto riguarda le domande e risposte di lunga durata, i ricercatori hanno generato domande utilizzando ChatGPT basandosi su documenti di Wikipedia che coprono argomenti diversi come Fisica, Ingegneria, Storia e Intrattenimento, insieme alle relative sintesi. Le risposte generate dai LLMs, che erano lunghe 256 token, sono state valutate utilizzando GPT-4 in base alla loro struttura, organizzazione e pertinenza rispetto alla domanda e al documento di origine. In questo scenario, il modello XGen-7B-8k-Inst ha superato i modelli di riferimento, limitati a 2k token, dimostrando le sue prestazioni superiori. Per quanto riguarda la sintesi del testo, i ricercatori hanno utilizzato due set di dati provenienti da domini diversi, nello specifico conversazioni di riunioni e report governativi, per valutare il modello XGen-7b. I risultati hanno rivelato che il modello XGen-7b supera significativamente gli altri modelli di riferimento in questi compiti, indicando le sue prestazioni superiori anche nella sintesi del testo.

Le valutazioni hanno dimostrato che il modello XGen-7b eccelle nella comprensione di contesti più lunghi in vari compiti, tra cui la generazione di dialoghi di lunghezza estesa, la risposta alle domande e la sintesi del testo. Le sue prestazioni superano quelle di altri modelli basati su istruzioni e modelli di base, dimostrando la sua efficacia nel comprendere e generare risposte coerenti in contesti di testo estesi. Tuttavia, nonostante la sua efficacia, i ricercatori riconoscono un limite del modello XGen, poiché non è esente da pregiudizi e ha il potenziale per generare risposte tossiche, una caratteristica che condivide con molti altri modelli di intelligenza artificiale. Salesforce Research ha anche reso open source il suo codice per consentire alla comunità di esplorare il suo lavoro.

Visita il Blog SF e il Link Github. Non dimenticare di unirti al nostro ML SubReddit con oltre 25k iscritti, al Canale Discord e alla Newsletter via Email, dove condividiamo le ultime novità sulla ricerca nell’intelligenza artificiale, progetti interessanti di intelligenza artificiale e altro ancora. Se hai domande riguardo all’articolo sopra o se abbiamo tralasciato qualcosa, non esitare a scriverci all’indirizzo email [email protected].