Trasformazione della formazione specializzata di intelligenza artificiale – Incontra LMFlow un promettente toolkit per ottimizzare ed personalizzare in modo efficiente grandi modelli di base per prestazioni superiori.

LMFlow è un toolkit promettente per ottimizzare e personalizzare in modo efficiente grandi modelli di base nell'ambito dell'intelligenza artificiale.

I modelli di linguaggio di grandi dimensioni (LLM) costruiti su modelli di base di grandi dimensioni hanno dimostrato la capacità generale di eseguire varie attività che erano impossibili prima. Tuttavia, è necessario un maggiore perfezionamento di tali LLM per aumentare le prestazioni in domini o lavori specializzati. Le procedure comuni per il perfezionamento di tali modelli di grandi dimensioni includono:

- Continua preallenamento in aree di nicchia, consentendo a un modello di base ampio di acquisire competenze in tali aree.

- Regolazione delle istruzioni per addestrare un modello di base ampio e generico a comprendere ed eseguire determinati tipi di istruzioni in linguaggio naturale.

- Addestrare un modello di base di grandi dimensioni con le necessarie capacità conversazionali utilizzando RLHF (apprendimento di rinforzo con feedback umano).

Mentre diversi modelli di grandi dimensioni sono già stati preallenati e resi disponibili al pubblico (GPT-J, Bloom, LLaMA, ecc.), nessun toolkit disponibile pubblicamente può effettuare efficacemente operazioni di perfezionamento in tutti questi modelli.

Per aiutare sviluppatori e ricercatori a perfezionare e inferire modelli enormi in modo efficiente con risorse limitate, un team di accademici dell’Università di Hong Kong e dell’Università di Princeton ha creato un set di strumenti facile da usare e leggero.

- Un’introduzione all’Ingegneria delle Proposte

- MosaicML ha appena rilasciato il loro MPT-30B sotto licenza Apache 2.0.

- Apprendimento delle preferenze con feedback automatizzato per l’espulsione della cache

Basta una GPU Nvidia 3090 e cinque ore per addestrare un modello personalizzato basato su un modello LLaMA con 7 miliardi di parametri. Il team ha reso disponibili i pesi del modello per la ricerca accademica dopo aver utilizzato questo framework per perfezionare versioni di LLaMA con 7, 13, 33 e 65 miliardi di parametri su una singola macchina.

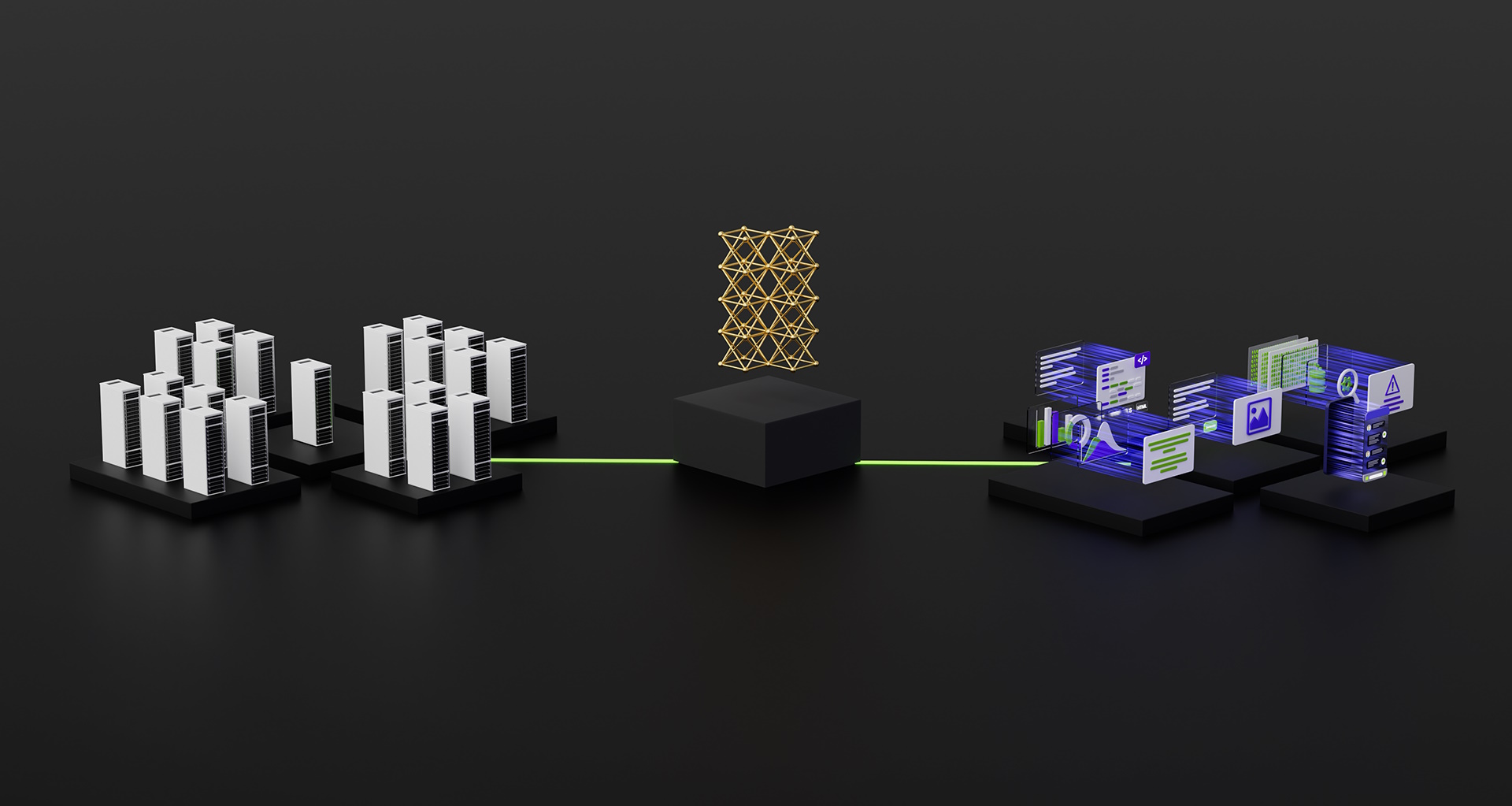

Ci sono quattro passaggi per ottimizzare l’output di un grande modello di linguaggio liberamente disponibile online:

- Il primo passaggio, “adattamento del dominio”, consiste nell’addestrare il modello su un certo dominio per gestirlo meglio.

- L’adattamento al compito è il secondo passaggio e comporta l’addestramento del modello per raggiungere un obiettivo specifico, come la sintesi, la risposta alle domande o la traduzione.

- L’aggiustamento dei parametri del modello basato su coppie di domande e risposte di istruzioni è il terzo passaggio, il perfezionamento delle istruzioni.

- Il passaggio finale è l’apprendimento di rinforzo utilizzando il feedback umano, che comporta il perfezionamento del modello in base alle opinioni delle persone.

LMFlow offre una procedura completa di perfezionamento per questi quattro passaggi, consentendo l’addestramento personalizzato di modelli di linguaggio enormi nonostante le risorse computazionali limitate.

LMFlow offre un approccio completo per il perfezionamento di modelli di grandi dimensioni con funzionalità come preallenamento continuo, regolazione delle istruzioni e RLHF, oltre a API facili e flessibili. L’addestramento personalizzato del modello è ora accessibile a tutti con LMFlow. Per attività come rispondere alle domande, compagnia, scrittura, traduzione e consulenze specialistiche in vari argomenti, ogni persona può scegliere un modello adatto in base alle proprie risorse disponibili. Se gli utenti dispongono di un modello e di un set di dati sufficientemente grandi, addestrare per un periodo più lungo darà risultati superiori. Il team ha recentemente addestrato un modello da 33 miliardi di parametri che supera ChatGPT.