MosaicML ha appena rilasciato il loro MPT-30B sotto licenza Apache 2.0.

MosaicML ha appena rilasciato il loro MPT-30B con licenza Apache 2.0.

Dopo il grande successo di MosaicML-7B, MosaicML ha ancora una volta superato il benchmark che avevano stabilito in precedenza. Nel nuovo lancio rivoluzionario, MosaicML ha lanciato MosaicML-30B.

MosaicML è un trasformatore preaddestrato molto preciso e potente. MosaicML sostiene che MosaicML-30B sia ancora migliore di ChatGPT3.

Prima del lancio di MosaicML-30B, MosaicML-7B ha conquistato il mondo dell’IA. Base-instruct di MPT-7B, base-chat e la scrittura di storie sono stati grandi successi. L’azienda ha affermato che questi modelli sono stati scaricati oltre 3 milioni di volte in tutto il mondo. Uno dei motivi principali per spingere per un motore ancora migliore, che Mosaic ML ha fatto con MPT-30B, è stata la follia della comunità per i modelli che hanno rilasciato in precedenza.

- Apprendimento delle preferenze con feedback automatizzato per l’espulsione della cache

- Tipi di funzioni di attivazione nelle reti neurali

- Cosa è il Machine Learning come Servizio? Vantaggi e le migliori piattaforme MLaaS.

È stato incredibile come la comunità si sia adattata e abbia utilizzato questi motori MPT per costruire qualcosa di meglio ottimizzato e servire casi d’uso concreti. Alcuni dei casi interessanti sono LLaVA-MPT. LLaVa-MPT aggiunge la comprensione della visione a MPT-7B preaddestrato.

Allo stesso modo, GGML ottimizza i motori MPT per funzionare meglio su Apple Silicon e CPU. GPT4ALL è un altro caso d’uso che consente di eseguire un’opzione di chat simile a GPT4 con MPT come motore di base.

Quando osserviamo da vicino, uno dei motivi principali per cui MosaicML è così migliore e sembra avere un vantaggio nel fornire una dura concorrenza e un’alternativa migliore alle grandi aziende è l’elenco delle funzionalità competitive che offrono e l’adattabilità dei loro modelli a diversi casi d’uso con un’integrazione relativamente facile.

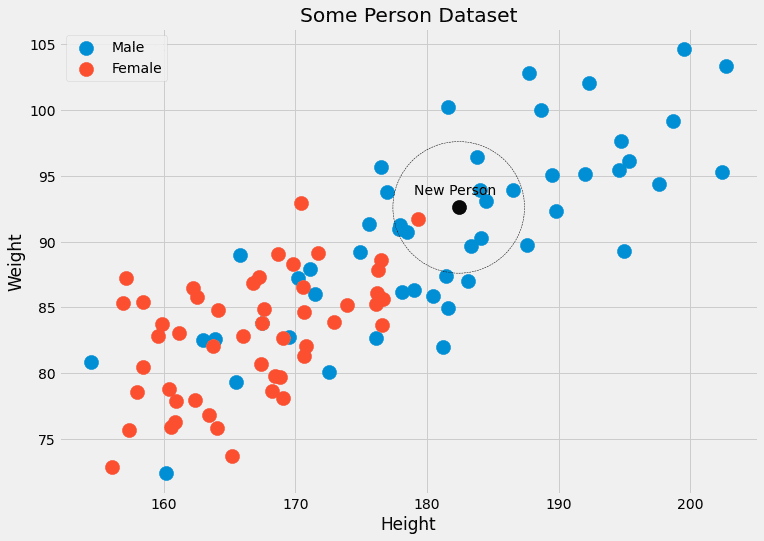

In questa versione, Mosaic ML ha anche affermato che il loro MPT-30B supera ChatGPT3 esistente con circa un terzo dei parametri utilizzati da ChatGPT, rendendolo un modello estremamente leggero rispetto alle soluzioni generative esistenti.

È migliore rispetto all’esistente MPT-7B di MosaicML e questo MPT-30B è prontamente disponibile per l’uso commerciale sotto licenza commerciale.

Non solo, ma MPT-30B viene fornito con due modelli preaddestrati, che sono MPT-30B-Instruct e MPT-30B-Chat, in grado di essere influenzati da una singola istruzione e capaci di seguire una conversazione multiturn per un periodo più lungo.

I motivi per cui è migliore continuano. MosaicML ha progettato MPT-30B per essere un modello migliore e più robusto in un approccio bottom-up, garantendo che ogni pezzo in movimento funzioni meglio e in modo più efficiente. MPT-30B è stato addestrato con una finestra di contesto di 8k token. Supporta contesti più lunghi tramite ALiBi.

Ha migliorato le sue prestazioni di addestramento e inferenza con l’aiuto di FlashAttention. MPT-30B è anche dotato di capacità di codifica più potenti, merito della diversità dei dati che hanno affrontato. Questo modello è stato esteso a una finestra di contesto di 8K su H100 di Nvidia. L’azienda afferma che questo, per quanto ne sa, è il primo modello LLM addestrato su H100, che è prontamente disponibile per i clienti.

MosaicML ha anche mantenuto il modello leggero, il che aiuta le organizzazioni emergenti a mantenere bassi i costi operativi.

Anche la dimensione di MPT-30B è stata scelta appositamente per renderlo facile da implementare su una singola GPU. Un A100-80GB in precisione a 16 bit o un A100-40GB in precisione a 8 bit possono eseguire il sistema. Altri LLM comparabili, come Falcon-40B, hanno un numero maggiore di parametri e non possono essere serviti su una singola GPU del data center (oggi); ciò rende necessari 2+ GPU, il che aumenta il costo minimo del sistema di inferenza.