Le GPU NVIDIA H100 stabiliscono lo standard per l’AI generativa nell’ambito del primo benchmark MLPerf.

NVIDIA H100 GPUs set the standard for generative AI in the first MLPerf benchmark.

Gli utenti leader e i benchmark dell’industria concordano: le GPU NVIDIA H100 Tensor Core offrono le migliori prestazioni di intelligenza artificiale, specialmente sui grandi modelli di linguaggio (LLM) che alimentano l’AI generativa.

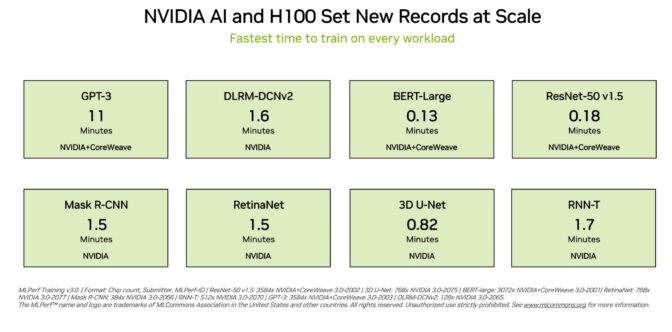

Le GPU H100 hanno stabilito nuovi record su tutti e otto i test nei più recenti benchmark di formazione di MLPerf, eccellendo su un nuovo test MLPerf per l’AI generativa. Questa eccellenza viene fornita sia per acceleratore che a livello di server massicci.

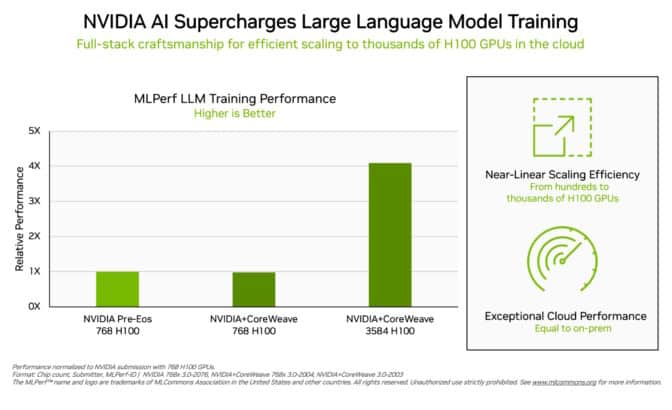

Ad esempio, su un cluster disponibile commercialmente di 3.584 GPU H100 co-sviluppato dalla startup Inflection AI e operato da CoreWeave, un provider di servizi cloud specializzato in carichi di lavoro accelerati da GPU, il sistema ha completato il massiccio benchmark di formazione basato su GPT-3 in meno di undici minuti.

“I nostri clienti stanno costruendo LLM e AI generative all’avanguardia su larga scala oggi, grazie alle nostre migliaia di GPU H100 su reti InfiniBand veloci e a bassa latenza”, ha dichiarato Brian Venturo, co-fondatore e CTO di CoreWeave. “La nostra presentazione congiunta MLPerf con NVIDIA dimostra chiaramente le grandi prestazioni di cui godono i nostri clienti”.

- La corsa per prevenire il peggiore scenario per il Machine Learning

- T5 Trasformatori di Testo in Testo (Parte Uno)

- Dalla teoria alla pratica Costruire un classificatore k-Nearest Neighbors

Le migliori prestazioni disponibili oggi

Inflection AI ha sfruttato queste prestazioni per costruire il LLM avanzato dietro la sua prima AI personale, Pi, che sta per intelligenza personale. L’azienda agirà come uno studio di AI, creando AI personali con cui gli utenti possono interagire in modo semplice e naturale.

“Chiunque può sperimentare oggi la potenza di un’AI personale basata sul nostro moderno grande modello di linguaggio che è stato addestrato sulla potente rete di GPU H100 di CoreWeave”, ha detto Mustafa Suleyman, CEO di Inflection AI.

Fondata all’inizio del 2022 da Mustafa e Karén Simonyan di DeepMind e Reid Hoffman, Inflection AI mira a lavorare con CoreWeave per costruire uno dei cluster di calcolo più grandi del mondo utilizzando le GPU NVIDIA.

Il racconto del nastro

Queste esperienze utente riflettono le prestazioni dimostrate nei benchmark di MLPerf annunciati oggi.

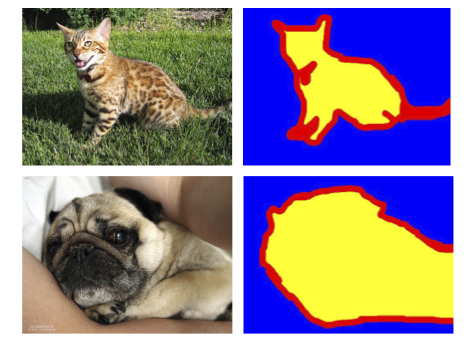

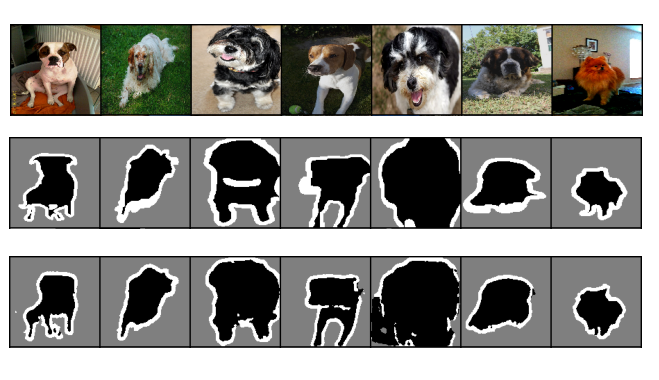

Le GPU H100 hanno fornito le prestazioni più elevate su ogni benchmark, compresi i grandi modelli di linguaggio, i sistemi di raccomandazione, la visione artificiale, l’imaging medico e il riconoscimento del parlato. Sono state le uniche schede ad eseguire tutti e otto i test, dimostrando la versatilità della piattaforma AI NVIDIA.

Eccellenza in esecuzione a scala

La formazione è tipicamente un lavoro eseguito su larga scala da molte GPU che lavorano in tandem. Su ogni test MLPerf, le GPU H100 hanno stabilito nuovi record di prestazioni a scala per la formazione di AI.

L’ottimizzazione dell’intera pila tecnologica ha permesso una scalabilità delle prestazioni quasi lineare sul test LLM impegnativo, poiché le presentazioni sono passate da centinaia a migliaia di GPU H100.

Inoltre, CoreWeave ha fornito dalla cloud prestazioni simili a quelle che NVIDIA ha ottenuto da un supercomputer di AI in esecuzione in un data center locale. Questo è un segno della rete a bassa latenza di NVIDIA Quantum-2 InfiniBand che CoreWeave utilizza.

In questa serie, MLPerf ha anche aggiornato il suo benchmark per i sistemi di raccomandazione.

Il nuovo test utilizza un set di dati più grande e un modello di AI più moderno per riflettere meglio le sfide che i provider di servizi cloud affrontano. NVIDIA è stata l’unica azienda a presentare i risultati del benchmark migliorato.

Un ecosistema NVIDIA AI in espansione

Quasi una dozzina di aziende ha presentato i risultati sulla piattaforma NVIDIA in questa serie. Il loro lavoro dimostra che l’AI NVIDIA è supportata dall’ecosistema più ampio del settore nell’apprendimento automatico.

Le presentazioni sono arrivate dai principali produttori di sistemi che includono ASUS, Dell Technologies, GIGABYTE, Lenovo e QCT. Più di 30 presentazioni sono state eseguite su GPU H100.

Questo livello di partecipazione consente agli utenti di sapere che possono ottenere ottime prestazioni con l’AI NVIDIA sia nel cloud che nei server in esecuzione nei loro data center.

Prestazioni su tutti i carichi di lavoro

I partner dell’ecosistema NVIDIA partecipano a MLPerf perché sanno che è uno strumento prezioso per i clienti che valutano le piattaforme e i fornitori di AI.

I benchmark coprono i carichi di lavoro che gli utenti considerano importanti: visione artificiale, traduzione e apprendimento per rinforzo, oltre all’AI generativa e ai sistemi di raccomandazione.

Gli utenti possono fare affidamento sui risultati di MLPerf per prendere decisioni di acquisto informate, poiché i test sono trasparenti e oggettivi. I benchmark godono del sostegno di un ampio gruppo che include Arm, Baidu, Facebook AI, Google, Harvard, Intel, Microsoft, Stanford e l’Università di Toronto.

I risultati di MLPerf sono disponibili oggi su piattaforme H100, L4 e NVIDIA Jetson in tutti i benchmark relativi all’AI training, all’inference e all’HPC. In futuro, presenteremo i nostri risultati anche sui sistemi NVIDIA Grace Hopper.

L’importanza dell’efficienza energetica

Man mano che le esigenze di performance dell’AI crescono, diventa essenziale espandere l’efficienza di come queste performance vengono raggiunte. Ecco cosa fa il calcolo accelerato.

I data center accelerati con le GPU NVIDIA utilizzano meno nodi del server, quindi occupano meno spazio nel rack e meno energia. Inoltre, la rete accelerata aumenta l’efficienza e le prestazioni, mentre le ottimizzazioni software in corso portano a guadagni x-factor sulla stessa hardware.

Le prestazioni ad alta efficienza energetica sono vantaggiose per il pianeta e per l’azienda. Prestazioni maggiori possono accelerare il tempo di commercializzazione e consentire alle organizzazioni di sviluppare applicazioni più avanzate.

L’efficienza energetica riduce anche i costi perché i data center accelerati con le GPU NVIDIA utilizzano meno nodi del server. Infatti, NVIDIA alimenta 22 dei primi 30 supercomputer nella lista Green500 più recente.

Software disponibile per tutti

NVIDIA AI Enterprise, il livello software della piattaforma NVIDIA AI, consente prestazioni ottimizzate su un’infrastruttura di calcolo accelerata leader. Il software viene fornito con il supporto, la sicurezza e l’affidabilità di livello enterprise necessari per eseguire l’AI nel data center aziendale.

Tutto il software utilizzato per questi test è disponibile nel repository di MLPerf, quindi praticamente chiunque può ottenere questi risultati di livello mondiale.

Le ottimizzazioni vengono continuamente integrate nei container disponibili su NGC, il catalogo NVIDIA per il software accelerato da GPU.

Leggi questo blog tecnico per approfondire le ottimizzazioni che alimentano le prestazioni e l’efficienza di MLPerf di NVIDIA.