Perché c’è una sorta di pranzo gratis

Why is there a sort of free lunch?

Sull’Universalità dei Pattern in Neuroscienze e Intelligenza Artificiale

“Non esiste il pranzo gratis”. – Robert A. Henlein

Il teorema “Non esiste il pranzo gratis” nel campo del machine learning mi ricorda il teorema dell’incompletezza di Gödel nel mondo della matematica.

Mentre questi teoremi vengono spesso citati, raramente sono spiegati in profondità e le implicazioni per le applicazioni del mondo reale spesso rimangono poco chiare. Proprio come il teorema di Gödel divenne una sfida nella convinzione dei matematici del primo Novecento in un sistema formale completo e autoconsistente, i teoremi “Non esiste il pranzo gratis” sfidano la nostra fiducia nell’efficacia degli algoritmi generali di machine learning. Tuttavia, l’impatto di questi teoremi sulle applicazioni pratiche quotidiane può spesso essere limitato e la maggior parte degli operatori procede senza essere vincolata da questi vincoli teorici.

In questo articolo, voglio esplorare ciò che afferma il teorema “Non esiste il pranzo gratis” e approfondire le sue associazioni con la visione, il transfer learning, le neuroscienze e l’intelligenza artificiale generale.

- 8 Cose Potenzialmente Sorprendenti Da Sapere Sui Grandi Modelli Linguistici (LLM)

- Efficiente segmentazione delle immagini utilizzando PyTorch Parte 1.

- Efficiente segmentazione delle immagini utilizzando PyTorch Parte 2

Il teorema o i teoremi “Non esiste il pranzo gratis”, proposti da Wolpert e Macready nel 1997 e spesso utilizzati nel contesto del machine learning, affermano che nessun algoritmo è universalmente il migliore per tutti i possibili problemi. Non esiste una soluzione magica che si adatta a tutti. Un algoritmo potrebbe funzionare eccezionalmente bene per un compito, ma potrebbe avere una scarsa performance su un altro.

Un obiettivo fondamentale del machine learning è discernere pattern significativi all’interno di dati disparati. Tuttavia, l’efficacia di un algoritmo dipende spesso dalla natura specifica dei dati a disposizione. Potrebbe rivelarsi molto utile per un tipo di dati, ma meno efficace quando applicato ad un altro.

Ciò diventa evidente quando si considerano i diversi tipi di dati che potremmo incontrare. Qualcosa di semplice come un lancio di moneta genera una semplice distribuzione probabilistica di due pattern.

D’altra parte, esempi praticamente più significativi, come i dati di immagine o di testo, sono molto più complessi. L’universo dei pattern potenziali cresce in modo esponenziale con il numero di pixel, rendendo l’array di possibili configurazioni in un’immagine di 500×500 già incredibilmente grande:

Data la dimensione di questo spazio, come possiamo ancora imparare qualcosa di significativo dai dati?

Una parte importante della risposta è che la maggior parte dei campioni di interesse non è campionata uniformemente dallo spazio di tutti i campioni possibili, ma ha una grande quantità di struttura preesistente rispetto al campionamento casuale.

I dati linguistici servono come un altro esempio classico. La somma di tutte le parole in una qualsiasi lingua consiste in un sottoinsieme di pattern che vive in uno spazio molto più basso quando confrontato con l’insieme di tutte le possibili combinazioni di lettere, qualcosa che è stato utilizzato nei primi modelli statistici semplici del linguaggio (ho approfondito questo argomento nel mio articolo sui chain di Markov).

Per i machine learners, è una grande notizia che ci siano alcuni pattern ricorrenti in molti tipi di dati di input. Ciò significa che possiamo addestrare modelli che imparano ad estrarre questi pattern e possibilmente riutilizzare i modelli per estrarre pattern simili in diverse applicazioni.

La tecnica del transfer learning fa uso esplicito del fatto che la maggior parte dei problemi del mondo reale condividono alcune strutture comuni.

Il transfer learning utilizza modelli pre-addestrati, che già hanno imparato pattern da un grande dataset, per adattarsi e “fine-tune” a un compito diverso ma correlato. Un modello addestrato per riconoscere oggetti in immagini potrebbe aver appreso caratteristiche a basso livello come bordi e gradienti di colore e caratteristiche ad alto livello come forme. Queste caratteristiche apprese potrebbero poi essere applicate a un compito correlato, come il riconoscimento di cifre scritte a mano o la classificazione di tumori nelle immagini mediche.

Hubel e Wiesel l’hanno capito quando hanno scoperto che la corteccia visiva è composta da strati gerarchici che si occupano di pattern sempre più complessi, vincendo il premio Nobel nel 1981. Dall’avvento delle Convolutional Neural Networks (CNN), il loro lavoro è stato ampiamente discusso in relazione agli algoritmi di machine learning.

Nella corteccia visiva primaria, ad esempio, le cellule semplici rilevano i bordi e i gradienti di colore, mentre le cellule complesse aggregano le uscite di queste cellule semplici per riconoscere pattern più ampi, come il movimento o forme specifiche. Andando più a fondo nel sistema visivo, i pattern riconosciuti dai neuroni diventano sempre più complessi, passando da forme geometriche semplici a volti e oggetti intricati, fino alla famigerata nonna-neurone che si attiva solo quando vedi la tua nonna (o quando assaggi i madeleine che ti ha dato da bambino).

Allo stesso modo, i livelli di una CNN estraggono caratteristiche di complessità crescente. Nei livelli iniziali, la CNN potrebbe imparare a rilevare strutture semplici, come linee, angoli e macchie di colore. Man mano che avanziamo nei livelli, queste caratteristiche semplici vengono combinate per formare rappresentazioni più complesse: cerchi, rettangoli e infine oggetti distinguibili che iniziano a somigliare a gatti, cani o elefanti.

Forse queste somiglianze non dovrebbero sorprenderci: entrambi i sistemi sono evoluti e sono stati progettati, rispettivamente, per sfruttare la struttura intrinseca dei dati visivi. Questa comprensione del tipo di pattern che si verificano più frequentemente in tutti i tipi di scene visive può essere riutilizzata o trasferita per gestire compiti diversi ma correlati, come discusso in precedenza.

Qui entra in gioco il concetto di transfer learning e la capacità del cervello di adattarsi e imparare. Un bambino che impara a riconoscere una bicicletta non parte da zero quando impara a riconoscere una motocicletta. Trasferisce la sua comprensione della struttura di base della bicicletta da un contesto all’altro. Allo stesso modo, una CNN addestrata su una varietà di immagini non ha bisogno di riapprendere il concetto di “bordo” quando passa dal riconoscimento dei volti al riconoscimento dei numeri scritti a mano.

Il nostro cervello ha scoperto la stessa verità che sottende il ‘tipo di pranzo gratis’ di cui ho discusso nel titolo: il mondo che ci è utile è molto lontano dall’essere uniformemente casuale, ma piuttosto pieno di pattern e strutture ricorrenti. Poiché questi pattern sono ciò che ci interessa, il nostro cervello è cablato per percepirli selettivamente.

Possiamo addirittura andare un po’ oltre semplicemente dicendo che siamo fortunati che ci siano pattern significativi nel mondo. Le moderne teorie di neuroscienze cognitive vedono il cervello più come una macchina di previsione che come uno strumento di percezione della ‘realtà’.

L’ipotesi del cervello bayesiano, ad esempio, suggerisce che il nostro cervello stia costantemente facendo previsioni probabilistiche sul mondo, aggiornando queste previsioni in base agli input sensoriali. La nostra percezione del mondo, quindi, non è un processo passivo ma attivo. Non percepiamo semplicemente il mondo per come è, ma lo interpretiamo attivamente in base ai nostri prior, alcuni basati sulle nostre esperienze ricordate, ma alcuni risalenti a prior strutturali indotti dall’esperienza passata di miliardi di anni di evoluzione.

Il componente attivo e basato sui prior della cognizione ha un’influenza così significativa sulla nostra percezione che scienziati come Anil Seth hanno definito l’attività del nostro cervello come qualcosa di simile a una ‘allucinazione controllata’.

Ciò si collega anche all’idea provocatoria di Donald Hoffman (il caso contro la realtà) secondo cui non percepiamo la realtà per come è, ma che si è sviluppata nel corso di milioni di anni come un’interfaccia utente, il cui obiettivo principale è aiutare la nostra sopravvivenza. Le icone sulla scrivania del tuo computer, ad esempio, non rivelano la realtà di ciò che sta accadendo all’interno della macchina, ma forniscono un’interfaccia che facilita l’utilizzo del computer.

Ciò che percepiamo come una mela rossa, ad esempio, non è l’apple stessa ma una rappresentazione che ci guida verso il cibo nutritivo. I nostri sistemi percettivi, quindi, impongono un forte prior sui nostri input sensoriali, filtrando una grande parte dei dati che non si adatta ai nostri modelli preesistenti o che non contribuisce direttamente alla nostra sopravvivenza. Questo bias verso i pattern salienti e lontano dal rumore percepito (l’insieme di tutti i possibili pattern visivi come quello rumoroso che ho mostrato sopra) rispecchia la struttura che abbiamo discusso e che sottende il transfer learning e il ‘tipo di pranzo gratis’ nell’apprendimento automatico.

I nostri cervelli sono come modelli pre-addestrati che hanno imparato a concentrarsi solo su determinati schemi nel mondo, aiutandoci a gestire il costante flusso di nuovi input sensoriali.

Man mano che invecchiamo, diventiamo meno propensi a invertire il nostro modello e affinarlo quando compaiono schemi invisibili, e più camminiamo in giro con una macchina di inferenza nella nostra testa che è l’epitome del pranzo gratuito (auto-percepito): per andare con il meme, il “vecchio uomo bianco” è qualcuno che sta spiegando ogni cosa che incontra attraverso la lente del suo modello di mondo già saldamente stabilito che (nella sua mente) è l’algoritmo universale che gli garantisce un pranzo gratuito per ogni problema di apprendimento che incontra.

Scherzi a parte, mentre il trasferimento di apprendimento all’interno delle modalità è cruciale, la nostra discussione si estende perfettamente agli sviluppi attuali nell’ambiente multimodale, sia in neuroscienze che in apprendimento automatico.

Il cervello ha una sorprendente capacità di riorganizzarsi, nota come neuroplasticità, una capacità spesso osservata dopo ictus o altri casi drammatici di perdita sensoriale.

La perdita sensoriale porta spesso al riprosciutto di alcune aree cerebrali. Gli individui ciechi, ad esempio, sviluppano spesso un senso dell’udito e del tatto più elevato. Questo non è semplicemente una questione di maggiore attenzione o pratica. La ricerca ha dimostrato che la corteccia visiva, che normalmente elabora le informazioni visive, diventa attiva durante compiti uditivi e tattili negli individui ciechi (il libro Livewired di David Eagleman fornisce un fantastico resoconto del ruolo centrale che la neuroplasticità svolge nel cervello).

È come se il cervello abbia preso una rete neurale pre-addestrata su compiti visivi e, trovandosi a non ricevere più input visivi, l’abbia affinata per elaborare informazioni uditive e tattili.

Allo stesso modo, è stato riscontrato che gli individui sordi utilizzano aree del cervello generalmente associate all’elaborazione del linguaggio parlato, come le aree di Broca e Wernicke, mentre utilizzano la lingua dei segni. Queste aree sono dedicate alla comunicazione in modo più ampio, indipendentemente dalla specifica modalità di quella comunicazione. La rete del linguaggio del cervello è abbastanza flessibile da gestire diverse forme di comunicazione, sia essa parlata, scritta o segnata.

Questi casi di neuroplasticità ci mostrano che i calcoli del nostro cervello sono sostenuti da una forma di algoritmo di apprendimento universale, in grado di elaborare una vasta gamma di schemi, non solo quelli tipicamente associati a una specifica modalità sensoriale. Ciò su cui si basa precisamente questo algoritmo è oggetto di dibattito (vedi ad esempio i “mille cervelli” di Jeff Hawkin o i riconoscitori di pattern di Kurzweil per spiegazioni neuroscientifiche popolari, e il libro “The Master Algorithm” di Pedro Domingues per una prospettiva informatica), ma la neuroplasticità indica chiaramente che qualcosa di simile esiste.

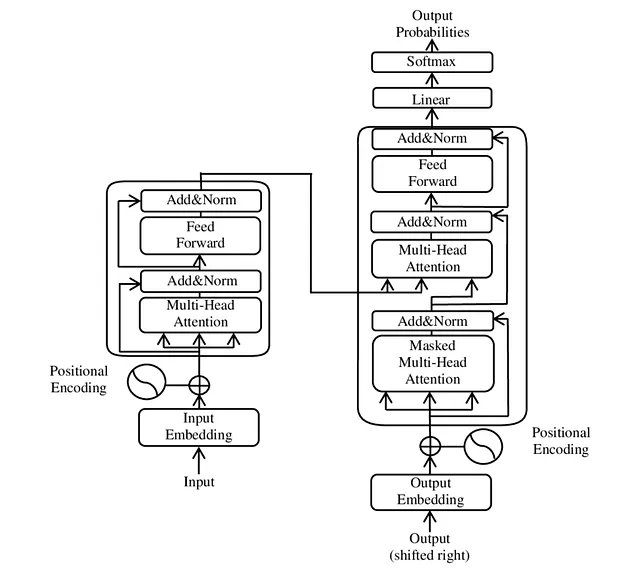

La versatilità del cervello è anche rispecchiata dai nostri modelli di apprendimento automatico più avanzati. Mentre i Transformers sono stati inizialmente sviluppati per l’elaborazione del linguaggio naturale, rispecchiando il bias induttivo del linguaggio, sono stati successivamente applicati a una vasta gamma di tipi di dati, dalle immagini all’audio ai dati di serie temporali (se questo è principalmente un risultato dell’attuale hype intorno ad essi può essere discusso). Proprio come la corteccia visiva nelle persone cieche può riprogettarsi per compiti uditivi o tattili, i Transformers possono essere adattati per una varietà di tipi di dati, suggerendo l’esistenza di schemi universali che questi modelli possono catturare, indipendentemente dalla specifica modalità di input (in tutta onestà, questo potrebbe anche essere in parte perché i Transformers sono ben adattati ad essere ottimizzati sulle nostre attuali architetture di elaborazione, poiché possono essere pesantemente parallelizzati).

Citando l’originale NFL paper di Wolpert e Macready: “qualsiasi due algoritmi di ottimizzazione sono uguali quando le loro prestazioni sono mediate su tutti i possibili problemi”. Ma parafrasando Orwell, quando guardiamo alla maggior parte dei problemi che ci interessano davvero, alcuni algoritmi di ottimizzazione sono più uguali di altri.

Ad esempio, l’applicazione dei Transformers ai dati delle immagini ha portato a modelli come i Vision Transformers, che trattano un’immagine come una sequenza di patch e applicano lo stesso meccanismo di autoattenzione.

Questa idea è ulteriormente esemplificata nei Transformers multimodali, che possono processare e comprendere contemporaneamente più tipi di dati. Gli embedding di testo e immagini come il modello CLIP, sono addestrati per comprendere contemporaneamente immagini e le loro descrizioni testuali correlate. CLIP apprende la relazione incorporando entrambe le modalità in uno spazio di embedding comune.

Questi modelli sfruttano le strutture comuni tra diversi tipi di dati e creano efficacemente un sistema di “traduzione” tra di essi. Un esempio sorprendente di questa capacità di CLIP è ormai familiare alla maggior parte di noi: fornendo la base per modelli basati sulla diffusione come DALL-E, ci permettono di generare immagini impressionanti solo a partire da descrizioni testuali.

Che questo funzioni così bene potrebbe anche non essere del tutto una coincidenza: le unità fondamentali di significato nel linguaggio potrebbero avere corrispondenti nell’elaborazione visiva, e la percezione visiva potrebbe anche essere compresa in termini di un insieme finito di modelli visivi di base o “parole visive”.

Nel linguaggio, le unità più significative per gli esseri umani, come “gatto”, “cane” o “amore”, sono brevi, e il linguaggio è strutturato secondo gli stessi concetti che hanno salienza per noi nelle scene visive: molto probabilmente, internet presenta più immagini di gatti che di ammassi rumorosi di colori. Più in generale, è importante notare che il linguaggio è già una modalità derivata, e una modalità che grandi gruppi di persone sviluppano congiuntamente per condensare tutte le cose che sono più importanti per loro in una rappresentazione simbolica concisa.

Forse il fatto che ci sia “un po’ di pranzo gratis” si riferisce anche all’intelligenza artificiale generale (AGI), dal momento che un AGI è un algoritmo che riesce a ottenere un po’ di pranzo gratis dalla maggior parte delle applicazioni.

Pensate a Chat-GPT: mentre i modelli GPT sono stati addestrati interamente sul testo, stanno cominciando a mostrare la capacità di comprendere, ragionare e comunicare sul mondo in generale, ben al di là dei limiti dei dati testuali. Nonostante siano stati addestrati solo per prevedere dati testuali, questi modelli sembrano scoprire qualche tipo di logica universale che va oltre il testo, estendendosi a diverse modalità e dimensioni della comprensione.

In particolare, quando vengono co-addestrati con altre modalità, i LLM stanno andando oltre la descrizione testuale di quella modalità ma invece comprendono i modelli sottostanti alle modalità e possono generare idee nuove da esse, simile a quello che fanno i cervelli.

Credo che una delle ragioni per cui le persone (tra cui me stesso) sono rimaste così sorprese dal successo dei LLM nell’ottenere un’intelligenza generalizzante sia che abbiamo collettivamente sottovalutato fino a che punto il mondo percettivo che è più saliente per noi si basa già sulla universalità dei modelli e sulla corrispondente universalità di un algoritmo di apprendimento nel nostro cervello.

Anche se il teorema del pranzo gratis è vero in teoria, è anche evidente che la maggior parte dei problemi che ci preoccupano di più sono lontani dall’universalità dal punto di vista statistico. Invece, tendono a occupare uno spazio a bassa dimensione principalmente incentrato sulla visione, il linguaggio e il suono, la sfera primaria di interesse e salienza umana.

Nell’emergere di modelli di lingua ampia multimodali, abbiamo un quadro algoritmico che sfrutta queste rappresentazioni a bassa dimensionalità e cross-modalità. Offre una visione entusiasmante e leggermente spaventosa del potenziale dell’AGI e del modo in cui potrebbe cambiare il nostro mondo e la nostra comprensione del mondo.