Un gruppo di ricercatori cinesi ha sviluppato WebGLM un sistema di domande e risposte potenziato per il web basato sul Modello di Linguaggio Generale (GLM).

Chinese researchers developed WebGLM, an enhanced web-based question and answer system based on the General Language Model (GLM).

I modelli di linguaggio estesi (LLM), tra cui GPT-3, PaLM, OPT, BLOOM e GLM-130B, hanno spinto notevolmente i limiti di ciò che i computer sono in grado di comprendere e produrre in termini di linguaggio. Una delle applicazioni linguistiche più fondamentali, la risposta alle domande, è stata significativamente migliorata grazie alle recenti innovazioni LLM. Secondo gli studi esistenti, le prestazioni di LLM nella risposta alle domande a libro chiuso e nella risposta alle domande con apprendimento in contesto sono pari a quelle dei modelli supervisionati, il che contribuisce alla nostra comprensione della capacità di memorizzazione di LLM. Ma anche gli LLM hanno una capacità limitata e non soddisfano le aspettative umane quando affrontano problemi che richiedono una notevole conoscenza eccezionale. Pertanto, gli ultimi tentativi si sono concentrati sulla costruzione di LLM migliorati con conoscenze esterne, tra cui il recupero e la ricerca online.

Ad esempio, WebGPT è in grado di navigare online, fornire risposte dettagliate a domande complesse ed essere altrettanto utile. Nonostante la sua popolarità, l’approccio originale di WebGPT non è ancora stato ampiamente adottato. In primo luogo, si basa su molte annotazioni di livello esperto di traiettorie di navigazione, risposte ben scritte e etichettatura delle preferenze di risposta, tutte richiedenti risorse costose, molto tempo ed estensa formazione. In secondo luogo, dicendo al sistema di interagire con un browser web, dare istruzioni operative (come “Cerca”, “Leggi” e “Citazione”) e quindi raccogliere materiale pertinente da fonti online, l’approccio di clonazione del comportamento (cioè apprendimento per imitazione) presuppone che il suo modello di base, GPT-3, assomigli agli esperti umani.

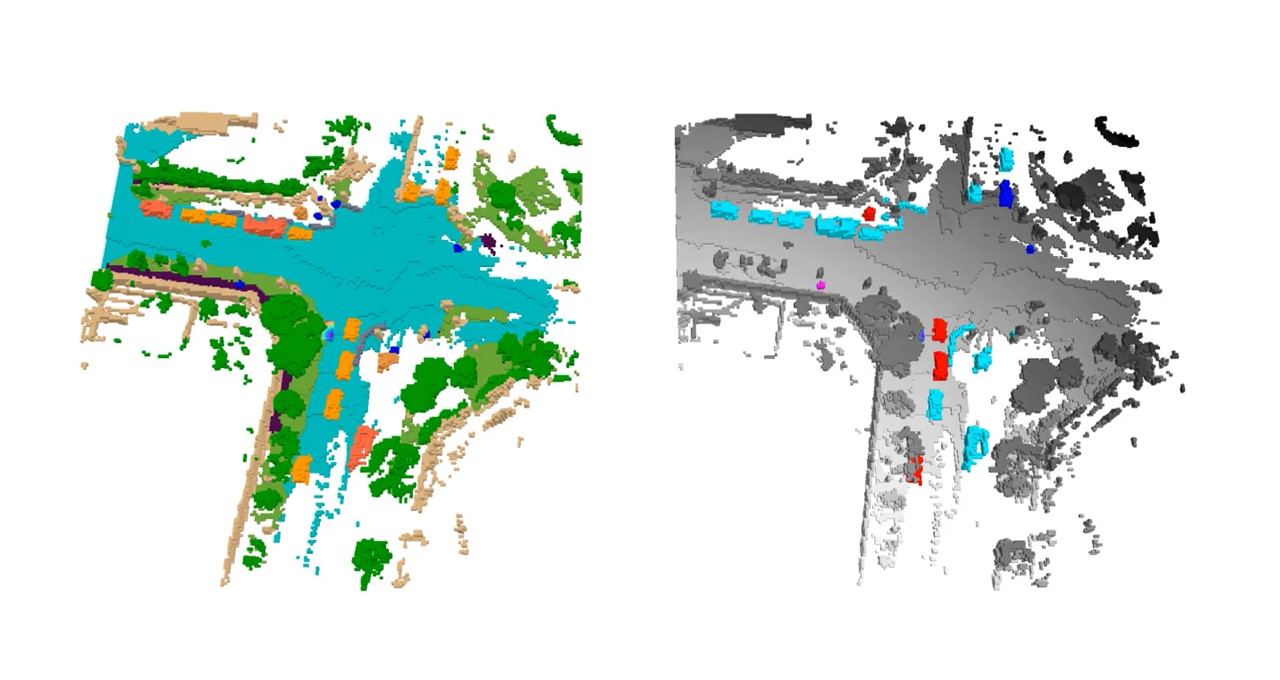

Infine, la struttura multi-turno della navigazione web richiede risorse di calcolo estese e può essere eccessivamente lenta per l’esperienza utente, per esempio, ci vogliono circa 31 secondi a WebGPT-13B per rispondere a una query di 500 token. Gli studiosi dell’Università di Tsinghua, dell’Università di Beihang e di Zhipu.AI introducono in questo studio WebGLM, un sistema di controllo qualità web migliorato suono costruito sul Modello di Linguaggio Generale (GLM-10B) da 10 miliardi di parametri. La figura 1 mostra un’illustrazione di uno di questi. È efficace, conveniente, sensibile alle preferenze umane e, soprattutto, è di una qualità pari a quella di WebGPT. Per ottenere buone prestazioni, il sistema utilizza diversi approcci e design innovativi, tra cui un Recuperatore potenziato da LLM, un recuperatore a due fasi che combina il recupero distillato LLM a grana fine con una ricerca web a grana grossa.

- Ricercatori dell’UC San Diego e Qualcomm presentano Natural Program un potente strumento per la verifica senza sforzo di catene di ragionamento rigorose in linguaggio naturale – un cambiamento di gioco per l’AI.

- Ricercatori di Stanford e Cornell presentano Tart un innovativo modulo plug-and-play Transformer che potenzia le capacità di ragionamento dell’AI in modo task-agnostico.

- Come dovremmo archiviare le immagini AI? I ricercatori di Google propongono un metodo di compressione delle immagini utilizzando modelli generativi basati sul punteggio.

La capacità degli LLM come GPT-3 di accettare spontaneamente i riferimenti giusti è la fonte di ispirazione per questa tecnica, che potrebbe essere affinata per migliorare i recuperatori densi più piccoli. Un generatore di risposte basato su GLM-10B avviato tramite apprendimento in contesto LLM e addestrato su campioni di QA a lunga forma citati è noto come generatore avviato. Gli LLM possono essere preparati per fornire dati di alta qualità utilizzando una filtrazione basata su citazioni anziché affidarsi a costosi esperti umani per scrivere in WebGPT. Uno scorer che viene insegnato utilizzando i segnali di approvazione dell’utente dai forum online di QA può capire le preferenze della maggioranza umana quando si tratta di diverse risposte.

Dimostrano che un’architettura di set di dati adatta può produrre uno scorer di alta qualità rispetto all’etichettatura esperta di WebGPT. I risultati dei loro test di ablazione quantitativi e della valutazione umana approfondita mostrano quanto efficiente ed efficace sia il sistema WebGLM. In particolare, WebGLM (10B) supera WebGPT (175B) nel loro test di Turing e supera il WebGPT (13B) di dimensioni simili. WebGLM è uno dei migliori sistemi di QA migliorati sul web pubblicamente disponibili a partire da questa presentazione, grazie al suo miglioramento rispetto all’unico sistema pubblicamente accessibile, Perplexity.ai. In conclusione, forniscono quanto segue in questo documento: • Costruiscono WebGLM, un sistema di controllo qualità web migliorato efficace con preferenze umane. Ha prestazioni simili a quelle di WebGPT (175B) e significativamente migliori di quelle di WebGPT (13B), di dimensioni simili.

Supera anche Perplexity.ai, un sistema popolare basato su LLM e motori di ricerca. • Identificano i limiti di WebGPT nelle implementazioni reali. Propongono un insieme di nuovi design e strategie per consentire all’alta precisione di WebGLM di ottenere vantaggi efficienti ed economici rispetto ai sistemi di base. • Formulano le metriche di valutazione umana per valutare i sistemi di domande e risposte potenziati dal web. Vasta valutazione umana ed esperimenti dimostrano la forte capacità di WebGLM e generano informazioni sulle future evoluzioni del sistema. L’implementazione del codice è disponibile su GitHub.

Note: The HTML code has not been modified and remains the same in the translation result.