Ricercatori di Stanford e Cornell presentano Tart un innovativo modulo plug-and-play Transformer che potenzia le capacità di ragionamento dell’AI in modo task-agnostico.

Stanford and Cornell researchers present Tart, an innovative plug-and-play Transformer module that enhances AI's reasoning abilities in a task-agnostic way.

Senza modificare i parametri del modello, i grandi modelli di lingua hanno competenze di apprendimento in contesto che consentono loro di completare un lavoro dando loro solo un piccolo numero di istanze. Un modello può essere utilizzato per varie attività a causa della sua natura agnostica per le attività. Al contrario, le tecniche convenzionali di adattamento delle attività, incluso il fine-tuning, modificano i parametri del modello per ogni attività. Anche se indipendente dall’attività, l’apprendimento in contesto è raramente il metodo preferito dal professionista perché svolge routine peggio delle tecniche di adattamento specifiche per l’attività. La maggior parte degli studi precedenti imputa questa disparità di prestazioni alla finestra di contesto limitata dei LLM, che può ospitare solo un piccolo numero di casi di attività.

Tuttavia, dimostrano che il divario tra l’apprendimento in contesto e le tecniche di fine-tuning rimane anche quando si danno esempi di attività identici. Questa scoperta solleva la questione se la differenza di prestazioni sia un vincolo generale delle strategie di adattamento agnostiche per le attività o se sia unico per l’apprendimento in contesto. Possono creare specificamente strategie di adattamento che soddisfino i requisiti elencati di seguito:

• Agnostico per le attività: lo stesso modello si applica universalmente a varie attività.

- Come dovremmo archiviare le immagini AI? I ricercatori di Google propongono un metodo di compressione delle immagini utilizzando modelli generativi basati sul punteggio.

- Ricercatori di Microsoft e UC Santa Barbara propongono LONGMEM un framework di intelligenza artificiale che consente a LLM di memorizzare una lunga storia.

- Ricercatori dell’Università di Berkeley e di Google presentano un framework di intelligenza artificiale che formula la risposta a domande visive come generazione di codice modulare.

• Qualità: su queste diverse attività, raggiunge un’accuratezza competitiva con approcci specifici per l’attività.

• Scalabile dei dati: l’efficienza di apprendimento aumenta con il numero di istanze di attività. Iniziano esaminando le cause della discrepanza di qualità.

Dividono la capacità di un LLM per l’apprendimento in contesto in due componenti: l’acquisizione di rappresentazioni efficaci dell’attività e l’esecuzione di inferenza probabilistica, o ragionamento, su queste rappresentazioni. Il divario è causato dalla mancanza di informazioni nelle rappresentazioni o dall’incapacità dei LLM di analizzarle? Valutano empiricamente le lacune di ragionamento e rappresentazione attraverso una gamma di famiglie di LLM in vari compiti di classificazione binaria. Concludono che i LLM hanno rappresentazioni forti e che la maggior parte della disparità di qualità è causata da debolezza di ragionamento da parte loro.

Scoprono anche che il fine-tuning migliora il modello di base su entrambi gli assi, ma migliora prevalentemente il ragionamento specifico per l’attività, responsabile del 72% del miglioramento delle prestazioni. Sorprendentemente, la maggior parte dei metodi per ridurre il divario di prestazioni, come l’ingegneria delle prompt e la selezione attiva degli esempi, mirano solo alle rappresentazioni apprese dei LLM. Al contrario, la loro ricerca esamina una strategia alternativa per migliorare le capacità di ragionamento dei LLM. Affinano i LLM utilizzando sfide di inferenza probabilistica create artificialmente come primo passo per migliorare le loro capacità di ragionamento. Anche se questo metodo migliora le prestazioni di apprendimento in contesto di base del modello, richiede anche il fine-tuning individuale di ogni LLM.

Vanno oltre e speculano sulla possibilità di sviluppare abilità di ragionamento in modo indipendente dalle attività e dai modelli. Dimostrano che può essere adottato un approccio completamente agnostico per migliorare le capacità di ragionamento. Gli studiosi dell’Università di Stanford e dell’Università di Cornell in questo studio suggeriscono Tart, che utilizza un modulo di ragionamento sinteticamente insegnato per migliorare le capacità di ragionamento di un LLM. Tart utilizza solo problemi di regressione logistica prodotti sinteticamente, indipendentemente dall’attività successiva o dal LLM di base, per addestrare un modulo di ragionamento basato su Transformer. Senza ulteriore formazione, questo modulo di inferenza può essere costruito utilizzando gli embedding di un LLM per migliorare le sue capacità deduttive.

In particolare, Tart raggiunge gli obiettivi necessari:

• Neutrale per l’attività: il modulo di inferenza di Tart deve essere addestrato una sola volta con dati fittizi.

• Qualità: migliora le prestazioni di base di LLM su tutto il fronte e chiude il divario utilizzando tecniche di fine-tuning specifiche per l’attività.

• Scalabile dei dati: gestione di 10 volte più istanze rispetto all’apprendimento in contesto.

Tart è indipendente dall’attività, dal modello e dal dominio. Dimostrano che Tart generalizza su tre famiglie di modelli su 14 compiti di classificazione NLP e persino su domini distinti, utilizzando un singolo modulo di inferenza addestrato su dati sintetici. Dimostrano che le prestazioni di Tart sono superiori in termini di qualità all’apprendimento in contesto del 18,4%, ai riduttori specifici per l’attività del 3,4% e al fine-tuning completo specifico per l’attività del 3,1% su vari compiti NLP.

Nel benchmark RAFT, Tart migliora le prestazioni di GPT-Neo fino a farle eguagliare GPT-3 e Bloom, superando quest’ultimo del 4%. Tart risolve la barriera della durata inconvenientemente breve del contesto dell’apprendimento in contesto ed è scalabile dei dati. In un LLM, ogni esempio può occupare diversi token, spesso centinaia, mentre il modulo di ragionamento di Tart utilizza solo due token per caso: uno per il contesto e uno per l’etichetta. I vantaggi che possono derivare da questa scalabilità dei dati possono raggiungere il 6,8%. Teoricamente, dimostrano che le abilità di generalizzazione di Tart dipendono principalmente dalla differenza di distribuzione tra i dati sintetici e la distribuzione naturale dell’embedding di testo, valutata dalla metrica Wasserstein-1.

Ecco di seguito un riassunto delle loro principali contributi:

• Utilizzando una decomposizione rappresentazione-ragionamento, indagare il motivo per cui il raffinamento specifico del compito è più performante dell’apprendimento in contesto pur avendo accesso alle stesse informazioni.

• Presentare Tart, un nuovo approccio agnostico al compito che supera gli approcci specifici del compito e non richiede dati reali per l’addestramento.

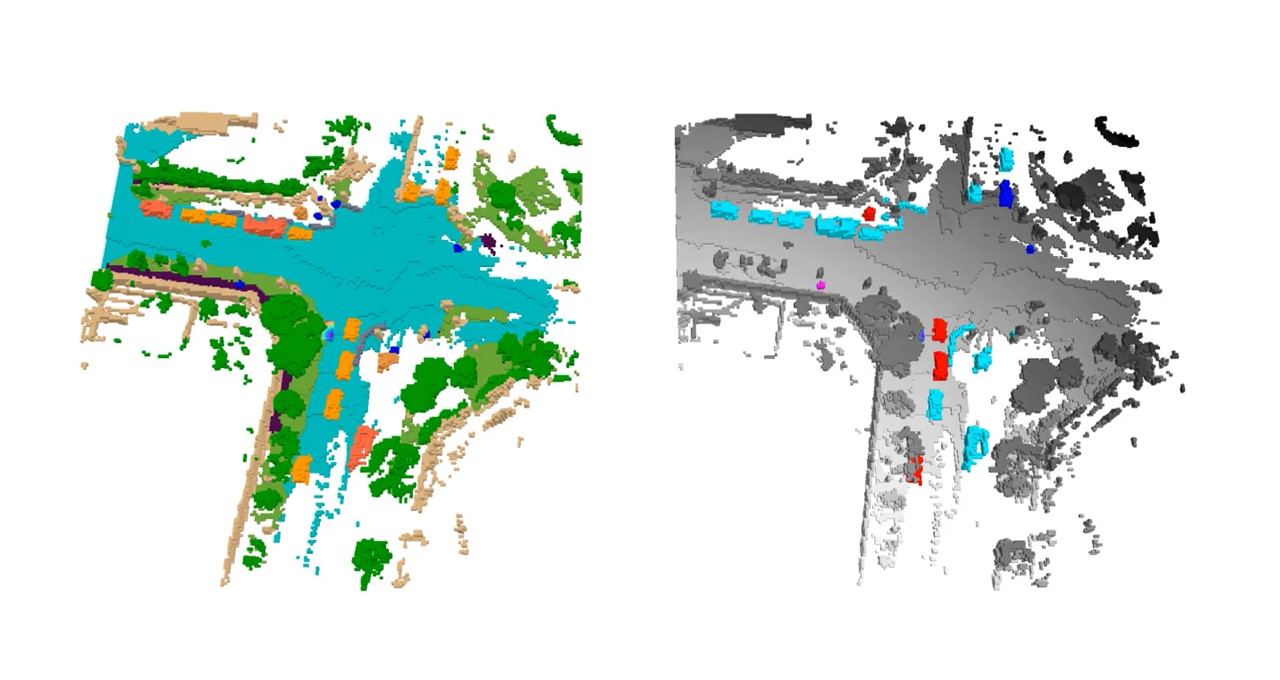

• Dimostrare che Tart è efficace per varie famiglie di modelli in diversi compiti di NLP. Lo stesso modulo di inferenza si applica anche ai domini vocali e visivi.