Ricercatori dell’Università di Berkeley e di Google presentano un framework di intelligenza artificiale che formula la risposta a domande visive come generazione di codice modulare.

Researchers from Berkeley University and Google present an AI framework that formulates the answer to visual questions as modular code generation.

Il dominio dell’Intelligenza Artificiale (AI) sta evolvendo e avanzando con il rilascio di ogni nuovo modello e soluzione. I Large Language Models (LLM), che recentemente hanno ottenuto molta popolarità grazie alle loro incredibili capacità, sono la principale ragione dell’aumento dell’AI. I sottodomini dell’AI, sia che si tratti di Elaborazione del Linguaggio Naturale, Comprensione del Linguaggio Naturale o Visione Artificiale, stanno tutti progredendo, e per tutte buone ragioni. Un’area di ricerca che ha recentemente suscitato molto interesse dalle comunità di AI e deep learning è la Visual Question Answering (VQA). La VQA è il compito di rispondere a domande basate su testo aperte su un’immagine.

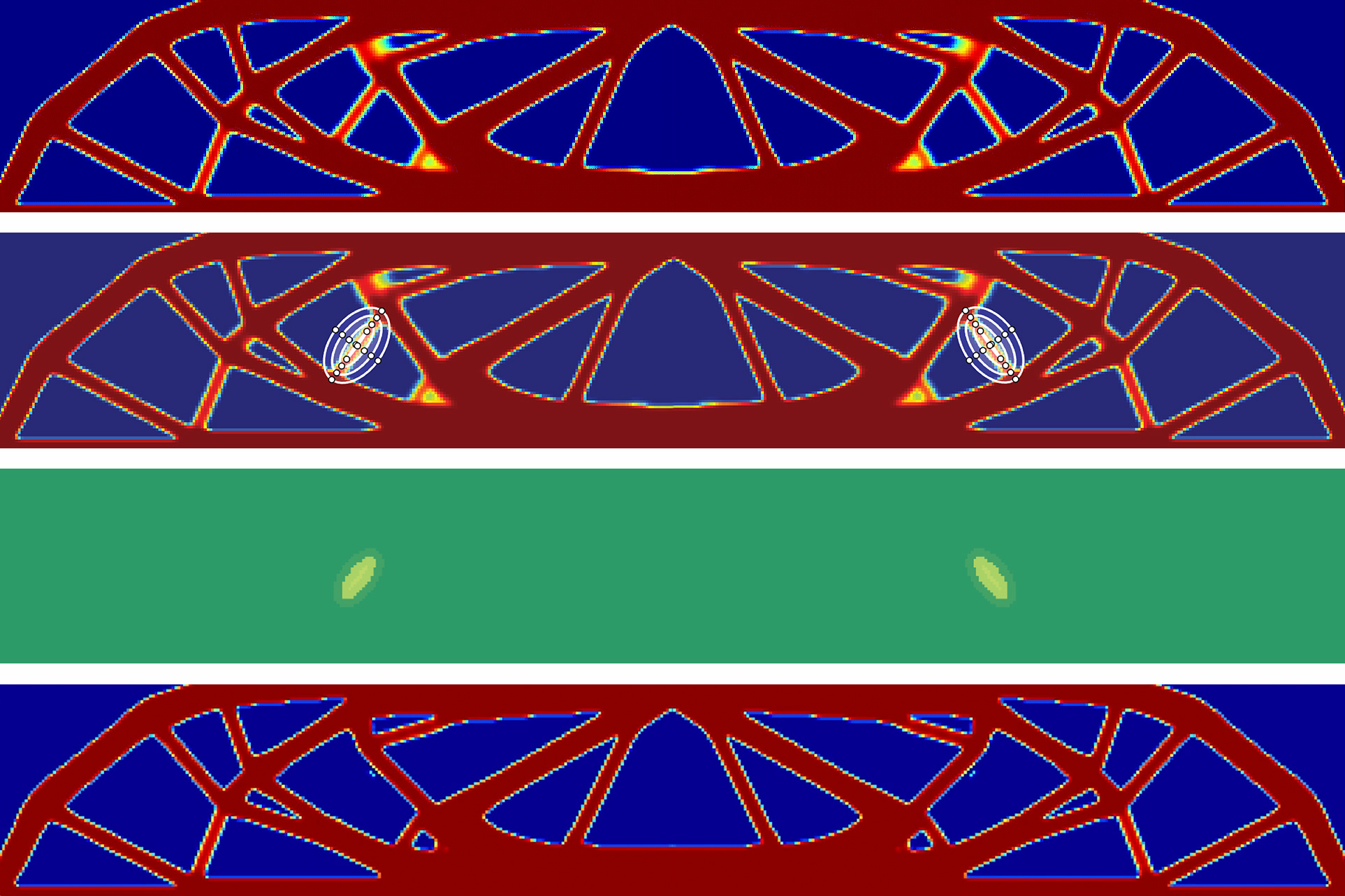

I sistemi che adottano la Visual Question Answering cercano di rispondere in modo appropriato a domande in linguaggio naturale riguardanti un input sotto forma di immagine, e questi sistemi sono progettati in modo che comprendano i contenuti di un’immagine in modo simile a come fanno gli esseri umani e quindi comunicano efficacemente le scoperte. Recentemente, un team di ricercatori dell’UC Berkeley e di Google Research ha proposto un approccio chiamato CodeVQA che affronta la visual question answering utilizzando la generazione di codice modulare. CodeVQA formula la VQA come un problema di sintesi di programmi e utilizza modelli di linguaggio di scrittura di codice che prendono domande in input e generano codice in output.

Lo scopo principale di questo framework è creare programmi Python che possono chiamare modelli visivi pre-addestrati e combinare le loro uscite per fornire risposte. I programmi prodotti manipolano le uscite del modello visivo e derivano una soluzione utilizzando la logica aritmetica e condizionale. A differenza degli approcci precedenti, questo framework utilizza modelli di linguaggio pre-addestrati, modelli di visione pre-addestrati basati su coppie immagine-didascalia, un numero limitato di campioni VQA e modelli di visione pre-addestrati per supportare l’apprendimento in contesto.

- Rivoluzionando la navigazione ricercatori del MIT svelano un nuovo approccio di apprendimento automatico per la stabilizzazione dei veicoli autonomi e l’evitamento degli ostacoli.

- Un team di ricerca composto da Google, Cornell e UC Berkeley ha presentato OmniMotion un metodo di intelligenza artificiale rivoluzionario per la stima del movimento denso e a lungo raggio nei video.

- NVIDIA Research vince la sfida di guida autonoma e il premio per l’innovazione al CVPR.

Per estrarre informazioni visive specifiche dall’immagine, come didascalie, posizioni di pixel delle cose o punteggi di similarità immagine-testo, CodeVQA utilizza API visive primitive avvolte attorno a modelli di linguaggio visivo. Il codice creato coordina varie API per raccogliere i dati necessari, quindi utilizza l’intera espressività del codice Python per analizzare i dati e ragionare su di essi utilizzando la matematica, le strutture logiche, i cicli di feedback e altri costrutti di programmazione per arrivare a una soluzione.

Per la valutazione, il team ha confrontato le prestazioni di questa nuova tecnica con una baseline a pochi scatti che non utilizza la generazione di codice per valutarne l’efficacia. COVR e GQA sono i due dataset di benchmark utilizzati nella valutazione, tra cui il dataset GQA include domande multihop create da grafi di scena di singole foto Visual Genome che gli esseri umani hanno annotato manualmente, e il dataset COVR contiene domande multihop su insiemi di immagini nei dataset Visual Genome e imSitu. I risultati hanno mostrato che CodeVQA ha funzionato meglio su entrambi i dataset rispetto alla baseline. In particolare, ha mostrato un miglioramento dell’accuratezza di almeno il 3% nel dataset COVR e di circa il 2% nel dataset GQA.

Il team ha menzionato che CodeVQA è semplice da implementare e utilizzare perché non richiede alcuna formazione aggiuntiva. Utilizza modelli pre-addestrati e un numero limitato di campioni VQA per l’apprendimento in contesto, il che aiuta a personalizzare i programmi creati a particolari modelli domanda-risposta. In sintesi, questo framework è potente e utilizza la forza di LLM e modelli visivi pre-addestrati, fornendo un approccio modulare e basato su codice alla VQA.