Addestrare le macchine affinché imparino in modo più simile a quello umano

Train machines to learn more like humans.

I ricercatori identificano una proprietà che aiuta i modelli di visione artificiale a imparare a rappresentare il mondo visivo in modo più stabile e prevedibile.

Immagina di sedere su una panchina in un parco, guardando qualcuno passeggiare. Mentre la scena può cambiare costantemente mentre la persona cammina, il cervello umano può trasformare quella dinamica informazione visiva in una rappresentazione più stabile nel tempo. Questa capacità, nota come raddrizzamento percettivo, ci aiuta a prevedere la traiettoria della persona che cammina.

- Utilizzando le riflessioni per vedere il mondo da nuovi punti di vista

- La prima grande sfida J-WAFS mira a sviluppare varianti di colture migliorate e a trasferirle dal laboratorio al campo.

- I ricercatori utilizzano l’AI per identificare materiali simili in immagini.

A differenza degli esseri umani, i modelli di visione artificiale dei computer di solito non mostrano una percezione rettilinea, quindi imparano a rappresentare le informazioni visive in modo altamente imprevedibile. Ma se i modelli di apprendimento automatico avessero questa capacità, potrebbe consentire loro di stimare meglio come si muoveranno oggetti o persone.

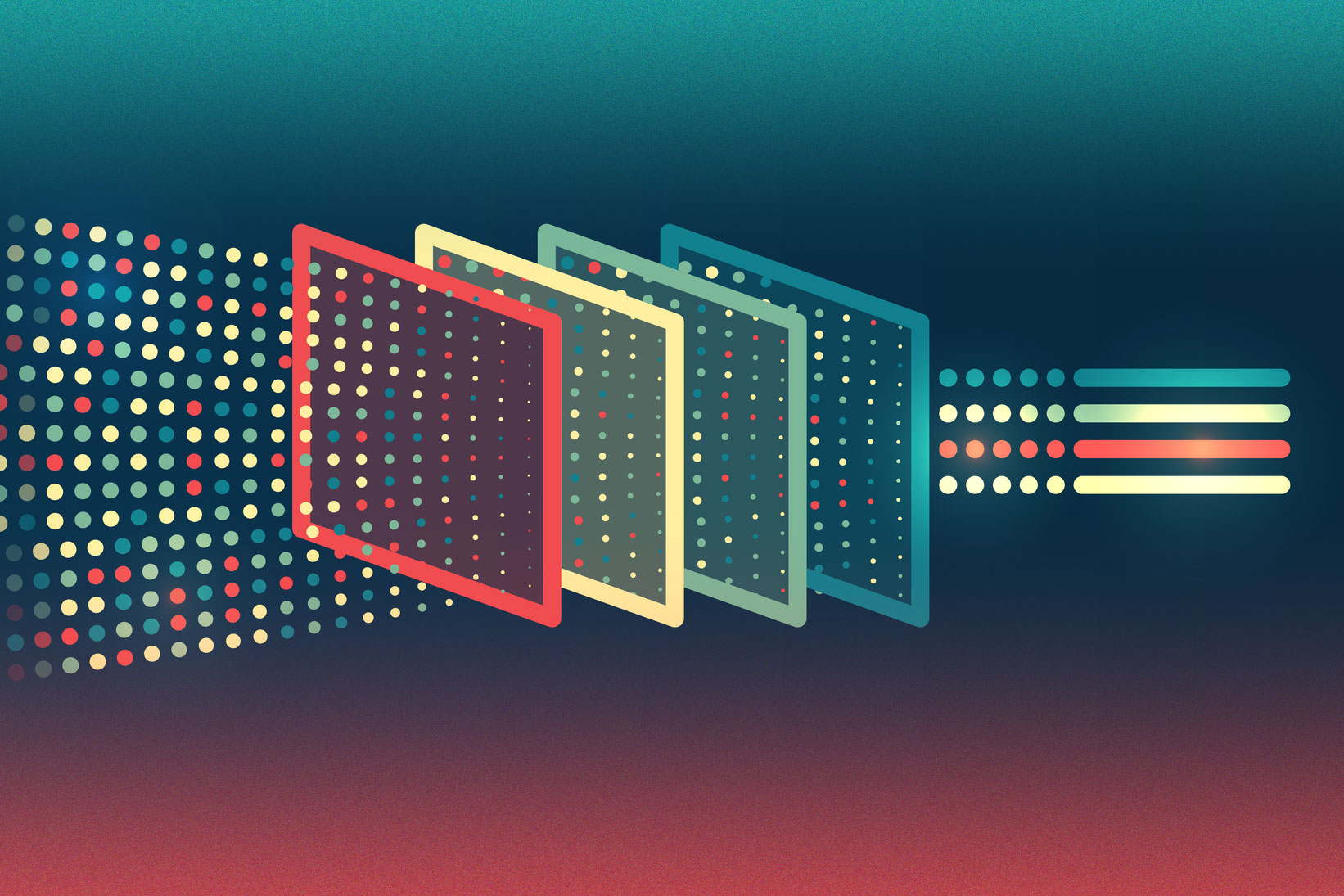

I ricercatori del MIT hanno scoperto che un metodo di formazione specifico può aiutare i modelli di visione artificiale dei computer a imparare rappresentazioni più percettivamente rettilinee, come fanno gli esseri umani. La formazione prevede di mostrare a un modello di apprendimento automatico milioni di esempi in modo che possa apprendere un compito.

I ricercatori hanno scoperto che la formazione dei modelli di visione artificiale dei computer utilizzando una tecnica chiamata formazione avversaria, che li rende meno reattivi agli errori minimi aggiunti alle immagini, migliora la rettilineità percettiva dei modelli.

Il team ha anche scoperto che la rettilinearità percettiva è influenzata dal compito per il quale si addestra un modello. I modelli addestrati a svolgere compiti astratti, come la classificazione delle immagini, apprendono rappresentazioni più percettivamente rettilinee rispetto a quelli addestrati a svolgere compiti più dettagliati, come l’assegnazione di ogni pixel di un’immagine a una categoria.

Ad esempio, i nodi all’interno del modello hanno attivazioni interne che rappresentano “cane”, che consentono al modello di rilevare un cane quando vede qualsiasi immagine di un cane. Le rappresentazioni percettivamente rettilinee mantengono una rappresentazione “cane” più stabile quando ci sono piccoli cambiamenti nell’immagine. Ciò li rende più robusti.

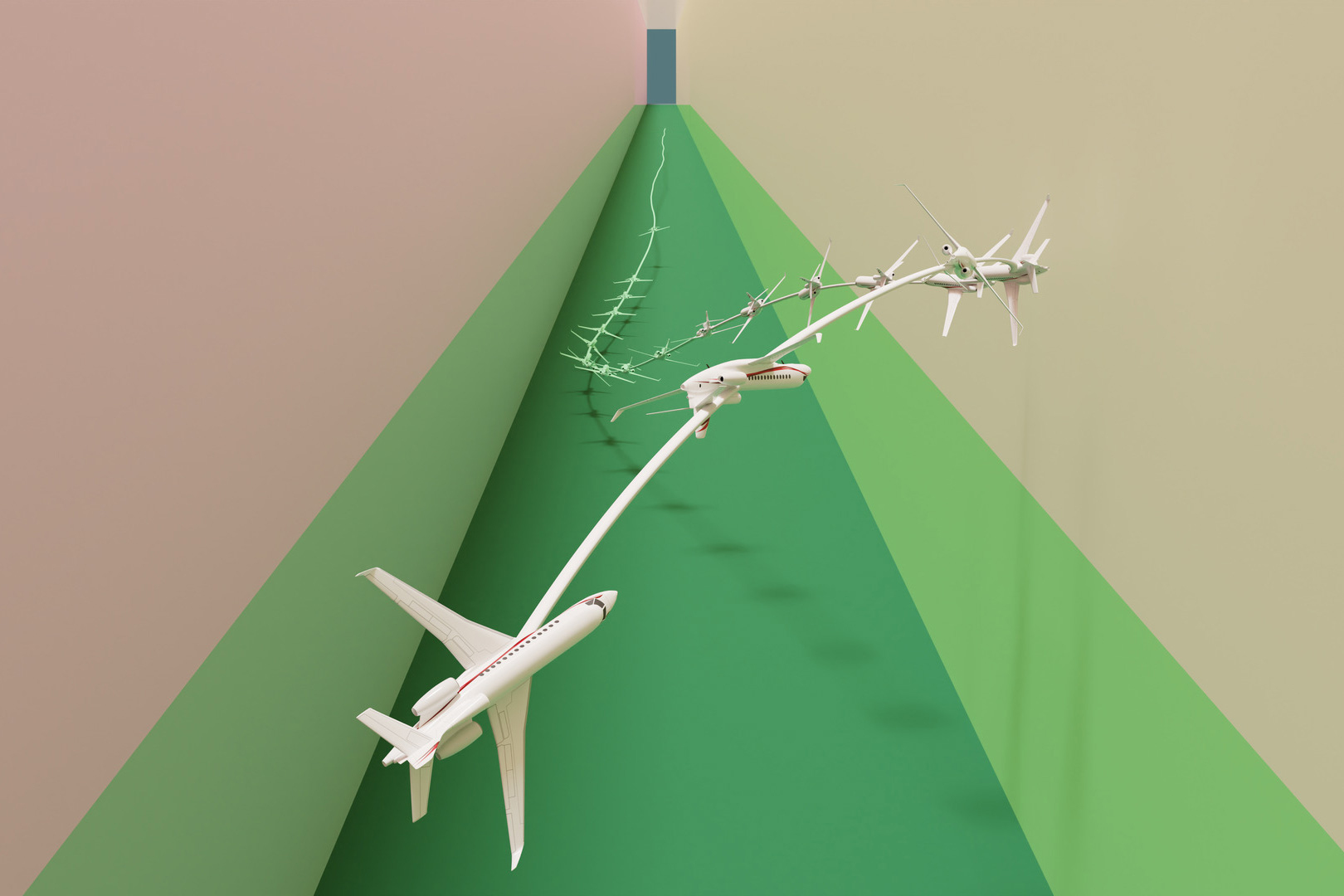

Acquisendo una migliore comprensione della rettilinearità percettiva nella visione artificiale dei computer, i ricercatori sperano di scoprire informazioni che potrebbero aiutarli a sviluppare modelli in grado di fare previsioni più accurate. Ad esempio, questa proprietà potrebbe migliorare la sicurezza dei veicoli autonomi che utilizzano modelli di visione artificiale dei computer per prevedere le traiettorie di pedoni, ciclisti e altri veicoli.

“Uno dei messaggi principali qui è che trarre ispirazione da sistemi biologici, come la visione umana, può sia fornirti informazioni su perché alcune cose funzionano nel modo in cui lo fanno e anche ispirare idee per migliorare le reti neurali”, afferma Vasha DuTell, un postdoc del MIT e coautore di un articolo che esplora la rettilinearità percettiva nella visione artificiale dei computer.

Altri autori dell’articolo sono Anne Harrington, studentessa di dottorato del Dipartimento di Ingegneria Elettrica e Informatica (EECS); Ayush Tewari, postdoc; Mark Hamilton, studente di dottorato; Simon Stent, responsabile della ricerca presso Woven Planet; Ruth Rosenholtz, ricercatrice principale del Dipartimento di Scienze del Cervello e della Cognizione e membro del Laboratorio di Informatica e Intelligenza Artificiale (CSAIL); e l’autore principale William T. Freeman, il professore Thomas e Gerd Perkins di Ingegneria Elettrica e Informatica e membro del CSAIL. La ricerca viene presentata alla Conferenza internazionale sulla rappresentazione dell’apprendimento.

Studiare il raddrizzamento

Dopo aver letto un articolo del 2019 di un team di ricercatori dell’Università di New York sulla rettilinearità percettiva negli esseri umani, DuTell, Harrington e i loro colleghi si sono chiesti se quella proprietà potesse essere utile anche nei modelli di visione artificiale dei computer.

Si sono messi alla ricerca per determinare se i diversi tipi di modelli di visione artificiale dei computer raddrizzano le rappresentazioni visive che apprendono. Hanno fornito a ciascun modello fotogrammi di un video e poi hanno esaminato la rappresentazione in diverse fasi del processo di apprendimento.

Se la rappresentazione del modello cambia in modo prevedibile attraverso i fotogrammi del video, quel modello sta raddrizzando. Alla fine, la sua rappresentazione di output dovrebbe essere più stabile rispetto alla rappresentazione di input.

“Puoi pensare alla rappresentazione come a una linea, che inizia molto curva. Un modello che raddrizza può prendere quella linea curva dal video e raddrizzarla attraverso i suoi passaggi di elaborazione”, spiega DuTell.

La maggior parte dei modelli testati non si raddrizzava. Dei pochi che lo facevano, quelli che raddrizzavano più efficacemente erano stati addestrati per compiti di classificazione utilizzando la tecnica nota come formazione avversaria.

La formazione avversaria comporta la modifica sottile delle immagini mediante la modifica leggera di ciascun pixel. Mentre un essere umano non noterebbe la differenza, queste piccole modifiche possono ingannare una macchina in modo che classifichi erroneamente l’immagine. La formazione avversaria rende il modello più robusto, quindi non verrà ingannato da queste manipolazioni.

Poiché la formazione avversaria insegna al modello ad essere meno reattivo a leggere modifiche nelle immagini, ciò aiuta ad apprendere una rappresentazione più prevedibile nel tempo, spiega Harrington.

“Le persone hanno già avuto questa idea che l’addestramento avversario potrebbe aiutare il modello a diventare più simile a un essere umano, ed è stato interessante vedere che questa proprietà si è estesa ad un’altra caratteristica che non era stata testata prima”, afferma.

Ma i ricercatori hanno scoperto che i modelli addestrati in modo avversario imparano a raddrizzare solo quando vengono addestrati per compiti ampi, come la classificazione di immagini intere in categorie. I modelli incaricati di segmentazione – ovvero l’etichettatura di ogni pixel di un’immagine come una certa classe – non si raddrizzavano, anche quando venivano addestrati in modo avversario.

Classificazione coerente

I ricercatori hanno testato questi modelli di classificazione delle immagini mostrandogli dei video. Hanno scoperto che i modelli che hanno imparato rappresentazioni più perceptualmente dritte tendevano a classificare correttamente gli oggetti nei video in modo più coerente.

“Per me, è incredibile che questi modelli addestrati in modo avversario, che non hanno mai visto un video e non sono mai stati addestrati su dati temporali, mostrino comunque una certa quantità di raddrizzamento”, afferma DuTell.

I ricercatori non sanno esattamente cosa dell’addestramento avversario consenta a un modello di visione artificiale di raddrizzarsi, ma i loro risultati suggeriscono che schemi di addestramento più forti fanno sì che i modelli si raddrizzino di più, spiega.

Partendo da questo lavoro, i ricercatori vogliono utilizzare ciò che hanno imparato per creare nuovi schemi di addestramento che conferiscano esplicitamente a un modello questa proprietà. Vogliono anche approfondire l’addestramento avversario per capire perché questo processo aiuta un modello a raddrizzarsi.

“Dal punto di vista biologico, l’addestramento avversario non ha necessariamente senso. Non è così che gli esseri umani comprendono il mondo. Ci sono ancora molte domande su perché questo processo di addestramento sembra aiutare i modelli ad agire più come gli esseri umani”, afferma Harrington.

“Comprendere le rappresentazioni apprese dalle reti neurali profonde è fondamentale per migliorare proprietà come la robustezza e la generalizzazione”, afferma Bill Lotter, professore associato presso il Dana-Farber Cancer Institute e la Harvard Medical School, che non ha partecipato a questa ricerca. “Harrington et al. effettuano una valutazione estensiva di come le rappresentazioni dei modelli di visione artificiale cambiano nel tempo durante l’elaborazione di video naturali, mostrando che la curvatura di questi percorsi varia ampiamente a seconda dell’architettura del modello, delle proprietà di addestramento e del compito. Questi risultati possono informare lo sviluppo di modelli migliorati e offrono anche informazioni sulle elaborazioni visive biologiche”.

“Il documento conferma che il raddrizzamento dei video naturali è una proprietà abbastanza unica espressa dal sistema visivo umano. Solo le reti addestrate in modo avversario lo mostrano, il che offre un collegamento interessante con un’altra firma della percezione umana: la sua robustezza a varie trasformazioni dell’immagine, sia naturali che artificiali”, afferma Olivier Hénaff, ricercatore presso DeepMind, che non ha partecipato a questa ricerca. “Il fatto che anche i modelli di segmentazione della scena addestrati in modo avversario non raddrizzino i loro input solleva importanti questioni per il futuro lavoro: gli esseri umani analizzano le scene naturali nello stesso modo dei modelli di visione artificiale? Come rappresentare e prevedere le traiettorie degli oggetti in movimento mantenendo la sensibilità ai loro dettagli spaziali? Collegando l’ipotesi di raddrizzamento con altri aspetti del comportamento visivo, il documento getta le basi per teorie più unificate della percezione”.

La ricerca è finanziata in parte dal Toyota Research Institute, dalla MIT CSAIL METEOR Fellowship, dalla National Science Foundation, dall’U.S. Air Force Research Laboratory e dall’U.S. Air Force Artificial Intelligence Accelerator.