Ricercatori di Microsoft propongono BioViL-T un nuovo framework auto-supervisionato che introduce una migliore performance predittiva ed efficienza dei dati nelle applicazioni biomediche.

Microsoft researchers propose BioViL-T, a new self-supervised framework that introduces better predictive performance and data efficiency in biomedical applications.

L’Intelligenza Artificiale (AI) è emersa come una significativa forza perturbatrice in numerosi settori, dal modo in cui le aziende tecnologiche operano fino al modo in cui l’innovazione viene sbloccata in diversi subdomini del settore sanitario. In particolare, il campo biomedico ha visto significativi progressi e trasformazioni con l’introduzione dell’AI. Uno di questi notevoli progressi può essere riassunto nell’utilizzo di modelli di visione-linguaggio auto-supervisionati in radiologia. I radiologi si basano pesantemente sui rapporti di radiologia per trasmettere osservazioni di imaging e fornire diagnosi cliniche. È importante notare che gli studi di imaging precedenti svolgono spesso un ruolo chiave in questo processo decisionale perché forniscono un contesto cruciale per valutare il corso delle malattie e stabilire scelte di medicazione adatte. Tuttavia, le attuali soluzioni di AI nel mercato non riescono a allineare con successo le immagini con i dati dei rapporti a causa del limitato accesso alle scansioni precedenti. Inoltre, questi metodi spesso non considerano lo sviluppo cronologico delle malattie o delle scoperte di imaging tipicamente presenti nei dataset biologici. Questa mancanza di informazioni contestuali comporta rischi in applicazioni successive come la generazione automatica di rapporti, dove i modelli potrebbero generare contenuti temporali imprecisi senza accesso alle scansioni mediche passate.

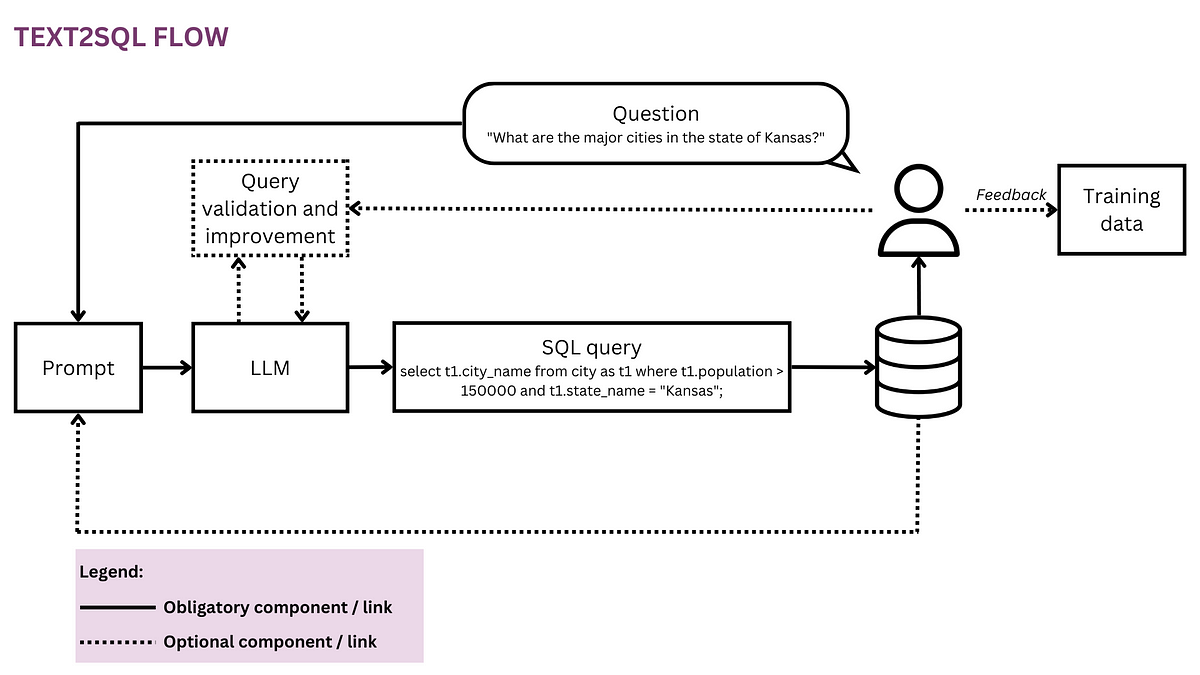

Con l’introduzione dei modelli di visione-linguaggio, i ricercatori mirano a generare segnali di addestramento informativi utilizzando coppie immagine-testo, eliminando così la necessità di etichette manuali. Questo approccio consente ai modelli di imparare come identificare e individuare con precisione le scoperte nelle immagini e stabilire connessioni con le informazioni presentate nei rapporti di radiologia. Microsoft Research ha continuamente lavorato per migliorare l’AI per la segnalazione e la radiografia. La loro precedente ricerca sull’apprendimento auto-supervisionato multimodale di rapporti e immagini di radiologia ha prodotto risultati incoraggianti nell’identificazione dei problemi medici e nella localizzazione di queste scoperte all’interno delle immagini. Come contributo a questa ondata di ricerca, Microsoft ha rilasciato BioViL-T, un framework di addestramento auto-supervisionato che considera le immagini e i rapporti precedenti quando disponibili durante l’addestramento e il fine-tuning. BioViL-T raggiunge risultati innovativi su vari benchmark successivi, come la classificazione della progressione e la creazione di rapporti, utilizzando la struttura temporale esistente nei dataset. Lo studio sarà presentato alla prestigiosa Conferenza sulla Visione Artificiale e il Riconoscimento dei Pattern (CVPR) nel 2023.

La caratteristica distintiva di BioViL-T risiede nella sua esplicita considerazione di immagini e rapporti precedenti durante i processi di addestramento e di fine-tuning anziché trattare ogni coppia immagine-rapporto come un’entità separata. La ragione dei ricercatori di incorporare immagini e rapporti precedenti era principalmente quella di massimizzare l’utilizzo dei dati disponibili, ottenendo rappresentazioni più complete e prestazioni migliorate su un’ampia gamma di compiti. BioViL-T introduce un nuovo codificatore multi-immagine CNN-Transformer che viene addestrato congiuntamente con un modello di testo. Questo nuovo codificatore multi-immagine serve come blocco fondamentale del framework di pre-addestramento, affrontando sfide come l’assenza di immagini precedenti e le variazioni di posa nelle immagini nel tempo.

- Incontra TARDIS un framework di intelligenza artificiale che identifica le singolarità in spazi complessi e cattura le strutture singolari e la complessità geometrica locale nei dati delle immagini.

- Previsione del rendimento delle colture utilizzando Machine Learning e distribuzione di Flask.

- Come funziona GPT una spiegazione metaforica di Key, Value, Query in Attention, utilizzando una storia di pozioni.

È stata scelta una CNN e un modello transformer per creare il codificatore multi-immagine ibrido per estrarre caratteristiche spazio-temporali dalle sequenze di immagini. Quando sono disponibili immagini precedenti, il transformer si occupa di catturare le interazioni di embedding di patch nel tempo. D’altra parte, la CNN ha il compito di fornire proprietà di token visivo delle singole immagini. Questo codificatore di immagini ibrido migliora l’efficienza dei dati, rendendolo adatto a dataset di dimensioni anche più ridotte. Cattura in modo efficiente le caratteristiche statiche e temporali dell’immagine, che sono essenziali per applicazioni come la decodifica di rapporti che richiedono un ragionamento visivo a livello denso nel tempo. La procedura di pre-addestramento del modello BioViL-T può essere divisa in due componenti principali: un codificatore multi-immagine per l’estrazione di caratteristiche spazio-temporali e un codificatore di testo che incorpora opzionalmente l’attenzione incrociata con le caratteristiche dell’immagine. Questi modelli sono addestrati congiuntamente utilizzando obiettivi contrastivi globali e locali cross-modali. Il modello utilizza anche rappresentazioni fuse multimodali ottenute tramite attenzione incrociata per la modellizzazione del linguaggio mascherato guidato dall’immagine, sfruttando efficacemente le informazioni visive e testuali. Questo gioca un ruolo centrale nella risoluzione delle ambiguità e nell’aumento della comprensione del linguaggio, che è di estrema importanza per una vasta gamma di compiti successivi.

Il successo della strategia dei ricercatori di Microsoft è stato aiutato da una varietà di valutazioni sperimentali che hanno condotto. Il modello raggiunge prestazioni di stato dell’arte per una varietà di compiti successivi come la categorizzazione della progressione, la grounding di frase e la generazione di rapporti in configurazioni a singola e multi-immagine. Inoltre, migliora i modelli precedenti e produce risultati apprezzabili su compiti come la classificazione delle malattie e la similarità delle frasi. Microsoft Research ha reso il modello e il codice sorgente disponibili al pubblico per incoraggiare la comunità a investigare ulteriormente il loro lavoro. Inoltre, i ricercatori stanno rendendo pubblico un nuovo dataset di benchmark temporale multimodale chiamato MS-CXR-T per stimolare ulteriori ricerche sulla quantificazione di quanto bene le rappresentazioni di visione-linguaggio possono catturare la semantica temporale.