Ricercatori insegnano all’IA a scrivere didascalie di grafici migliori

Researchers teach AI to write better graph captions

Un nuovo set di dati può aiutare gli scienziati a sviluppare sistemi automatici che generano didascalie più ricche e descrittive per grafici online.

Le didascalie dei grafici che spiegano tendenze e pattern complessi sono importanti per migliorare la capacità di comprensione e memorizzazione dei dati presentati da parte del lettore. E per le persone con disabilità visive, le informazioni contenute in una didascalia spesso rappresentano l’unico modo per comprendere il grafico.

Tuttavia, scrivere didascalie efficaci e dettagliate è un processo laborioso. Sebbene le tecniche di autocaptioning possano alleviare questo onere, spesso faticano a descrivere le caratteristiche cognitive che forniscono contesto aggiuntivo.

- Utilizzo di GAN in TensorFlow per generare immagini

- Cos’è la simulazione robotica?

- Una guida per migliorare la trasformazione digitale attraverso la pulizia dei dati

Per aiutare le persone a creare didascalie di grafici di alta qualità, i ricercatori del MIT hanno sviluppato un dataset per migliorare i sistemi di autocaptioning automatico. Utilizzando questo strumento, i ricercatori potrebbero insegnare a un modello di machine learning a variare il livello di complessità e il tipo di contenuto incluso in una didascalia di un grafico in base alle esigenze degli utenti.

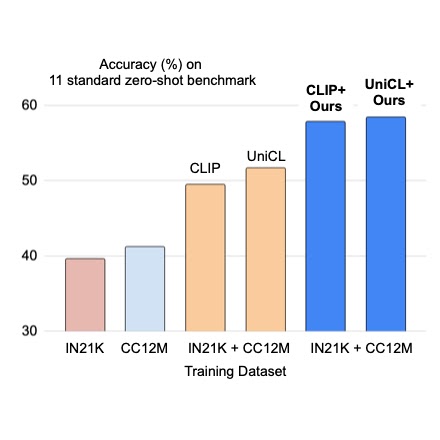

I ricercatori del MIT hanno scoperto che i modelli di machine learning addestrati per l’autocaptioning con il loro dataset generavano costantemente didascalie precise, semanticamente ricche e che descrivevano tendenze dei dati e pattern complessi. Analisi quantitative e qualitative hanno rivelato che i loro modelli descrivevano i grafici in modo più efficace rispetto ad altri sistemi di autocaptioning.

L’obiettivo del team è fornire il dataset, chiamato VisText, come strumento che i ricercatori possono utilizzare mentre lavorano sul complesso problema dell’autocaptioning dei grafici. Questi sistemi automatici potrebbero contribuire a fornire didascalie per grafici online non didascaliati e migliorare l’accessibilità per le persone con disabilità visive, afferma Angie Boggust, co-autrice del paper e studentessa di dottorato in ingegneria elettrica e informatica al MIT e membro del gruppo di visualizzazione nel Laboratorio di Informatica e Intelligenza Artificiale (CSAIL).

“Abbiamo cercato di incorporare molti valori umani nel nostro dataset in modo che quando noi e altri ricercatori stiamo costruendo sistemi automatici di autocaptioning dei grafici, non finiamo con modelli che non sono ciò che le persone vogliono o di cui hanno bisogno”, afferma.

Boggust è affiancata nel paper da Benny J. Tang, co-autore e collega studente di dottorato, e da Arvind Satyanarayan, autore senior e professore associato di informatica al MIT che guida il gruppo di visualizzazione in CSAIL. La ricerca sarà presentata all’Annual Meeting dell’Association for Computational Linguistics.

Analisi centrata sull’essere umano

I ricercatori sono stati ispirati a sviluppare VisText da un precedente lavoro del gruppo di visualizzazione che ha esplorato cosa rende una buona didascalia di un grafico. In tale studio, i ricercatori hanno scoperto che gli utenti vedenti e gli utenti non vedenti o con bassa visione avevano preferenze diverse per la complessità del contenuto semantico in una didascalia.

Il gruppo voleva portare tale analisi centrata sull’essere umano nella ricerca sull’autocaptioning. Per farlo, hanno sviluppato VisText, un dataset di grafici e didascalie associate che potrebbero essere utilizzate per addestrare modelli di machine learning a generare didascalie accurate, semanticamente ricche e personalizzabili.

Sviluppare sistemi di autocaptioning efficaci non è un compito facile. I metodi di machine learning esistenti cercano spesso di descrivere i grafici come farebbero con un’immagine, ma le persone e i modelli interpretano le immagini naturali in modo diverso da come leggiamo i grafici. Altre tecniche saltano completamente il contenuto visivo e descrivono un grafico utilizzando la tabella di dati sottostante. Tuttavia, tali tabelle di dati spesso non sono disponibili dopo che i grafici sono stati pubblicati.

Dati i limiti dell’uso di immagini e tabelle di dati, VisText rappresenta anche i grafici come grafi di scena. I grafi di scena, che possono essere estratti da un’immagine di un grafico, contengono tutti i dati del grafico ma includono anche contesto immagine aggiuntivo.

“Un grafo di scena è come il meglio di entrambi i mondi: contiene quasi tutte le informazioni presenti in un’immagine ed è più facile da estrarre dalle immagini rispetto alle tabelle di dati. Essendo anche testo, possiamo sfruttare i progressi nei moderni modelli linguistici di grandi dimensioni per la didascalia”, spiega Tang.

Hanno compilato un dataset che contiene oltre 12.000 grafici, ognuno rappresentato come una tabella di dati, un’immagine e un grafo di scena, oltre a didascalie associate. Ogni grafico ha due didascalie separate: una didascalia a basso livello che descrive la costruzione del grafico (come i suoi intervalli degli assi) e una didascalia a livello superiore che descrive statistiche, relazioni nei dati e tendenze complesse.

I ricercatori hanno generato didascalie a basso livello utilizzando un sistema automatizzato e hanno ottenuto didascalie a livello superiore tramite la collaborazione di lavoratori umani.

“Le nostre didascalie sono state basate su due elementi chiave della ricerca precedente: linee guida esistenti sulle descrizioni accessibili dei media visivi e un modello concettuale del nostro gruppo per la categorizzazione del contenuto semantico. Ciò ha garantito che le nostre didascalie presentassero importanti elementi di grafico a basso livello come assi, scale e unità per i lettori con disabilità visive, mantenendo al contempo la variabilità umana nella scrittura delle didascalie”, afferma Tang.

Traduzione dei grafici

Dopo aver raccolto immagini di grafici e didascalie, i ricercatori hanno utilizzato VisText per addestrare cinque modelli di machine learning per l’autocaptioning. Volevano vedere come ogni rappresentazione – immagine, tabella di dati e grafo di scena – e le combinazioni delle rappresentazioni influenzassero la qualità della didascalia.

“Puoi pensare a un modello di autocaptioning dei grafici come a un modello per la traduzione del linguaggio. Ma invece di dire, traduci questo testo in tedesco in inglese, diciamo traduci questo ‘linguaggio dei grafici’ in inglese”, dice Boggust.

I loro risultati hanno mostrato che i modelli addestrati con grafi di scena hanno ottenuto risultati simili o migliori rispetto a quelli addestrati utilizzando tabelle di dati. Poiché i grafi di scena sono più facili da estrarre dai grafici esistenti, i ricercatori sostengono che potrebbero essere una rappresentazione più utile.

Hanno anche addestrato modelli con didascalie a basso livello e ad alto livello separatamente. Questa tecnica, nota come sintonizzazione semantica del prefisso, ha permesso loro di insegnare al modello a variare la complessità del contenuto della didascalia.

Inoltre, hanno condotto un’analisi qualitativa delle didascalie prodotte dal loro metodo migliore e hanno categorizzato sei tipi di errori comuni. Ad esempio, si verifica un errore direzionale se un modello afferma che una tendenza sta diminuendo quando in realtà sta aumentando.

Questa valutazione qualitativa dettagliata e robusta è stata importante per comprendere come il modello stesse commettendo gli errori. Ad esempio, utilizzando metodi quantitativi, un errore direzionale potrebbe comportare la stessa penalità di un errore di ripetizione, in cui il modello ripete la stessa parola o frase. Ma un errore direzionale potrebbe essere più ingannevole per un utente rispetto a un errore di ripetizione. L’analisi qualitativa li ha aiutati a comprendere questi tipi di sottigliezze, afferma Boggust.

Questi tipi di errori mettono anche in evidenza limitazioni dei modelli attuali e sollevano considerazioni etiche che i ricercatori devono valutare mentre lavorano per sviluppare sistemi di autocaptioning, aggiunge.

I modelli generativi di machine learning, come quelli che alimentano ChatGPT, hanno dimostrato di creare allucinazioni o fornire informazioni errate che possono essere ingannevoli. Sebbene ci sia un chiaro vantaggio nell’utilizzare questi modelli per l’autocaptioning dei grafici esistenti, potrebbe portare alla diffusione di informazioni errate se i grafici vengono sottotitolati in modo errato.

“Forse questo significa che non dobbiamo semplicemente sottotitolare tutto ciò che vediamo con l’IA. Invece, forse forniamo questi sistemi di autocaptioning come strumenti di autorialità per consentire alle persone di modificarli. È importante pensare a queste implicazioni etiche durante tutto il processo di ricerca, non solo alla fine quando abbiamo un modello da distribuire”, afferma.

Boggust, Tang e i loro colleghi vogliono continuare ad ottimizzare i modelli per ridurre alcuni errori comuni. Vogliono anche ampliare il dataset di VisText includendo più grafici e grafici più complessi, come quelli con barre sovrapposte o linee multiple. E vorrebbero anche ottenere informazioni su ciò che questi modelli di autocaptioning stanno effettivamente imparando sui dati dei grafici.

Questa ricerca è stata supportata in parte da un Google Research Scholar Award, dalla National Science Foundation, dall’iniziativa MLA@CSAIL e dall’United States Air Force Research Laboratory.