3 Metodi Semplici Per Migliorare Il Tuo Grande Modello Linguistico

3 Metodi per Migliorare il Tuo Modello Linguistico

Potenziare la potenza di Llama 2

I Large Language Models (LLM) sono qui per restare. Con il recente rilascio di Llama 2, gli LLM open-source si avvicinano alle prestazioni di ChatGPT e con una messa a punto adeguata possono persino superarlo.

L’utilizzo di questi LLM non è sempre così semplice come sembra, soprattutto se si desidera sintonizzare l’LLM per il proprio caso d’uso specifico.

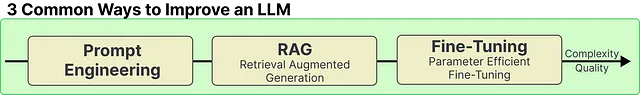

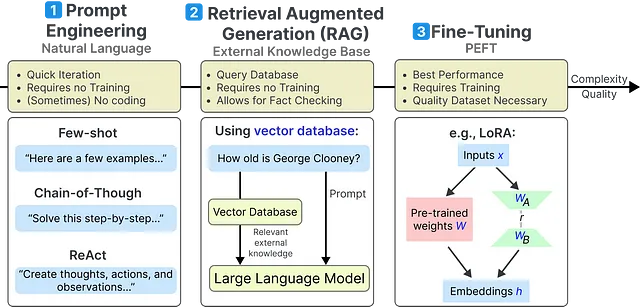

In questo articolo, esamineremo tre dei metodi più comuni per migliorare le prestazioni di qualsiasi LLM:

- Tecniche di caccia alle minacce di nuova generazione con integrazione SIEM-SOAR

- Come ottenere un lavoro in Data Science come studente

- Cosa è una persona ChatGPT?

- Progettazione delle istruzioni

- Generazione potenziata dal recupero (RAG)

- Sintonizzazione efficiente dei parametri (PEFT)

Ci sono molti altri metodi, ma questi sono i più semplici e possono portare a miglioramenti significativi senza troppo lavoro.

Questi tre metodi partono dal metodo meno complesso, i cosiddetti frutti a portata di mano, fino a uno dei metodi più complessi per migliorare il tuo LLM.

Per ottenere il massimo dagli LLM, puoi persino combinare tutti e tre i metodi!

Prima di iniziare, ecco una panoramica più dettagliata dei metodi per un riferimento più semplice:

Puoi anche seguire il Notebook di Google Colab per assicurarti che tutto funzioni come previsto.

Carica Llama 2 🦙

Prima di iniziare, dobbiamo caricare un LLM da utilizzare in questi esempi. Scegliamo il Llama 2 di base in quanto mostra prestazioni incredibili e perché sono un grande fan di utilizzare modelli di base nei tutorial.

Dovremo prima accettare la licenza prima di poter iniziare. Segui questi passaggi:

- Crea un account HuggingFace qui

- Fai domanda per l’accesso a Llama 2 qui

- Ottieni il tuo token HuggingFace qui