Ricostruire gli spazi interni con NeRF

Reconstructing internal spaces with NeRF.

Marcos Seefelder, Ingegnere del Software, e Daniel Duckworth, Ingegnere del Software di Ricerca, Google Research

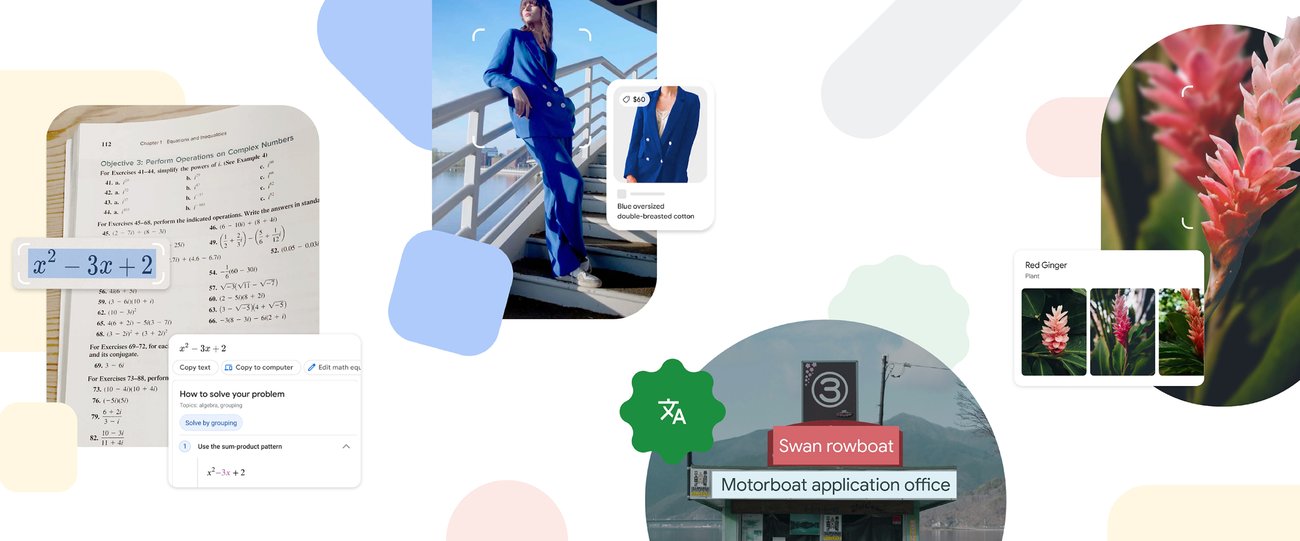

Quando scegliamo un locale, spesso ci troviamo con domande come: Questo ristorante ha l’atmosfera giusta per un appuntamento? Ci sono posti all’aperto? Ci sono abbastanza schermi per guardare la partita? Anche se le foto e i video possono rispondere parzialmente a domande come queste, non possono sostituire la sensazione di sentirsi lì, anche quando la visita di persona non è un’opzione.

Le esperienze immersive che sono interattive, fotorealistiche e multidimensionali hanno il potenziale di colmare questa lacuna e ricreare la sensazione e l’atmosfera di uno spazio, permettendo agli utenti di trovare naturalmente e intuitivamente le informazioni di cui hanno bisogno. Per aiutare in questo, Google Maps ha lanciato Immersive View , che utilizza i progressi dell’apprendimento automatico (ML) e della visione artificiale per fondere miliardi di immagini di Street View e aeree per creare un modello digitale e ricco del mondo. Oltre a ciò, fornisce informazioni utili come il meteo, il traffico e quanto è affollato un luogo. Immersive View fornisce viste interne di ristoranti, caffè e altri luoghi per dare agli utenti un’occhiata ravvicinata virtuale che può aiutarli a decidere con sicurezza dove andare.

Oggi descriviamo il lavoro svolto per fornire queste viste interne in Immersive View. Ci basiamo sui campi di radianza neurali (NeRF), un approccio all’avanguardia per fondere le foto per produrre una ricostruzione realistica e multidimensionale all’interno di una rete neurale. Descriviamo il nostro processo per la creazione di NeRF, che include la cattura personalizzata delle foto dello spazio utilizzando telecamere DSLR, l’elaborazione delle immagini e la riproduzione della scena. Approfittiamo dei recenti progressi di Alphabet in questo campo per progettare un metodo che eguaglia o supera lo stato dell’arte precedente nella fedeltà visiva. Questi modelli vengono quindi incorporati come video interattivi a 360° seguendo percorsi di volo curati, consentendo loro di essere disponibili sui telefoni cellulari.

- Crea un’applicazione web per l’ottimizzazione di una catena di approvvigionamento sostenibile.

- Costruisci una pipeline di traduzione automatica multilingue con Amazon Translate Active Custom Translation.

- ‘AI Doctor’ Prevede il Ricovero in Ospedale, Altri Esiti della Salute

| La ricostruzione di The Seafood Bar ad Amsterdam in Immersive View. |

Dalle foto ai NeRF

Al centro del nostro lavoro c’è NeRF , un metodo sviluppato di recente per la ricostruzione 3D e la sintesi di nuove visualizzazioni. Dato un insieme di foto che descrivono una scena, NeRF le distilla in un campo neurale , che può quindi essere utilizzato per rendere le foto da punti di vista non presenti nella raccolta originale.

Anche se NeRF risolve in gran parte la sfida della ricostruzione, un prodotto rivolto agli utenti basato su dati del mondo reale presenta una vasta gamma di sfide. Ad esempio, la qualità della ricostruzione e dell’esperienza utente dovrebbero rimanere consistenti tra i luoghi, dai bar poco illuminati ai caffè sul marciapiede ai ristoranti dell’hotel. Allo stesso tempo, la privacy dovrebbe essere rispettata e qualsiasi informazione potenzialmente identificabile personalmente dovrebbe essere rimossa. Inoltre, le scene dovrebbero essere catturate in modo coerente ed efficiente, risultando in ricostruzioni di alta qualità con il minimo sforzo necessario per catturare le foto necessarie. Infine, la stessa esperienza naturale dovrebbe essere disponibile per tutti gli utenti mobili, indipendentemente dal dispositivo disponibile.

| Il processo di ricostruzione indoor di Immersive View. |

Acquisizione e pre-elaborazione

Il primo passo per produrre un NeRF di alta qualità è la cattura attenta di una scena: una densa raccolta di foto da cui è possibile derivare la geometria 3D e il colore. Per ottenere la migliore qualità di ricostruzione possibile, ogni superficie dovrebbe essere osservata da diverse direzioni. Più informazioni un modello ha sulla superficie di un oggetto, migliore sarà nella scoperta della forma dell’oggetto e del modo in cui interagisce con le luci.

Inoltre, i modelli NeRF pongono ulteriori presupposti sulla fotocamera e sulla scena stessa. Ad esempio, la maggior parte delle proprietà della fotocamera, come il bilanciamento del bianco e l’apertura, sono considerati fissi durante la cattura. Allo stesso modo, si presume che la scena stessa sia congelata nel tempo: i cambiamenti di illuminazione e di movimento dovrebbero essere evitati. Ciò deve essere bilanciato con le esigenze pratiche, compreso il tempo necessario per la cattura, la disponibilità di illuminazione, il peso dell’attrezzatura e la privacy. In collaborazione con fotografi professionisti, abbiamo sviluppato una strategia per catturare rapidamente e affidabilmente foto di locali utilizzando telecamere DSLR entro un intervallo di tempo di solo un’ora. Questo approccio è stato utilizzato per tutte le nostre ricostruzioni NeRF fino ad oggi.

Una volta caricata la cattura nel nostro sistema, inizia l’elaborazione. Poiché le foto possono involontariamente contenere informazioni sensibili, automaticamente scansioniamo e sfocando il contenuto personalmente identificabile. Applichiamo quindi una pipeline di struttura dal movimento per risolvere i parametri della fotocamera per ogni foto : la sua posizione e orientamento rispetto ad altre foto, insieme alle proprietà della lente come la lunghezza focale . Questi parametri associamo ogni pixel con un punto e una direzione nello spazio 3D e costituiscono un segnale chiave nel processo di ricostruzione di NeRF.

Ricostruzione NeRF

A differenza di molti modelli di Machine Learning, un nuovo modello NeRF viene addestrato da zero in ogni posizione catturata. Per ottenere la migliore qualità di ricostruzione possibile entro un budget di calcolo target, incorporiamo funzionalità da una varietà di lavori pubblicati su NeRF sviluppati presso Alphabet. Alcuni di questi includono:

- Ci basiamo su mip-NeRF 360, uno dei modelli NeRF con le prestazioni migliori fino ad oggi. Sebbene più intensivo dal punto di vista computazionale rispetto all’ampiamente utilizzato Instant NGP di Nvidia, scopriamo che mip-NeRF 360 produce costantemente meno artefatti e una maggiore qualità di ricostruzione.

- Incorporiamo i vettori di ottimizzazione latenti generativi a bassa dimensionalità (GLO) introdotti in NeRF in the Wild come input ausiliario alla rete di radianza del modello. Questi sono vettori latenti a valori reali appresi che incorporano informazioni sull’aspetto per ogni immagine. Assegnando a ogni immagine il proprio vettore latente, il modello può catturare fenomeni come i cambiamenti di illuminazione senza ricorrere a geometrie nuvolose, un artefatto comune nelle catture NeRF casuali.

- Incorporiamo anche la condizionatura dell’esposizione come introdotta in Block-NeRF. A differenza dei vettori GLO, che sono parametri del modello non interpretabili, l’esposizione è direttamente derivata dai metadati della foto e alimentata come input aggiuntivo alla rete di radianza del modello. Ciò offre due vantaggi principali: apre la possibilità di variare l’ISO e fornisce un metodo per controllare la luminosità di un’immagine al momento dell’elaborazione. Troviamo entrambe le proprietà preziose per catturare e ricostruire ambienti poco illuminati.

Addestriamo ogni modello NeRF su acceleratori TPU o GPU, che forniscono punti di compromesso diversi. Come per tutti i prodotti Google, continuiamo a cercare nuovi modi per migliorare, dalla riduzione dei requisiti di calcolo al miglioramento della qualità di ricostruzione.

| Un confronto diretto tra il nostro metodo e una linea di base mip-NeRF 360. |

Un’esperienza utente scalabile

Dopo che un NeRF viene addestrato, abbiamo la capacità di produrre nuove foto di una scena da qualsiasi punto di vista e lente della fotocamera che scegliamo. Il nostro obiettivo è offrire un’esperienza utente significativa e utile: non solo le ricostruzioni stesse, ma anche visite guidate interattive che danno agli utenti la libertà di esplorare naturalmente gli spazi dal comfort dei loro smartphone.

A tal fine, abbiamo progettato un player video controllabile a 360° che emula un volo attraverso uno spazio interno lungo un percorso predefinito, consentendo all’utente di guardarsi intorno liberamente e viaggiare avanti o indietro. Come primo prodotto Google che esplora questa nuova tecnologia, i video a 360° sono stati scelti come formato per fornire i contenuti generati per alcune ragioni.

Dal lato tecnico, l’inferenza in tempo reale e le rappresentazioni precalcolate sono ancora intensive in termini di risorse su base cliente (sia su dispositivo che in cloud), e fare affidamento su di esse limiterebbe il numero di utenti in grado di accedere a questa esperienza. Utilizzando i video, siamo in grado di scalare lo storage e la distribuzione dei video a tutti gli utenti sfruttando la stessa infrastruttura di gestione e distribuzione video utilizzata da YouTube. Dal lato operativo, i video ci danno un controllo editoriale più chiaro sull’esperienza di esplorazione e sono più facili da ispezionare in grandi volumi per la qualità.

Sebbene avessimo considerato di catturare lo spazio con una telecamera a 360° direttamente, l’utilizzo di un NeRF per ricostruire e renderizzare lo spazio presenta diversi vantaggi. Una telecamera virtuale può volare ovunque nello spazio, anche oltre gli ostacoli e attraverso le finestre, e può utilizzare qualsiasi obiettivo desiderato. Il percorso della telecamera può anche essere modificato in post-produzione per la scorrevolezza e la velocità, a differenza di una registrazione dal vivo. Una cattura NeRF non richiede inoltre l’uso di hardware per telecamere specializzate.

I nostri video a 360° sono resi mediante il ray casting attraverso ogni pixel di una telecamera virtuale sferica e la composizione degli elementi visibili della scena. Ogni video segue un percorso fluido definito da una sequenza di foto chiave scattate dal fotografo durante la cattura. La posizione della telecamera per ogni immagine viene calcolata durante la struttura dal movimento, e la sequenza di immagini viene interpolata in modo fluido in un percorso di volo.

Per mantenere la velocità costante in diversi luoghi, calibriamo le distanze per ciascuno catturando coppie di immagini, ciascuna distante 3 metri. Conoscendo le misurazioni nello spazio, ridimensioniamo il modello generato e renderizziamo tutti i video a una velocità naturale.

L’esperienza finale viene resa disponibile all’utente all’interno di Immersive View: l’utente può volare senza interruzioni in ristoranti e altri luoghi interni e scoprire lo spazio volando attraverso video a 360° fotorealistici.

Domande di ricerca aperte

Crediamo che questa funzionalità sia il primo passo di molti in un viaggio verso esperienze immersive alimentate dall’IA universalmente accessibili. Dal punto di vista della ricerca NeRF, rimangono aperte molte domande. Alcune di queste includono:

- Migliorare le ricostruzioni con la segmentazione della scena, aggiungendo informazioni semantiche alle scene che potrebbero renderle ad esempio ricercabili e più facili da navigare.

- Adattare NeRF alle collezioni di foto all’aperto, oltre che a quelle indoor. Ciò permetterebbe di offrire esperienze simili in ogni angolo del mondo e cambiare il modo in cui gli utenti potrebbero vivere il mondo esterno.

- Abilitare l’esplorazione 3D interattiva in tempo reale attraverso il rendering neurale su dispositivo.

| Ricostruzione di una scena all’aperto con un modello NeRF addestrato su panorami di Street View. |

Continuiamo a crescere e non vediamo l’ora di collaborare e contribuire alla comunità per costruire la prossima generazione di esperienze immersive.

Ringraziamenti

Questo lavoro è una collaborazione tra diversi team di Google. I contributori del progetto includono Jon Barron, Julius Beres, Daniel Duckworth, Roman Dudko, Magdalena Filak, Mike Harm, Peter Hedman, Claudio Martella, Ben Mildenhall, Cardin Moffett, Etienne Pot, Konstantinos Rematas, Yves Sallat, Marcos Seefelder, Lilyana Sirakovat, Sven Tresp e Peter Zhizhin.

Inoltre, vorremmo estendere i nostri ringraziamenti a Luke Barrington, Daniel Filip, Tom Funkhouser, Charles Goran, Pramod Gupta, Mario Lučić, Isalo Montacute e Dan Thomasset per i preziosi feedback e suggerimenti.