Ricercatori della NTU e di Microsoft propongono MIMIC-IT un dataset di tuning delle istruzioni multimodale in contesto su larga scala.

NTU and Microsoft researchers propose MIMIC-IT, a large-scale multimodal instruction tuning dataset.

Gli sviluppi recenti nell’intelligenza artificiale si sono concentrati su assistenti conversazionali con grandi capacità di comprensione che poi possono agire. I notevoli successi di questi assistenti conversazionali possono essere attribuiti alla pratica di adattamento delle istruzioni oltre all’alta capacità di generalizzazione dei grandi modelli linguistici (LLM). Ciò comporta l’ottimizzazione dei LLM per una varietà di attività descritte da istruzioni varie ed eccellenti. Includendo l’adattamento delle istruzioni, i LLM ottengono una comprensione più profonda delle intenzioni dell’utente, migliorando la loro performance zero-shot anche in compiti nuovi e non esplorati in precedenza.

L’adattamento delle istruzioni internalizza il contesto, che è desiderabile nelle interazioni con l’utente, specialmente quando l’input dell’utente supera il contesto ovvio, che può essere una spiegazione per il miglioramento della velocità zero-shot. Gli assistenti conversazionali hanno avuto straordinari progressi nelle sfide linguistiche. Tuttavia, un assistente conversazionale ideale deve essere in grado di gestire attività che richiedono diverse modalità. Per questo è necessario un ampio e sofisticato dataset di istruzioni multimodali. Il dataset originale di istruzioni e immagini è chiamato LLaVAInstruct-150K o LLaVA. È stato costruito utilizzando immagini COCO, istruzioni e dati da GPT-4 basati su bounding box dell’oggetto e descrizioni dell’immagine.

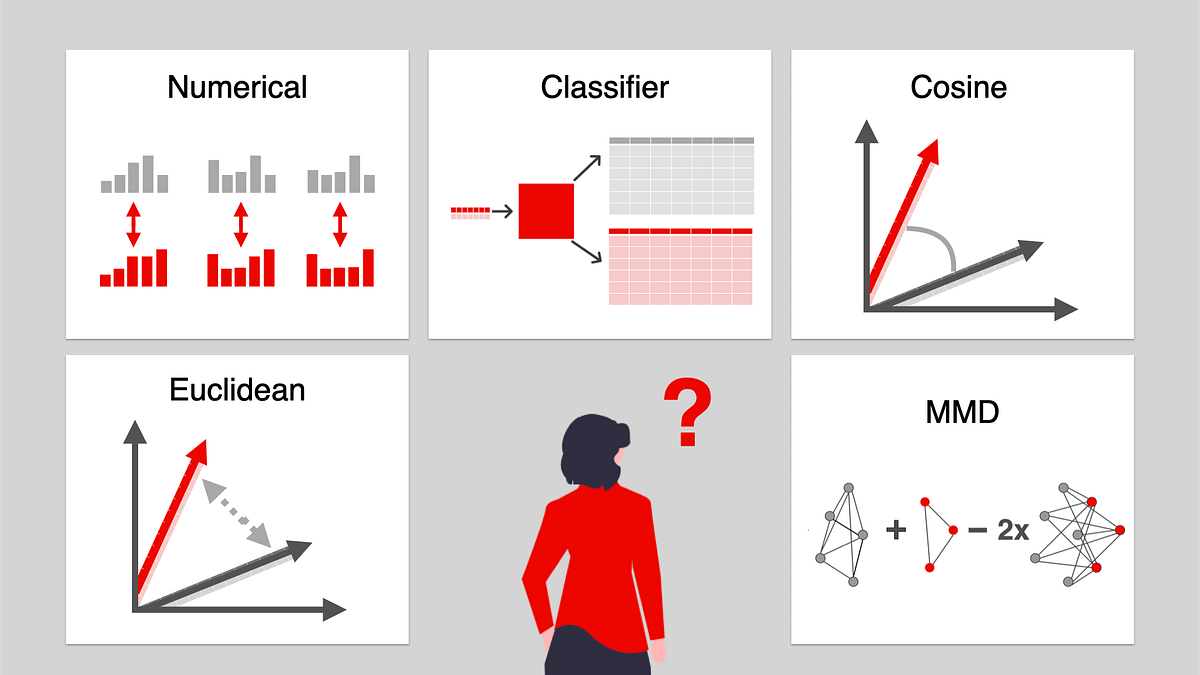

LLaVA-Instruct-150K è fonte di ispirazione, ma ha tre svantaggi. (1) Limitata diversità visiva: poiché il dataset utilizza solo l’immagine COCO, la sua diversità visiva è limitata. (2) Utilizza una sola immagine come input visivo, ma un assistente conversazionale multimodale dovrebbe essere in grado di gestire diverse foto o addirittura filmati lunghi. Ad esempio, quando un utente chiede aiuto nel trovare un titolo per un album di fotografie (o una sequenza di immagini, come un video), il sistema deve rispondere adeguatamente. (3) Informazioni solo in contesto linguistico: mentre un assistente conversazionale multimodale dovrebbe utilizzare informazioni multimodali in contesto per comprendere meglio le istruzioni dell’utente, le informazioni solo in contesto linguistico si basano interamente sulla lingua.

- Incontra AnythingLLM un’applicazione Full-Stack che trasforma il tuo contenuto in dati ricchi per migliorare le interazioni dei grandi modelli di lingua (LLMs).

- Preparazione avanzata dei dati utilizzando trasformatori personalizzati in Scikit-Learn

- Data Scraping Demystified Come Estrarre Informazioni Preziose dal Web

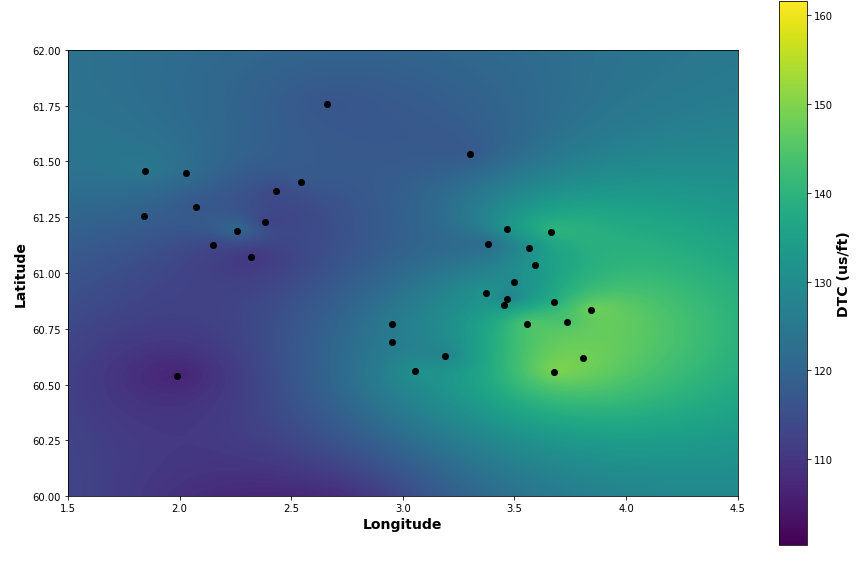

Ad esempio, se un utente umano offre un campione visivo specifico delle caratteristiche richieste, un assistente può allineare in modo più preciso la sua descrizione di un’immagine con il tono, lo stile o altri elementi. I ricercatori di S-Lab, Nanyang Technological University, Singapore e Microsoft Research, Redmond forniscono MIMICIT (Multimodal In-Context Instruction Tuning), che affronta queste limitazioni. (1) Scene visive diverse, integrate da foto e video di scene generali, scene in prima persona e immagini RGB-D indoor provenienti da diversi dataset, sono una caratteristica di MIMIC-IT. (2) Sono utilizzate più foto (o un video) come dati visivi per supportare le associazioni istruzione-risposta che possono essere accompagnate da diverse immagini o filmati. (3) Le informazioni multimodali in contesto consistono in dati in contesto presentati in diverse coppie istruzione-risposta, foto o video (per maggiori dettagli sul formato dei dati, vedere Fig. 1).

Forniscono Sythus, un pipeline automatizzato per l’annotazione di istruzioni e risposte ispirato dall’approccio di autoistruzione, per creare efficacemente associazioni istruzione-risposta. Mirando alle tre funzioni principali dei modelli visione-linguaggio: percezione, ragionamento e pianificazione, Sythus utilizza il messaggio di sistema, l’annotazione visiva e gli esempi in contesto per guidare il modello linguistico (GPT-4 o ChatGPT) nella generazione di associazioni istruzione-risposta basate sul contesto visivo, compresi i timestamp, le didascalie e le informazioni sugli oggetti. Le istruzioni e le risposte vengono anche tradotte dall’inglese in altre sette lingue per consentire l’utilizzo multilingue. Allenano un modello multimodale chiamato Otter basato su OpenFlamingo su MIMIC-IT.

Le abilità multimodali di Otter vengono valutate in due modi: (1) Otter si comporta al meglio nella valutazione ChatGPT sulla MMAGIBenchmark, che confronta le abilità percettive e di ragionamento di Otter con altri modelli correnti di visione-linguaggio (VLM). (2) Valutazione umana nella Multi-Modality Arena, dove Otter si comporta meglio degli altri VLM e riceve il punteggio Elo più alto. Otter supera OpenFlamingo in tutte le condizioni di few-shot, secondo la nostra valutazione delle sue capacità di apprendimento in-context few-shot utilizzando il dataset COCO Caption.

In particolare, sono stati forniti: • Il dataset Multimodal In-Context Instruction Tuning (MIMIC-IT) contiene 2,8 milioni di coppie di istruzioni-risposta multimodali in-context con 2,2 milioni di istruzioni distinte in vari contesti del mondo reale. • Syphus, un processo automatizzato creato con LLM per produrre coppie di istruzioni-risposta di alta qualità e multilingue a seconda del contesto visivo. • Otter, un modello multimodale, mostra un abile apprendimento in-context e una forte capacità di percezione e ragionamento multimodale, seguendo con successo l’intento umano.