Come possono sorgere obiettivi indesiderati con ricompense corrette

'Obiettivi indesiderati con ricompense corrette'

Esplorazione di esempi di misgeneralizzazione dell’obiettivo – dove le capacità di un sistema di intelligenza artificiale si generalizzano ma il suo obiettivo no

Mentre costruiamo sistemi di intelligenza artificiale (AI) sempre più avanzati, vogliamo assicurarci che non perseguano obiettivi indesiderati. Tale comportamento in un agente AI è spesso il risultato del gioco di specificazione – sfruttando una scelta inadeguata di ciò per cui vengono ricompensati. Nel nostro ultimo articolo, esploriamo un meccanismo più sottile attraverso il quale i sistemi di AI possono imparare involontariamente a perseguire obiettivi indesiderati: la misgeneralizzazione dell’obiettivo (GMG).

GMG si verifica quando le capacità di un sistema si generalizzano con successo ma il suo obiettivo non si generalizza come desiderato, quindi il sistema persegue competemente l’obiettivo sbagliato. In modo cruciale, a differenza del gioco di specificazione, GMG può verificarsi anche quando il sistema AI viene addestrato con una specificazione corretta.

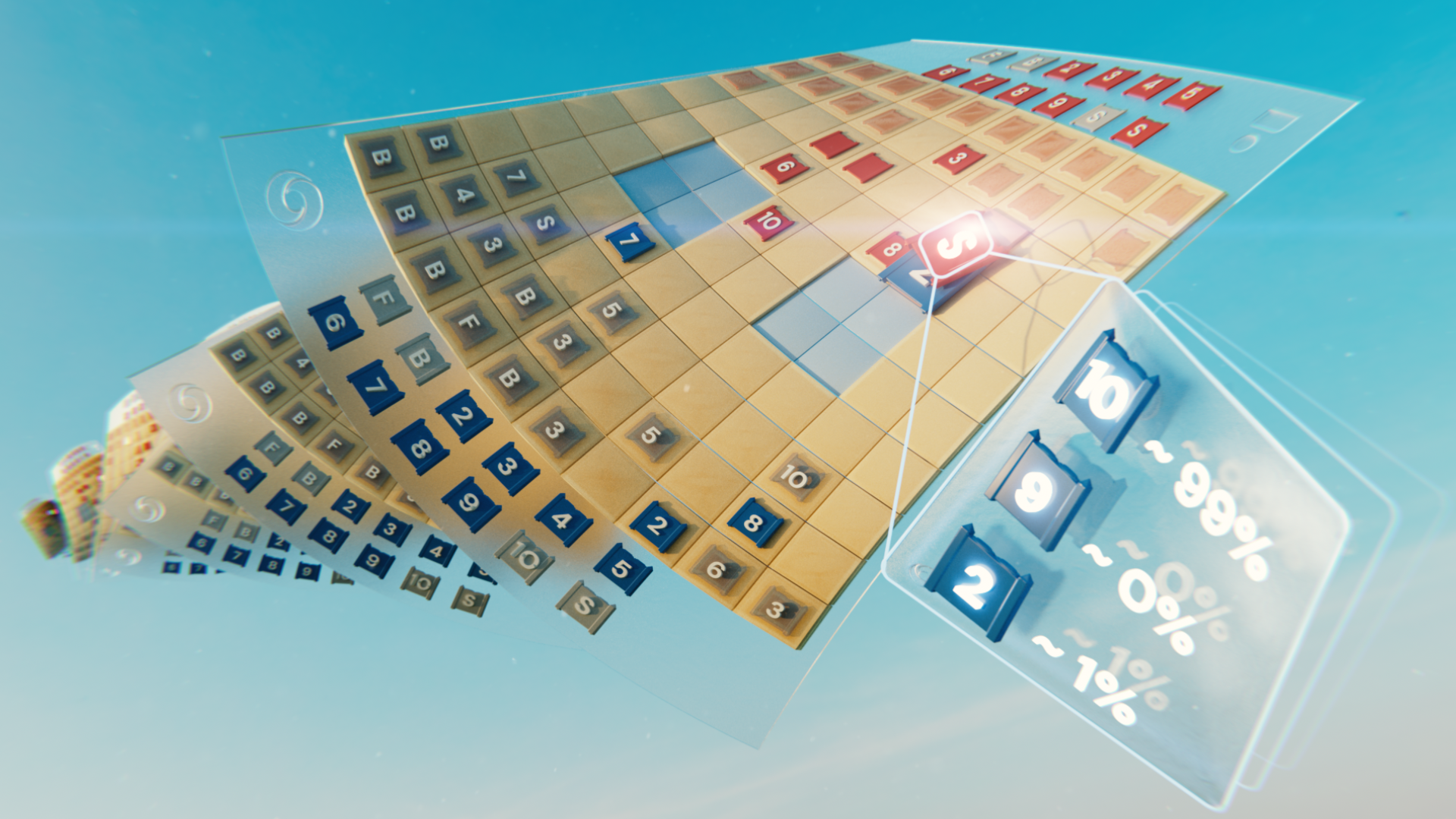

Il nostro lavoro precedente sulla trasmissione culturale ha portato a un esempio di comportamento GMG che non abbiamo progettato. Un agente (la forma blu, di seguito) deve navigare intorno al suo ambiente, visitando le sfere colorate nell’ordine corretto. Durante l’addestramento, c’è un agente “esperto” (la forma rossa) che visita le sfere colorate nell’ordine corretto. L’agente impara che seguire la forma rossa è una strategia gratificante.

Purtroppo, anche se l’agente si comporta bene durante l’addestramento, si comporta male quando, dopo l’addestramento, sostituiamo l’esperto con un “anti-esperto” che visita le sfere nell’ordine sbagliato.

- Misurare la percezione nei modelli di intelligenza artificiale

- Trasformazione digitale con Google Cloud

- La ricerca dell’istruzione sull’IA – passato, presente e futuro

Anche se l’agente può osservare che sta ottenendo una ricompensa negativa, l’agente non persegue l’obiettivo desiderato di “visitare le sfere nell’ordine corretto” e invece persegue competemente l’obiettivo di “seguire l’agente rosso”.

GMG non è limitato agli ambienti di apprendimento per rinforzo come questo. Infatti, può verificarsi con qualsiasi sistema di apprendimento, incluso l’apprendimento “few-shot” dei grandi modelli di linguaggio (LLM). Gli approcci di apprendimento “few-shot” mirano a costruire modelli accurati con meno dati di addestramento.

Abbiamo chiesto a un LLM, Gopher, di valutare espressioni lineari che coinvolgono variabili sconosciute e costanti, come x+y-3. Per risolvere queste espressioni, Gopher deve prima chiedere i valori delle variabili sconosciute. Gli forniamo dieci esempi di addestramento, ognuno dei quali coinvolge due variabili sconosciute.

Al momento del test, al modello vengono poste domande con zero, una o tre variabili sconosciute. Anche se il modello si generalizza correttamente alle espressioni con una o tre variabili sconosciute, quando non ci sono variabili sconosciute, fa comunque domande ridondanti come “Cosa è 6?”. Il modello fa sempre almeno una domanda all’utente prima di dare una risposta, anche quando non è necessario.

All’interno del nostro articolo, forniamo ulteriori esempi in altri contesti di apprendimento.

Affrontare GMG è importante per allineare i sistemi di AI con gli obiettivi dei loro progettisti semplicemente perché è un meccanismo attraverso il quale un sistema di AI può mancare l’obiettivo. Questo sarà particolarmente critico quando ci avvicineremo all’intelligenza artificiale generale (AGI).

Considera due possibili tipi di sistemi AGI:

- A1: Modello inteso. Questo sistema di AI fa ciò che i suoi progettisti intendono che faccia.

- A2: Modello ingannevole. Questo sistema di AI persegue un obiettivo indesiderato, ma (per assunzione) è anche abbastanza intelligente da sapere che verrà penalizzato se si comporta in modo contrario alle intenzioni del suo progettista.

Dato che A1 e A2 mostreranno lo stesso comportamento durante l’addestramento, la possibilità di GMG significa che entrambi i modelli potrebbero prendere forma, anche con una specifica che premia solo il comportamento desiderato. Se A2 viene appreso, cercherà di eludere la supervisione umana al fine di attuare i suoi piani verso l’obiettivo non desiderato.

Il nostro team di ricerca sarebbe lieto di vedere ulteriori studi che indaghino quanto è probabile che si verifichi GMG nella pratica e le possibili mitigazioni. Nel nostro articolo, suggeriamo alcuni approcci, tra cui interpretabilità meccanicistica e valutazione ricorsiva, su entrambi stiamo lavorando attivamente.

Attualmente stiamo raccogliendo esempi di GMG in questo foglio di calcolo pubblicamente disponibile. Se hai incontrato una misgeneralizzazione degli obiettivi nella ricerca sull’IA, ti invitiamo a inviare gli esempi qui.