Misurare la percezione nei modelli di intelligenza artificiale

Misurare la percezione nell'IA

Nuovo benchmark per valutare i sistemi multimodali basati su dati video, audio e testo reali

Dal test di Turing a ImageNet, i benchmark hanno svolto un ruolo fondamentale nello sviluppo dell’intelligenza artificiale (AI) aiutando a definire gli obiettivi di ricerca e consentendo ai ricercatori di misurare i progressi verso quegli obiettivi. Incredibili progressi negli ultimi 10 anni, come AlexNet nella visione artificiale e AlphaFold nella piegatura delle proteine, sono stati strettamente legati all’utilizzo di benchmark che consentono ai ricercatori di classificare le scelte di progettazione e formazione dei modelli e di iterare per migliorare i loro modelli. Mentre lavoriamo verso l’obiettivo di costruire un’intelligenza artificiale generale (AGI), lo sviluppo di benchmark robusti ed efficaci che amplino le capacità dei modelli AI è altrettanto importante quanto lo sviluppo dei modelli stessi.

La percezione, il processo di esperienza del mondo attraverso i sensi, è una parte significativa dell’intelligenza. E costruire agenti con una comprensione percettiva del mondo a livello umano è un compito centrale ma sfidante, che sta diventando sempre più importante nella robotica, nelle auto a guida autonoma, negli assistenti personali, nell’imaging medico e altro ancora. Quindi oggi stiamo introducendo il Perception Test, un benchmark multimodale che utilizza video del mondo reale per valutare le capacità di percezione di un modello.

Sviluppo di un benchmark di percezione

Attualmente vengono utilizzati molti benchmark correlati alla percezione nella ricerca di AI, come Kinetics per il riconoscimento delle azioni nei video, Audioset per la classificazione degli eventi audio, MOT per il tracciamento degli oggetti o VQA per il question-answering delle immagini. Questi benchmark hanno portato a progressi straordinari nella progettazione e nello sviluppo delle architetture e dei metodi di formazione dei modelli AI, ma ognuno di essi si concentra solo su aspetti limitati della percezione: i benchmark delle immagini escludono gli aspetti temporali; la visual question-answering si concentra principalmente sulla comprensione semantica a livello elevato della scena; i compiti di tracciamento degli oggetti catturano principalmente l’aspetto a livello inferiore degli oggetti individuali, come il colore o la texture. E pochissimi benchmark definiscono compiti su entrambe le modalità audio e visiva.

I modelli multimodali, come Perceiver, Flamingo o BEiT-3, mirano a essere modelli più generali di percezione. Ma le loro valutazioni erano basate su diversi dataset specializzati perché non era disponibile un benchmark dedicato. Questo processo è lento, costoso e fornisce una copertura incompleta delle capacità generali di percezione come la memoria, rendendo difficile per i ricercatori confrontare i metodi.

- Trasformazione digitale con Google Cloud

- La ricerca dell’istruzione sull’IA – passato, presente e futuro

- Migliori pratiche per l’arricchimento dei dati

Per affrontare molti di questi problemi, abbiamo creato un dataset di video appositamente progettati di attività del mondo reale, etichettati secondo sei diversi tipi di compiti:

- Tracciamento degli oggetti: viene fornita una casella intorno a un oggetto all’inizio del video, il modello deve restituire un tracciamento completo durante tutto il video (anche attraverso le occlusioni).

- Tracciamento dei punti: viene selezionato un punto all’inizio del video, il modello deve tracciare il punto durante tutto il video (anche attraverso le occlusioni).

- Localizzazione temporale delle azioni: il modello deve localizzare e classificare temporalmente un insieme predefinito di azioni.

- Localizzazione temporale dei suoni: il modello deve localizzare e classificare temporalmente un insieme predefinito di suoni.

- Question-answering video a scelta multipla: domande testuali sul video, ognuna con tre scelte tra cui selezionare la risposta.

- Question-answering video basato su fatti: domande testuali sul video, il modello deve restituire uno o più tracciamenti degli oggetti.

Ci siamo ispirati al modo in cui la percezione dei bambini viene valutata nella psicologia dello sviluppo, così come ai dataset sintetici come CATER e CLEVRER, e abbiamo progettato 37 script video, ognuno con diverse variazioni per garantire un dataset bilanciato. Ogni variazione è stata filmata da almeno una dozzina di partecipanti reclutati online (simile a lavori precedenti su Charades e Something-Something), per un totale di oltre 100 partecipanti, con un totale di 11.609 video, con una durata media di 23 secondi.

I video mostrano giochi semplici o attività quotidiane, che ci consentirebbero di definire compiti che richiedono le seguenti abilità per essere risolti:

- Conoscenza della semantica: testare aspetti come il completamento del compito, il riconoscimento degli oggetti, delle azioni o dei suoni.

- Comprensione della fisica: collisioni, movimento, occlusioni, relazioni spaziali.

- Ragionamento temporale o memoria: ordinamento temporale degli eventi, conteggio nel tempo, rilevamento dei cambiamenti in una scena.

- Abilità di astrazione: corrispondenza di forme, concetti di uguale/diverso, rilevazione di pattern.

I partecipanti reclutati online hanno etichettato i video con annotazioni spaziali e temporali (tracce di bounding box degli oggetti, tracce di punti, segmenti di azione, segmenti di suono). Il nostro team di ricerca ha progettato le domande per i compiti di question-answering video a scelta multipla e basato su fatti per assicurare una buona diversità delle abilità testate, ad esempio, domande che indagano la capacità di ragionare in modo controfattuale o di fornire spiegazioni per una situazione data. Le risposte corrispondenti per ogni video sono state fornite ancora una volta dai partecipanti reclutati online.

Valutare i sistemi multimodali con il Test di Percezione

Assumiamo che i modelli siano stati pre-addestrati su set di dati e compiti esterni. Il Test di Percezione include un piccolo set di messa a punto (20%) che i creatori del modello possono eventualmente utilizzare per comunicare la natura dei compiti ai modelli. I dati rimanenti (80%) consistono in una divisione pubblica di convalida e una divisione di test con cui le prestazioni possono essere valutate solo tramite il nostro server di valutazione.

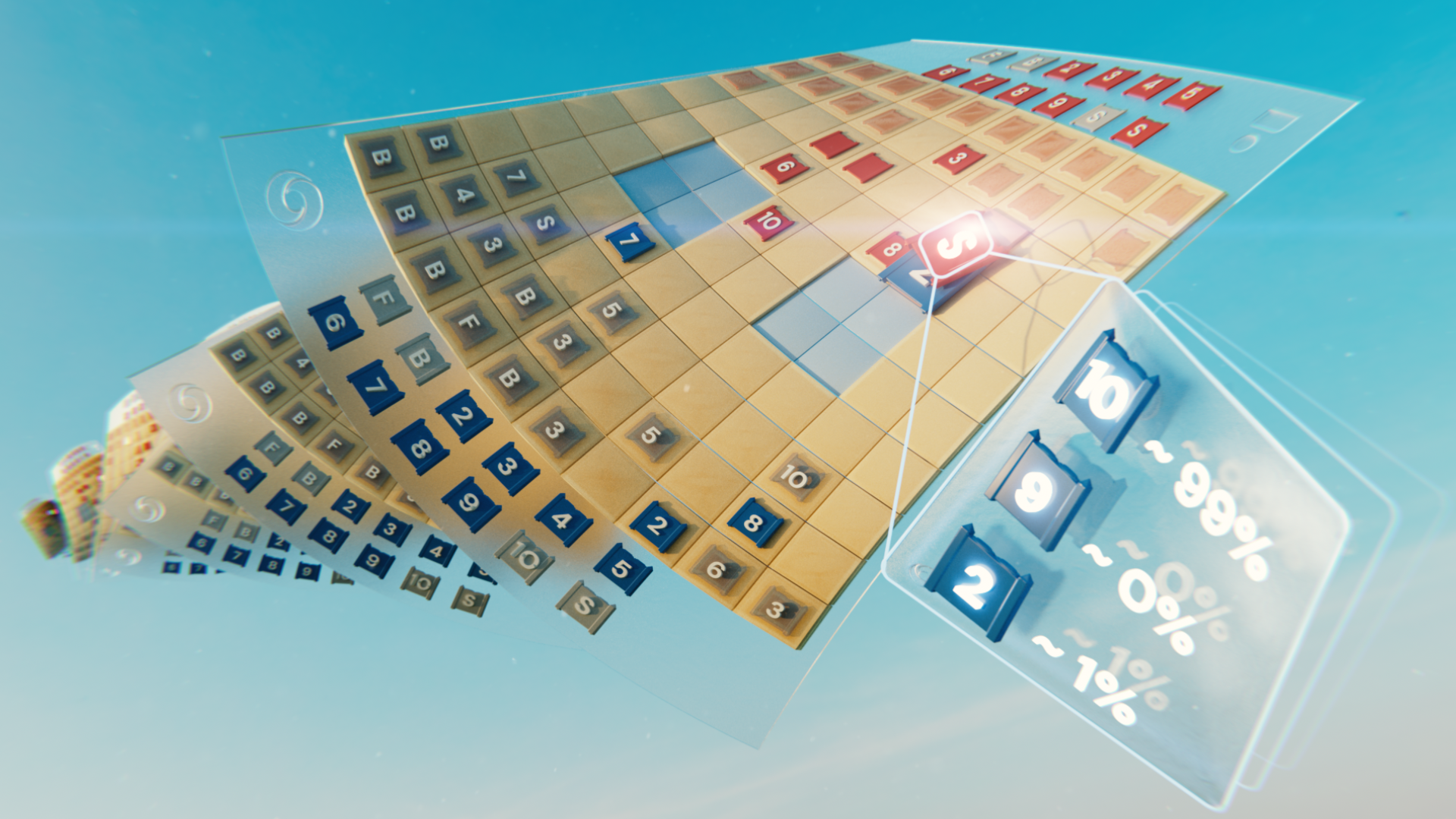

Qui mostriamo un diagramma della configurazione di valutazione: gli input sono un video e una sequenza audio, oltre a una specifica di compito. Il compito può essere in forma di testo ad alto livello per il question answering visivo o un input a basso livello, come le coordinate del bounding box di un oggetto per il compito di tracciamento oggetti.

I risultati della valutazione sono dettagliati su diverse dimensioni e misuriamo le capacità nei sei compiti computazionali. Per i compiti di question answering visivo forniamo anche una mappatura delle domande nei tipi di situazioni mostrate nei video e nei tipi di ragionamento richiesto per rispondere alle domande per un’analisi più dettagliata (vedi il nostro articolo per ulteriori dettagli). Un modello ideale dovrebbe massimizzare i punteggi in tutti i grafici radar e in tutte le dimensioni. Si tratta di una valutazione dettagliata delle capacità di un modello, che ci permette di circoscrivere le aree di miglioramento.

Assicurare la diversità dei partecipanti e delle scene mostrate nei video è stata una considerazione critica durante lo sviluppo del benchmark. Per fare ciò, abbiamo selezionato partecipanti provenienti da diversi paesi di diverse etnie e generi e abbiamo cercato di avere una rappresentazione diversificata all’interno di ciascun tipo di script video.

Scoprire di più sul Test di Percezione

Il benchmark del Test di Percezione è pubblicamente disponibile qui e ulteriori dettagli sono disponibili nel nostro articolo. Presto sarà disponibile anche una classifica e un server di sfida.

Il 23 ottobre 2022 ospiteremo un workshop sui modelli di percezione generale presso la Conferenza Europea sulla Visione Artificiale a Tel Aviv (ECCV 2022), dove discuteremo del nostro approccio e di come progettare ed valutare i modelli di percezione generale con altri esperti di spicco del settore.

Speriamo che il Test di Percezione possa ispirare e guidare ulteriori ricerche verso modelli di percezione generale. In futuro, speriamo di collaborare con la comunità di ricerca multimodale per introdurre ulteriori annotazioni, compiti, metriche o addirittura nuovi linguaggi nel benchmark.

Contattaci inviando un’email a [email protected] se sei interessato a contribuire!