Questa newsletter sull’IA è tutto ciò di cui hai bisogno #61

Newsletter IA #61 - tutto ciò che serve

Cosa è successo questa settimana nell’ambito dell’AI di Louie

Negli ultimi mesi abbiamo continuato a vedere grandi progressi nei modelli di linguaggio (LLM) e una graduale introduzione di nuove tecniche, ma non abbiamo ancora assistito a una competizione diretta mirata a sostituire GPT-4 come modello più avanzato (e ad alta intensità di calcolo per l’addestramento). Google ha consolidato i suoi sforzi nell’ambito dell’AI unendo Google Brain e Deepmind all’inizio di quest’anno ed ha anche incrementato rapidamente le risorse di calcolo per l’addestramento. Il suo modello Gemini sarà probabilmente il primo importante nuovo rilascio da questa nuova collaborazione. Google ha gradualmente generato aspettative per Gemini rivelando informazioni attraverso interviste e comunicati stampa controllati. L’azienda si sta probabilmente preparando affinché Gemini svolga il ruolo di risposta a GPT-4, con l’ambizione di superarlo in determinate capacità.

Con il rilascio che si sta preparando, secondo le notizie, per “questo autunno”, siamo entusiasti di vedere quali nuove innovazioni e capacità porterà Gemini e come si piazzerà rispetto a GPT-4. Lo sforzo è guidato da Oriol Vinyals e Koray Kavukcuoglu, insieme a Jeff Dean, che supervisiona centinaia di dipendenti nello sviluppo di Gemini. Abbiamo sentito diverse cose sul modello, sia attraverso citazioni dirette dalla dirigenza che attraverso fughe di notizie. “Gemini combina i punti di forza presenti nei sistemi di tipo AlphaGo con le eccezionali capacità linguistiche proprie dei grandi modelli”, Demis Hassabis. Sappiamo anche che il modello ha iniziato ad essere addestrato prima di maggio; “Siamo già al lavoro su Gemini, il nostro prossimo modello creato da zero per essere multimodale, altamente efficiente nelle integrazioni di strumenti e API, e costruito per consentire future innovazioni, come la memoria e la pianificazione. Gemini è ancora in fase di addestramento, ma sta già mostrando capacità multimodali mai viste prima nei modelli precedenti”, Google CEO blog, 23 maggio. Si prevede che il modello sia multimodale, con capacità di generazione di immagini complete come Midjourney. Abbiamo anche sentito dire che Google sta avendo cura del suo set di addestramento e che potrebbe aver integrato dati video e audio da YouTube in Gemini.

La continua rivalità tra Google e OpenAI è eccitante da osservare e sarà interessante vedere come si svilupperanno questi sviluppi in futuro e in particolare quali tecniche di AlphaGo Deepmind verranno integrate nei LLM. Sembra che quest’anno vedremo un’evoluzione ancora più entusiasmante nei LLM!

– Louie Peters – Co-fondatore e CEO di Towards AI

- Impara i concetti di base di MLOps con questo eBook gratuito

- Le 5 domande principali che gli Ingegneri dei Dati dovrebbero fare prima di unirsi a una startup

- Presentazione di IDEFICS una riproduzione aperta di un modello di linguaggio visivo all’avanguardia.

Questo numero ti è offerto grazie a OVHcloud:

OVHcloud offre GPU a prezzi imbattibili per soddisfare le tue esigenze di intelligenza artificiale. Questo include una selezione di istanze cloud NVIDIA con uno sconto fino al 60% rispetto ai prezzi normali, fino ad esaurimento scorte. Progettato per accelerare l’elaborazione dei dati con la garanzia di reversibilità completa dei dati e flessibilità delle risorse, il portfolio di AI di OVHcloud include anche server bare metal e soluzioni di ML open-source come AI Notebooks, AI Training e AI Deploy, che beneficiano tutti della tecnologia di raffreddamento ad acqua di OVHcloud per ottenere il consumo energetico più basso.

Notizie più calde

- La prossima grande rivelazione open source di Meta sarà probabilmente un bot generatore di codice

La prossima release AI di Meta sarà probabilmente una macchina per il coding. Questo nuovo modello, chiamato “Code Llama”, sarà open source e disponibile gratuitamente online. Potrebbe essere rilasciato già dalla prossima settimana. Questo è coerente con la strategia dell’azienda fino ad ora di rilasciare software AI ampiamente disponibili che semplificano lo sviluppo di nuovi modelli AI personalizzabili.

2. Moderazione dei contenuti di OpenAI

OpenAI ha proposto l’utilizzo di GPT-4 per lo sviluppo di politiche dei contenuti e per facilitare le decisioni di moderazione dei contenuti su piattaforme digitali. Questo approccio mira a sollevare gli esseri umani dal peso coinvolto, consentendo così una marcatura più uniforme dei contenuti e accelerando i cicli di feedback.

3. Microsoft pianifica un servizio AI con Databricks che potrebbe danneggiare OpenAI

L’offerta recente di Azure+Databricks da parte di Microsoft fornisce agli utenti di Databricks la possibilità di utilizzare qualsiasi modello AI, inclusi i LLM open source, per addestrare i loro dati sulla piattaforma Azure. Ciò potrebbe potenzialmente portare a una diminuzione del numero di aziende che acquistano licenze per i modelli OpenAI per soddisfare casi d’uso simili.

4. Gli esperti di AI di punta di Google pianificano di creare il loro proprio studio di sviluppo in Giappone

Top esperti di AI di Google, la cui ricerca ha contribuito allo sviluppo di AI bots come ChatGPT di OpenAI, Google Bard, Stability AI, Midjourney e Dall-E, hanno intenzione di creare i loro studi di sviluppo di AI indipendenti. Sakana AI guida gli sforzi per creare il proprio modello AI generativo, ossia un software in grado di creare testo, immagini, codice e altro ancora.

5. L’IA di parte ha bisogno dell’aiuto umano per evitare azioni dannose sul clima, dicono i ricercatori

Secondo un nuovo studio dei ricercatori dell’Università di Cambridge, il pregiudizio nella raccolta dei dati su cui si basano i programmi informatici di intelligenza artificiale può limitare l’utilità dei climatologi nella previsione di scenari futuri e nell’orientamento dell’azione globale. Lo studio conclude che la tecnologia guidata dall’uomo rimane fondamentale nello sviluppo di un’intelligenza artificiale socialmente responsabile.

Cinque letture/video di 5 minuti per continuare a imparare

- Elenco di lettura Anti-Hype LLM

Navigare l’attuale hype sull’IA può essere impegnativo, rendendo difficile distinguere ciò che è veramente sostanziale. Questa compilazione comprende una raccolta attentamente curata di articoli fondamentali, interessanti domande aperte e una guida per approfondire la conoscenza del settore.

2. Perché (probabilmente) non hai bisogno di sintonizzare finemente un LLM

Questo post approfondisce le ragioni per cui la sintonizzazione fina potrebbe non essere essenziale per la tua applicazione. Esplora in modo approfondito cosa comporta la sintonizzazione fina e analizza possibili alternative. Il contenuto è rivolto a coloro che si concentrano sulla creazione di applicazioni LLM.

3. Sfide aperte nella ricerca LLM

La rapida crescita dell’IA ha dato origine a nuove direzioni di ricerca. Questo articolo riunisce le sfide prevalenti nella ricerca LLM, come la multimodalità, le alternative alle GPU, le architetture innovative e altro ancora.

4. AI2 Dolma: corpus aperto di 3 trilioni di token per il preaddestramento del modello linguistico

AI2 Dolma è un dataset di 3 trilioni di token tratti da una vasta gamma di fonti, tra cui contenuti web, pubblicazioni accademiche, repository di codice, libri e materiali enciclopedici. Il suo obiettivo principale è fornire ai ricercatori i mezzi per indagare l’impatto dei dati su larga scala. È facilmente accessibile per il download su HuggingFace Hub.

5. Suggerimenti per la scrittura di articoli NLP

Questo post condivide come costruire un processo standardizzato per la scrittura di articoli NLP. Presenta componenti essenziali, tra cui strutturazione del contenuto, precisione del linguaggio, revisioni della letteratura esaustive, citazioni accurate e altro ancora. Sebbene alcuni suggerimenti siano rivolti alla ricerca NLP, i principi qui esposti possono essere efficacemente applicati in diversi settori.

Articoli e repository

- Allineamento automatico con backtranslation delle istruzioni

Questo articolo presenta un metodo scalabile per costruire un modello linguistico di alta qualità per seguire istruzioni, etichettando automaticamente il testo scritto dall’uomo con le istruzioni corrispondenti. Si parte da un modello linguistico sintonizzato su una piccola quantità di dati iniziali e un corpus web fornito.

2. Neuralangelo: Ricostruzione di superfici neurali ad alta fedeltà

Questo articolo presenta Neuralangelo, che combina la potenza di rappresentazione delle griglie a hash 3D a multi-risoluzione con il rendering di superfici neurali. I due ingredienti chiave che consentono questo approccio sono i gradienti numerici per il calcolo delle derivate di ordine superiore e l’ottimizzazione da grossolana a fine sulle griglie a hash.

3. Filtraggio collaborativo coerente tramite scomposizione di tensori

Questo lavoro ha sviluppato la Sliced Anti-symmetric Decomposition (SAD), un nuovo modello per il filtraggio collaborativo basato su feedback impliciti. SAD produce le preferenze personalizzate più coerenti mantenendo un alto livello di precisione nelle raccomandazioni personalizzate.

4. Generazione guidata efficiente per grandi modelli linguistici

Questo articolo mostra come il problema della generazione di testo neurale possa essere riformulato in modo costruttivo in termini di transizioni tra gli stati di una macchina a stati finiti. Guida la generazione di testo con espressioni regolari e grammatica libera dal contesto consentendo la costruzione di un indice su un vocabolario del modello linguistico.

5. neuml/txtai

Txtai è un database di incorporamento open source all-in-one per la ricerca semantica, l’orchestrazione LLM e i flussi di lavoro dei modelli linguistici. Può essere configurato in pochi minuti, viene eseguito localmente, ha un’occupazione ridotta e funziona con micromodelli fino a grandi modelli linguistici.

Ti sono piaciuti questi articoli e riassunti di notizie? Ricevi un riassunto giornaliero nella tua casella di posta!

Sezione Community di Learn AI Together!

Meme della settimana!

Meme condiviso da rucha8062

Post della community in evidenza dal Discord

Marcklingen ha recentemente presentato “langfuse”, uno strumento open-source di osservabilità e analisi progettato per le applicazioni LLM (Large Language Model). Questo strumento consente agli utenti di accelerare il processo di sviluppo delle loro applicazioni fornendo una prospettiva dettagliata di tracce di esecuzione precise, che comprendono aspetti come qualità, costo e latenza. Attualmente, Langfuse Analytics è nella fase alpha chiusa, durante la quale il team principale collabora con un gruppo di utenti per costruire la piattaforma di analisi più utile per le applicazioni LLM. Dai un’occhiata su GitHub e supporta un altro membro della community. Condividi i tuoi feedback e domande nel thread qui.

Sezione curata da TAI

Articolo della settimana

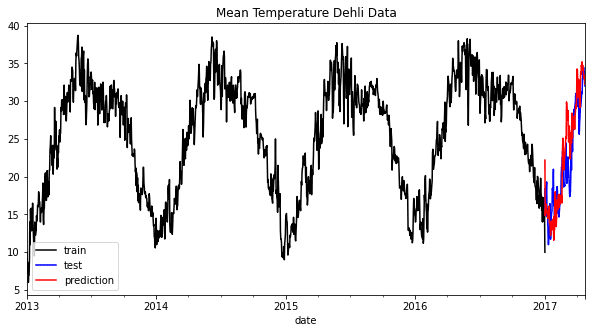

Come ho costruito un sistema di raccomandazione video utilizzando grandi modelli di linguaggio e un database di vettori di Zoumana Keita

In questo articolo, imparerai come sfruttare grandi modelli di linguaggio, strumenti di analisi testuale e vocale all’avanguardia e database di vettori per creare una soluzione di raccomandazione audio end-to-end. Questa soluzione suggerirà i migliori video in base agli interessi degli utenti.

I nostri articoli da leggere assolutamente

Il nuovo modello testo-immagine di Metas – CM3leon Paper spiegato da Boris Meinardus

Usa LangChain per estrarre un dizionario dal testo di Eugenia Anello

Occupato? Questa è la tua guida rapida per aprire la scatola nera dei modelli di diffusione di Paul Iusztin

Se desideri pubblicare su Towards AI, consulta le nostre linee guida e registrati. Pubblicheremo il tuo lavoro sulla nostra rete se rispetta le nostre politiche editoriali e i nostri standard.

Offerte di lavoro

Senior Staff Writer (Software Tecnico) @Future Publishing (Londra, Regno Unito)

Junior Software Engineer (React.js) — OP01114 @Dev.Pro (Remoto)

Architetto delle soluzioni (Sviluppo software) @Uni Systems (Varsavia, Polonia)

Ingegnere del software @Mention Me (Remoto)

Ingegnere del software, Full Stack @Basetwo (Remoto)

Ingegnere dei dati senior @Hertility Health (Remoto)

Ingegnere di intelligenza artificiale @Plain Concepts (Remoto)

Interessato a condividere un’opportunità di lavoro qui? Contatta [email protected].

Se stai preparando il tuo prossimo colloquio di machine learning, non esitare a visitare il nostro sito web leader nella preparazione di colloqui, confetti!