Abbattere la barriera dei dati come l’apprendimento senza dati, l’apprendimento con un solo esempio e l’apprendimento con pochi esempi stanno trasformando l’apprendimento automatico

L'apprendimento senza dati, l'apprendimento con un solo esempio e l'apprendimento con pochi esempi stanno trasformando l'apprendimento automatico.' - 'Breaking the data barrier like data-free learning, one-shot learning, and few-shot learning are transforming machine learning.

Introduzione

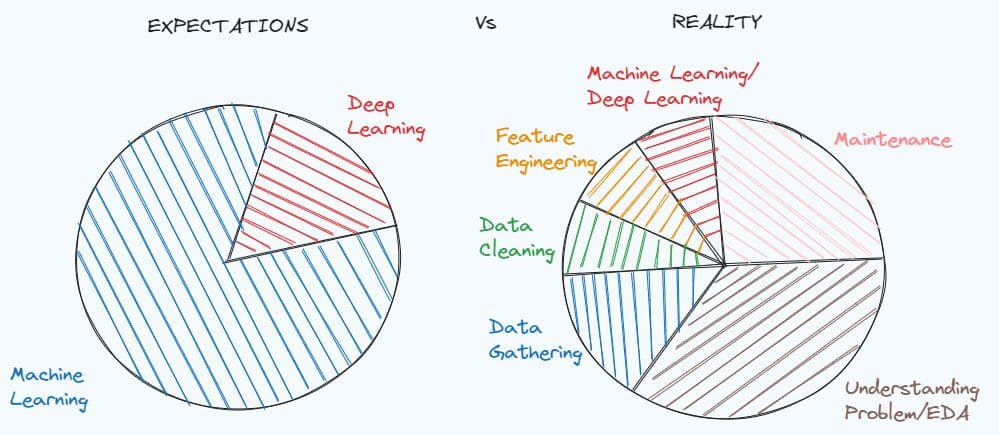

Nel mondo in continua evoluzione di oggi, la tecnologia sta migliorando ogni giorno e l’Apprendimento Automatico (Machine Learning) e l’Intelligenza Artificiale (Artificial Intelligence) hanno rivoluzionato una varietà di settori grazie al potere dell’automazione dei processi e all’efficienza migliorata. Tuttavia, gli esseri umani hanno ancora un vantaggio distintivo rispetto agli algoritmi tradizionali di apprendimento automatico perché questi algoritmi richiedono migliaia di campioni per rispondere alle correlazioni sottostanti e identificare un oggetto.

- Dieci casi comuni di dati errati da conoscere e le relative soluzioni

- 5 Milionari che utilizzano ChatGPT

- Incontra ToolLLM un framework generale per la costruzione di dati e l’addestramento di modelli che migliora l’utilizzo dell’API dei grandi modelli di linguaggio.

Immagina la frustrazione di sbloccare il tuo smartphone usando le impronte digitali o il riconoscimento facciale effettuando 100 scansioni prima che l’algoritmo funzioni. Un tale tipo di funzione non sarebbe mai stato messo sul mercato.

Tuttavia, dal 2005, gli esperti di apprendimento automatico hanno sviluppato nuovi algoritmi che potrebbero cambiare completamente il gioco. I miglioramenti apportati negli ultimi quasi due decenni hanno prodotto algoritmi che possono imparare dal numero minimo (Zero, One o Few) di campioni.

In questo articolo, esploriamo i concetti dietro quegli algoritmi e forniamo una comprensione completa di come queste tecniche di apprendimento funzionano, mentre facciamo luce anche su alcune sfide incontrate durante la loro implementazione.

Come funziona l’apprendimento Zero-Shot?

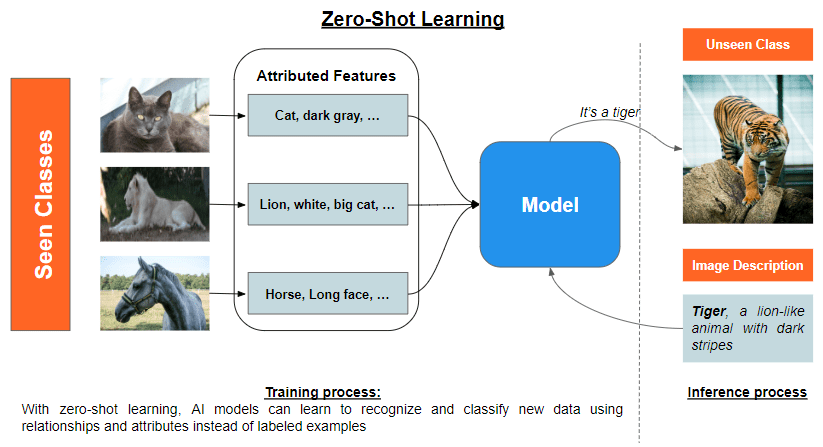

L’apprendimento Zero-Shot è il concetto di addestrare un modello a classificare oggetti che non ha mai visto prima. L’idea principale è sfruttare la conoscenza esistente di un altro modello per ottenere rappresentazioni significative delle nuove classi.

Utilizza l’incorporamento semantico o l’apprendimento basato su attributi per sfruttare in modo significativo la conoscenza precedente che può fornire una comprensione a livello superiore delle relazioni tra classi conosciute e sconosciute. Entrambi possono essere usati insieme o indipendentemente.

Gli incorporamenti semantici sono rappresentazioni vettoriali di parole, frasi o documenti che catturano il significato sottostante e la relazione tra di essi in uno spazio vettoriale continuo. Questi incorporamenti vengono tipicamente generati utilizzando algoritmi di apprendimento non supervisionato, come Word2Vec, GloVe o BERT. L’obiettivo è creare una rappresentazione compatta delle informazioni linguistiche, in cui significati simili siano codificati con vettori simili. In questo modo, gli incorporamenti semantici consentono confronti e manipolazioni efficienti e precise dei dati testuali e la generalizzazione alle classi non viste proiettando le istanze in uno spazio semantico continuo e condiviso.

L’apprendimento basato su attributi consente la classificazione di oggetti provenienti da classi non viste senza avere accesso a esempi etichettati di tali classi. Scompone gli oggetti nelle loro proprietà significative e rilevabili, che fungono da rappresentazione intermedia, consentendo al modello di stabilire una corrispondenza tra classi viste e non viste. Questo processo coinvolge tipicamente l’estrazione degli attributi, la previsione degli attributi e l’inferenza delle etichette.

- L’estrazione degli attributi consiste nel derivare attributi significativi e discriminativi per ciascuna classe di oggetti per colmare il divario tra le caratteristiche a basso livello e i concetti ad alto livello.

- La previsione degli attributi consiste nell’apprendere una corrispondenza tra le caratteristiche a basso livello delle istanze e gli attributi ad alto livello, utilizzando tecniche di apprendimento automatico per riconoscere pattern e relazioni tra le caratteristiche per generalizzare alle classi nuove.

- L’inferenza delle etichette consiste nella previsione dell’etichetta di classe di una nuova istanza utilizzando i suoi attributi previsti e le relazioni tra gli attributi e le etichette di classe non viste, senza fare affidamento su esempi etichettati.

Nonostante il potenziale promettente dell’apprendimento Zero-Shot, rimangono diverse sfide, come ad esempio:

- Adattamento di Dominio: La distribuzione delle istanze nel dominio di destinazione può differire significativamente da quella nel dominio di origine, portando a una discrepanza tra gli incorporamenti semantici appresi per classi viste e non viste. Questo cambiamento di dominio può danneggiare le prestazioni, poiché il modello potrebbe non stabilire una corrispondenza significativa tra istanze e attributi tra i domini. Per superare questa sfida, sono state proposte varie tecniche di adattamento di dominio, come l’apprendimento avversario, la separazione delle caratteristiche e l’apprendimento auto-supervisionato, mirando all’allineamento delle distribuzioni di istanze e attributi nei domini di origine e destinazione.

Come funziona l’apprendimento One-Shot?

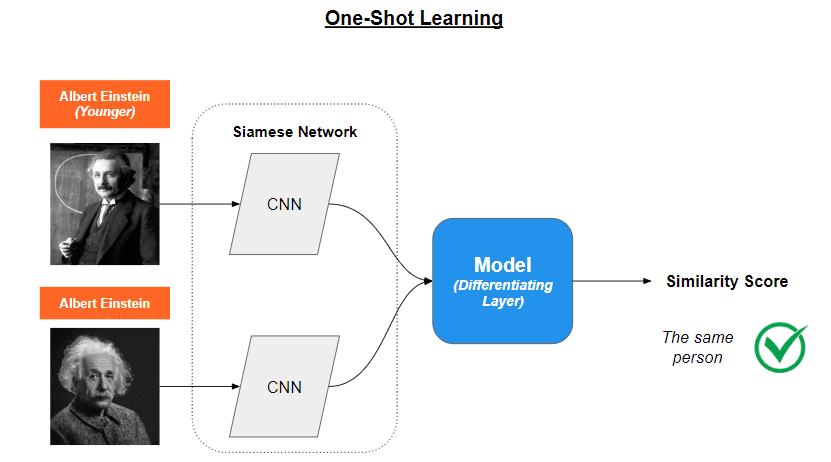

Nel processo di sviluppo di una rete neurale tradizionale, ad esempio per identificare le automobili, il modello ha bisogno di migliaia di campioni, catturati da angolazioni e contrasti diversi, al fine di differenziarle efficacemente. L’apprendimento One-Shot adotta un approccio diverso. Invece di identificare l’automobile in questione, il metodo determina se l’immagine A è equivalente all’immagine B. Ciò viene ottenuto generalizzando le informazioni che il modello ha acquisito dall’esperienza con compiti precedenti. L’apprendimento One-Shot è principalmente usato nella visione artificiale.

Le tecniche utilizzate per raggiungere questo obiettivo includono le Memory Augmented Neural Networks (MANNs) e le Siamese Networks. Sfruttando queste tecniche in modo indipendente, i modelli di apprendimento di tipo one-shot possono adattarsi rapidamente a nuovi compiti e ottenere buone prestazioni anche con dati molto limitati, rendendoli adatti a scenari reali in cui ottenere dati etichettati può essere costoso o richiedere molto tempo.

Le Memory Augmented Neural Networks (MANNs) sono una classe di reti neurali avanzate progettate per apprendere da pochissimi esempi, simili a come gli esseri umani possono imparare da un solo esempio di un nuovo oggetto. Le MANNs raggiungono questo obiettivo grazie a un componente di memoria aggiuntivo che può memorizzare e accedere alle informazioni nel tempo.

Immagina una MANN come un robot intelligente con un quaderno. Il robot può usare il suo quaderno per ricordare le cose che ha visto in precedenza e utilizzare quelle informazioni per capire le nuove cose che incontra. Questo aiuta il robot a imparare molto più velocemente rispetto a un modello di intelligenza artificiale tradizionale.

Le Siamese Networks, d’altra parte, sono progettate per confrontare campioni di dati utilizzando due o più sottoreti identiche con pesi condivisi. Queste reti apprendono una rappresentazione delle caratteristiche che cattura le differenze e le somiglianze fondamentali tra i campioni di dati.

Immagina le Siamese Networks come una coppia di detective gemelli che lavorano sempre insieme. Condividono la stessa conoscenza e competenze, e il loro compito è confrontare due oggetti e decidere se sono uguali o diversi. Questi detective osservano le caratteristiche importanti di ciascun oggetto e poi confrontano le loro scoperte per prendere una decisione.

La formazione di una rete Siamese si sviluppa in due fasi: la fase di verifica e la fase di generalizzazione.

- Durante la verifica, la rete determina se le due immagini di input o i punti di dati appartengono alla stessa classe o meno. La rete elabora separatamente entrambi gli input utilizzando le sottoreti gemelle.

- Durante la generalizzazione, il modello generalizza la sua comprensione dei dati di input apprendendo in modo efficace una rappresentazione delle caratteristiche che può discriminare tra diverse classi.

Una volta completate le due fasi, il modello è in grado di determinare se l’immagine A corrisponde all’immagine B.

L’apprendimento one-shot è molto promettente perché non è necessario addestrarlo nuovamente per rilevare nuove classi. Tuttavia, affronta sfide come l’elevato requisito di memoria e l’immensa necessità di potenza di calcolo, dato che sono necessarie due volte più operazioni per l’apprendimento.

Come funziona l’apprendimento Few-Shot?

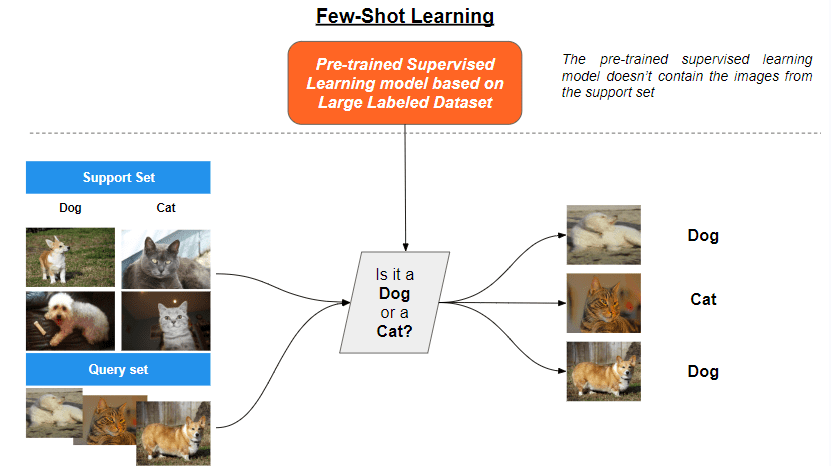

Il metodo di apprendimento finale presentato è l’Apprendimento Few-Shot, un sottocampo dell’apprendimento meta, che mira a sviluppare algoritmi capaci di apprendere da pochi esempi etichettati.

In questo contesto, le Prototypical Networks e il Model-Agnostic Meta-Learning (MAML) sono due tecniche alternative di rilievo che hanno dimostrato successo in scenari di apprendimento few-shot.

Prototypical Networks

Le Prototypical Networks sono una classe di reti neurali progettate per compiti di classificazione few-shot. L’idea principale è quella di apprendere un prototipo, o un esempio rappresentativo, per ogni classe nello spazio delle caratteristiche. I prototipi servono come base per la classificazione confrontando la distanza tra un nuovo input e i prototipi appresi.

Sono coinvolti tre passaggi principali:

- Incorporamento: La rete calcola un incorporamento per ogni input utilizzando un codificatore di reti neurali, come una Convolutional Neural Network (CNN) o una Recurrent Neural Network (RNN). Gli incorporamenti sono rappresentazioni ad alta dimensionalità che catturano le caratteristiche salienti dei dati di input.

- Calcolo del prototipo: Per ogni classe, la rete calcola il prototipo prendendo la media degli incorporamenti del set di supporto, che è un piccolo sottoinsieme di esempi etichettati per ogni classe. Il prototipo rappresenta il “centro” della classe nello spazio delle caratteristiche.

- Classificazione: Dato un nuovo input, la rete calcola il suo incorporamento e calcola la distanza (ad esempio, la distanza euclidea) tra l’incorporamento dell’input e i prototipi. L’input viene quindi assegnato alla classe con il prototipo più vicino.

Il processo di apprendimento prevede la minimizzazione di una funzione di perdita che incoraggia i prototipi ad essere più vicini agli incorporamenti della loro rispettiva classe e lontani dagli incorporamenti delle altre classi.

Meta-Learning Agnostico al Modello (MAML)

MAML è un algoritmo di meta-learning che mira a trovare una inizializzazione ottimale per i parametri del modello, in modo che possa adattarsi rapidamente a nuovi compiti con pochi passi di gradiente. MAML è agnostico al modello, il che significa che può essere applicato a qualsiasi modello addestrato con la discesa del gradiente.

MAML coinvolge i seguenti passaggi:

- Estrazione dei compiti: Durante la meta-formazione, i compiti vengono estratti da una distribuzione di compiti, dove ogni compito è un problema di apprendimento a pochi esempi con alcuni esempi etichettati.

- Apprendimento specifico del compito: Per ogni compito, i parametri del modello vengono ottimizzati utilizzando i dati di addestramento del compito (insieme di supporto) con alcuni passi di gradiente. Ciò porta a modelli specifici del compito con parametri aggiornati.

- Meta-apprendimento: L’obiettivo meta è minimizzare la somma delle perdite specifiche del compito sui dati di convalida (insieme di query) per tutti i compiti. I parametri iniziali del modello vengono aggiornati tramite la discesa del gradiente per raggiungere questo obiettivo.

- Meta-test: Dopo la meta-formazione, il modello può essere rapidamente ottimizzato su nuovi compiti con alcuni passi di gradiente, sfruttando l’inizializzazione appresa.

MAML richiede risorse computazionali significative, in quanto implica molteplici aggiornamenti nidificati del gradiente che presentano sfide. Una di queste sfide è la Diversità dei Compiti. In molti scenari di apprendimento a pochi esempi, il modello deve adattarsi a una vasta gamma di compiti o classi, ognuna con pochi esempi. Questa diversità può rendere difficile sviluppare un singolo modello o approccio che possa gestire efficacemente compiti o classi diverse senza un’ampia ottimizzazione o adattamento.

Conclusione

Il mondo incredibile dell’apprendimento automatico ci ha regalato tecniche innovative come l’apprendimento a zero, uno o pochi esempi. Questi approcci consentono ai modelli di intelligenza artificiale di imparare e riconoscere oggetti o modelli con solo una manciata di esempi, proprio come fanno gli esseri umani. Questo apre un mondo di possibilità in vari settori, come sanità, vendita al dettaglio e produzione, dove l’accesso a grandi quantità di dati etichettati non è sempre un lusso. Christophe Atten guida un team dinamico di scienziati dei dati nel settore finanziario e, dal 2022, è anche VoAGI AI Writer, focalizzato sulla trasformazione di dati grezzi in soluzioni informative.

Originale. Ripubblicato con il permesso.