Incontra Advanced Reasoning Benchmark (ARB) Un nuovo benchmark per valutare i grandi modelli di linguaggio.

Incontra ARB, un nuovo benchmark per valutare grandi modelli di linguaggio.

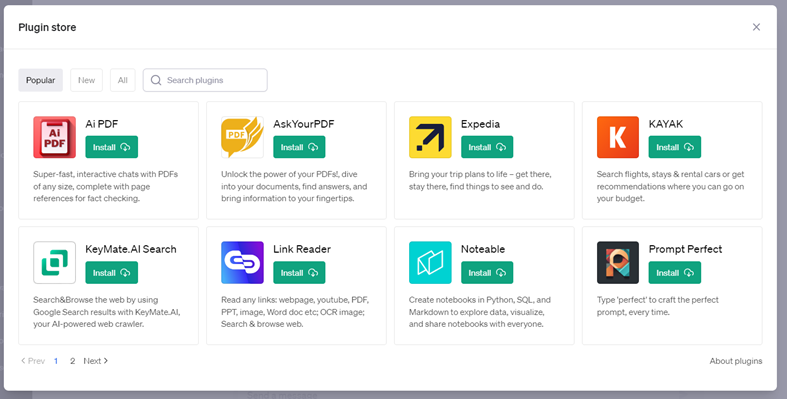

Il Natural Language Processing si è evoluto notevolmente negli ultimi anni, soprattutto con la creazione di modelli linguistici sofisticati. Quasi tutti i compiti di linguaggio naturale, compresa la traduzione e il ragionamento, hanno registrato progressi notevoli nelle prestazioni di modelli ben noti come GPT 3.5, GPT 4, BERT, PaLM, ecc. Una serie di benchmark viene utilizzata per valutare e valutare questi sviluppi nel campo dell’Intelligenza Artificiale. Il benchmark è essenzialmente una collezione di compiti standardizzati creati per testare le capacità dei modelli di linguaggio (LLM).

Considerando i benchmark GLUE e SuperGLUE, che sono stati tra i primi benchmark di comprensione del linguaggio, modelli come BERT e GPT-2 sono stati più impegnativi poiché i modelli linguistici hanno superato questi benchmark, dando il via a una competizione tra lo sviluppo dei modelli e la difficoltà dei benchmark. Aumentare le dimensioni dei modelli e addestrarli su set di dati più grandi è la chiave per prestazioni migliorate. I modelli LLM hanno dimostrato prestazioni eccezionali su una varietà di benchmark che valutano la loro capacità di conoscenza e ragionamento quantitativo, ma quando questi modelli ottengono punteggi più alti rispetto agli standard attuali, è evidente che questi benchmark non sono più utili per valutare le capacità dei modelli.

Per affrontare le limitazioni, un team di ricercatori ha proposto un nuovo e unico benchmark chiamato ARB (Advanced Reasoning Benchmark). ARB è stato creato per affrontare problemi più complessi in diverse aree tematiche, come matematica, fisica, biologia, chimica e diritto. A differenza dei benchmark precedenti, ARB si concentra su problemi di ragionamento complessi nel tentativo di migliorare le prestazioni dei modelli LLM. Il team ha anche introdotto un insieme di domande di matematica e fisica come sottoinsieme di ARB che richiedono un pensiero simbolico sofisticato e una conoscenza approfondita della materia. Questi problemi sono eccezionalmente difficili e al di fuori del campo di applicazione dei modelli LLM esistenti.

- Articolo di Georgia Tech propone un metodo di intelligenza artificiale per identificare più velocemente i potenziali superconduttori

- LG AI Research propone QASA un nuovo set di dati di benchmark di intelligenza artificiale e un approccio computazionale

- La necessità di un gradiente di spiegabilità nell’IA

Il team ha valutato questi nuovi modelli sul benchmark ARB, inclusi GPT-4 e Claude. Questi modelli hanno faticato a gestire la complessità di queste difficoltà, come dimostrato dai risultati, che mostrano che si sono comportati significativamente al di sotto del 50% nelle attività più difficili contenute in ARB. Il team ha anche dimostrato un approccio di valutazione basato su una rubrica per migliorare il processo di valutazione. Utilizzando questa strategia, GPT-4 può valutare i propri processi di ragionamento intermedi mentre cerca di risolvere i problemi di ARB. Ciò amplia il campo del processo di revisione e fa luce sulla strategia di risoluzione dei problemi del modello.

Anche il sottoinsieme simbolico di ARB è stato sottoposto a revisione umana. Ai revisori umani è stato chiesto di risolvere i problemi e fornire le proprie valutazioni. Sono emersi accordi promettenti tra i revisori umani e i punteggi di valutazione basati sulla rubrica di GPT-4, suggerendo che l’autovalutazione del modello sia ragionevolmente allineata al giudizio umano. Con centinaia di problemi che richiedono ragionamento esperto in campi quantitativi, in cui i modelli LLM hanno di solito incontrato difficoltà, il nuovo set di dati supera significativamente i benchmark precedenti.

A differenza delle domande a scelta multipla nei benchmark precedenti, un numero considerevole di problemi è costituito da domande a risposta breve e a risposta aperta, rendendo più difficile valutare i modelli LLM. La combinazione di compiti di ragionamento di livello esperto e formati di domande più realistici consente una valutazione più accurata delle capacità dei modelli nel gestire problemi complessi del mondo reale.