Ricercatori dell’Università Nazionale di Singapore propongono Mind-Video un nuovo strumento di intelligenza artificiale che utilizza i dati fMRI del cervello per ricreare immagini video.

Ricercatori dell'Università di Singapore propongono Mind-Video, un nuovo strumento di intelligenza artificiale che utilizza i dati fMRI per ricreare video.

Comprendere la cognizione umana ha reso affascinante la ricostruzione della visione umana dai processi cerebrali, specialmente quando si impiegano tecnologie non invasive come la risonanza magnetica funzionale (fMRI). Ci sono stati molti progressi nel recupero di immagini statiche da registrazioni cerebrali non invasive, ma non molto per quanto riguarda esperienze visive continue come i film.

Anche se le tecnologie non invasive raccolgono solo una quantità limitata di dati poiché sono meno robuste e più vulnerabili a influenze esterne come il rumore. Inoltre, raccogliere dati di neuroimaging è un processo che richiede tempo e costoso.

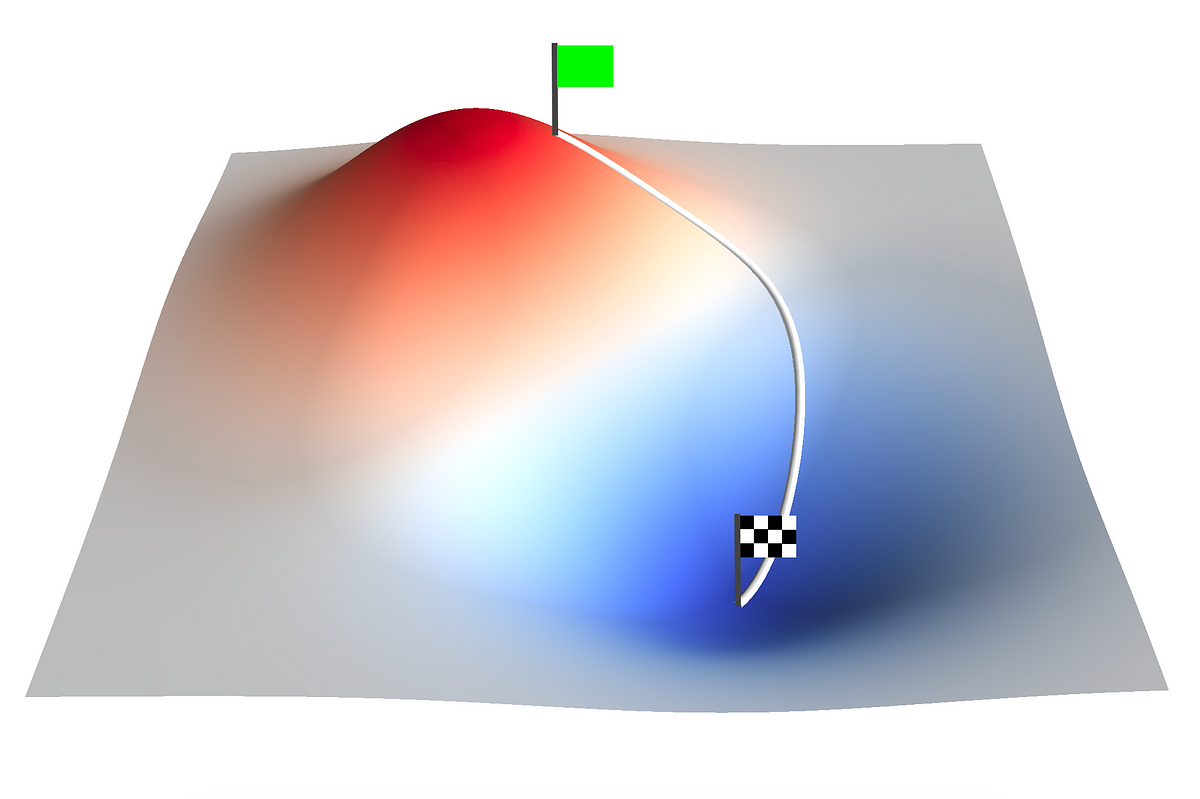

Nonostante queste sfide, sono stati fatti progressi, soprattutto nell’apprendimento di utili caratteristiche fMRI con coppie di annotazioni sparse fMRI. A differenza delle immagini statiche, l’esperienza visiva umana è uno stream continuo e in continua evoluzione di paesaggi, movimenti e oggetti. Poiché la fMRI misura i segnali di dipendenza dal livello di ossigenazione del sangue (BOLD) e scatta foto dell’attività cerebrale ogni pochi secondi, può essere difficile ripristinare un’esperienza visiva dinamica. Ogni lettura fMRI può essere considerata una “media” dell’attività cerebrale durante la scansione. Al contrario, la frequenza dei fotogrammi di un video standard è di 30 fotogrammi al secondo (FPS). Nel tempo necessario per acquisire un fotogramma fMRI, possono essere visualizzati 60 fotogrammi video come stimoli visivi, esponendo potenzialmente il soggetto a una vasta gamma di oggetti, azioni e ambienti. Pertanto, recuperare film a una frequenza di fotogrammi significativamente maggiore rispetto alla risoluzione temporale della fMRI mediante decodifica fMRI è una sfida.

- Ricercatori dell’UT Austin e dell’UC Berkeley introducono Ambient Diffusion un framework di intelligenza artificiale per addestrare/affinare modelli di diffusione dati solo con dati corrotti come input.

- Incontra QLORA un approccio di fine-tuning efficiente che riduce l’utilizzo della memoria abbastanza da permettere il fine-tuning di un modello a 65 miliardi di parametri su una singola GPU da 48 GB, preservando al contempo le prestazioni complete di fine-tuning a 16 bit.

- LLMs superano il Reinforcement Learning – Incontra SPRING un innovativo framework di prompting per LLMs progettato per consentire una pianificazione e un ragionamento in catena di pensiero in contesto

Ricercatori dell’Università Nazionale di Singapore e dell’Università Cinese di Hong Kong hanno introdotto MinD-Video, un modulo di decodifica cerebrale modulare che comprende un codificatore fMRI e un modello di diffusione stabile aumentato addestrati in modo indipendente e poi sintonizzati insieme. Il modello proposto raccoglie dati dal cervello in diverse fasi, espandendo la sua conoscenza del campo semantico.

Inizialmente, il team addestra caratteristiche fMRI visive generiche utilizzando l’apprendimento non supervisionato su larga scala e la modellazione cerebrale mascherata. Successivamente, utilizzano la multimodalità del dataset annotato per distillare le caratteristiche correlate al significato e utilizzano l’apprendimento contrastivo per addestrare il codificatore fMRI nello spazio di pre-addestramento immagine-linguaggio contrastivo (CLIP). Successivamente, un modello di diffusione stabile aumentato, progettato per la produzione di video utilizzando l’input fMRI, viene addestrato insieme alle caratteristiche apprese per affinarle.

I ricercatori hanno aggiunto una focalizzazione vicina al fotogramma al modello di diffusione stabile per generare video dinamici di scena. Hanno anche sviluppato un sistema guida avversario per condizionare le scansioni fMRI per scopi specifici. Sono stati recuperati video di alta qualità e le loro semantica, come i movimenti e la dinamica delle scene, erano perfetti.

Il team ha valutato i risultati utilizzando metriche semantiche e di pixel a livello di video e fotogrammi. Con un’accuratezza del 85% nelle metriche semantiche e 0,19 in SSIM, questo metodo è il 49% più efficace rispetto ai metodi precedenti più avanzati. I risultati suggeriscono anche che il modello sembra avere plausibilità biologica e interpretabilità in base ai risultati dello studio di attenzione, che hanno mostrato una mappatura con la corteccia visiva e le reti cognitive superiori.

A causa delle differenze individuali, la capacità della tecnica proposta di generalizzare tra i soggetti è ancora oggetto di studio. In questo metodo, vengono utilizzati meno del 10% dei voxel corticali per le ricostruzioni, mentre il pieno potenziale dei dati cerebrali totali rimane inutilizzato. I ricercatori ritengono che all’aumentare della complessità dei modelli, questa area troverà probabilmente utilizzo in settori come la neuroscienza e l’interfaccia cervello-computer (BCI).