Calcola facilmente i costi dell’API OpenAI con Tiktoken

Calcola i costi API OpenAI con Tiktoken

Conta i tuoi token e evita di andare in bancarotta usando l’API di OpenAI

Molte persone che conosco sono interessate a giocare con i grandi modelli linguistici (LLM) di OpenAI. Ma ospitare i LLM è costoso, quindi i servizi di inferenza come l’interfaccia di programmazione dell’applicazione (API) di OpenAI non sono gratuiti. Ma inserire le informazioni di pagamento senza sapere quali costi di inferenza si accumuleranno può essere un po’ intimidatorio.

Solitamente, mi piace includere un piccolo indicatore dei costi API di un tutorial dei miei articoli, in modo che i miei lettori sappiano cosa aspettarsi e possano avere un’idea dei costi di inferenza.

Questo articolo ti introduce alla libreria tiktoken che uso per stimare i costi di inferenza per i modelli della fondazione OpenAI.

Cos’è tiktoken?

tiktoken è un tokenizzatore di codifica a coppie di byte (BPE) open-source sviluppato da OpenAI che viene utilizzato per tokenizzare il testo nei loro LLM. Consente agli sviluppatori di contare quanti token ci sono in un testo prima di effettuare chiamate al punto di accesso di OpenAI.

- Una guida completa sui termini di interazione nella previsione delle serie temporali

- 130 trucchi e risorse di ML selezionati attentamente da 3 anni (più eBook gratuito)

- L’intersezione tra CDP e AI come l’intelligenza artificiale sta rivoluzionando le piattaforme di dati dei clienti

Quindi aiuta a stimare i costi associati all’utilizzo dell’API di OpenAI perché i costi vengono fatturati in unità di 1.000 token secondo la pagina dei prezzi di OpenAI [1].

GitHub — openai/tiktoken: tiktoken è un tokenizzatore BPE veloce da utilizzare con i modelli di OpenAI.

tiktoken è un tokenizzatore BPE veloce da utilizzare con i modelli di OpenAI. — GitHub — openai/tiktoken: tiktoken è un tokenizzatore BPE veloce…

github.com

Token e Tokenizzazione

I token sono sequenze comuni di caratteri in un testo, e la tokenizzazione è quando si divide una stringa di testo in una lista di token. Un token può essere uguale a una parola, ma di solito una parola è composta da più token.

I modelli di elaborazione del linguaggio naturale (NLP) sono addestrati sui token e comprendono le relazioni tra di essi. Pertanto, il testo di input viene tokenizzato prima che un modello NLP lo elabori.

Ma come vengono esattamente tokenizzate le parole dipende dal tokenizzatore utilizzato.

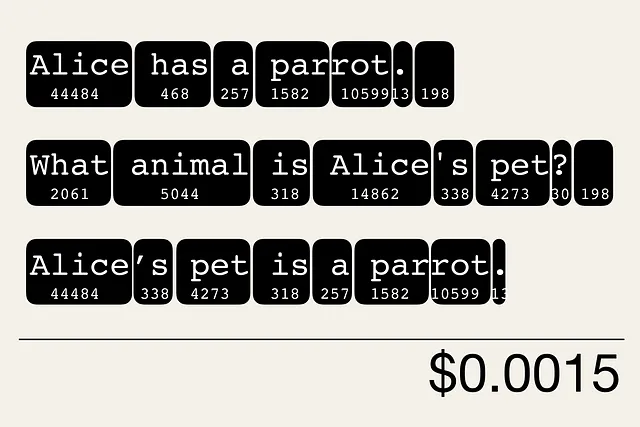

Sotto puoi vedere un esempio di come il testo

“Alice ha un pappagallo.

Quale animale è l’animale domestico di Alice?”