Dalla GPT-3 alle Future Generations dei modelli linguistici

From GPT-3 to Future Generations of Language Models.

Introduzione

I Large Language Models (LLM) hanno rivoluzionato l’elaborazione del linguaggio naturale, consentendo ai computer di generare testo simile a quello umano e di comprendere il contesto con una precisione senza precedenti. In questo articolo, discuteremo del futuro dei modelli di linguaggio? Come i LLM rivoluzioneranno il mondo? Tra i notevoli LLM, il Generative Pre-trained Transformer 3 (GPT-3) rappresenta una pietra miliare significativa, che ha affascinato il mondo con le sue impressionanti capacità di generazione di linguaggio. Tuttavia, poiché i LLM continuano ad evolversi, i ricercatori stanno affrontando le limitazioni e le sfide di GPT-3, aprendo la strada a future generazioni di modelli di linguaggio ancora più potenti.

Qui, esploreremo l’evoluzione dei LLM, partendo da GPT-3 e approfondendo i progressi, le applicazioni reali e le possibilità entusiasmanti che si aprono nel campo della modellizzazione del linguaggio.

Obiettivi di Apprendimento

- Comprendere i vari tipi di LLM.

- Sapere di GPT3 e dei suoi modelli base.

- Acquisire conoscenze sugli avanzamenti dei LLM.

- Imparare ad utilizzare i pesi dei LLM da Hugging Face e cosa sia il finetuning.

Questo articolo è stato pubblicato come parte del Data Science Blogathon.

I Diversi Tipi di LLMs

1. Base LLMs

I Base LLMs fungono da modelli di linguaggio pre-addestrati fondamentali che costituiscono il punto di partenza per una vasta gamma di compiti di elaborazione del linguaggio naturale (NLP). Prevede la prossima parola in base ai dati di addestramento del testo.

- Questa ricerca sull’Intelligenza Artificiale propone un metodo di sintesi vocale personalizzato Zero-Shot Lip2Speech un modello di sintesi vocale sintetico per abbinare i movimenti delle labbra.

- Immaginando il futuro dell’informatica

- Apprendimento automatico in uno spazio non euclideo

Applicazioni

- Generazione di Testo: I LLM eccellono nella generazione di testo coerente e rilevante dal punto di vista contestuale, rendendoli utili nella creazione di contenuti, nell’assistenza alla scrittura creativa e nella sintesi automatica.

- Risposta alle Domande: I LLM possono leggere e comprendere documenti di testo, consentendo loro di rispondere alle domande in base alle informazioni fornite.

- Traduzione Automatica: I LLM possono migliorare l’accuratezza e la fluidità dei sistemi di traduzione automatica, facilitando la traduzione del testo tra lingue diverse.

2. Instruction Tuned LLMs

I LLM intonati alle istruzioni si riferiscono ai modelli di linguaggio che hanno subito un fine-tuning o una specializzazione per compiti o istruzioni specifiche, mirati a conformarsi a quelle particolari istruzioni.

I Base LLMs forniscono una comprensione ampia del linguaggio, mentre i LLM intonati alle istruzioni sono specificamente addestrati ad aderire a linee guida o istruzioni specifiche, rendendoli più adatti per applicazioni particolari.

Applicazioni

- Traduzione Automatica: I LLM intonati alle istruzioni possono essere messi a punto sui singoli coppie o domini di lingue per migliorare la qualità e l’accuratezza della traduzione.

- Analisi del Sentimento: I LLM intonati alle istruzioni possono essere messi a punto per eseguire l’analisi del sentimento in modo più accurato fornendo istruzioni o esempi specifici durante l’addestramento.

- Riconoscimento delle Entità Nominative: I LLM intonati alle istruzioni possono essere messi a punto per rilevare entità nominative (ad esempio, persone, organizzazioni, luoghi) con maggiore precisione e richiamo.

- Riconoscimento dell’Intento: I LLM intonati alle istruzioni possono essere messi a punto per riconoscere e comprendere con precisione gli intenti degli utenti in applicazioni come assistenti vocali o chatbot.

Sia i Base LLMs che i LLM intonati alle istruzioni svolgono ruoli essenziali nello sviluppo dei modelli di linguaggio e nelle applicazioni di NLP. I Base LLMs forniscono una solida base con la loro comprensione del linguaggio generale, mentre i LLM intonati alle istruzioni offrono un livello di personalizzazione e specificità per soddisfare i requisiti di compiti o istruzioni specifici.

Mediante il fine-tuning dei LLM con istruzioni specifiche, prompt o dati specifici del dominio, i LLM intonati alle istruzioni possono fornire prestazioni migliorate e una migliore allineamento con compiti o domini specifici rispetto ai Base LLMs.

GPT-3: Una pietra miliare nello sviluppo di LLM

Generative Pre-trained Transformer 3 (GPT-3) è emerso come un risultato innovativo nel campo dei Large Language Models (LLM). Questo modello di trasformazione è stato oggetto di grande attenzione per le sue eccezionali capacità di generazione del linguaggio naturale e ha spinto i confini di ciò che era precedentemente ritenuto possibile nell’elaborazione del linguaggio naturale.

Modelli di base GPT 3

I modelli GPT-3 hanno la capacità di comprendere e generare il linguaggio naturale. I modelli di base GPT 3 sono gli unici modelli disponibili per il fine-tuning.

Ha il punto finale: /v1/completions

Utilizzo del modello GPT3 Davinci per la generazione di testo

Il primo compito è caricare la chiave API di OpenAI nella variabile di ambiente e importare le librerie necessarie.

# Importa le librerie necessarie

import openai

import os

import IPython

from dotenv import load_dotenv

load_dotenv()

# Configurazione API

openai.api_key = os.getenv("OPENAI_API_KEY")Ciò dimostra come generare testo utilizzando il modello GPT-3 di OpenAI, qui il modello davinci. Il prompt viene utilizzato come punto di partenza e il metodo ‘openai.Completion.create()’ viene utilizzato per effettuare una chiamata API a GPT-3 per la generazione di testo. Il testo generato viene quindi stampato nella console, consentendo agli utenti di vedere l’output del processo di generazione di testo.

# Definisci un prompt per la generazione di testo

prompt = "C'era una volta"

# Genera testo utilizzando GPT-3

response = openai.Completion.create(

engine='davinci',

prompt=prompt,

max_tokens=100 # Regola la lunghezza desiderata del testo generato

)

# Stampa il testo generato

print(response.choices[0].text.strip())Output

Ho lavorato come coordinatore dei servizi sanitari alle prese con l’incarico di creare un grafico del peso da distribuire ai nostri clienti. Aveva 7 categorie, oltre a un titolo. Questa è stata una sfida.

Necessità di altri LLM nonostante GPT3

Sebbene GPT-3 sia un modello di linguaggio potente e versatile, c’è ancora la necessità di altri LLM per complementare e migliorare le capacità di GPT-3. Ecco alcune ragioni per cui gli altri LLM sono importanti:

- GPT-3 è un modello di linguaggio ad uso generale, ma LLM specializzati possono fornire una migliore prestazione e precisione per casi d’uso specifici

- LLM più piccoli ed efficienti offrono un’alternativa conveniente ai costosi calcoli di GPT-3, rendendo la distribuzione più accessibile.

- LLM addestrati su insiemi di dati specifici o che incorporano conoscenze specifiche del dominio forniscono la comprensione contestuale e risultati più precisi in domini specializzati.

- La ricerca e lo sviluppo continuo nel campo degli LLM contribuiscono ai progressi nell’elaborazione del linguaggio naturale.

Sebbene GPT-3 sia un notevole modello di linguaggio, lo sviluppo e l’utilizzo di altri LLM sono necessari per soddisfare i domini specializzati, migliorare l’efficienza, incorporare conoscenze specifiche del dominio, affrontare le preoccupazioni etiche e guidare ulteriori ricerche e innovazioni nel campo dell’elaborazione del linguaggio naturale.

Sviluppi negli LLM oltre GPT-3

L’evoluzione degli LLM non si ferma a GPT-3. I ricercatori e gli sviluppatori lavorano continuamente sugli avanzamenti per affrontare le limitazioni e le sfide. Modelli recenti, come GPT-4, Megatron, StableLM, MPT e molti altri si basano sulle fondamenta gettate da GPT-3, mirando a migliorare le prestazioni, l’efficienza e la gestione di pregiudizi.

Per esempio,

- GPT-4 si concentra sulla riduzione dei requisiti di calcolo mantenendo o migliorando la qualità della generazione del linguaggio.

- Megatron enfatizza la formazione scalabile del modello, consentendo la formazione di LLM ancora più grandi in modo efficiente.

- StableLM affronta problemi di stabilità in modelli grandi, garantendo prestazioni coerenti e affidabili.

Questi LLM avanzati hanno dimostrato risultati promettenti. Ad esempio, Megatron ha ottenuto risultati di stato dell’arte in vari benchmark di NLP. StableLM ha affrontato problemi legati all’oblio catastrofico, consentendo l’apprendimento continuo in modelli di larga scala. Questi progressi aprono la strada a LLM più efficienti, capaci e affidabili che possono essere implementati in un’ampia gamma di applicazioni.

Sviluppi recenti di LLM nel 2023

Il problema con LLM per l’uso commerciale è che potrebbero non essere open source o vietati per l’uso. Di conseguenza, le aziende potrebbero non essere in grado di utilizzarli affatto o potrebbero dover pagare per farlo. Per motivi come la trasparenza e la flessibilità per modificare il codice, alcune aziende potrebbero preferire anche di utilizzare modelli open source.

Modelli di linguaggio open source disponibili commercialmente

Ci sono diversi modelli di linguaggio open source disponibili commercialmente.

- Pythia: contiene due set di otto modelli di dimensioni 70M, 160M, 410M, 1B, 1,4B, 2,8B, 6,9B e 12B. I checkpoint per ogni dimensione del modello sono disponibili in Hugging Face. Puoi anche controllare l’implementazione su GitHub.

- StableLM Alpha: StableLM-Tuned-Alpha è una raccolta di modelli di linguaggio decoder-only di 3B e 7B di parametro costruiti sopra i modelli StableLM-Base-Alpha e ulteriormente affinati su vari dataset di chat e di istruzioni. I checkpoint per entrambe le dimensioni del modello sono disponibili in Hugging Face. Puoi anche controllare l’implementazione su GitHub.

- H2oGPT: h2oGPT è un framework di fine-tuning per grandi modelli di linguaggio (LLM) e una UI chatbot con capacità di domanda-risposta di documenti. I documenti forniscono contesto rilevante per l’istruzione, che aiuta a fondare LLM contro le allucinazioni. Puoi controllare l’implementazione su GitHub.

- Dolly: Dolly-v2-12b, è un grande modello di linguaggio di seguito istruzioni addestrato sulla piattaforma di apprendimento automatico Databricks. Non è un modello di stato dell’arte, ma dimostra un comportamento di seguito istruzioni di alta qualità insolitamente elevato che non è tipico del modello di base su cui è costruito. Puoi controllare l’implementazione su GitHub.

- Bloom: BLOOM è un autoregressivo Large Language Model (LLM) addestrato su volumi massicci di dati di testo. Di conseguenza, può generare testo significativo in 46 lingue e 13 linguaggi di programmazione che sono quasi indistinguibili dal materiale scritto dall’uomo. Puoi controllare i checkpoint per Bloom su Hugging Face.

- Falcon: Falcon-40B è un modello solo-decoder causale con 40B di parametri. Ha superato LLaMA, StableLM, RedPajama, MPT e molti altri modelli. È un modello pre-addestrato, che dovrebbe essere ulteriormente affinato per la maggior parte dei casi d’uso. Puoi controllare il modello su Hugging Face.

Come utilizzare i pesi degli LLM da Hugging Face?

Useremo Falcon7b, un modello solo-decoder causale pre-addestrato, che richiede tipicamente ulteriore fine-tuning per la maggior parte dei casi d’uso. Tuttavia, per la generazione di testo, ha dimostrato prestazioni superiori rispetto a vari altri modelli.

Importa le librerie necessarie

!pip install transformers

!pip install torch

from transformers import AutoTokenizer, AutoModelForCausalLM

import transformers

import torchCarica il modello e il tokenizer

Il passo successivo è istanziare un oggetto AutoTokenizer e caricare il tokenizer e il modello per il modello Falcon pre-addestrato.

model = "tiiuae/falcon-7b-instruct"

tokenizer = AutoTokenizer.from_pretrained(model)Costruisci la pipeline del modello utilizzando la pipeline Hugging Face Transformers

Crea una pipeline di generazione di testo utilizzando la libreria Transformers. Specifica il compito come “generazione di testo” e richiede un modello e un tokenizer pre-addestrati. I calcoli sono configurati per utilizzare un tipo di dati a virgola mobile a 16 bit.

!pip install einops

!pip install accelerate

pipeline = transformers.pipeline(

"text-generation",

model=model,

tokenizer=tokenizer,

torch_dtype=torch.bfloat16,

trust_remote_code=True,

device_map="auto",

)Inferenza del modello

Il compito a portata di mano è utilizzare la pipeline creata per stampare il risultato. La variabile ‘prompt’ contiene il testo iniziale che serve come punto di partenza. Configuriamo la pipeline per generare un massimo di 200 token, abilitare il campionamento e considerare i primi 10 token probabili ad ogni passo.

prompt = "Scrivi una poesia riguardo Elon Musk che licenzia dipendenti di Twitter"

sequences = pipeline(

prompt,

max_length=200,

do_sample=True,

top_k=10,

num_return_sequences=1,

eos_token_id=tokenizer.eos_token_id,

)

for seq in sequences:

print(f"Risultato: {seq['generated_text']}")

Output

Possibilità future e considerazioni etiche

Il futuro dei LLM è promettente, con innumerevoli possibilità in attesa di essere esplorate. I progressi nei LLM hanno il potenziale per creare assistenti virtuali indistinguibili dagli esseri umani, rivoluzionando il servizio clienti e le interazioni uomo-computer. Capacità avanzate di comprensione e generazione del linguaggio possono portare a esperienze di realtà virtuale più fluide e immersive. I LLM possono anche svolgere un ruolo cruciale nel superare le barriere linguistiche e favorire la comunicazione globale.

Tuttavia, man mano che i LLM continuano a evolversi, le considerazioni etiche diventano fondamentali.

- La trasparenza, la responsabilità e le tecniche di mitigazione del bias sono cruciali per garantire lo sviluppo e l’uso responsabile dei LLM.

- Linee guida e regolamentazioni rigorose sono necessarie per affrontare questioni di disinformazione, privacy dei dati e potenziale uso improprio.

- Inoltre, la collaborazione tra ricercatori, sviluppatori e responsabili politici è essenziale per promuovere pratiche etiche e tutelare gli interessi degli individui e della società nel suo insieme.

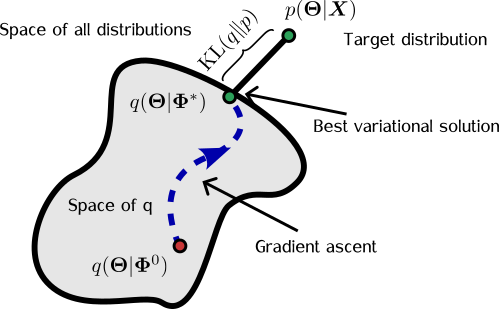

Fine-tuning LLM

Il processo di fine-tuning implica l’addestramento del LLM di base su dataset specifici del compito, dove il modello impara a generare risposte o output che si allineano alle istruzioni o alle linee guida desiderate. Questo processo di fine-tuning permette al modello di adattare le sue capacità di generazione del linguaggio per soddisfare i requisiti specifici del compito a portata di mano.

I LLM sintonizzati sulle istruzioni trovano utilità particolare in scenari che richiedono un elevato grado di controllo o aderenza a linee guida specifiche. Ad esempio, nelle applicazioni di chatbot, il fine-tuning dei LLM sintonizzati sulle istruzioni consente la generazione di risposte più appropriate dal punto di vista del contesto, specifiche del dominio o allineate con le linee guida desiderate della conversazione.

Attraverso il fine-tuning dei LLM di base con istruzioni specifiche del compito, gli sviluppatori possono creare un modello di linguaggio più specializzato e mirato. Questo processo migliora le prestazioni del modello e gli consente di generare output personalizzati che eccellono in applicazioni specifiche.

Esempi concreti di LLM evoluti

L’evoluzione dei LLM porta a una moltitudine di applicazioni reali con un impatto significativo.

- I LLM evoluti possono rivoluzionare i sistemi di supporto al cliente fornendo risposte personalizzate e consapevoli del contesto alle richieste degli utenti.

- Un ulteriore snellimento dei processi di creazione di contenuti consente una generazione di contenuti più rapida e coinvolgente su tutte le piattaforme.

- La traduzione del linguaggio può diventare più accurata e sfumata, facilitando la comunicazione interculturale.

Inoltre, i LLM evoluti hanno un potenziale nei settori della sanità, legale ed educativo.

- Nell’ambito sanitario, questi modelli possono assistere nella diagnosi medica, raccomandando trattamenti basati sui sintomi del paziente e sulle storie cliniche.

- Nel settore legale, i LLM possono aiutare nella ricerca legale, analizzando vasti quantitativi di documenti legali e fornendo informazioni per casi specifici.

- Nell’educazione, i LLM possono contribuire a esperienze di apprendimento personalizzate, offrendo contenuti didattici su misura agli studenti in base alle loro esigenze e stili di apprendimento specifici.

Conclusione

L’evoluzione dei LLM, dal GPT-3 alle future generazioni, segna una tappa significativa nel campo dell’elaborazione del linguaggio naturale. Questi modelli avanzati hanno il potenziale per rivoluzionare diverse industrie, razionalizzare i processi e migliorare le interazioni uomo-computer.

Tuttavia, gli sviluppi nei modelli di linguaggio presentano limitazioni, sfide e considerazioni etiche che richiedono attenzione. È cruciale sviluppare e mettere in campo in modo responsabile grandi modelli di linguaggio (LLM), supportati dalla ricerca e dalla collaborazione in corso. Questi sforzi daranno forma al futuro dei modelli di linguaggio, consentendoci di raccoglierne i vantaggi mitigando i potenziali rischi. Il viaggio dei LLM continua, con grandi promesse per l’avanzamento dell’AI e la trasformazione delle nostre interazioni con la tecnologia.

Punti chiave

- L’evoluzione dei LLM rappresenta una tappa significativa nell’elaborazione del linguaggio naturale, consentendo applicazioni rivoluzionarie e migliorando le interazioni uomo-computer.

- È importante riconoscere e affrontare le limitazioni e le sfide associate ai LLM, come il bias e le considerazioni etiche, per garantire uno sviluppo e una distribuzione responsabile.

- La ricerca continua, la collaborazione e l’uso responsabile dei LLM daranno forma al futuro dell’AI, sbloccando possibilità trasformative nella comprensione e interazione del linguaggio.

Domande frequenti

I media mostrati in questo articolo non sono di proprietà di Analytics Vidhya e sono utilizzati a discrezione dell’autore.