Efficienti modelli di lingua piccoli il parametro 1.3 miliardi di phi-1.5 di Microsoft

Efficient language models Microsoft's 1.3 billion parameter phi-1.5 small models.

Quando pensavi di aver sentito abbastanza notizie sui Large Language Model (LLM), Microsoft Research è tornata a disturbare nuovamente il mercato. Nel giugno 2023, Microsoft Research ha pubblicato un documento chiamato “Textbooks is All You Need,” in cui ha introdotto phi-1, un nuovo grande modello di linguaggio per il codice. phi-1 è un modello basato su trasformatori con 1,3 miliardi di parametri, che è stato allenato per 4 giorni su 8 GPU A100, utilizzando una selezione di dati di “qualità da manuale” dal web.

Sembra che i LLM stiano diventando sempre più piccoli.

- Ricercatori dell’Università di Tokyo presentano una nuova tecnica per proteggere le applicazioni sensibili basate sull’intelligenza artificiale AI dagli attacchi degli aggressori.

- Tracciamento degli esperimenti di Machine Learning utilizzando MLflow

- 3 modi in cui l’AI può aiutare le comunità ad adattarsi ai cambiamenti climatici in Africa

Cosa è phi-1.5?

Ora Microsoft Research ti presenta phi-1.5, un Transformer con 1,3 miliardi di parametri, che è stato allenato utilizzando le stesse fonti di dati di phi-1. Come già detto, phi-1 è stato allenato su dati di alta qualità da manuali, mentre phi-1.5 è stato allenato solo su dati sintetici. phi-1.5 ha utilizzato 32 GPU A100-40G ed è stato allenato con successo in 8 giorni. L’obiettivo di phi-1.5 era creare un modello open-source che possa svolgere un ruolo nella comunità della ricerca utilizzando un modello piccolo non limitato che ti permetta di esplorare le diverse sfide di sicurezza con i LLM, come la riduzione della tossicità, il miglioramento della controllabilità e altro ancora.

Utilizzando l’approccio “Generazione di Dati Sintetici”, le prestazioni di phi-1.5 sono equivalenti a modelli 5 volte più grandi nei test di linguaggio naturale e ha dimostrato di superare la maggior parte dei LLM in compiti di ragionamento più difficili.

Abbastanza impressionante vero?

Il percorso di apprendimento del modello è molto interessante. Ricava dati da diverse fonti, tra cui frammenti di codice Python da StackOverflow, manuali sintetici di Python e esercizi generati da GPT-3.5-turbo-0301.

Affrontare la tossicità e i pregiudizi

Una delle sfide principali con i LLM è la tossicità e il contenuto di pregiudizio. Microsoft Research ha cercato di superare questa sfida continua di contenuto dannoso/offensivo e contenuto che promuove una specifica ideologia.

I dati sintetici utilizzati per allenare il modello generavano risposte con una minore propensione a generare contenuti tossici rispetto ad altri LLM come Falcon-7B e Llama 2-7B, come mostrato nell’immagine seguente:

Benchmarks

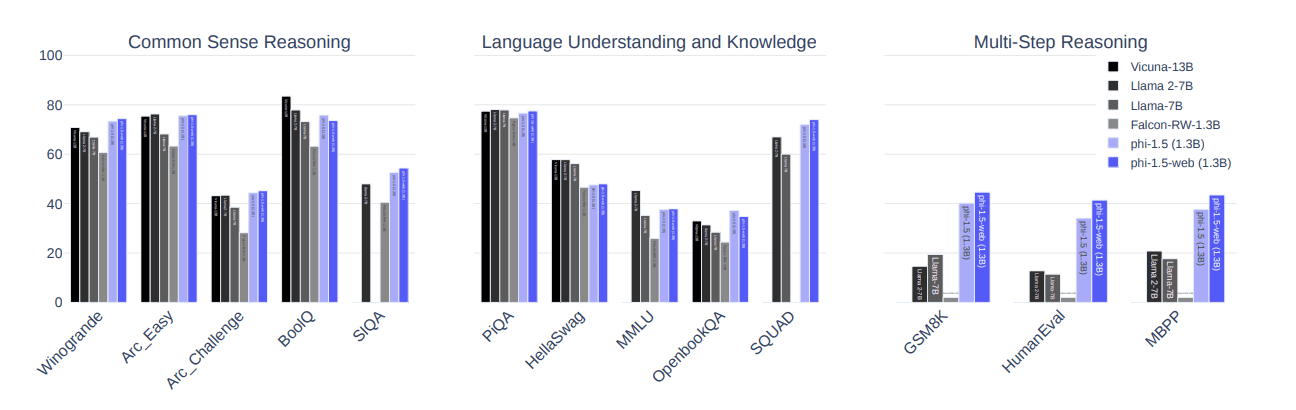

L’immagine seguente mostra come phi-1.5 si sia comportato leggermente meglio rispetto a modelli all’avanguardia, come Llama 2-7B, Llama-7B e Falcon-RW-1.3B) su 3 benchmark: ragionamento di senso comune, competenze linguistiche e ragionamento a più passi.

Come è stato fatto ciò?

L’uso di dati simili a quelli dei manuali ha differenziato l’uso di tali dati nei LLM rispetto ai dati estratti da internet. Per valutare ulteriormente come il modello gestisce i contenuti tossici, è stato utilizzato ToxiGen e sono stati progettati e etichettati manualmente 86 prompt come “pass”, “fail” o “non compreso” per avere una migliore comprensione delle limitazioni del modello.

Detto ciò, phi-1.5 ha superato 47 prompt, ha fallito 34 prompt e non ha compreso 4 prompt. L’approccio di HumanEval per valutare i modelli genera risposte che mostrano che phi-1.5 ha ottenuto punteggi più alti rispetto ad altri modelli ben noti.

Punti chiave da ricordare:

Ecco i principali punti di discussione che dovresti ricordare riguardo a phi-1.5:

- È un modello basato su trasformatori

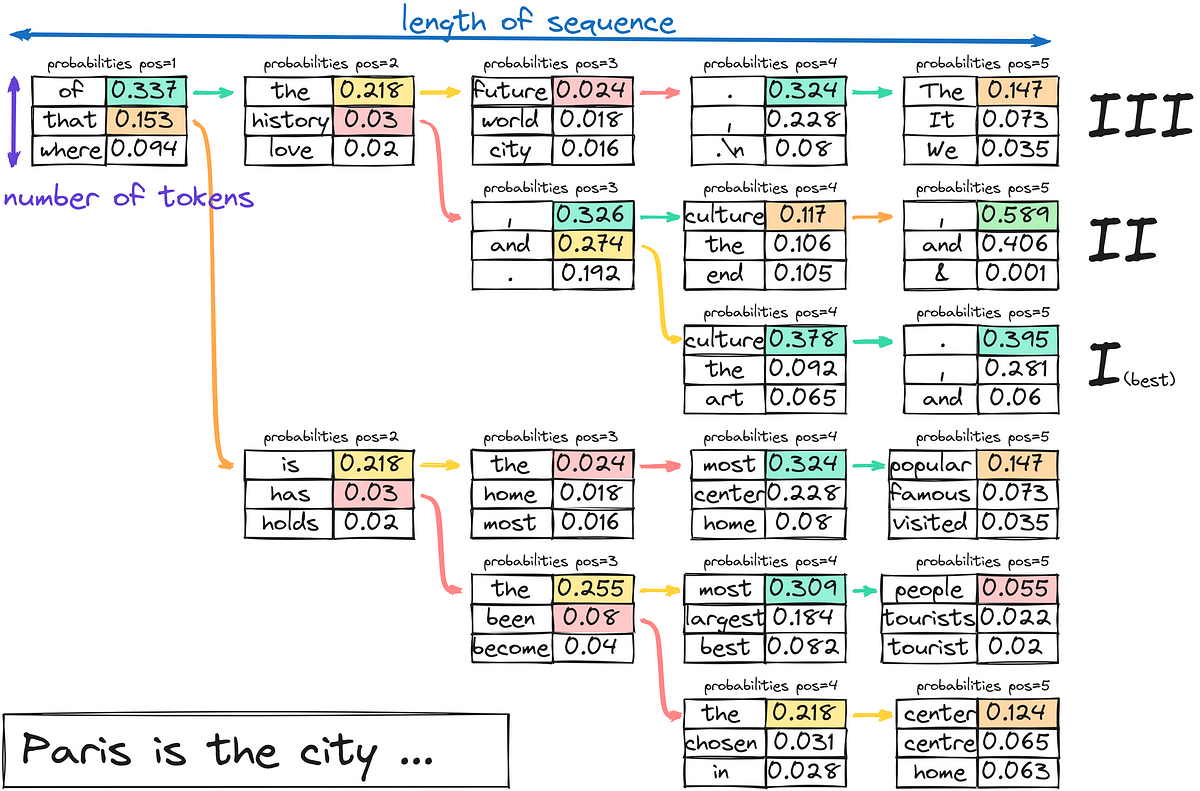

- È un LLM che si concentra sugli obiettivi di previsione della parola successiva

- È stato allenato su 30 miliardi di token

- Ha utilizzato 32 GPU A100-40G

- È stato allenato con successo in 8 giorni

Nisha Arya è una Data Scientist, Scrittrice Tecnica Freelance e Community Manager presso VoAGI. È particolarmente interessata a fornire consigli sulla carriera in Data Science o tutorial e conoscenze teoriche su Data Science. Desidera anche esplorare i diversi modi in cui l’Intelligenza Artificiale può beneficiare della longevità della vita umana. Un’apprendista appassionata, alla ricerca di ampliare le sue conoscenze tecniche e le sue competenze di scrittura, aiutando nel frattempo a guidare gli altri.