Avremo presto il nostro personale AI Movie Buddy?

Avremo presto il nostro AI Movie Buddy?

Video-LLaMA 🦙 spiegato nel paper.

Se stiamo chattando durante o dopo un film, sappiamo entrambi che ci piace parlare dei film che amiamo. Ma quanto siamo lontani dal farlo con l’intelligenza artificiale? Sfruttando potenti LLM come LLaMA [1], Video-LLaMA [2] ci sta avvicinando un passo alla realtà di parlare dei contenuti video. Alla fine di questo post del blog, saprai come Video-LLaMA gestisce il contenuto visivo e uditivo dei video e quali trucchi gli autori hanno usato per addestrare il modello. Ma imparerai anche le sfide nel trattare i dati video.

Risultati

Quindi, cosa riesce a fare nello specifico Video-LLaMA?

![Fonte: [2]](https://miro.medium.com/v2/resize:fit:640/1*BINhs5KEPcs6-WmdU9jP3g.gif)

Riesce con successo a permetterti di inserire un video e non solo chiedere del suo contenuto visivo ma anche di ciò che il modello può udire nel video!

- Tutto ciò di cui hai bisogno per diventare un Data Scientist certificato SAS

- Semplifica la condivisione dei file

- Padroneggiare l’arte del fine-tuning dei prompt per l’IA generativa liberare tutto il potenziale

![Fonte: [2]](https://miro.medium.com/v2/resize:fit:640/format:webp/1*2OtwjkFhqKYl0bbaE2q7fQ.png)

Grazie alla sua architettura, il modello può anche gestire immagini statiche, ad esempio descrivendole in modo dettagliato o comprendendo il concetto di “insolito” e descrivendo ciò che specificamente è insolito nella scena corrispondente. Questa capacità viene notevolmente potenziata dalle già esistenti capacità di ragionamento dei moderni LLM utilizzati, come LLaMA.

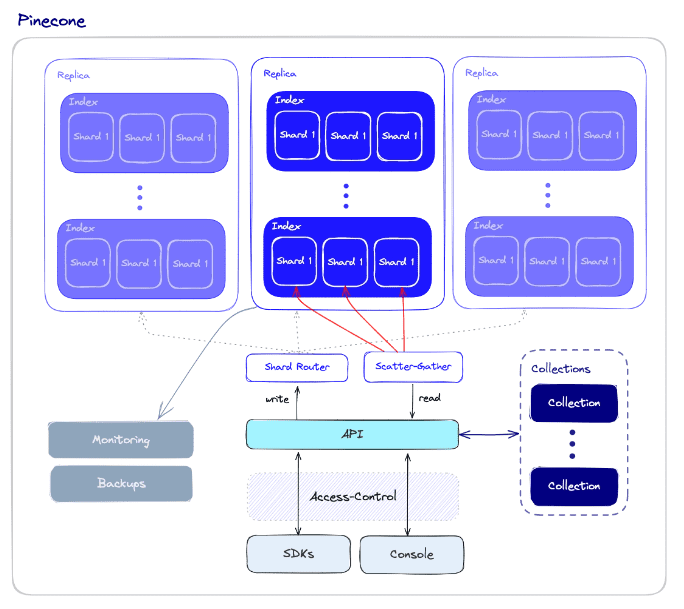

Architettura

La descrizione delle immagini, o più in generale, i modelli Immagine-testo come Flamingo [3], LLaVa [4], BLIP2 [5], Kosmos-1 [6] e -2 [7], utilizzano tutti generalmente un codificatore di visione come un ViT per incorporare un’immagine singola in una sequenza di embedding e quindi cercano di allineare questi con un LLM. Ma con i video, non abbiamo un’unica immagine ma una sequenza di immagini e abbiamo una sequenza audio corrispondente. Quindi, come possiamo incorporare un intero video? Beh, onestamente, più o meno allo stesso modo.

![Architettura complessiva di Video-LLaMA. Fonte: [2]](https://miro.medium.com/v2/resize:fit:640/format:webp/1*ANl5_qohxSdIOg21ooHEeg.png)