Il potenziale creativo dei flussi di normalizzazione nell’IA generativa

Potenziale creativo dei flussi di normalizzazione nell'IA generativa

Introduzione

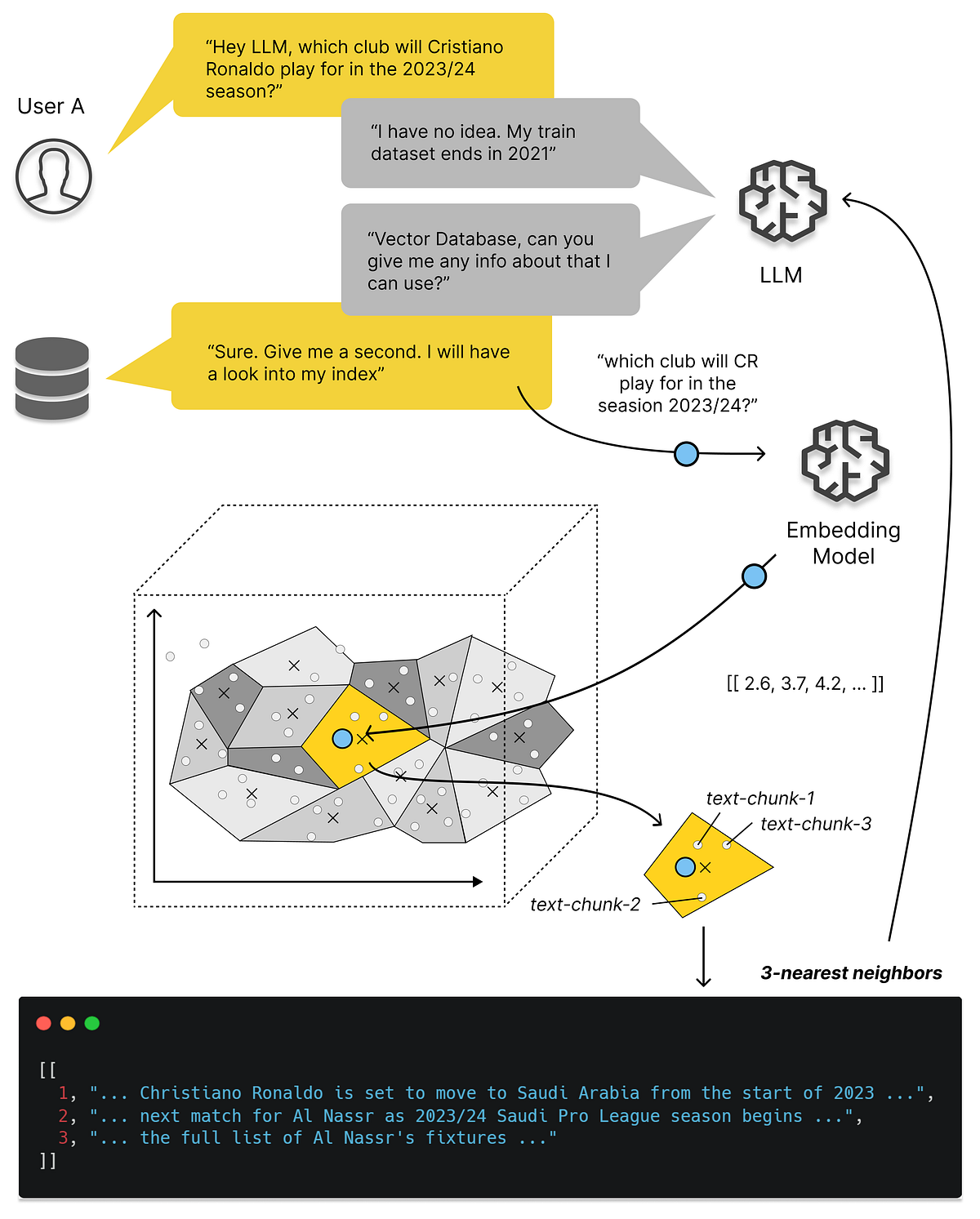

L’IA generativa, con la sua notevole capacità di creare dati che assomigliano da vicino agli esempi del mondo reale, ha attirato molta attenzione negli ultimi anni. Mentre modelli come GAN e VAE hanno rubato la scena, una gemma meno conosciuta chiamata “Normalizing Flows” nell’IA generativa ha silenziosamente ridisegnato il panorama della modellazione generativa.

In questo articolo, intraprendiamo un viaggio nel mondo delle Normalizing Flows, esplorando le loro caratteristiche uniche e le applicazioni e fornendo esempi pratici in Python per svelarne il funzionamento interno. In questo articolo, impareremo:

- Comprensione di base delle Normalizing Flows.

- Applicazioni delle Normalizing Flows, come stima di densità, generazione di dati, inferenza variazionale e aumento dei dati.

- Esempio di codice Python per comprendere le Normalizing Flows.

- Comprensione della classe di trasformazione affine.

Questo articolo è stato pubblicato come parte del Data Science Blogathon.

- Top 10 Automazioni di Intelligenza Artificiale per Aumentare la Produttività

- Best First Search in Artificial Intelligence’ ‘La ricerca Best First nell’Intelligenza Artificiale

- Cosa succederà nella progettazione delle proteine? I ricercatori di Microsoft introducono EvoDiff un rivoluzionario framework di intelligenza artificiale per l’ingegneria delle proteine basata sulla sequenza.

Svelare le Normalizing Flows

Le Normalizing Flows, spesso abbreviate come NF, sono modelli generativi che affrontano la sfida di campionare da distribuzioni di probabilità complesse. Sono radicate nel concetto di cambiamento di variabili della teoria delle probabilità. L’idea fondamentale è partire da una distribuzione di probabilità semplice, come una gaussiana, e applicare una serie di trasformazioni invertibili per trasformarla gradualmente nella distribuzione complessa desiderata.

La caratteristica distintiva delle Normalizing Flows è la loro invertibilità. Ogni trasformazione applicata ai dati può essere invertita, garantendo che sia possibile sia il campionamento che la stima di densità. Questa proprietà li distingue da molti altri modelli generativi.

Anatomia di una Normalizing Flow

- Distribuzione di base: Una distribuzione di probabilità semplice (ad esempio, gaussiana) da cui inizia il campionamento.

- Trasformazioni: Una serie di trasformazioni biunivoche (invertibili) che modificano progressivamente la distribuzione di base.

- Trasformazioni inverse: Ogni trasformazione ha un’inversa, consentendo la generazione di dati e la stima della verosimiglianza.

- Distribuzione complessa finale: La composizione delle trasformazioni porta a una distribuzione complessa che si avvicina molto alla distribuzione dei dati target.

Applicazioni delle Normalizing Flows

- Stima di densità: le Normalizing Flows eccellono nella stima di densità. Possono modellare accuratamente distribuzioni di dati complesse, rendendole preziose per la rilevazione di anomalie e la stima dell’incertezza.

- Generazione di dati: le NF possono generare campioni di dati che assomigliano da vicino ai dati reali. Questa capacità è cruciale in applicazioni come la generazione di immagini, la generazione di testo e la composizione musicale.

- Inferenza variazionale: le Normalizing Flows svolgono un ruolo vitale nell’apprendimento automatico bayesiano, in particolare negli autoencoder variazionali (VAE). Consentono approssimazioni posteriori più flessibili ed espressive.

- Aumento dei dati: le NF possono aumentare i set di dati generando campioni sintetici, utili quando i dati sono scarsi.

Approfondiamo in Python: Implementazione di una Normalizing Flow

Implementiamo una semplice Normalizing Flow 1D utilizzando Python e la libreria PyTorch. In questo esempio, ci concentreremo sulla trasformazione di una distribuzione gaussiana in una distribuzione più complessa.

import torch

import torch.nn as nn

import torch.optim as optim

# Definisci una trasformazione biunivoca

class AffineTransformation(nn.Module):

def __init__(self):

super(AffineTransformation, self).__init__()

self.scale = nn.Parameter(torch.Tensor(1))

self.shift = nn.Parameter(torch.Tensor(1))

def forward(self, x):

return self.scale * x + self.shift, torch.log(self.scale)

# Crea una sequenza di trasformazioni

transformations = [AffineTransformation() for _ in range(5)]

flow = nn.Sequential(*transformations)

# Definisci la distribuzione di base (gaussiana)

base_distribution = torch.distributions.Normal(0, 1)

# Campiona dalla distribuzione complessa

samples = flow(base_distribution.sample((1000,))).squeeze()

Librerie Utilizzate

- torch: Questa libreria è PyTorch, un popolare framework di deep-learning. Fornisce strumenti e moduli per la creazione e l’addestramento di reti neurali. Nel codice, la utilizziamo per definire moduli di reti neurali, creare tensori e svolgere efficientemente varie operazioni matematiche sui tensori.

- torch.nn: Questo sottomodulo di PyTorch contiene classi e funzioni per la costruzione di reti neurali. Nel codice, lo utilizziamo per definire la classe nn.Module che funge da classe base per i moduli di reti neurali personalizzati.

- torch.optim: Questo sottomodulo di PyTorch fornisce algoritmi di ottimizzazione comunemente utilizzati per l’addestramento di reti neurali. Nel codice, viene utilizzato per definire un ottimizzatore per l’addestramento dei parametri del modulo AffineTransformation. Tuttavia, il codice fornito non include esplicitamente la configurazione dell’ottimizzatore.

Classe AffineTransformation

La classe AffineTransformation è un modulo personalizzato di PyTorch che rappresenta un passo nella sequenza di trasformazioni utilizzate in un Normalizing Flow. Vediamo le sue componenti:

- nn.Module: Questa classe è la classe base per tutti i moduli personalizzati di reti neurali in PyTorch. Ereditando da nn.Module, AffineTransformation diventa a sua volta un modulo PyTorch e può contenere parametri apprendibili (come self.scale e self.shift) e definire un’operazione di passaggio in avanti (forward pass).

- __init__(self): Il metodo costruttore della classe. Quando viene creato un’istanza di AffineTransformation, inizializza due parametri apprendibili: self.scale e self.shift. Questi parametri saranno ottimizzati durante l’addestramento.

- self.scale e self.shift: Questi sono oggetti nn.Parameter di PyTorch. I parametri sono tensori tracciati automaticamente dal sistema di autograd di PyTorch, rendendoli adatti all’ottimizzazione. Qui, self.scale e self.shift rappresentano i fattori di scala e di spostamento applicati all’input x.

- forward(self, x): Questo metodo definisce il passaggio in avanti del modulo. Quando si passa un tensore di input x a un’istanza di AffineTransformation, calcola la trasformazione utilizzando l’operazione affine self.scale * x + self.shift. Inoltre, restituisce il logaritmo di self.scale. Il logaritmo viene utilizzato perché assicura che self.scale rimanga positivo, il che è importante per l’invertibilità nei Normalizing Flows.

In un Normalizing Flow in un contesto di Intelligenza Artificiale Generativa, questa classe AffineTransformation rappresenta una semplice trasformazione invertibile applicata ai dati. Ogni passo nel flusso consiste in tali trasformazioni, che ridisegnano collettivamente la distribuzione di probabilità da una semplice (ad esempio, Gaussiana) a una più complessa che si avvicina alla distribuzione target dei dati. Queste trasformazioni, quando composte, consentono una stima flessibile della densità e la generazione di dati.

# Crea una sequenza di trasformazioni

transformations = [AffineTransformation() for _ in range(5)]

flow = nn.Sequential(*transformations)Nella sezione di codice sopra, stiamo creando una sequenza di trasformazioni utilizzando la classe AffineTransformation. Questa sequenza rappresenta la serie di trasformazioni invertibili che verranno applicate alla nostra distribuzione di base per renderla più complessa.

Cosa Sta Accadendo?

Ecco cosa sta accadendo:

- Stiamo inizializzando una lista vuota chiamata transformations.

- Utilizziamo una list comprehension per creare una sequenza di istanze di AffineTransformation. La costruzione [AffineTransformation() for _ in range(5)] crea una lista contenente cinque istanze della classe AffineTransformation. Applichiamo queste trasformazioni in sequenza ai nostri dati.

# Definisci la distribuzione di base (Gaussiana)

base_distribution = torch.distributions.Normal(0, 1)Qui, stiamo definendo una distribuzione di base come punto di partenza. In questo caso, stiamo utilizzando una distribuzione Gaussiana con media 0 e deviazione standard 1 (ossia, una distribuzione normale standard). Questa distribuzione rappresenta la semplice distribuzione di probabilità da cui inizieremo la nostra sequenza di trasformazioni.

# Esegui un campionamento dalla distribuzione complessa

samples = flow(base_distribution.sample((1000,))).squeeze()Questa sezione riguarda il campionamento dei dati dalla distribuzione complessa che deriva dall’applicazione della nostra sequenza di trasformazioni alla distribuzione di base. Ecco la spiegazione dettagliata:

- base_distribution.sample((1000,)): Utilizziamo il metodo sample dell’oggetto base_distribution per generare 1000 campioni dalla distribuzione di base. La sequenza di trasformazioni trasformerà questi campioni per creare dati complessi.

- flow(…): L’oggetto flow rappresenta la sequenza di trasformazioni che abbiamo creato in precedenza. Applichiamo queste trasformazioni in sequenza passando i campioni dalla distribuzione di base attraverso il flusso.

- squeeze(): Ciò rimuove eventuali dimensioni superflue dai campioni generati. Spesso viene utilizzato quando si lavora con tensori PyTorch per assicurarsi che la forma corrisponda al formato desiderato.

Conclusione

Le Normalizing Flows (NF) sono modelli generativi che modellano distribuzioni di dati complesse trasformando progressivamente una semplice distribuzione di base attraverso una serie di operazioni invertibili. L’articolo esplora i componenti principali delle NF, tra cui le distribuzioni di base, le trasformazioni biunivoche e l’invertibilità che ne sottende il potere. Sottolinea il loro ruolo fondamentale nella stima della densità, nella generazione dei dati, nell’inferenza variazionale e nell’aumento dei dati.

Punti chiave

I punti chiave dell’articolo sono:

- I Normalizing Flows sono modelli generativi che trasformano una semplice distribuzione di base in una complessa distribuzione target tramite una serie di trasformazioni invertibili.

- Trovano applicazione nella stima della densità, nella generazione dei dati, nell’inferenza variazionale e nell’aumento dei dati.

- I Normalizing Flows offrono flessibilità e interpretabilità, rendendoli un potente strumento per catturare distribuzioni di dati complesse.

- Implementare un Normalizing Flow comporta la definizione di trasformazioni biunivoche e la loro composizione sequenziale.

- Esplorare i Normalizing Flows svela un approccio versatile alla modellazione generativa, offrendo nuove possibilità per la creatività e la comprensione delle distribuzioni di dati complesse.

Domande frequenti

I media mostrati in questo articolo non sono di proprietà di Analytics Vidhya e vengono utilizzati a discrezione dell’autore.