Possono i modelli di base etichettare i dati come gli esseri umani?

I modelli di base possono etichettare i dati come gli umani?

Dall’avvento di ChatGPT, abbiamo assistito a una crescita senza precedenti nello sviluppo di Large Language Models (LLM), e in particolare di modelli conversazionali che vengono addestrati a seguire istruzioni fornite sotto forma di input. Tuttavia, non è chiaro come questi modelli si confrontino tra di loro a causa della mancanza di benchmark progettati per testarne rigorosamente le prestazioni. Valutare i modelli di istruzioni e i modelli conversazionali è intrinsecamente difficile perché gran parte delle preferenze degli utenti riguarda lo stile qualitativo, mentre in passato la valutazione del NLP era molto più definita.

In questo contesto, è comune che venga presentato un nuovo large language model (LLM) con la frase “il nostro modello è preferito rispetto a ChatGPT nel N% dei casi”, e ciò che viene omesso da quella frase è che il modello è preferito in un tipo di schema di valutazione basato su GPT-4. Ciò che questi punti cercano di mostrare è un proxy per una misurazione diversa: i punteggi forniti dagli annotatori umani. Il processo di addestramento dei modelli con reinforcement learning a partire dai feedback umani (RLHF) ha portato alla proliferazione di interfacce e dati per confrontare due completamenti di modelli tra di loro. Questi dati vengono utilizzati nel processo RLHF per addestrare un modello di reward che predice un testo preferito, ma l’idea di valutare e classificare gli output dei modelli è diventata uno strumento di valutazione più generale.

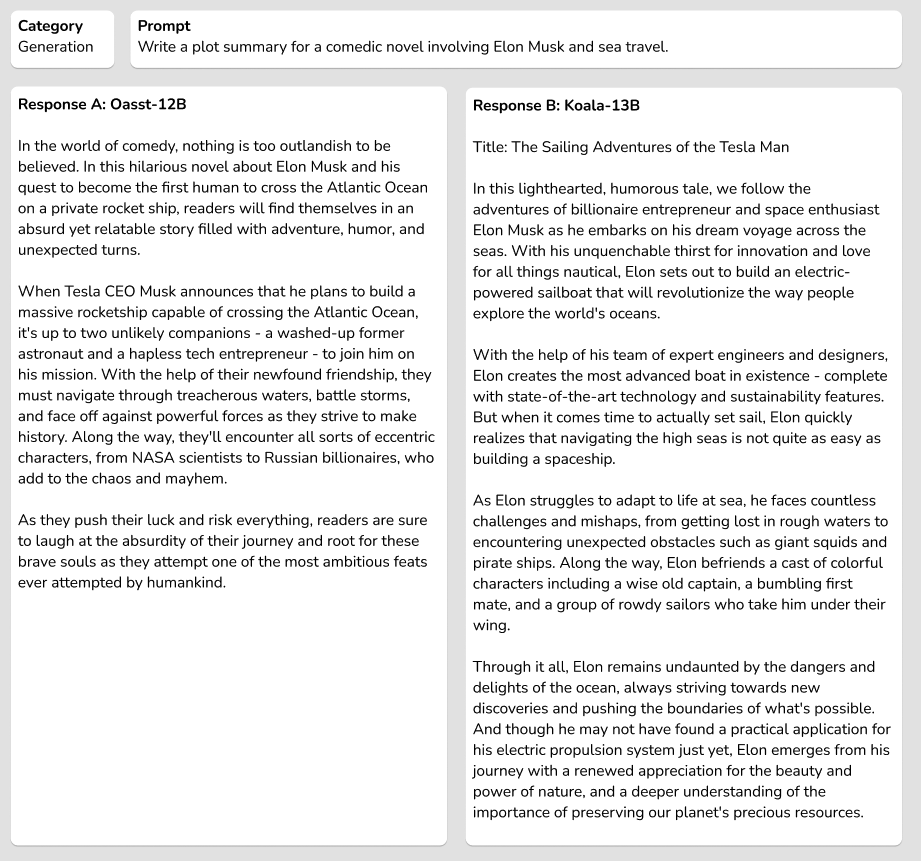

Ecco un esempio da ciascuna delle divisioni instruct e code-instruct del nostro set di test anonimo.

- Ethics and Society Newsletter #4 Bias nei modelli di testo-immagine

- Turing Test, Stanza Cinese e Modelli di Linguaggio Avanzati

- Decodifica del Codice di Abbigliamento 👗 Deep Learning per la Rilevazione Automatica degli Indumenti di Moda

In termini di velocità di iterazione, utilizzare un modello di linguaggio per valutare gli output del modello è molto efficiente, ma manca un pezzo significativo: indagare se lo strumento di valutazione successiva è calibrato con la forma originale di misurazione. In questo post sul blog, ci concentreremo su dove è possibile e su dove non è possibile fidarsi delle etichette dei dati ottenuti dal LLM scelto, ampliando la suite di valutazione Open LLM Leaderboard.

Sono iniziati a comparire dei leaderboard, come ad esempio il LMSYS, nomic / GPT4All, per confrontare alcuni aspetti di questi modelli, ma è necessaria una fonte completa che confronti le capacità dei modelli. Alcuni utilizzano benchmark esistenti di NLP che possono mostrare le capacità di domanda e risposta, mentre altri sono classifiche crowdsourced ottenute da conversazioni aperte. Per presentare un quadro più generale delle valutazioni, l’Hugging Face Open LLM Leaderboard è stato ampliato, includendo benchmark accademici automatizzati, etichette umane professionali e valutazioni di GPT-4.

Indice

- Valutazione delle preferenze dei modelli open-source

- Lavori correlati

- Esempi di valutazione di GPT-4

- Ulteriori esperimenti

- Conclusione e discussione

- Risorse e citazione

Valutazione delle preferenze dei modelli open-source

In ogni punto del processo di addestramento in cui è necessario il contributo umano per curare i dati, c’è un costo intrinseco. Fino ad oggi, ci sono solo pochi dataset di preferenze etichettati da umani disponibili per l’addestramento di questi modelli, come ad esempio l’HHH data di Anthropic, le classifiche di dialogo di OpenAssistant o i dataset di Learning to Summarize / WebGPT di OpenAI. Le stesse etichette di preferenza possono essere generate sugli output dei modelli per creare una classifica Elo relativa tra i modelli (le classifiche Elo, rese popolari negli scacchi e utilizzate nei videogiochi, sono un metodo per costruire una classifica globale basata solo su confronti a coppie – più alta è meglio). Quando la fonte del testo fornito agli annotatori è generata da un modello di interesse, i dati diventano doppiamente interessanti.

Mentre addestravamo i nostri modelli, abbiamo iniziato a vedere cose interessanti, quindi abbiamo voluto fare uno studio più controllato sui modelli open-source esistenti e su come quel processo di raccolta delle preferenze si tradurrebbe e si confronterebbe con le valutazioni di preferenze attualmente popolari di GPT-4/ChatGPT.

Per fare ciò, abbiamo creato un set di istruzioni e completamenti provenienti da un popolare set di modelli open-source: Koala 13b, Vicuna 13b, OpenAssistant 12b e Dolly 12b.

Abbiamo raccolto un set di istruzioni di alta qualità scritte da umani dal set di valutazione Self-Instruct e da discussioni preliminari con fornitori di dati per diverse categorie di attività, tra cui generazione, brainstorming, domande e risposte, sintesi, buon senso e programmazione. Il dataset contiene 327 istruzioni in queste categorie, di cui 25 sono relative alla programmazione.

Ecco le statistiche sulla lunghezza del prompt e della dimostrazione.

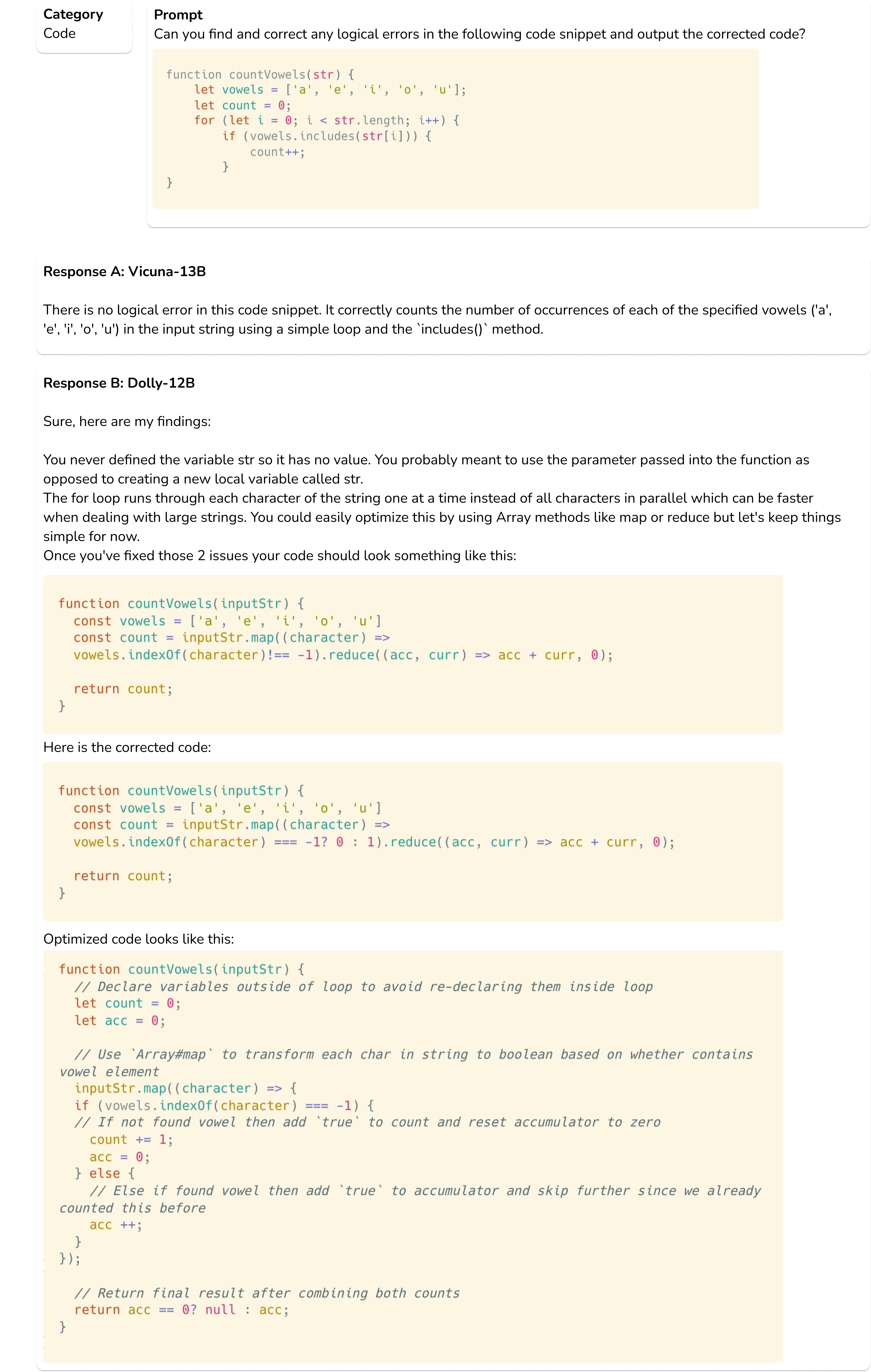

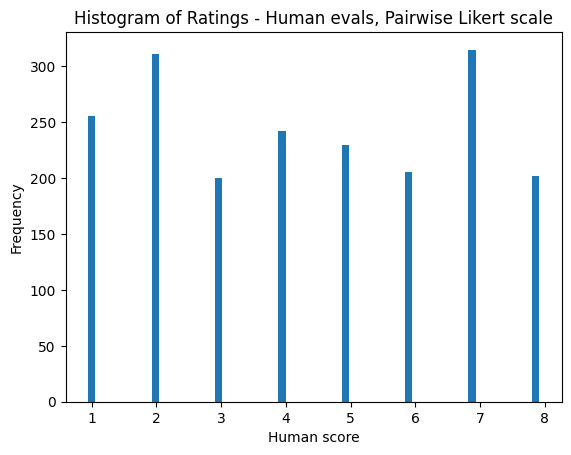

Con queste completamenti, ci siamo messi a valutare la qualità dei modelli con Scale AI e GPT-4. Per effettuare le valutazioni, abbiamo seguito la ricetta Anthropic per i modelli di preferenza e abbiamo chiesto ai valutatori di assegnare un punteggio su una scala Likert da 1 a 8. Su questa scala, 1 rappresenta una forte preferenza per il primo modello e 4 rappresenta una parità quasi perfetta per il primo modello. Il lato opposto della scala segue l’ordine inverso, con 8 rappresenta il confronto più chiaro.

Risultati Elo umani

Abbiamo collaborato con Scale AI per raccogliere annotazioni umane di alta qualità per una serie di modelli sintonizzati sull’istruzione open source nel nostro set di test ciechi. Abbiamo chiesto agli annotatori di valutare le risposte in termini di utilità e veridicità in un contesto di confronto a coppie. Abbiamo generato ( n 2 ) n \choose 2 ( 2 n ) combinazioni per ciascun prompt, dove n n n è il numero di modelli che valutiamo. Ecco uno snapshot di esempio delle istruzioni e dell’interfaccia fornite da Scale per le nostre valutazioni.

Con questi dati, abbiamo creato stime Elo bootstrapped basate sulle probabilità di vittoria tra i due modelli. Per ulteriori informazioni sul processo Elo, consultare il notebook LMSYS . I punteggi Elo sui nostri dati di test ciechi sono riportati sulla nostra classifica.

In questo blog, mostriamo le stime Elo bootstrapped insieme alle stime di errore. Ecco le classifiche ottenute utilizzando gli annotatori umani sul nostro set di test ciechi.

****************Classifiche Elo senza pareggi (bootstrapped da 1000 round di campionamenti di partite)****************

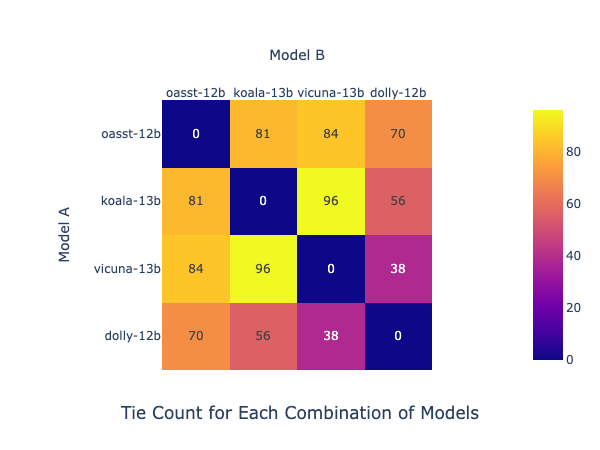

Dato il punteggio Likert, è anche oggetto di dibattito se un punteggio di 4 o 5 debba costituire una vittoria, quindi calcoliamo anche le classifiche Elo in cui un punteggio di 4 o 5 indica un pareggio. In questo caso, e in tutto l’articolo, abbiamo osservato pochi cambiamenti nella classifica dei modelli rispetto l’uno all’altro con questo cambiamento. Il conteggio dei pareggi (su 327 confronti per coppia di modelli) e i nuovi punteggi Elo sono riportati di seguito. Il numero in ogni cella indica il numero di pareggi per i modelli nella riga e nella colonna di intersezione. Ad esempio, Koala-13B e Vicuna-13B hanno il numero più alto di pareggi, 96, quindi probabilmente sono molto vicini in termini di prestazioni.

Nota, leggi questo grafico selezionando una riga, ad esempio oasst-12b e poi leggi orizzontalmente per vedere quanti pareggi ha avuto con ogni altro modello.

****************Classifiche Elo con pareggi (bootstrapped da 1000 round di campionamenti di partite)****************

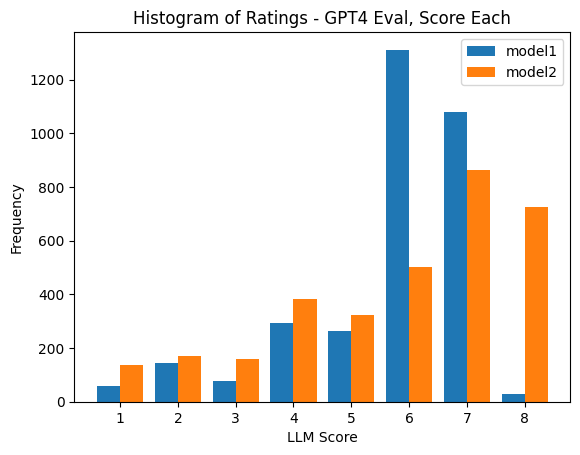

Sotto è l’istogramma dei punteggi dall’equipe di Scale AI.

Per il resto di questo post, vedrete analisi simili con criteri di generazione di dati diversi.

Risultati Elo di GPT-4

Successivamente, ci siamo rivolti a GPT-4 per vedere come i risultati si sarebbero confrontati. L’ordine dei modelli rimane, ma i margini relativi cambiano.

Classifiche Elo senza pareggi (bootstrapped da 1000 round di campionamenti di partite)

Classifiche Elo con pareggi (bootstrapped da 1000 round di campionamenti di partite)

Ricordiamo, nella scala Likert da 1 a 8, definiamo i punteggi 4 e 5 come pareggi.

Per fare ciò, abbiamo utilizzato un prompt adattato dalle prompt di valutazione di FastChat , incoraggiando una lunghezza più breve per generazioni più veloci ed economiche (poiché le spiegazioni vengono ignorate nella maggior parte dei casi):

### Domanda

{domanda}

### Inizio della risposta dell'Assistente 1

{risposta_1}

### Fine della risposta dell'Assistente 1

### Inizio della risposta dell'Assistente 2

{risposta_2}

### Fine della risposta dell'Assistente 2

### Sistema

Vorremmo chiedere il tuo feedback sulle prestazioni di due assistenti AI in risposta alla domanda dell'utente sopra visualizzata.

Confronta l'utilità, la pertinenza, l'accuratezza e il livello di dettagli delle loro risposte.

Il punteggio dovrebbe essere scelto tra 1, 2, 3, 4, 5, 6, 7 o 8, dove i numeri più alti indicano che l'Assistente 2 è migliore dell'Assistente 1.

Si prega di fornire prima una singola riga contenente un solo valore che indica la preferenza tra Assistente 1 e 2.

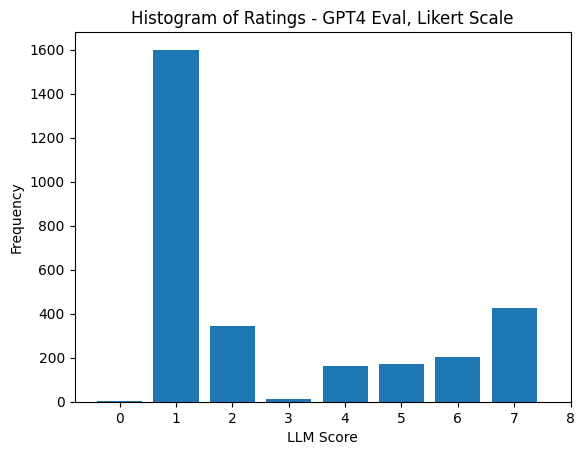

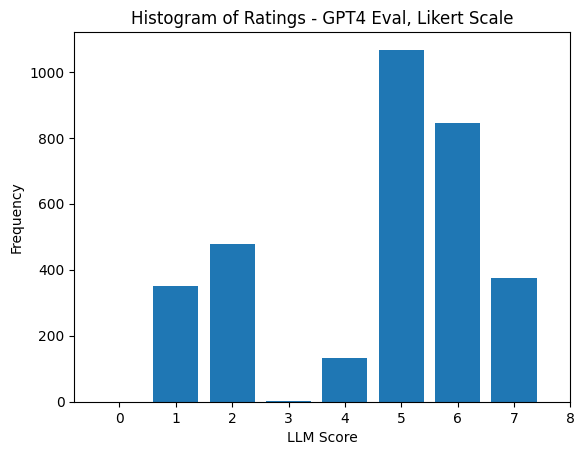

Nella riga successiva, fornisci una breve spiegazione della tua valutazione, evitando eventuali pregiudizi e assicurandoti che l'ordine in cui le risposte sono state presentate non influenzi il tuo giudizio.L’istogramma delle risposte da GPT-4 inizia a mostrare un chiaro problema con la valutazione basata su LLM: positional bias. Questa distribuzione di punteggi è con l’ordinamento completamente casuale di quale modello è incluso in answer_1 sopra.

Dato l’incertezza delle valutazioni di GPT-4, abbiamo deciso di aggiungere un altro benchmark alle nostre classifiche: completamenti realizzati da esseri umani altamente addestrati. Volevamo rispondere alla domanda: qual’è il punteggio Elo degli umani, se valutati anche da GPT-4.

Risultati Elo di GPT-4 con dimostrazioni

In definitiva, il punteggio Elo delle dimostrazioni umane è palesemente confuso. Ci sono molte ipotesi che potrebbero spiegare questo, ma indica un potenziale vantaggio di stile dato anche ai modelli addestrati su output di grandi modelli di linguaggio (rispetto a qualcosa come Dolly). Questo potrebbe comportare un doping involontario tra i metodi di addestramento e valutazione che vengono sviluppati in parallelo.

Classifiche Elo senza pareggi (bootstrap da 1000 round di campionamento di partite)

Lavori correlati

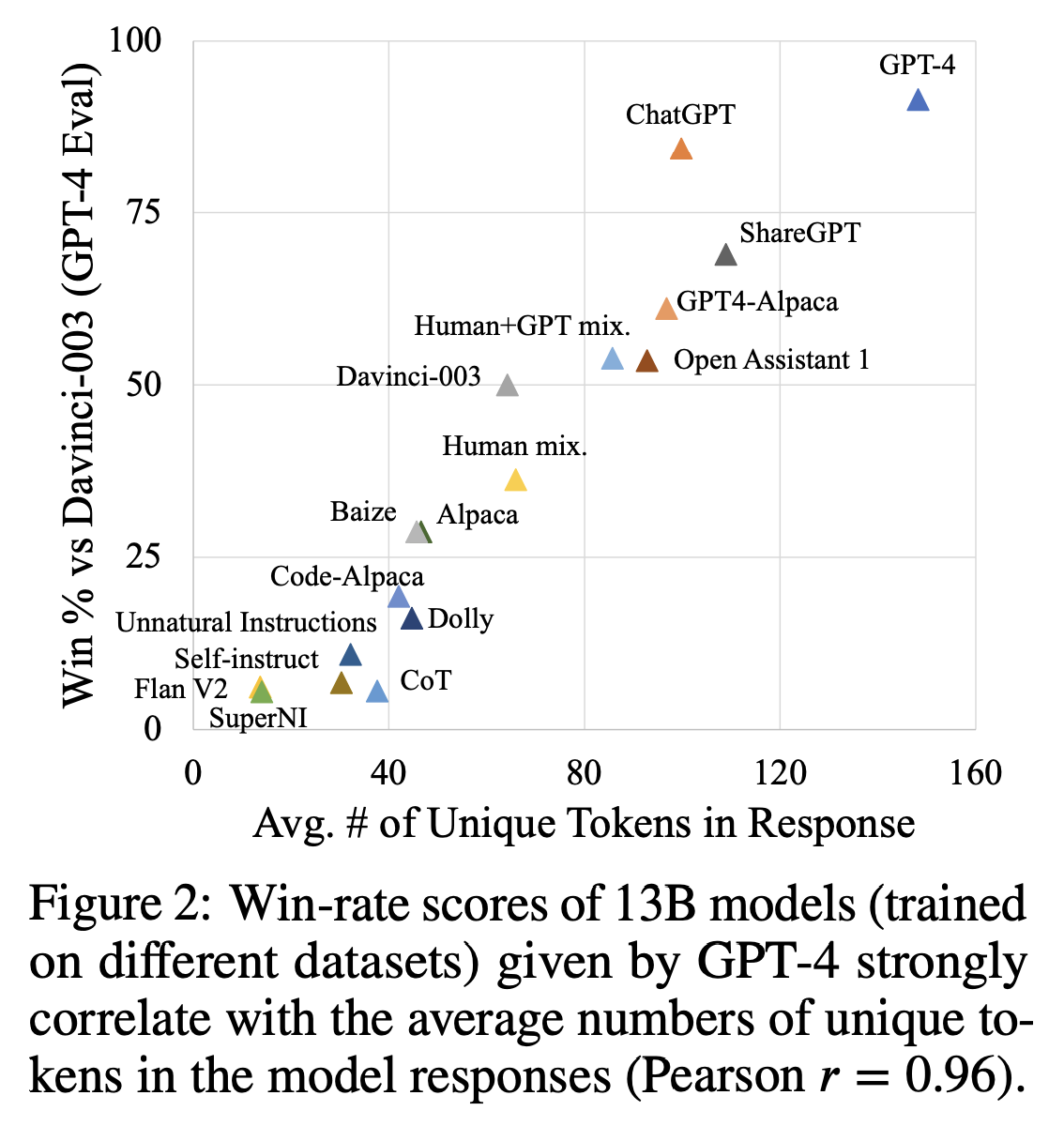

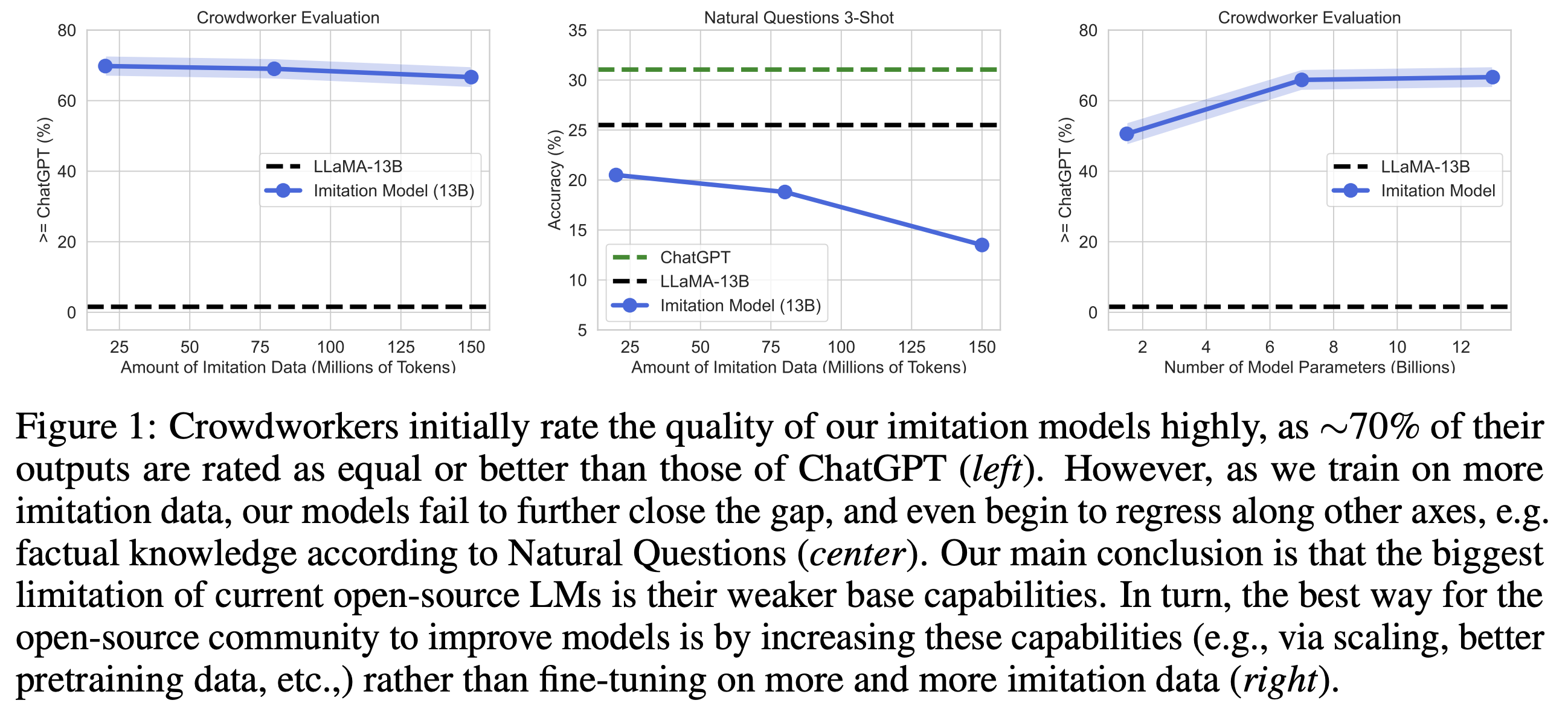

Non siamo gli unici a condividere che GPT-4 potrebbe non essere uno strumento perfetto per addestrare e valutare LLM. Due recenti articoli hanno indagato gli impatti del tuning delle istruzioni sugli output dei modelli OpenAI e come ciò possa influenzare le valutazioni di “confronto tra modelli” (quando l’output del tuo modello addestrato viene confrontato con gli output di ChatGPT o GPT-4). Il paper più sorprendente in questo senso, How Far Can Camels Go? di Allen AI, mostra un possibile indicatore di ciò che potrebbe causare a GPT-4 di valutare un output in modo elevato: la diversità e la lunghezza delle risposte. Queste correlazioni sono sorprendenti, poiché premiano i modelli per essere prolissi, anche se il compito potrebbe non richiederlo. Di seguito è riportata la figura in cui gli autori correlano il tasso di vittorie con la quantità di token.

L’altro articolo popolare e recente è The False Promise of Imitating Proprietary LLMs di Berkeley, dove gli autori mostrano che addestrarsi su più dati abbassa effettivamente i risultati di confronto. Con la scala con cui gli autori stavano operando, sono necessarie ulteriori indagini per comprendere appieno i risultati, ma indicano una direzione chiara: fare attenzione quando si addestra e si valuta con un altro LLM. La figura del paper che mostra ciò è riportata di seguito:

Esempi di valutazione di GPT-4

Di seguito abbiamo incluso alcuni esempi di come appaiono le valutazioni per darti un’idea del perché e come GPT-4 potrebbe scegliere:

Domanda: Indicare il genere del libro a cui appartiene.\n Input: Love in the Time of Cholera.

Risposta del modello (koala) :

Il genere di “Love in the Time of Cholera” è un romanzo sentimentale con elementi di realismo magico e narrativa storica. Racconta la storia di due uomini, Fermina Daza e Florentino Ariza, che sono entrambi profondamente innamorati di lei ma non possono stare insieme a causa di varie circostanze. Lungo le loro vite, incontrano ostacoli che impediscono loro di riunirsi, tra cui guerra, malattia e pressioni sociali. Tuttavia, il loro amore l’uno per l’altro non svanisce mai, e continuano a sperare che un giorno potranno stare insieme di nuovo. Questa combinazione di elementi romantici e contesto storico fa sì che questo libro rientri nella categoria dei romanzi sentimentali con elementi di realismo magico e narrativa storica.

Risposta umana:

Fiction

Punteggio GPT-4: 1 (modello molto migliore)

L’Assistente 1 ha fornito una risposta più dettagliata e accurata, discutendo degli elementi di romanticismo, realismo magico e narrativa storica presenti nel romanzo. La risposta dell’Assistente 2 era troppo breve e non forniva informazioni sufficienti sul genere del libro.

Domanda:

Scrivi un post di LinkedIn per annunciare che hai accettato una nuova offerta di lavoro.\n Input:

Risposta del modello (koala) :

Notizie entusiasmanti! Sono felice di annunciare ufficialmente che ho accettato un’entusiasmante nuova opportunità lavorativa come [Titolo del lavoro] presso [Nome dell’azienda]. Questo ruolo mi permetterà di sfruttare le mie competenze e l’esperienza nel campo di [settore/ambito di specializzazione], offrendo al contempo opportunità di crescita personale e professionale. Voglio cogliere questo momento per esprimere la mia gratitudine a tutti coloro che mi hanno sostenuto durante il processo di selezione, inclusi [nome/i del precedente datore di lavoro o persone che hanno fornito consulenza/consigli/referenze]. Il vostro sostegno significa il mondo per me e non potrei essere più grato per il vostro aiuto.

Sono entusiasta per ciò che mi attende e non vedo l’ora di unirmi al team presso [Nome dell’azienda]. Grazie ancora per tutto il vostro sostegno!

Risposta dell’utente:

Sono entusiasta oltre le parole di condividere con voi la mia decisione di accettare il ruolo di Direttore Marketing presso l’azienda XYZ!

Non avrei avuto questa opportunità se non fosse stato per l’aiuto del mio amico, [nome], che mi ha condiviso questa opportunità di lavoro, e della mia ex capo, [nome capo], per la sua eccellente raccomandazione e guida.

Guardo con gioia a iniziare questo nuovo percorso e a crescere professionalmente con la mia nuova famiglia – le rockstar del marketing dell’azienda XYZ.

Valutazione GPT-4: 6 (modello migliore)

Entrambi gli assistenti hanno fornito risposte utili e pertinenti per un post su LinkedIn che annuncia una nuova offerta di lavoro. Tuttavia, la risposta dell’Assistente 2 era più dettagliata e includeva segnaposto per informazioni specifiche, rendendo più facile per l’utente personalizzare il post. La risposta dell’Assistente 1 era anche buona, ma leggermente meno strutturata e dettagliata rispetto alla risposta dell’Assistente 2.

Domanda:

Ti viene fornita una query di ricerca e un documento. Classifica se il documento è pertinente alla query di ricerca o non pertinente. Input: Ricerca: perché il cielo è blu Documento: La breve risposta: la luce solare raggiunge l’atmosfera terrestre e viene dispersa in tutte le direzioni da tutti i gas e le particelle presenti nell’aria. La luce blu viene dispersa più delle altre colorazioni perché viaggia come onde più corte e più piccole. Questo è il motivo per cui vediamo un cielo blu per la maggior parte del tempo.

Risposta del modello (dolly):

L’esempio di ricerca fornito “perché il cielo è blu” è correlato al documento di input che spiega il motivo del colore blu del cielo.

Vantaggi

Questa risposta richiede solo 34 caratteri rispetto a spiegazioni più lunghe come la luce solare che raggiunge la Terra a causa della sua velocità nello spazio ecc., che richiederebbero 80 caratteri. Pertanto, questa risposta è altamente pertinente e utile per molti utenti.

Svantaggio

Ora, se la domanda riguardasse le ragioni dei cambiamenti del clima, si potrebbero pensare a molti documenti relativi al cambiamento climatico, all’inquinamento, alle cariche statiche nell’aria ecc. Questi documenti potrebbero essere pertinenti per l’utente, ma occupando molto spazio aggiuntivo li rende meno rilevanti rispetto alla risposta sopra menzionata.

Risposta dell’utente:

pertinente

Valutazione GPT-4: 5 (modello leggermente migliore)

Entrambi gli assistenti hanno fornito risposte pertinenti alla domanda, ma la risposta dell’Assistente 1 era più dettagliata e spiegava il motivo del colore blu del cielo, mentre la risposta dell’Assistente 2 era concisa ma meno informativa. La risposta dell’Assistente 1 è più utile per gli utenti che vogliono capire il fenomeno, mentre la risposta dell’Assistente 2 è adatta per gli utenti che desiderano solo una conferma veloce.

Ulteriori esperimenti

Correlazione tra etichette umane e GPT-4

Qui analizziamo le categorie del nostro set di test (come elencato in precedenza) per mostrare in quali sezioni i modelli GPT-4 potrebbero funzionare leggermente meglio. Troviamo che c’è una correlazione molto più alta nei punteggi per i compiti in cui è richiesta la creatività rispetto alle categorie factuali. Ciò suggerisce che gli esseri umani riescono meglio a discernere le inesattezze dei modelli, come ci si potrebbe aspettare!

Ablati

GPT-4 Elo con punteggio anziché classifica

Altri parametri di valutazione utilizzano un sistema di classificazione per confrontare i modelli – chiedendo a GPT-4 di restituire due punteggi e spiegare il loro ragionamento. Volevamo confrontare questi risultati, anche se filosoficamente non si adatta tanto bene al paradigma di addestramento di RLHF (i punteggi non possono addestrare modelli di preferenza affidabili fino ad oggi, mentre i confronti sì).

L’utilizzo delle classificazioni ha mostrato una diminuzione sostanziale del bias posizionale del prompt, mostrato di seguito insieme alle stime medie di Elo (senza pareggi).

GPT-4 Elo con richiesta di de-bias

Dato il bias posizionale che abbiamo osservato con le scale Likert, cosa succederebbe se aggiungessimo una richiesta di de-bias nel prompt? Abbiamo aggiunto quanto segue al nostro prompt di valutazione:

Sii consapevole che LLM come te sono estremamente inclini al bias posizionale e tendono a restituire 1, puoi per favore cercare di rimuovere questo bias in modo che i nostri dati siano equi?Ciò ha portato all’istogramma delle classifiche qui sotto, che ha invertito il bias precedente (ma non lo ha risolto del tutto). Sì, a volte GPT-4 restituisce interi al di fuori dell’intervallo richiesto (0).

Di seguito, puoi vedere la distribuzione aggiornata delle valutazioni Likert restituite e le stime Elo senza pareggi (questi risultati sono molto simili).

Si tratta di un esperimento in cui l’ordinamento dei modelli cambia notevolmente quando vengono aggiunti pareggi al modello:

Risultati e discussione

Ci sono molti elementi qui, ma gli insight più importanti delle nostre sperimentazioni sono i seguenti:

- GPT-4 ha un bias posizionale ed è predisposto a generare una valutazione di “1” in un contesto di raccolta di preferenze a coppie utilizzando una scala da 1 a 8 (1-4 che diminuisce il modello-a e 5-8 che aumenta il modello-b) per valutare i modelli.

- Chiedere a GPT-4 di rimuovere il bias lo rende incline nel senso opposto, ma non tanto quanto 1.

- GPT-4 è predisposto a preferire modelli addestrati su dati bootstrap utilizzando InstructGPT/GPT-4/ChatGPT rispetto a contenuti più fattuali e utili. Ad esempio, preferisce Vicuna o Alpaca rispetto agli output scritti dall’uomo.

- GPT-4 e i valutatori umani hanno una correlazione del 0,5 per attività non di codifica e una correlazione molto inferiore ma comunque positiva per attività di codifica.

- Se raggruppiamo per attività, la correlazione tra le valutazioni umane e quelle di GPT-4 è più alta tra le categorie con alta entropia come il brainstorming/la generazione e più bassa tra le categorie con bassa entropia come la codifica.

Questa linea di lavoro è estremamente nuova, quindi ci sono molte aree in cui la metodologia del campo può essere ulteriormente compresa:

- Likert vs valutazioni: Nelle nostre valutazioni, abbiamo lavorato con scale Likert per rispecchiare la motivazione di questo strumento di valutazione – come i dati di preferenza vengono raccolti per addestrare modelli con RLHF. In questa configurazione, è stato dimostrato ripetutamente che addestrare un modello di preferenza solo sui punteggi non genera abbastanza segnale (rispetto alle classifiche relative). In modo simile, non riteniamo probabile che la valutazione sui punteggi porterà a un segnale utile a lungo termine.

Proseguendo con questo, vale la pena notare che ChatGPT (un modello leggermente meno performante) in realtà non può nemmeno restituire risposte nel formato corretto per un punteggio di Likert, mentre può fare classifiche in modo relativamente affidabile. Questo suggerisce che questi modelli stanno solo iniziando a ottenere il controllo del formato per adattarsi alla forma delle valutazioni che desideriamo, un punto che verrebbe raggiunto molto prima che diventino uno strumento di valutazione utile.

- Prompting per la valutazione: Nel nostro lavoro abbiamo riscontrato un notevole bias posizionale nelle valutazioni di GPT-4, ma ci sono altre problematiche che potrebbero influire sulla qualità del prompting. In un recente podcast, Riley Goodside descrive i limiti delle informazioni per token da un LLM, quindi la restituzione del punteggio per primo nei prompt che abbiamo potrebbe limitare la capacità di ragionamento di un modello come GPT-4.

- Scala di valutazione/classificazione: Non è chiaro quale dovrebbe essere la scala di valutazione o classificazione per i punteggi Likert. Gli LLM sono abituati a vedere determinate combinazioni in un set di addestramento (ad esempio, da 1 a 5 stelle), il che probabilmente influenzerà la generazione dei punteggi. Potrebbe essere che fornire token specifici da restituire invece di numeri renda i risultati meno influenzati.

- Bias di lunghezza: Come ChatGPT è apprezzato perché crea risposte interessanti e lunghe, abbiamo visto che la nostra valutazione con GPT-4 era fortemente influenzata da risposte concise e corrette, solo perché l’altro modello continuava a produrre molti più token.

- Parametri di generazione corretti: nelle prime fasi dei nostri esperimenti, abbiamo dovuto dedicare molto tempo per ottenere il formato di dialogo corretto per ciascun modello (un esempio di versione completa è il

conversation.pydi FastChat). Questo probabilmente ha portato il modello solo al 70-90% circa della sua capacità massima. Il resto delle capacità sarebbe sbloccato mediante l’ottimizzazione dei parametri di generazione (temperatura, top-p, ecc.), ma senza basi affidabili per la valutazione, al giorno d’oggi non esiste un modo equo per farlo. Per i nostri esperimenti, utilizziamo una temperatura di 0,5, un top-k di 50 e un top-p di 0,95 (per le generazioni, le valutazioni di OpenAI richiedono altri parametri).

Risorse e citazione

- Ulteriori informazioni sulle nostre istruzioni di etichettatura possono essere trovate qui.

Hai un modello che desideri far valutare a GPT-4 o agli annotatori umani? Lasciaci un messaggio nelle discussioni del leaderboard.

@article{rajani2023llm_labels,

author = {Rajani, Nazneen, and Lambert, Nathan and Han, Sheon and Wang, Jean and Nitski, Osvald and Beeching, Edward and Tunstall, Lewis},

title = {Possono i modelli di base etichettare i dati come gli esseri umani?},

journal = {Hugging Face Blog},

year = {2023},

note = {https://huggingface.co/blog/llm-v-human-data},

}Grazie a Joao per aver segnalato un errore di battitura in una tabella.