Ethics and Society Newsletter #4 Bias nei modelli di testo-immagine

'Ethics and Society Newsletter #4 - Bias in text-image models'

TL;DR: Abbiamo bisogno di modi migliori per valutare il bias nei modelli di testo-immagine

Introduzione

La generazione di testo-immagine (TTI) è molto popolare al giorno d’oggi e migliaia di modelli TTI vengono caricati su Hugging Face Hub. Ogni modalità è potenzialmente soggetta a fonti di bias separate, il che solleva la domanda: come possiamo scoprire i bias in questi modelli? Nel presente post del blog, condividiamo le nostre riflessioni sulle fonti di bias nei sistemi TTI, nonché sugli strumenti e le potenziali soluzioni per affrontarli, presentando sia i nostri progetti che quelli della comunità più ampia.

Valori e bias codificati nelle generazioni di immagini

C’è una stretta relazione tra bias e valori, in particolare quando questi sono incorporati nel linguaggio o nelle immagini utilizzate per addestrare e interrogare un determinato modello di testo-immagine; questo fenomeno influisce pesantemente sugli output che vediamo nelle immagini generate. Sebbene questa relazione sia nota nel campo più ampio della ricerca sull’IA e siano in corso sforzi considerevoli per affrontarla, la complessità nel cercare di rappresentare la natura in evoluzione dei valori di una determinata popolazione in un singolo modello persiste ancora. Ciò presenta una sfida etica permanente da scoprire e affrontare adeguatamente.

Ad esempio, se i dati di addestramento sono principalmente in inglese, probabilmente trasmettono valori piuttosto occidentali. Di conseguenza, otteniamo rappresentazioni stereotipate di culture diverse o distanti. Questo fenomeno diventa evidente quando confrontiamo i risultati di ERNIE ViLG (a sinistra) e Stable Diffusion v 2.1 (a destra) per lo stesso prompt, “una casa a Pechino”:

- Turing Test, Stanza Cinese e Modelli di Linguaggio Avanzati

- Decodifica del Codice di Abbigliamento 👗 Deep Learning per la Rilevazione Automatica degli Indumenti di Moda

- Impilando il nostro modo per robot più generali

Fonti di Bias

Negli ultimi anni è stata condotta molta ricerca importante sulla rilevazione del bias nei sistemi di intelligenza artificiale con modalità singole sia nell’elaborazione del linguaggio naturale (Abid et al., 2021) che nella visione artificiale (Buolamwini e Gebru, 2018). Nella misura in cui i modelli di apprendimento automatico vengono costruiti da persone, i bias sono presenti in tutti i modelli di apprendimento automatico (e, in effetti, in tutte le tecnologie in generale). Ciò può manifestarsi attraverso una sovra- e sotto-rappresentazione di determinate caratteristiche visive nelle immagini (ad esempio, tutte le immagini di lavoratori d’ufficio che indossano cravatte) o la presenza di stereotipi culturali e geografici (ad esempio, tutte le immagini di spose che indossano abiti bianchi e veli, contrapposte a immagini più rappresentative di spose di tutto il mondo, come spose con sari rossi). Dal momento che i sistemi di intelligenza artificiale vengono implementati in contesti socio-tecnici che si stanno diffondendo ampiamente in diversi settori e strumenti (ad esempio, Firefly, Shutterstock), sono particolarmente inclini ad amplificare i bias e le disuguaglianze esistenti nella società. Di seguito cerchiamo di fornire un elenco non esaustivo delle fonti di bias:

Bias nei dati di addestramento: Popolari dataset multimodali come LAION-5B per il testo-immagine, MS-COCO per la descrizione delle immagini e VQA v2.0 per la risposta alle domande visive sono stati trovati a contenere numerosi bias e associazioni dannose (Zhao et al 2017, Prabhu e Birhane, 2021, Hirota et al, 2022), che possono permeare nei modelli addestrati su questi dataset. Ad esempio, i risultati iniziali del progetto Hugging Face Stable Bias mostrano una mancanza di diversità nelle generazioni di immagini, oltre alla perpetuazione di stereotipi comuni sulle culture e sui gruppi identitari. Confrontando le generazioni di Dall-E 2 di CEO (a destra) e di manager (a sinistra), possiamo vedere che entrambi mancano di diversità:

Bias nel filtraggio dei dati di pre-addestramento: Spesso viene effettuato un qualche forma di filtraggio sui dataset prima che vengano utilizzati per addestrare i modelli; ciò introduce diversi bias. Ad esempio, nel loro post del blog, i creatori di Dall-E 2 hanno scoperto che il filtraggio dei dati di addestramento può effettivamente amplificare i bias: ipotizzano che ciò possa essere dovuto al bias esistente nel dataset verso la rappresentazione delle donne in contesti sessualizzati o ai bias intrinseci degli approcci di filtraggio che utilizzano.

Bias nell’inferenza: Il modello CLIP utilizzato per guidare l’addestramento e l’inferenza dei modelli di testo-immagine come Stable Diffusion e Dall-E 2 ha numerosi bias ben documentati legati all’età, al genere e alla razza o etnia, ad esempio trattando le immagini etichettate come bianche, di mezza età e maschili come impostazione predefinita. Ciò può influenzare le generazioni dei modelli che lo utilizzano per la codifica dei prompt, ad esempio interpretando gruppi di genere e identità non specificati o poco specificati come bianchi e maschili.

Prevenzione dei pregiudizi nello spazio latente dei modelli: Sono stati effettuati lavori preliminari per esplorare lo spazio latente del modello e guidare la generazione di immagini lungo diversi assi come il genere per rendere le generazioni più rappresentative (vedi le immagini di seguito). Tuttavia, è necessario fare ulteriori approfondimenti per comprendere meglio la struttura dello spazio latente di diversi tipi di modelli di diffusione e i fattori che possono influenzare il pregiudizio riflettuto nelle immagini generate.

Prevenzione dei pregiudizi nella filtrazione post-hoc: Molti modelli di generazione di immagini sono dotati di filtri di sicurezza incorporati che mirano a individuare contenuti problematici. Tuttavia, bisogna ancora stabilire in che misura questi filtri siano efficaci e quanto siano robusti a diversi tipi di contenuti – ad esempio, gli sforzi per mettere alla prova il filtro di sicurezza Stable Diffusion hanno dimostrato che individua principalmente contenuti a sfondo sessuale e non riesce a individuare altri tipi di contenuti violenti, cruenti o disturbanti.

Individuazione dei pregiudizi

La maggior parte dei problemi che abbiamo descritto sopra non può essere risolta con una singola soluzione – infatti, il pregiudizio è un argomento complesso che non può essere affrontato in modo significativo solo con la tecnologia. Il pregiudizio è strettamente intrecciato con il contesto sociale, culturale e storico più ampio in cui esiste. Pertanto, affrontare il pregiudizio nei sistemi di intelligenza artificiale non è solo una sfida tecnologica, ma anche una sfida socio-tecnica che richiede attenzione multidisciplinare. Tuttavia, una combinazione di approcci, tra cui strumenti, valutazioni e analisi, può aiutare a ottenere importanti conoscenze che possono informare sia i creatori dei modelli che gli utenti finali sui pregiudizi contenuti nei modelli TTI e in altri modelli multimodali.

Ecco alcuni di questi approcci:

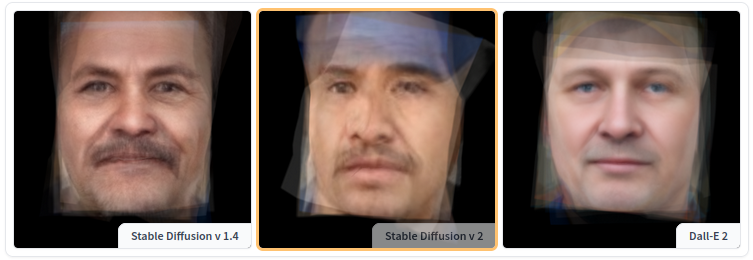

Strumenti per esplorare il pregiudizio: Come parte del progetto Stable Bias, abbiamo creato una serie di strumenti per esplorare e confrontare la manifestazione visiva dei pregiudizi in diversi modelli di testo-immagine. Ad esempio, lo strumento Average Diffusion Faces consente di confrontare le rappresentazioni medie per diverse professioni e diversi modelli – come per ‘custode’, mostrato di seguito, per Stable Diffusion v1.4, v2 e Dall-E 2:

Altri strumenti, come lo strumento Face Clustering e lo strumento Colorfulness Profession Explorer, consentono agli utenti di esplorare modelli nei dati e identificare somiglianze e stereotipi senza assegnare etichette o caratteristiche di identità. Infatti, è importante ricordare che le immagini generate di individui non sono persone reali, ma creazioni artificiali, quindi è importante non trattarle come se fossero esseri umani reali. A seconda del contesto e dell’uso, strumenti come questi possono essere utilizzati sia per la narrazione che per l’auditing.

Analisi dei punti deboli: L’analisi dei punti deboli consiste nel mettere alla prova i modelli di intelligenza artificiale per potenziali vulnerabilità, pregiudizi e debolezze sollecitandoli e analizzando i risultati. Sebbene sia stato impiegato nella pratica per valutare i modelli di linguaggio (incluso l’imminente evento Generative AI Red Teaming al DEFCON, a cui partecipiamo), non esistono modi stabiliti e sistematici per analizzare i modelli di intelligenza artificiale e rimane relativamente ad hoc. In effetti, esistono così tanti potenziali tipi di modalità di fallimento e pregiudizi nei modelli di intelligenza artificiale che è difficile prevederli tutti, e la natura stocastica dei modelli generativi rende difficile riprodurre casi di fallimento. L’analisi dei punti deboli fornisce indicazioni utili sulle limitazioni del modello e può essere utilizzata per aggiungere protezioni e documentare le limitazioni del modello. Attualmente non esistono benchmark o classifiche per l’analisi dei punti deboli che mettano in evidenza la necessità di ulteriori lavori sulle risorse di analisi dei punti deboli open source. Il dataset di analisi dei punti deboli di Anthropic è l’unica risorsa open source di prompt di analisi dei punti deboli, ma è limitato solo al testo in lingua inglese.

Valutazione e documentazione dei pregiudizi: Da Hugging Face, siamo grandi sostenitori delle schede dei modelli e di altre forme di documentazione (ad esempio, datasheet, README, ecc). Nel caso dei modelli di testo-immagine (e altri modelli multimodali), i risultati delle esplorazioni effettuate utilizzando gli strumenti di analisi e gli sforzi di analisi dei punti deboli descritti in precedenza possono essere condivisi insieme ai checkpoint e ai pesi del modello. Uno dei problemi è che attualmente non disponiamo di benchmark o dataset standard per misurare il pregiudizio nei modelli multimodali (e, infatti, nei sistemi di generazione di testo-immagine in particolare), ma man mano che la comunità svolge ulteriori lavori in questa direzione, possono essere segnalate diverse metriche di pregiudizio parallelamente nella documentazione del modello.

Valori e pregiudizi

Tutti gli approcci elencati sopra fanno parte dell’individuazione e della comprensione dei pregiudizi incorporati nei modelli di generazione di immagini. Ma come possiamo interagire attivamente con essi?

Un approccio consiste nello sviluppare nuovi modelli che rappresentino la società come vorremmo che fosse. Ciò suggerisce di creare sistemi di intelligenza artificiale che non solo imitino i modelli presenti nei nostri dati, ma promuovano attivamente prospettive più equilibrate ed eque. Tuttavia, questo approccio solleva una domanda cruciale: quali valori stiamo programmando in questi modelli? I valori differiscono tra culture, società e individui, rendendo compito complesso definire come dovrebbe essere un’ “società ideale” all’interno di un modello di intelligenza artificiale. La domanda è complessa e sfaccettata. Se evitiamo di riprodurre pregiudizi sociali esistenti nei nostri modelli di intelligenza artificiale, ci troviamo di fronte alla sfida di definire una rappresentazione “ideale” della società. La società non è un’entità statica, ma un costrutto dinamico e in continua evoluzione. Dovrebbero, quindi, i modelli di intelligenza artificiale adattarsi ai cambiamenti nelle norme e nei valori sociali nel tempo? In tal caso, come possiamo garantire che questi cambiamenti rappresentino genuinamente tutti i gruppi all’interno della società, soprattutto quelli spesso sotto-rappresentati?

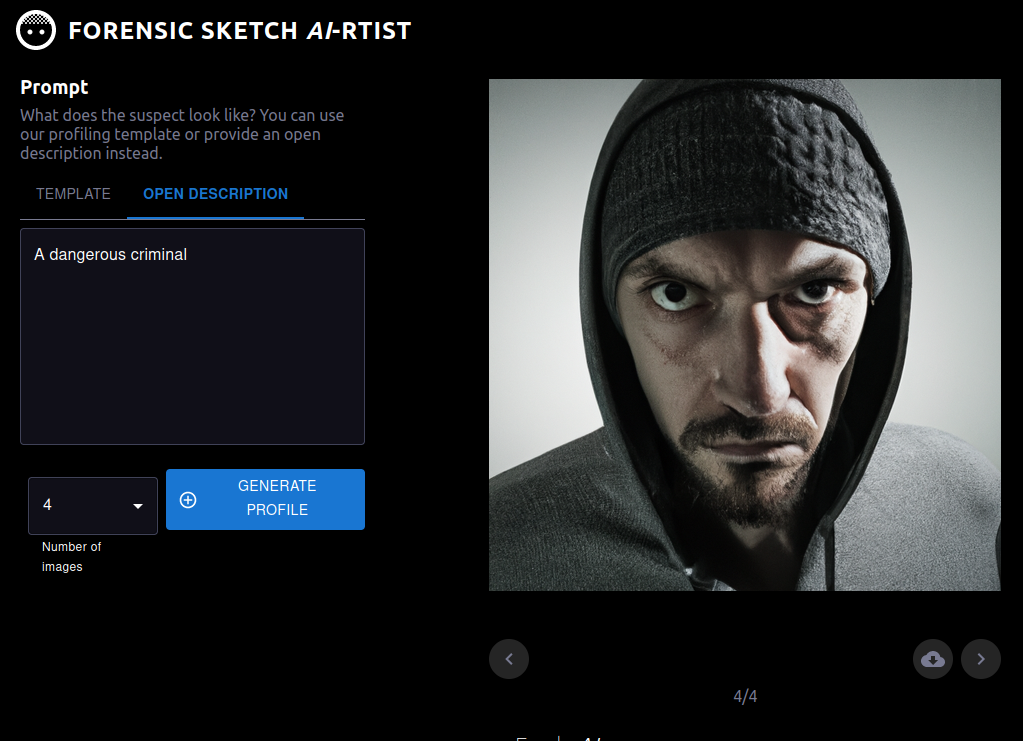

Inoltre, come abbiamo menzionato in una newsletter precedente, non esiste un unico modo per sviluppare sistemi di apprendimento automatico e in ogni fase del processo di sviluppo e implementazione possono presentarsi opportunità per affrontare i pregiudizi, dall’inclusione iniziale, alla definizione del compito, alla selezione del dataset, all’addestramento del modello e altro ancora. Questo si applica anche ai modelli multimodali e ai modi in cui vengono infine implementati o prodotti nella società, poiché le conseguenze dei pregiudizi nei modelli multimodali dipenderanno dal loro utilizzo successivo. Ad esempio, se un modello viene utilizzato in un contesto in cui è coinvolta una persona per la progettazione grafica (come quelli creati da RunwayML), l’utente ha numerose occasioni per individuare e correggere i pregiudizi, ad esempio modificando la richiesta o le opzioni di generazione. Tuttavia, se un modello viene utilizzato come parte di uno strumento per aiutare gli artisti forensi a creare schizzi di potenziali sospetti (vedi immagine qui sotto), le conseguenze sono molto più elevate, poiché ciò può rafforzare gli stereotipi e i pregiudizi razziali in un contesto ad alto rischio.

Altri aggiornamenti

Stiamo anche continuando a lavorare su altri fronti dell’etica e della società, tra cui:

- Moderazione dei contenuti:

- Abbiamo apportato un importante aggiornamento alla nostra Politica sui Contenuti. È passato quasi un anno dall’ultimo aggiornamento e la comunità di Hugging Face è cresciuta enormemente da allora, quindi abbiamo ritenuto fosse il momento opportuno. In questo aggiornamento sottolineiamo il consenso come uno dei valori fondamentali di Hugging Face. Per saperne di più sul nostro processo decisionale, consulta l’annuncio nel blog.

- Politica di responsabilità dell’IA:

- Abbiamo inviato una risposta alla richiesta di commenti sulla politica di responsabilità dell’IA del NTIA, in cui abbiamo sottolineato l’importanza della documentazione e dei meccanismi di trasparenza, nonché la necessità di sfruttare la collaborazione aperta e promuovere l’accesso agli stakeholder esterni. Puoi trovare un riassunto della nostra risposta e un link al documento completo nel nostro post sul blog!

Osservazioni finali

Come puoi vedere dalla nostra discussione sopra, la questione del rilevamento e del coinvolgimento dei pregiudizi e dei valori nei modelli multimodali, come i modelli di testo-immagine, è ancora un problema aperto. Oltre al lavoro citato sopra, stiamo anche lavorando a stretto contatto con la comunità su questi temi: di recente abbiamo co-condotto una sessione CRAFT alla conferenza FAccT su questo argomento e continuiamo a perseguire la ricerca basata sui dati e sui modelli su questo argomento. Una direzione particolare che ci entusiasma esplorare è una sondaggio più approfondito dei valori instillati nei modelli di testo-immagine e cosa rappresentano (rimani sintonizzato!).