Accendendo la combustione cognitiva unendo architetture cognitive e LLM per costruire il prossimo computer

Combining cognitive architectures and LLM to build the next computer by igniting cognitive combustion.

“Un sistema non è mai la somma delle sue parti, ma il prodotto delle loro interazioni” – Russell Ackoff.

Tendiamo a focalizzarci sugli ultimi gadget e algoritmi, ma la tecnologia da sola non guida il cambiamento nel mondo reale. Il vero progresso dipende dai sistemi che integrano le tecnologie in una soluzione. Gli strumenti individuali sono un mezzo per raggiungere un fine; i sistemi sono il fine stesso.

Consideriamo questo esempio. Gli esseri umani hanno sfruttato il potere della combustione per secoli senza svelarne tutto il potenziale. Abbiamo acceso fuochi, portato torce e abitato parti remote del pianeta. Ma estrarre il suo potenziale ha richiesto di progettare una danza intricata: il motore a combustione interna, per generare esplosioni che fanno girare le manovelle e muovono i pistoni. Nonostante i componenti del motore siano avanzati notevolmente, il design concettuale perdura perché produce risultati molto superiori a quelli che le singole parti potrebbero ottenere.

- Ottimizzazione del database Esplorazione degli indici in SQL

- LAION AI presenta Video2Dataset uno strumento open-source progettato per curare dataset video e audio in modo efficiente e su larga scala.

- Jasper AI Review (luglio 2023) Il miglior generatore di scrittura AI?

Allo stesso modo, nel campo dell’informatica, il progresso deve molto al pensiero sistematico. Nel 1945, il matematico John von Neumann ha assemblato la memoria, l’input, l’output, il controllo e l’elaborazione in un’architettura integrata per risolvere problemi computazionali. Questo sistema, non un singolo componente, ha dato origine all’informatica moderna. Settantotto anni dopo, sebbene le tecnologie siano molto diverse, i principi di von Neumann sono ancora in gran parte intatti. I computer di oggi, molto più potenti, sono strutturalmente simili ai loro antenati degli anni ’40 perché è l’architettura, non solo i componenti, a modellare il modo in cui vengono risolti i problemi del mondo reale.

Siamo sull’orlo di un’altra riconsiderazione, questa volta guidata dall’emergere dei modelli linguistici. Ma prima di arrivare a questo, vediamo con cosa stiamo lavorando.

Simbolico e Sotto-simbolico

Per la maggior parte di noi, la tecnologia implica sistemi logici e spiegabili basati su simboli come il codice, i numeri e il linguaggio. Diamo ai computer istruzioni simboliche esplicite e loro seguono deterministicamente le nostre ricette per produrre output attesi. Questi sistemi basati su regole sono il yang del pensiero caotico e non strutturato dei sistemi sotto-simbolici.

I sistemi sotto-simbolici come le reti neurali imitano la natura distribuita e parallela dei neuroni biologici. Essi emergono risposte dalle attività non coordinate di nodi individuali, proprio come le colonie emergono dalle formiche che seguono semplici schemi. Mentre i sistemi simbolici sono creati dalla logica umana, i sistemi sotto-simbolici individuano modelli e stabiliscono associazioni sfocate da soli. I loro risultati sembrano magici ma opachi rispetto ai processi simbolici e trasparenti.

Tuttavia, come il simbolo del yin e yang, le nostre menti uniscono queste due modalità. Le nostre facoltà simboliche ci permettono di creare e seguire le regole, costruire argomenti logici e comunicare chiaramente attraverso il linguaggio. Le nostre facoltà sotto-simboliche riconoscono volti, percepiscono emozioni e si muovono agevolmente nel caotico mondo fisico.

Tentativo di adattare una cosa a una situazione inadatta.

Il nostro mondo basato sulle regole ha incontrato un estraneo ribelle: il grande modello linguistico (LLM). Pretendiamo che le nostre tecnologie si comportino in modo logico e producano risultati coerenti, eppure gli LLM pensano in modo probabilistico, vedendo possibilità dove noi vediamo un vicolo cieco. Abbiamo scartato la loro creatività come allucinatoria, giudicando attraverso la lente quadrata del pensiero simbolico. Ma il futuro richiede un motore in grado di accendere sia il simbolico che il sotto-simbolico in una combustione cognitiva, sfruttando la loro energia per portarci a nuove vette computazionali.

La buona notizia è che gli scienziati stanno lavorando su questo da un po’ di tempo. Chi non vorrebbe scoprire il segreto per far agire le macchine come gli esseri umani?

Architetture Cognitive

Dal 1950, i ricercatori si sono dedicati alle “architetture cognitive” – sistemi capaci di ragionare ampiamente, acquisire intuizioni, adattarsi ai cambiamenti e persino riflettere sul proprio pensiero.

Dopo decenni di ricerca, le architetture cognitive sono proliferate fino a superare le 300 proposte. Nella loro recensione, Kosteruba e Tsotsos hanno analizzato 84 architetture, organizzandole in una tassonomia. Hanno scoperto che le architetture spaziavano dalle reti neurali ispirate alla biologia ai rigidi sistemi di regole simboliche, con molti ibridi nel mezzo.

Modello Comune della Cognizione

Fortunatamente non dobbiamo analizzare tutti questi modelli. Nel 2017, John Laird e colleghi hanno proposto un “modello standard della mente” per fornire un quadro comune per discutere di queste architetture. Il loro modello sintetizza concetti chiave da tre architetture pionieristiche:

- ACT-R, sviluppato da John Anderson dal 1976, modella la cognizione attraverso l’interazione tra la memoria procedurale e la memoria dichiarativa. La memoria procedurale codifica abilità e routine, mentre la memoria dichiarativa memorizza fatti. Seguendo procedure per accedere e applicare conoscenze dichiarative, ACT-R dimostra come l’interazione tra “sapere che” e “sapere come” permetta un comportamento intelligente.

- Soar, creato da John Laird negli anni ’80, fornisce un sistema unificato basato su regole che spazia dalla percezione, all’apprendimento, alla pianificazione, alla risoluzione dei problemi e alla presa di decisioni. Le “produzioni” rappresentano la conoscenza come regole di condizione-azione che operano sulla memoria di lavoro. Soar simula le capacità flessibili e orientate agli obiettivi della mente, seguendo dinamicamente le produzioni.

- Sigma, concepito da Polk e Newell nel 1988, vede la mente come una società asincrona di comportamenti. I moduli mentali inviano messaggi che innescano altri comportamenti, continuando fino a quando i desideri vengono soddisfatti o abbandonati. Questo ciclo di “generazione e gestione del comportamento” dà origine a comportamenti complessi ed adattivi.

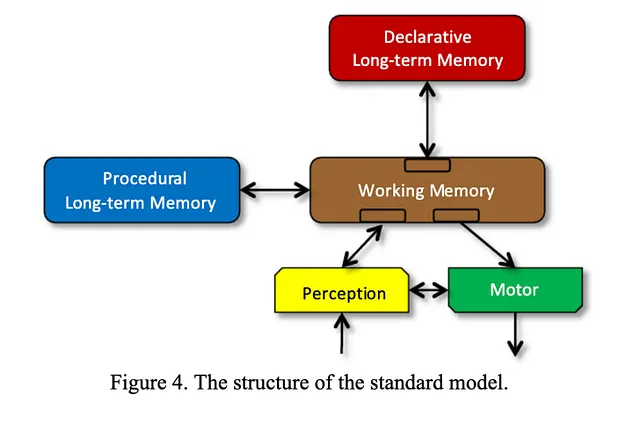

Il modello standard della mente comprende tre sistemi di memoria interattivi:

Memoria dichiarativa è la nostra base di conoscenza, che memorizza fatti e concetti che possiamo dichiarare consapevolmente. Conserva informazioni come il tuo colore preferito, eventi storici, segnali stradali o vocabolario. La memoria dichiarativa fornisce la materia prima per il pensiero, di cui gli altri sistemi si avvalgono.

Memoria procedurale codifica abilità e routine, la conoscenza del “come fare” che permette il comportamento. Ci consente di guidare biciclette, allacciare le scarpe o suonare strumenti musicali. La memoria procedurale traduce la conoscenza in azione.

Memoria di lavoro è il nostro spazio di lavoro mentale, che trattiene e manipola temporaneamente le informazioni per consentire la pianificazione, la risoluzione dei problemi e la presa di decisioni. Nella risoluzione di un problema matematico, la memoria di lavoro trattiene numeri, operazioni e passaggi intermedi fino a quando non emerge una soluzione. Integra l’accesso e l’applicazione della conoscenza dalla memoria dichiarativa e procedurale.

In questo modello non c’è un controllore; al suo posto, è guidato da un “ciclo cognitivo”. Come il ciclo dell’orologio nei computer, questo “ciclo cognitivo” guida il funzionamento del sistema eseguendo procedure per raggiungere obiettivi.

Guidare una macchina, ad esempio, richiede:

- Conoscenza dichiarativa di segnali, controlli e percorsi

- Abilità procedurali per guidare

- Memoria di lavoro per monitorare le condizioni e reagire nel momento

Integrazione dei Modelli Linguistici nel Modello Standard della Mente

Il modello standard ha articolato le principali facoltà prima dell’attuale boom nei modelli linguistici. Sebbene sia ancora presto, i framework degli agenti odierni (AutoGPT, BabyAGI, ecc.) hanno creato alcune di queste capacità.

Invece di moduli di memoria distinti, questi framework accedono a fonti di conoscenza esterne tramite ricerca vettoriale. I moduli di percezione e motori sono implementati come chiamate API e plugin. La finestra di contesto del modello linguistico è la memoria di lavoro temporanea.

Una lacuna chiave rimane: l’apprendimento robusto. I sistemi attuali mancano di un meccanismo per accumulare conoscenze e abilità in modo continuo dall’esperienza. Essi si affidano invece a prompt e al tuning del modello. La prossima svolta sarà l’integrazione di un meccanismo che consenta l’apprendimento continuo dalle interazioni, accumulando conoscenza e abilità al volo, come le menti umane!

Una Nuova Ricetta per il Progresso? Creazione di Architetture Cognitive

Oggi ci troviamo con nuovi ingredienti – modelli linguistici, ricerca vettoriale, API – e vecchie ricette per l’intelligenza delle architetture cognitive. Non è ancora chiaro se questi possano essere mescolati in un nuovo sistema con capacità al di là di ogni singola parte. La storia offre esempi di ricette che hanno resistito, come il framework di calcolo di von Neumann o il motore a combustione interna. Ma per ogni ricetta visionaria, ci sono state molte miscele fallite.

Una cosa è chiara. Quando scopriremo questo nuovo “motore cognitivo”, propellerà il progresso in modo più profondo di qualsiasi tecnologia prima di esso.