Spostare i grandi modelli di linguaggio (LLM) nelle applicazioni aziendali del mondo reale

Applicazioni aziendali dei grandi modelli di linguaggio (LLM)

I modelli di linguaggio di grandi dimensioni sono ovunque. Ogni conversazione con il cliente o presentazione agli investitori comporta domande su quanto sia pronta la tecnologia LLM e su come guiderà le future applicazioni. Ho affrontato alcuni modelli in questo argomento nel mio post precedente. Qui parlerò di alcuni modelli del mondo reale per un’applicazione nell’industria farmaceutica su cui Persistent Systems ha lavorato.

Modelli di linguaggio di grandi dimensioni e punti di forza principali

I LLM sono bravi a comprendere il linguaggio, questa è la loro specialità. Il modello più comune che vediamo con le applicazioni è il recupero con generazione potenziata (RAG), in cui le conoscenze vengono raccolte esternamente da fonti di dati e fornite in contesto come input per il LLM per parafrasare una risposta. In questo caso, meccanismi di ricerca super veloci come i database vettoriali e i motori basati su Elasticsearch fungono da prima linea di ricerca. Successivamente, i risultati della ricerca vengono compilati in un input e inviati al LLM principalmente come chiamata API.

Un altro modello consiste nella generazione di una query su dati strutturati alimentando il LLM con un modello di dati come input e una query specifica dell’utente. Questo modello potrebbe essere utilizzato per sviluppare un’interfaccia avanzata “parla con i tuoi dati” per database SQL come Snowflake, così come per database grafici come Neo4j.

Sfruttare i modelli LLM per intuizioni del mondo reale

Recentemente, Persistent Systems ha esaminato un modello per Blast Motion, un’azienda di telemetria sportiva (analisi del movimento per baseball, golf, ecc.), in cui abbiamo analizzato dati in serie temporali di riepiloghi dei giocatori per ottenere raccomandazioni.

- Java ZGC Ottimizzazione dell’algoritmo

- Come sta trasformando l’IA la gestione personale della conoscenza?

- Divisi cadiamo, uniti resistiamo CoTracker è un approccio di intelligenza artificiale che traccia congiuntamente più punti in un video

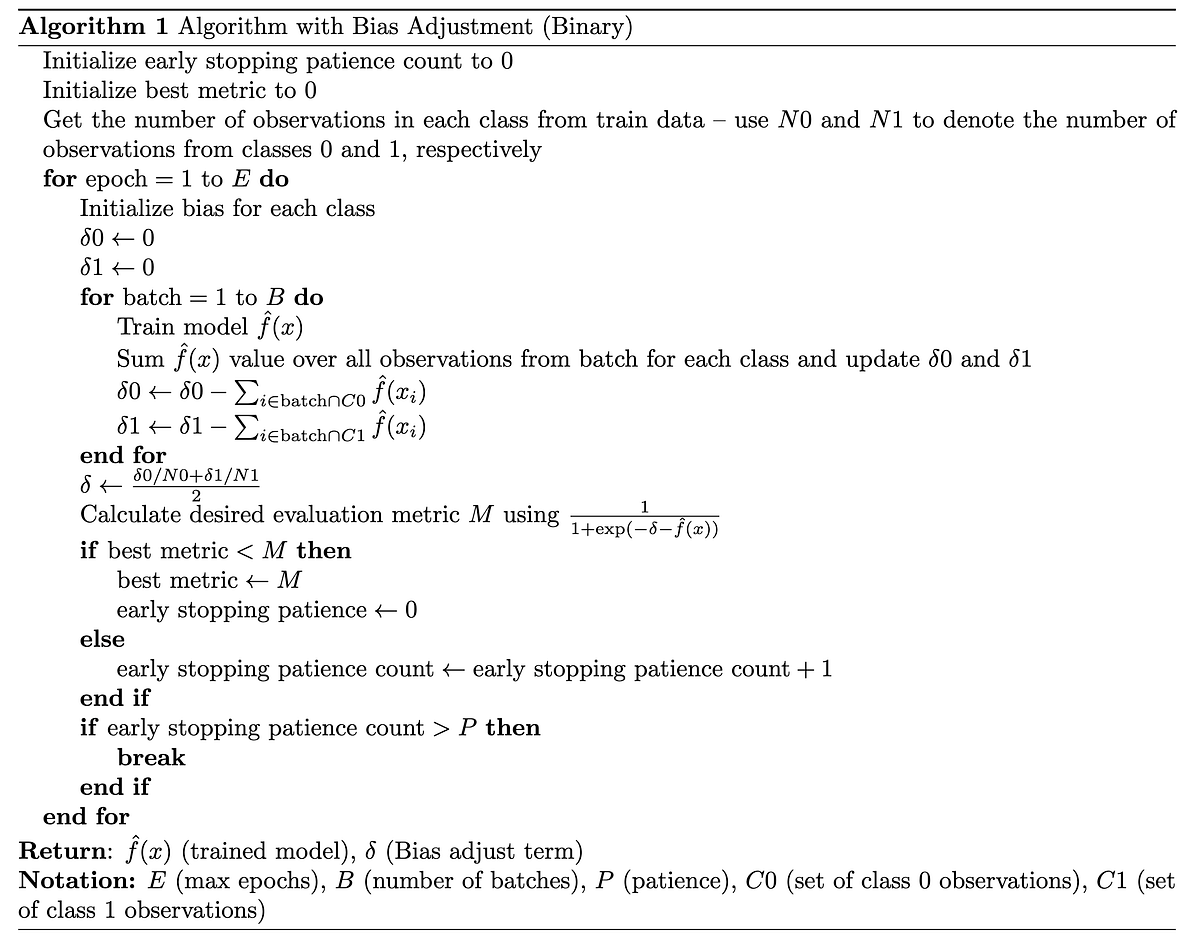

Per applicazioni più complesse, spesso è necessario concatenare le richieste del LLM con elaborazioni tra le chiamate. Per un’azienda farmaceutica, abbiamo sviluppato un’applicazione intelligente per la selezione dei pazienti per gli studi clinici basata su criteri estratti dal documento di studio clinico. Qui abbiamo utilizzato un approccio a catena LLM. Prima abbiamo sviluppato un LLM per leggere il documento PDF dello studio e utilizzare il modello RAG per estrarre i criteri di inclusione ed esclusione.

Per fare ciò, è stato utilizzato un LLM relativamente più semplice come GPT-3.5-Turbo (ChatGPT). Successivamente, abbiamo combinato queste entità estratte con il modello di dati del database SQL dei pazienti in Snowflake per creare un input. Questo input, alimentato a un LLM più potente come GPT4, ci fornisce una query SQL per filtrare i pazienti, pronta per essere eseguita su Snowflake. Poiché utilizziamo la concatenazione del LLM, potremmo utilizzare più LLM per ogni passaggio della catena, consentendoci così di gestire i costi.

Attualmente, abbiamo deciso di mantenere questa catena deterministica per un migliore controllo. Vale a dire, abbiamo deciso di avere più intelligenza nelle catene e mantenere l’orchestrazione molto semplice e prevedibile. Ogni elemento della catena è un’applicazione complessa di per sé che richiederebbe alcuni mesi per essere sviluppata nei giorni pre-LLM.

Alimentare casi d’uso più avanzati

Per un caso più avanzato, potremmo utilizzare agenti come ReAct per sollecitare il LLM a creare istruzioni passo passo da seguire per una particolare query dell’utente. Ciò richiederebbe ovviamente un LLM di alta qualità come GPT4 o Cohere o Claude 2. Tuttavia, c’è il rischio che il modello compia un passo errato che dovrà essere verificato utilizzando delle protezioni. Questo è un compromesso tra spostare l’intelligenza in collegamenti controllabili della catena o rendere l’intera catena autonoma.

Oggi, mentre ci abituiamo all’era dell’IA generativa per il linguaggio, il settore sta iniziando ad adottare applicazioni LLM con catene prevedibili. Man mano che questa adozione cresce, inizieremo presto a sperimentare una maggiore autonomia per queste catene tramite agenti. Di questo si tratta il dibattito sull’AGI e siamo interessati a vedere come tutto ciò si evolverà nel tempo.