Divisi cadiamo, uniti resistiamo CoTracker è un approccio di intelligenza artificiale che traccia congiuntamente più punti in un video

CoTracker è un approccio di intelligenza artificiale che traccia punti in un video.

Gli ultimi anni sono stati ricchi di progressi nella generazione di immagini e nei modelli di linguaggio nel campo dell’IA. Sono stati sotto i riflettori per molto tempo grazie alle loro capacità rivoluzionarie. Sia la generazione di immagini che i modelli di linguaggio sono diventati così buoni che è difficile differenziare gli output generati da quelli reali.

Ma non sono le uniche applicazioni che hanno fatto progressi rapidi negli ultimi anni. Abbiamo visto notevoli avanzamenti anche nelle applicazioni di visione artificiale. Ad esempio, il modello di segmentazione di qualsiasi cosa (SAM) ha aperto nuove possibilità nella segmentazione degli oggetti. SAM può segmentare qualsiasi oggetto in un’immagine o, in modo ancora più impressionante, in un video senza fare affidamento su un dizionario di addestramento.

La parte video è particolarmente interessante perché il video è sempre stato considerato un dato difficile da gestire. Quando si lavora con i video, il tracciamento del movimento gioca un ruolo fondamentale in qualsiasi obiettivo si stia cercando di raggiungere. Questo costituisce la base del problema.

- Pricing dinamico con il bandito armato multipla imparando facendo

- AWS vs Azure Il confronto finale tra i cloud

- Svelando il potere dell’aggiustamento del bias migliorare la precisione predittiva nei dataset sbilanciati

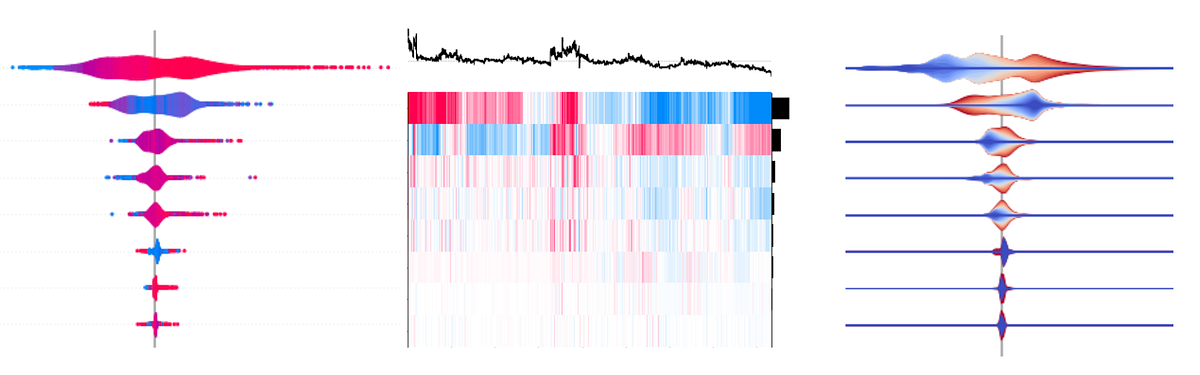

Un aspetto cruciale del tracciamento del movimento è stabilire le corrispondenze tra punti. Recentemente, ci sono stati molti tentativi di fare stima del movimento nei video con oggetti dinamici e telecamere in movimento. Questo compito impegnativo comporta la stima della posizione dei punti 2D attraverso i frame video, rappresentando la proiezione dei punti di scena 3D sottostanti.

I due approcci principali alla stima del movimento sono il flusso ottico e il tracciamento. Il flusso ottico stima la velocità per tutti i punti all’interno di un frame video, mentre il tracciamento si concentra sulla stima del movimento dei punti nel tempo, trattando i punti come statisticamente indipendenti.

Anche se le moderne tecniche di apprendimento profondo hanno compiuto progressi nel tracciamento dei punti, resta un aspetto fondamentale trascurato: la correlazione tra i punti tracciati. Intuitivamente, i punti che appartengono allo stesso oggetto fisico dovrebbero essere correlati, eppure i metodi convenzionali li trattano come indipendenti, portando ad approssimazioni errate. È ora di conoscere CoTracker, che affronta questo problema.

CoTracker è un tracker basato su una rete neurale che mira a rivoluzionare il tracciamento dei punti in sequenze video lunghe tenendo conto della correlazione tra i punti tracciati. La rete prende sia il video che un numero variabile di posizioni di tracciamento iniziali come input e restituisce le tracce complete per i punti specificati.

CoTracker supporta il tracciamento congiunto di più punti e l’elaborazione di video più lunghi in un’applicazione a finestre. Opera su una griglia bidimensionale di token, con una dimensione che rappresenta il tempo e l’altra i punti di tracciamento. Utilizzando operatori di self-attention adeguati, la rete basata su transformer può considerare ogni traccia nel suo insieme all’interno di una finestra e scambiare informazioni tra le tracce, sfruttando le loro correlazioni inherenti.

La flessibilità di CoTracker consente di tracciare punti arbitrari in qualsiasi posizione spaziale e temporale nel video. Prende una versione iniziale approssimativa delle tracce e le affina gradualmente per adattarle meglio al contenuto del video. Le tracce possono essere inizializzate da qualsiasi punto, anche nel bel mezzo di un video o dall’output del tracker stesso, quando viene utilizzato in modo scorrevole.

CoTracker rappresenta un progresso promettente nella stima del movimento, sottolineando l’importanza di considerare le correlazioni tra i punti. Apre la strada per un’analisi video migliorata e apre nuove possibilità per le attività future nella visione artificiale.