Allenare il proprio LLM senza codifica

Allenamento LLM senza codifica

Introduzione

L’IA generativa, un campo affascinante che promette di rivoluzionare il modo in cui interagiamo con la tecnologia e generiamo contenuti, ha conquistato il mondo. In questo articolo, esploreremo il fascinante mondo dei Large Language Models (LLM), i loro elementi costitutivi, le sfide poste dai LLM proprietari e l’emergere dei modelli open source. Approfondiremo anche l’ecosistema LLM di H2O, compresi gli strumenti e i framework come h2oGPT e LLM DataStudio che consentono alle persone di addestrare LLM senza competenze di programmazione approfondite.

Obiettivi di apprendimento:

- Comprendere il concetto e le applicazioni dell’IA generativa con i Large Language Models (LLM).

- Riconoscere le sfide dei LLM proprietari e i vantaggi dei modelli open source.

- Esplorare l’ecosistema LLM di H2O per l’addestramento dell’IA senza competenze di programmazione approfondite.

Elementi costitutivi dei LLM: modelli di base e affinamento

Prima di addentrarci nei dettagli dei LLM, fermiamoci un attimo e comprendiamo il concetto di IA generativa. Mentre l’IA predittiva è stata la norma, concentrata sulla previsione basata su modelli di dati storici, l’IA generativa ribalta la situazione. Equipaggia le macchine con la capacità di creare nuove informazioni da set di dati esistenti.

Immagina un modello di apprendimento automatico in grado non solo di prevedere, ma anche di generare testo, riassumere contenuti, classificare informazioni e altro ancora, tutto da un singolo modello. Ecco dove entrano in gioco i Large Language Models (LLM).

- OpenAI svela DALL·E 3 un balzo rivoluzionario nella generazione di testo-immagine

- I ricercatori di IBM propongono un nuovo framework di attacco avversario in grado di generare input avversari per i sistemi di intelligenza artificiale indipendentemente dalla modalità o dal compito

- Google Pub/Sub a BigQuery in modo semplice

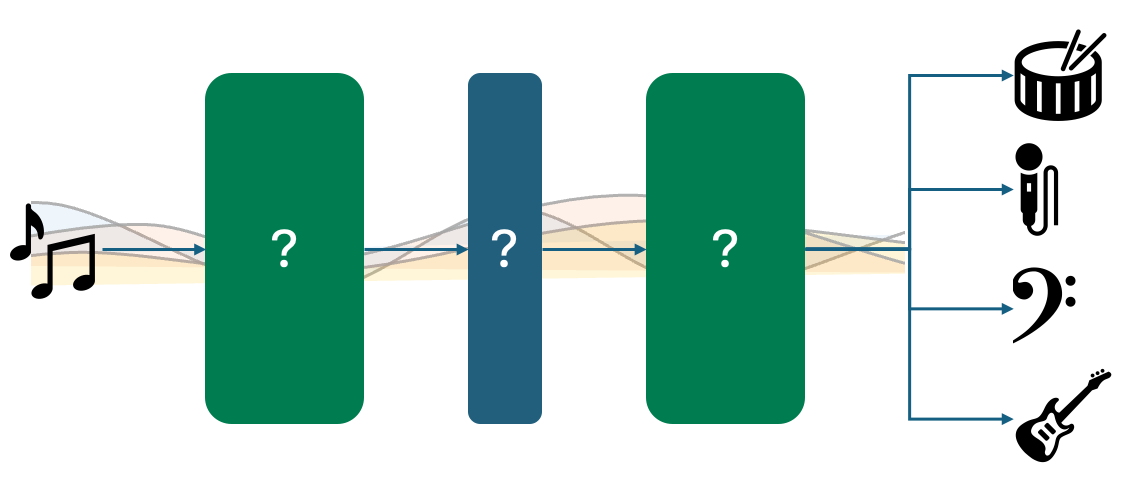

I LLM seguono un processo in più fasi, a partire da un modello di base. Questo modello richiede un set di dati esteso su cui addestrarsi, spesso nell’ordine dei terabyte o petabyte di dati. Questi modelli di base imparano predire la prossima parola in una sequenza, con l’obiettivo di comprendere i pattern all’interno dei dati.

Una volta stabilito il modello di base, il passo successivo è l’affinamento. Durante questa fase, viene impiegato l’affinamento supervisionato su set di dati selezionati per plasmare il modello secondo il comportamento desiderato. Questo può comportare l’addestramento del modello per eseguire compiti specifici, come la selezione a scelta multipla, la classificazione e altro ancora.

Il terzo passo, il reinforcement learning con feedback umano, perfeziona ulteriormente le prestazioni del modello. Utilizzando modelli di ricompensa basati su feedback umani, il modello affina le sue previsioni per allinearle più strettamente alle preferenze umane. Ciò aiuta a ridurre il rumore e aumentare la qualità delle risposte.

Ogni passo in questo processo contribuisce a migliorare le prestazioni del modello e a ridurre l’incertezza. È importante notare che la scelta del modello di base, del set di dati e delle strategie di affinamento dipende dal caso d’uso specifico.

Sfide dei LLM proprietari e l’emergere dei modelli open source

I LLM proprietari, come ChatGPT, Google Bard e altri, hanno dimostrato la loro efficacia. Tuttavia, presentano alcune sfide. Queste includono preoccupazioni sulla privacy dei dati, personalizzazione e controllo limitati, costi operativi elevati e occasionali indisponibilità.

Organizzazioni e ricercatori hanno riconosciuto la necessità di LLM più accessibili e personalizzabili. In risposta, hanno iniziato a sviluppare modelli open source. Questi modelli sono economici, flessibili e possono essere adattati a requisiti specifici. Inoltre, eliminano preoccupazioni riguardanti l’invio di dati sensibili a server esterni.

I LLM open source permettono agli utenti di addestrare i propri modelli e accedere al funzionamento interno degli algoritmi. Questo ecosistema aperto offre maggiore controllo e trasparenza, rendendolo una soluzione promettente per varie applicazioni.

L’ecosistema LLM di H2O: strumenti e framework per l’addestramento dei LLM senza programmazione

H2O, un importante attore nel mondo del machine learning, ha sviluppato un robusto ecosistema per i LLM. I loro strumenti e framework facilitano l’addestramento dei LLM senza la necessità di competenze approfondite di programmazione. Esploriamo alcuni di questi componenti.

h2oGPT

h2oGPT è un LLM affinato che può essere addestrato sui tuoi dati. La parte migliore? È completamente gratuito. Con h2oGPT, puoi sperimentare con i LLM e persino applicarli commercialmente. Questo modello open source ti consente di esplorare le potenzialità dei LLM senza barriere finanziarie.

Strumenti di Deploy

H2O.ai offre una serie di strumenti per il deploy dei tuoi LLM, garantendo che i tuoi modelli possano essere messi in azione in modo efficace ed efficiente. Che tu stia costruendo chatbot, assistenti di data science o strumenti di generazione di contenuti, queste opzioni di deploy offrono flessibilità.

Framework di Training per LLM

Allenare un LLM può essere un processo complesso, ma i framework di training per LLM di H2O semplificano il compito. Con strumenti come Colossal e DeepSpeed, puoi allenare i tuoi modelli open-source in modo efficace. Questi framework offrono supporto per vari modelli di base e ti consentono di ottimizzarli per compiti specifici.

Demo: Preparazione dei Dati e Ottimizzazione dei LLM con LLM DataStudio di H2O

Andiamo ora a vedere una dimostrazione su come puoi utilizzare l’ecosistema LLM di H2O, concentrandoci in particolare su LLM DataStudio. Questa soluzione senza codice ti permette di preparare i dati per ottimizzare i tuoi modelli LLM. Che tu stia lavorando con testi, PDF o altri formati di dati, LLM DataStudio semplifica il processo di preparazione dei dati, rendendolo accessibile a un’ampia gamma di utenti.

In questa demo, ti guideremo attraverso i passaggi di preparazione dei dati e ottimizzazione dei LLM, evidenziando la facilità d’uso di questi strumenti. Alla fine, avrai una comprensione più chiara di come sfruttare l’ecosistema di H2O per i tuoi progetti LLM.

Il mondo dei LLM e dell’intelligenza artificiale generativa sta evolvendo rapidamente e i contributi di H2O in questo campo lo rendono più accessibile che mai. Con modelli open-source, strumenti di deploy e framework user-friendly, puoi sfruttare la potenza dei LLM per una vasta gamma di applicazioni senza bisogno di competenze di programmazione estensive. Il futuro della generazione di contenuti e dell’interazione guidata dall’IA è qui, ed è emozionante far parte di questo viaggio trasformativo.

Introduzione a h2oGPT: Un’Interfaccia di Chat Multi-Modale

Nel mondo dell’intelligenza artificiale e dell’elaborazione del linguaggio naturale, si è assistito a un notevole sviluppo delle capacità dei modelli di linguaggio. L’avvento di GPT-3 e modelli simili ha aperto nuove possibilità nell’ambito della comprensione e generazione di testi simili a quelli umani. Tuttavia, il percorso non finisce qui. Il mondo dei modelli di linguaggio è in continua espansione e miglioramento, e uno sviluppo interessante è h2oGPT, un’interfaccia di chat multi-modale che porta il concetto di grandi modelli di linguaggio a un livello successivo.

h2oGPT è come un discendente di GPT, ma con una differenza. Invece di fare affidamento su un singolo grande modello di linguaggio, h2oGPT sfrutta la potenza di più modelli di linguaggio che operano contemporaneamente. Questo approccio fornisce agli utenti una vasta gamma di risposte e intuizioni. Quando fai una domanda, h2oGPT invia quella query a una varietà di modelli di linguaggio, tra cui Llama 2, GPT-NeoX, Falcon 40 B e altri. Ciascuno di questi modelli risponde con la propria risposta unica. Questa diversità ti consente di confrontare le risposte dei diversi modelli per trovare quella più adatta alle tue esigenze.

Ad esempio, se fai una domanda come “Che cos’è la statistica?” riceverai risposte da vari LLM all’interno di h2oGPT. Queste diverse risposte possono offrire prospettive preziose sullo stesso argomento. Questa potente funzionalità non solo è incredibilmente utile, ma anche completamente gratuita da utilizzare.

Semplificare la Curation dei Dati con LLM DataStudio

Per ottimizzare in modo efficace un grande modello di linguaggio, hai bisogno di dati curati di alta qualità. Tradizionalmente, ciò comportava l’assunzione di persone per creare manualmente prompt, raccogliere confronti e generare risposte, un processo che poteva richiedere molto tempo e lavoro. Tuttavia, h2oGPT introduce una soluzione rivoluzionaria chiamata LLM DataStudio che semplifica questo processo di cura dei dati.

LLM DataStudio ti consente di creare set di dati curati da dati non strutturati in modo semplice. Immagina di voler allenare o ottimizzare un LLM per comprendere un documento specifico, come un articolo di H2O su h2oGPT. Normalmente, dovresti leggere l’articolo e generare manualmente domande e risposte. Questo processo può essere faticoso, soprattutto con una grande quantità di dati.

Ma con LLM DataStudio, il processo diventa significativamente più semplice. Puoi caricare vari tipi di dati, come PDF, documenti Word, pagine web, dati audio e altro. Il sistema analizzerà automaticamente queste informazioni, estrarre parti di testo rilevanti e creare coppie domanda-risposta. Ciò significa che puoi creare set di dati di alta qualità senza la necessità di inserimento manuale dei dati.

Pulizia e Preparazione dei Dati senza Codifica

La pulizia e la preparazione dei dataset sono passaggi critici nella formazione di un modello di linguaggio e LLM DataStudio semplifica questa operazione senza richiedere competenze di programmazione. La piattaforma offre una serie di opzioni per pulire i tuoi dati, come la rimozione degli spazi vuoti, degli URL, delle parole volgari o il controllo della lunghezza della risposta. Ti consente anche di verificare la qualità delle domande e delle risposte. Tutto questo viene ottenuto attraverso un’interfaccia user-friendly, in modo che tu possa pulire i tuoi dati in modo efficace senza scrivere una sola riga di codice.

Inoltre, puoi arricchire i tuoi dataset con ulteriori sistemi di conversazione, domande e risposte, fornendo al tuo LLM ancora più contesto. Una volta che il tuo dataset è pronto, puoi scaricarlo in formato JSON o CSV per addestrare il tuo modello di linguaggio personalizzato.

Addestramento del tuo LLM personalizzato con H2O LLM Studio

Ora che hai il tuo dataset curato, è arrivato il momento di addestrare il tuo modello di linguaggio personalizzato e H2O LLM Studio è lo strumento che ti aiuterà a farlo. Questa piattaforma è progettata per addestrare modelli di linguaggio senza richiedere competenze di programmazione.

Il processo inizia importando il tuo dataset in LLM Studio. Specifica quali colonne contengono le domande e le risposte e la piattaforma fornisce una panoramica del tuo dataset. Successivamente, crei un esperimento, gli dai un nome e selezioni un modello di base. La scelta del modello di base dipende dal tuo caso d’uso specifico, poiché modelli diversi eccellono in diverse applicazioni. Puoi selezionare tra una serie di opzioni, ognuna con un numero variabile di parametri per soddisfare le tue esigenze.

Durante la configurazione dell’esperimento, puoi configurare parametri come il numero di epoche, l’approssimazione a basso rango, la probabilità del compito, la temperatura e altro ancora. Se non sei esperto di queste impostazioni, non preoccuparti; LLM Studio offre le migliori pratiche per guidarti. Inoltre, puoi utilizzare GPT di OpenAI come metrica per valutare le prestazioni del tuo modello, anche se sono disponibili metriche alternative come BLEU se preferisci non utilizzare API esterne.

Una volta configurato l’esperimento, puoi avviare il processo di addestramento. LLM Studio fornisce registri e grafici per aiutarti a monitorare i progressi del tuo modello. Dopo un addestramento riuscito, puoi avviare una sessione di chat con il tuo LLM personalizzato, testare le sue risposte e persino scaricare il modello per un uso successivo.

Conclusioni

In questo affascinante viaggio nel mondo dei Large Language Models (LLM) e dell’IA generativa, abbiamo scoperto il potenziale trasformativo di questi modelli. L’emergere dei LLM open-source, rappresentato dall’ecosistema di H2O, ha reso questa tecnologia più accessibile che mai. Con strumenti user-friendly, framework flessibili e modelli diversi come h2oGPT, stiamo assistendo a una rivoluzione nella generazione di contenuti e nell’interazione basata sull’IA.

h2oGPT, LLM DataStudio e H2O LLM Studio rappresentano un potente trio di strumenti che consentono agli utenti di lavorare con grandi modelli di linguaggio, curare i dati senza sforzi e addestrare modelli personalizzati senza la necessità di competenze di codifica. Questa suite completa di risorse non solo semplifica il processo, ma lo rende accessibile a un pubblico più ampio, aprendo una nuova era di comprensione e generazione di linguaggio naturale basata sull’IA. Che tu sia un esperto praticante di IA o un principiante, questi strumenti offrono l’opportunità di esplorare il mondo affascinante dei modelli di linguaggio e delle loro applicazioni.

Punti chiave:

- L’IA generativa, alimentata dai LLM, consente alle macchine di creare nuove informazioni da dati esistenti, aprendo possibilità al di là dei modelli di previsione tradizionali.

- I LLM open-source come h2oGPT forniscono soluzioni personalizzabili, trasparenti ed economiche, eliminando preoccupazioni sulla privacy e il controllo dei dati.

- L’ecosistema di H2O offre una serie di strumenti e framework, come LLM DataStudio e H2O LLM Studio, che rappresentano una soluzione no-code per l’addestramento di LLM.

Domande Frequenti

Informazioni sull’autore: Favio Vazquez

Favio Vazquez è un importante Data Scientist e Solutions Engineer presso H2O.ai, una delle più grandi piattaforme di machine learning al mondo. Vivendo in Messico, guida le operazioni in tutta l’America Latina e in Spagna. In questo ruolo, è fondamentale nello sviluppo di soluzioni all’avanguardia di data science su misura per i clienti LATAM. La sua padronanza di Python e del suo ecosistema, unita al suo controllo su H2O Driverless AI e H2O Hybrid Cloud, gli consente di creare innovative applicazioni basate sui dati. Inoltre, la sua partecipazione attiva a progetti privati e open-source solidifica ulteriormente il suo impegno nell’IA.

Pagina DataHour: https://community.analyticsvidhya.com/c/datahour/datahour-training-your-own-llm-without-coding

LinkedIn: https://www.linkedin.com/in/faviovazquez/