Sei passaggi verso la sicurezza dell’IA

6 passi per la sicurezza dell'IA

Nella scia di ChatGPT, ogni azienda sta cercando di trovare la propria strategia di intelligenza artificiale, lavoro che solleva rapidamente la domanda: e la sicurezza?

Alcuni potrebbero sentirsi sopraffatti dalla prospettiva di garantire la sicurezza di una nuova tecnologia. La buona notizia è che le politiche e le pratiche attualmente in vigore forniscono ottimi punti di partenza.

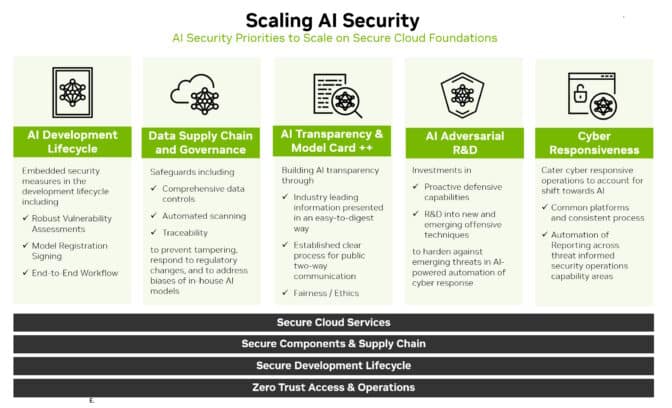

Infatti, la strada da seguire consiste nell’estendere le fondamenta esistenti della sicurezza aziendale e cloud. È un percorso che può essere riassunto in sei passaggi:

- Ampliare l’analisi delle minacce

- Allargare i meccanismi di risposta

- Proteggere la catena di fornitura dei dati

- Utilizzare l’intelligenza artificiale per ampliare gli sforzi

- Essere trasparenti

- Creare miglioramenti continui

Abbraccia l’Orizzonte Ampliato

Il primo passo è familiarizzare con il nuovo scenario.

- Utilizzare SQL per comprendere le tendenze della carriera della scienza dei dati

- Generazione di AI testo-musica Audio di stabilità, MusicLM di Google e altro

- Una guida passo passo per rilevare in modo accurato picchi e valli.

Ora la sicurezza deve coprire l’intero ciclo di sviluppo dell’intelligenza artificiale. Questo include nuove superfici di attacco come i dati di addestramento, i modelli e le persone e i processi che li utilizzano.

Estrapolare dai tipi conosciuti di minacce per identificare e prevedere quelle emergenti. Ad esempio, un attaccante potrebbe cercare di alterare il comportamento di un modello di intelligenza artificiale accedendo ai dati mentre il modello viene addestrato su un servizio cloud.

I ricercatori sulla sicurezza e i team di attacco simulato che hanno analizzato le vulnerabilità in passato saranno nuovamente ottime risorse. Avranno bisogno di accesso ai sistemi di intelligenza artificiale e ai dati per identificare e agire sulle nuove minacce, nonché per aiutare a costruire solide relazioni di lavoro con il personale di data science.

Allargare le Difese

Una volta chiaro il quadro delle minacce, definire modi per difendersi da esse.

Monitorare attentamente le prestazioni del modello di intelligenza artificiale. Assumere che subirà variazioni, aprendo nuove superfici di attacco, così come si può presumere che le difese di sicurezza tradizionali saranno violate.

Inoltre, basarsi sulle pratiche del PSIRT (team di risposta agli incidenti di sicurezza del prodotto) che dovrebbero già essere in atto.

Ad esempio, NVIDIA ha pubblicato politiche di sicurezza del prodotto che comprendono il suo portfolio di intelligenza artificiale. Diverse organizzazioni, tra cui l’Open Worldwide Application Security Project, hanno rilasciato implementazioni specifiche per l’intelligenza artificiale di elementi chiave della sicurezza, come il metodo di enumerazione delle vulnerabilità comune utilizzato per identificare le minacce informatiche tradizionali.

Adattare e applicare ai modelli e ai flussi di lavoro di intelligenza artificiale difese tradizionali come:

- Mantenere separati il controllo di rete e i piani di dati

- Rimuovere qualsiasi dato non sicuro o di identificazione personale

- Utilizzare la sicurezza e l’autenticazione a base di zero trust

- Definire registri eventi, avvisi e test appropriati

- Impostare controlli di flusso quando opportuno

Estendere le Salvaguardie Esistenti

Proteggere i dataset utilizzati per addestrare i modelli di intelligenza artificiale. Sono preziosi e vulnerabili.

Ancora una volta, le aziende possono sfruttare le pratiche esistenti. Creare catene di fornitura dei dati sicure, simili a quelle create per garantire canali di distribuzione sicuri per il software. È importante stabilire il controllo degli accessi per i dati di addestramento, proprio come avviene per gli altri dati interni.

Alcune lacune potrebbero dover essere colmate. Oggi, gli specialisti della sicurezza sanno come utilizzare i file hash delle applicazioni per garantire che nessuno abbia modificato il loro codice. Tale processo potrebbe essere difficile da scalare per dataset di dimensioni petabyte utilizzati per l’addestramento dell’intelligenza artificiale.

La buona notizia è che i ricercatori ne riconoscono la necessità e stanno lavorando su strumenti per affrontarla.

Amplia la Sicurezza con l’Intelligenza Artificiale

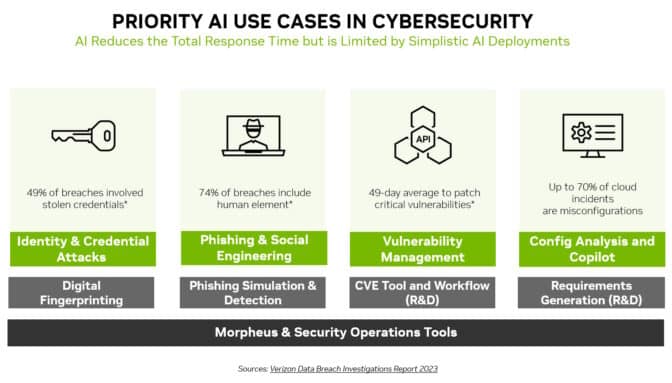

L’intelligenza artificiale non è solo una nuova area di attacco da difendere, ma anche un nuovo e potente strumento di sicurezza.

I modelli di machine learning possono rilevare cambiamenti sottili che nessun essere umano può percepire in enormi quantità di traffico di rete. Ciò rende l’intelligenza artificiale una tecnologia ideale per prevenire molti degli attacchi più diffusi, come il furto di identità, il phishing, il malware e il ransomware.

NVIDIA Morpheus, un framework per la sicurezza informatica, può creare applicazioni di intelligenza artificiale che creano, leggono e aggiornano impronte digitali digitali che scansionano molte tipologie di minacce. Inoltre, l’intelligenza artificiale generativa e Morpheus possono consentire nuovi modi per rilevare tentativi di spear phishing.

La Sicurezza Ama la Chiarezza

La trasparenza è un componente chiave di qualsiasi strategia di sicurezza. Informate i clienti su eventuali nuove politiche e pratiche di sicurezza dell’intelligenza artificiale che sono state adottate.

Ad esempio, NVIDIA pubblica dettagli sui modelli di intelligenza artificiale in NGC, la sua piattaforma per il software accelerato. Chiamate model cards, agiscono come dichiarazioni di verità nel prestito, descrivendo le intelligenze artificiali, i dati su cui sono state addestrate e eventuali vincoli per il loro utilizzo.

NVIDIA utilizza un insieme esteso di campi nei suoi model cards, in modo che gli utenti siano chiari sulla storia e i limiti di una rete neurale prima di metterla in produzione. Ciò aiuta a migliorare la sicurezza, stabilire la fiducia e garantire che i modelli siano robusti.

Definire Viaggi, Non Destinazioni

Questi sei passaggi sono solo l’inizio di un viaggio. Processi e politiche come questi devono evolversi.

La pratica emergente della computazione confidenziale, ad esempio, sta estendendo la sicurezza nei servizi cloud dove i modelli di intelligenza artificiale vengono spesso addestrati ed eseguiti in produzione.

L’industria sta già cominciando a vedere versioni di base di scanner di codice per modelli di intelligenza artificiale. Sono un segno di ciò che verrà. Le squadre devono tenere d’occhio l’orizzonte per le migliori pratiche e gli strumenti man mano che arrivano.

lungo il percorso, la comunità ha bisogno di condividere ciò che impara. Un eccellente esempio di ciò è avvenuto nell’ambito della recente Generative Red Team Challenge.

Alla fine, si tratta di creare una difesa collettiva. Stiamo tutti facendo questo viaggio verso la sicurezza dell’intelligenza artificiale insieme, un passo alla volta.