Utilizzare la conoscenza del contesto sociale per favorire l’applicazione responsabile dell’IA

Usare il contesto sociale per l'applicazione responsabile dell'IA

Pubblicato da Donald Martin, Jr., Program Manager Tecnico, Responsabile degli Strumenti e delle Soluzioni per la Comprensione del Contesto Sociale (SCOUTS), Google Research

I prodotti e le tecnologie legati all’IA sono costruiti e implementati in un contesto sociale: ovvero, una raccolta dinamica e complessa di circostanze sociali, culturali, storiche, politiche ed economiche. Poiché i contesti sociali sono per natura dinamici, complessi, non lineari, controversi, soggettivi e altamente qualitativi, è difficile tradurli nelle rappresentazioni quantitative, nei metodi e nelle pratiche che dominano gli approcci standard di apprendimento automatico (ML) e le pratiche di sviluppo responsabile dei prodotti di intelligenza artificiale.

La prima fase dello sviluppo di un prodotto di intelligenza artificiale è la comprensione del problema, e questa fase ha un’influenza enorme su come i problemi (ad esempio, l’aumento della disponibilità e dell’accuratezza degli screening per il cancro) vengono formulati per essere risolti dai sistemi di ML, così come molte altre decisioni successive, come la scelta del dataset e dell’architettura di ML. Quando il contesto sociale in cui un prodotto opererà non viene sufficientemente articolato e compreso per ottenere una solida comprensione del problema, le soluzioni di ML risultanti possono essere fragili e persino propagare pregiudizi ingiusti.

Quando gli sviluppatori di prodotti di intelligenza artificiale non hanno accesso alle conoscenze e agli strumenti necessari per comprendere e considerare in modo efficace il contesto sociale durante lo sviluppo, tendono a semplificarlo. Questa semplificazione li porta a una comprensione superficiale e quantitativa dei problemi che cercano di risolvere, mentre gli utenti del prodotto e gli stakeholder della società – che sono vicini a questi problemi e immersi in contesti sociali correlati – tendono ad avere una profonda comprensione qualitativa degli stessi problemi. Questa divergenza qualitativa-quantitativa nel modo di comprendere problemi complessi che separa gli utenti del prodotto e la società dagli sviluppatori è ciò che chiamiamo “il divario nella comprensione del problema”.

- Una nuova ricerca sull’IA da KAIST presenta FLASK un framework di valutazione dettagliata per modelli di linguaggio basato su set di abilità

- Framework di AI guidato dall’uomo promette un apprendimento robotico più rapido in ambienti nuovi

- Incontra DifFace un nuovo modello di diffusione di deep learning per il ripristino cieco del volto.

Questo divario ha ripercussioni nel mondo reale: ad esempio, è stata la causa principale del pregiudizio razziale scoperto da un ampio algoritmo sanitario utilizzato per risolvere il problema della scelta dei pazienti con le esigenze di salute più complesse per programmi speciali. Una comprensione incompleta del contesto sociale in cui l’algoritmo avrebbe operato ha portato i progettisti di sistema a formulare teorie causali errate e semplificate su quali fossero i fattori chiave del problema. Fattori socio-strutturali critici, come la mancanza di accesso alle cure mediche, la mancanza di fiducia nel sistema sanitario e la sottodiagnosi a causa di pregiudizi umani, sono stati trascurati, mentre la spesa sanitaria è stata evidenziata come un indicatore delle necessità di salute complesse.

Per superare in modo responsabile il divario nella comprensione del problema, gli sviluppatori di prodotti di intelligenza artificiale hanno bisogno di strumenti che mettano a loro disposizione la conoscenza strutturata e convalidata dalla comunità sul contesto sociale dei problemi complessi della società, a partire dalla comprensione del problema, ma anche lungo tutto il ciclo di sviluppo del prodotto. A tal fine, Societal Context Understanding Tools and Solutions (SCOUTS) – parte del team Responsible AI and Human-Centered Technology (RAI-HCT) all’interno di Google Research – è un team di ricerca dedicato alla missione di “fornire alle persone la conoscenza scalabile e affidabile del contesto sociale necessaria per realizzare intelligenza artificiale responsabile e robusta e risolvere i problemi sociali più complessi del mondo”. SCOUTS è motivato dalla sfida significativa di articolare il contesto sociale e conduce ricerche innovative fondamentali e applicate per produrre conoscenza strutturata del contesto sociale e integrarla in tutte le fasi del ciclo di sviluppo dei prodotti legati all’IA. Lo scorso anno abbiamo annunciato che Jigsaw, l’incubatore di Google per la costruzione di tecnologie che esplorano soluzioni alle minacce alle società aperte, ha utilizzato il nostro approccio strutturato alla conoscenza del contesto sociale durante le fasi di preparazione dei dati e valutazione dello sviluppo del modello per mitigare il pregiudizio nel loro ampiamente utilizzato classificatore di tossicità Perspective API. In futuro, l’agenda di ricerca di SCOUTS si concentrerà sulla fase di comprensione del problema dello sviluppo di prodotti legati all’IA con l’obiettivo di superare il divario nella comprensione del problema.

Superare il divario nella comprensione del problema dell’IA

Superare il divario nella comprensione del problema dell’IA richiede due ingredienti chiave: 1) un quadro di riferimento per organizzare la conoscenza strutturata del contesto sociale e 2) metodi partecipativi e non estrattivi per ottenere l’esperienza della comunità sui problemi complessi e rappresentarla come conoscenza strutturata. SCOUTS ha pubblicato ricerche innovative in entrambe le aree.

| Un’illustrazione del divario nella comprensione del problema. |

Un quadro di riferimento per il contesto sociale

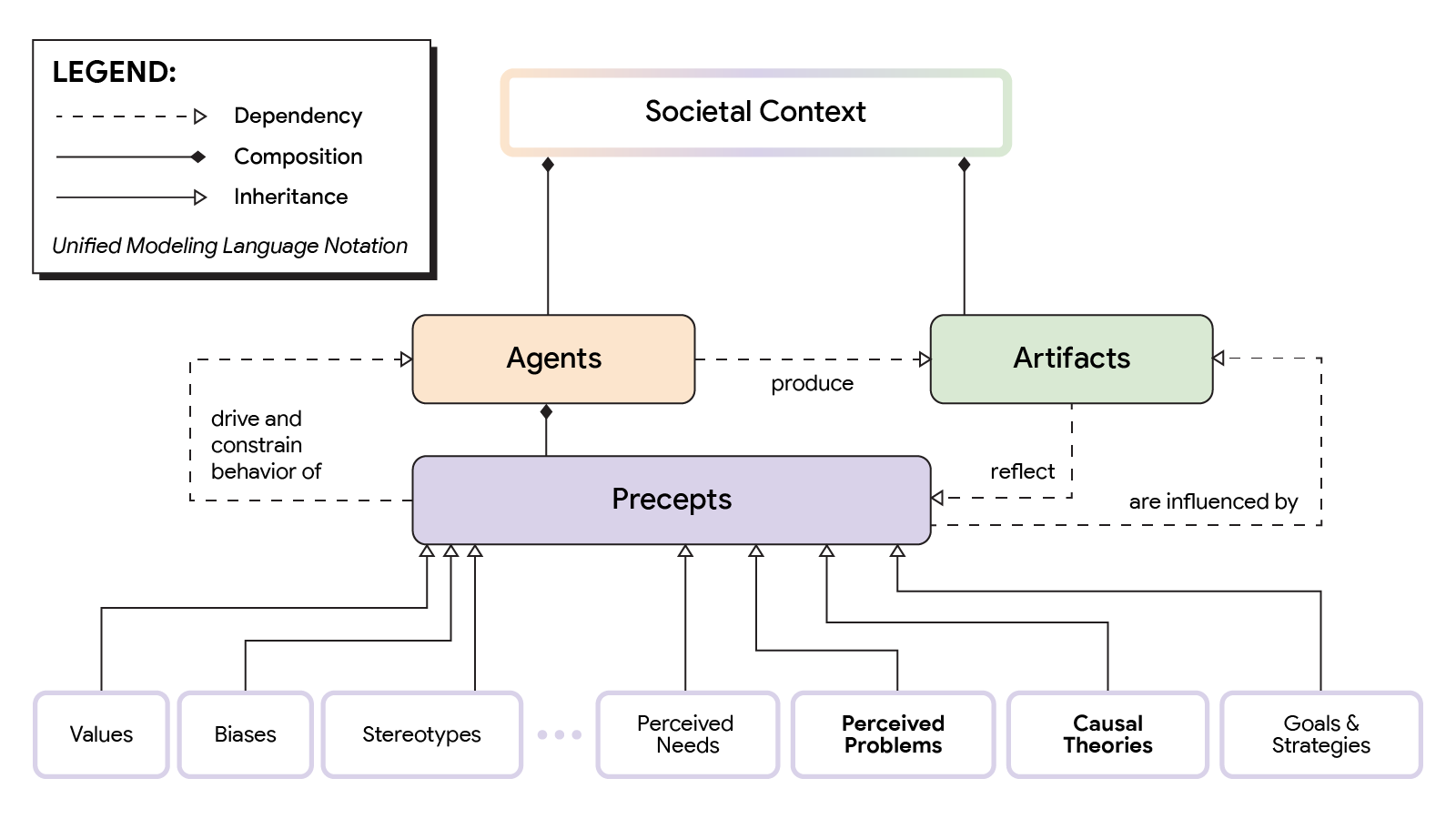

Un ingrediente essenziale per produrre conoscenza strutturata è una tassonomia per creare la struttura per organizzarla. SCOUTS ha collaborato con altri team RAI-HCT (TasC, Impact Lab), Google DeepMind e esperti esterni di dinamica dei sistemi per sviluppare un quadro di riferimento tassonomico per il contesto sociale. Per affrontare la natura complessa, dinamica e adattiva del contesto sociale, sfruttiamo la teoria dei sistemi adattivi complessi (CAS) per proporre un modello tassonomico di alto livello per organizzare la conoscenza del contesto sociale. Il modello individua tre elementi chiave del contesto sociale e i cicli di feedback dinamici che li legano insieme: agenti, preconcetti e artefatti.

- Agenti: Questi possono essere individui o istituzioni.

- Preconcetti: Le preconcetti, inclusi credenze, valori, stereotipi e pregiudizi, che limitano e guidano il comportamento degli agenti. Un esempio di preconcetto di base è che “tutti i giocatori di pallacanestro sono alti più di 1,80 metri”. Quell’assunzione limitante può portare a errori nell’identificazione dei giocatori di pallacanestro di statura più piccola.

- Artefatti: I comportamenti degli agenti producono molti tipi di artefatti, inclusi linguaggio, dati, tecnologie, problemi sociali e prodotti.

Le relazioni tra queste entità sono dinamiche e complesse. Il nostro lavoro ipotizza che i precetti siano l’elemento più critico del contesto sociale e mettiamo in evidenza i problemi che le persone percepiscono e le teorie causali che hanno su perché quei problemi esistono come precetti particolarmente influenti che sono fondamentali per comprendere il contesto sociale. Ad esempio, nel caso del pregiudizio razziale in un algoritmo medico descritto in precedenza, il precetto teoria causale detenuta dai progettisti era che i problemi di salute complessi avrebbero fatto aumentare le spese sanitarie per tutte le popolazioni. Quel precetto errato ha portato direttamente alla scelta delle spese sanitarie come variabile proxy per il modello per prevedere il bisogno di cure sanitarie complesse, il che a sua volta ha portato al modello essere di parte contro i pazienti di colore che, a causa di fattori sociali come la mancanza di accesso alle cure sanitarie e la sottodiagnosi dovuta al pregiudizio in media, non sempre spendono di più per le cure sanitarie quando hanno bisogno di cure sanitarie complesse. Una domanda chiave aperta è come possiamo estrarre eticamente ed equamente teorie causali dalle persone e dalle comunità che sono più prossime ai problemi di disuguaglianza e trasformarle in conoscenze strutturate utili?

|

| Versione illustrativa del quadro di riferimento del contesto sociale. |

|

| Versione tassonomica del quadro di riferimento del contesto sociale. |

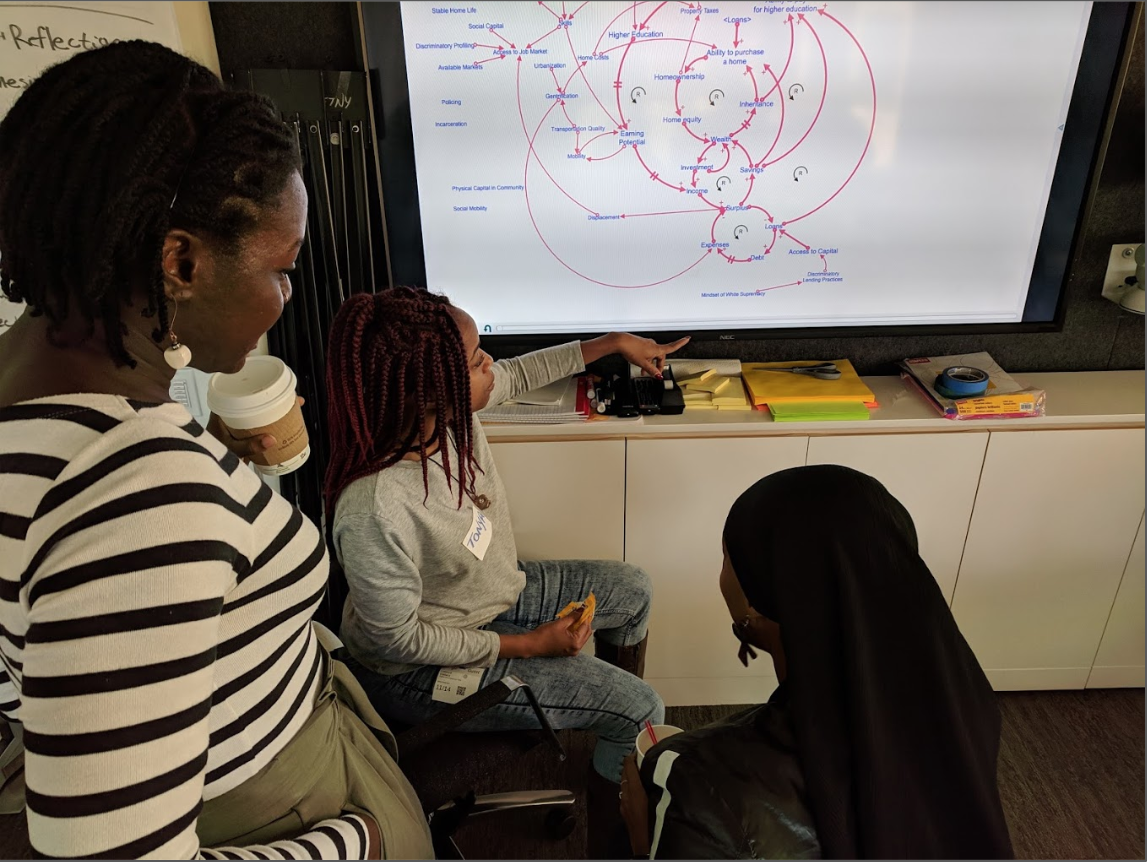

Lavorare con le comunità per promuovere l’applicazione responsabile dell’IA alle cure sanitarie

Dal suo inizio, SCOUTS ha lavorato per sviluppare la capacità nelle comunità storicamente emarginate di articolare il contesto sociale più ampio dei problemi complessi che sono importanti per loro utilizzando una pratica chiamata dinamica dei sistemi basata sulla comunità (CBSD). La dinamica dei sistemi (SD) è una metodologia per articolare teorie causali su problemi complessi, sia in modo qualitativo come diagrammi di loop causali e flusso di stock (CLD e SFD, rispettivamente) sia in modo quantitativo come modelli di simulazione. Il supporto intrinseco di strumenti qualitativi visivi, metodi quantitativi e costruzione collaborativa di modelli lo rende un ingrediente ideale per colmare il divario di comprensione del problema. CBSD è una variante basata sulla comunità e partecipativa di SD specificamente incentrata sulla sviluppo della capacità all’interno delle comunità di descrivere e modellizzare in modo collaborativo i problemi che affrontano come teorie causali, direttamente senza intermediari. Con CBSD abbiamo visto gruppi comunitari imparare le basi e iniziare a disegnare CLD entro 2 ore.

|

| Membri della comunità Data 4 Black Lives che imparano la dinamica dei sistemi. |

C’è un enorme potenziale per l’IA nel migliorare la diagnosi medica. Ma la sicurezza, l’equità e l’affidabilità degli algoritmi di diagnosi sanitaria legati all’IA dipendono da set di dati di allenamento diversificati ed equilibrati. Una sfida aperta nello spazio della diagnosi sanitaria è la mancanza di campioni di dati di allenamento provenienti da gruppi storicamente emarginati. SCOUTS ha collaborato con la comunità Data 4 Black Lives ed esperti CBSD per produrre teorie causali qualitative e quantitative per il problema della mancanza di dati. Le teorie includono fattori critici che compongono il contesto sociale più ampio che circonda la diagnosi sanitaria, tra cui la memoria culturale della morte e la fiducia nelle cure mediche.

La figura qui sotto rappresenta la teoria causale generata durante la collaborazione descritta sopra come un CLD. Ipotizza che la fiducia nelle cure mediche influenzi tutte le parti di questo sistema complesso e sia la leva chiave per aumentare lo screening, che a sua volta genera dati per superare il divario di diversità dei dati.

|

|

| Diagramma a loop causale del divario dei dati diagnostici sanitari |

Queste teorie causali provenienti dalla comunità sono un primo passo per colmare il divario di comprensione del problema con conoscenze affidabili sul contesto sociale.

Conclusione

Come discusso in questo blog, il divario di comprensione del problema è una sfida aperta critica nell’IA responsabile. SCOUTS conduce ricerche esplorative e applicate in collaborazione con altri team all’interno di Google Research, comunità esterne e partner accademici in molteplici discipline per fare progressi significativi nella sua risoluzione. Nel futuro, il nostro lavoro si concentrerà su tre elementi chiave, guidati dai nostri Principi di IA:

- Aumentare la consapevolezza e la comprensione del divario di comprensione del problema e delle sue implicazioni attraverso conferenze, pubblicazioni e formazione.

- Condurre ricerche fondamentali e applicate per rappresentare e integrare la conoscenza del contesto sociale nello sviluppo di strumenti e flussi di lavoro per lo sviluppo di prodotti di IA, dalla concezione al monitoraggio, valutazione e adattamento.

- Applicare metodi di modellazione causale basati sulla comunità nel campo dell’equità sanitaria nell’IA per ottenere un impatto e costruire la capacità della società e di Google di produrre e sfruttare conoscenze sul contesto sociale su scala globale per realizzare un’IA responsabile.

|

| Flywheel SCOUTS per colmare il divario di comprensione del problema. |

Riconoscimenti

Grazie a John Guilyard per lo sviluppo grafico, a tutti in SCOUTS e a tutti i nostri collaboratori e sponsor.