RT-2 Il nuovo modello traduce la visione e il linguaggio in azione

RT-2, il nuovo modello di traduzione visione-linguaggio in azione

Robotic Transformer 2 (RT-2) è un nuovo modello visione-linguaggio-azione (VLA) che impara sia dai dati web che dai dati robotici, e traduce questa conoscenza in istruzioni generalizzate per il controllo robotico.

I modelli visione-linguaggio ad alta capacità (VLM) vengono addestrati su dataset di dimensioni web, rendendo questi sistemi straordinariamente bravi nel riconoscere modelli visivi o linguistici e nell’operare in diverse lingue. Ma affinché i robot raggiungano un livello di competenza simile, dovrebbero raccogliere dati robotici di prima mano su ogni oggetto, ambiente, compito e situazione.

Nel nostro articolo, presentiamo Robotic Transformer 2 (RT-2), un nuovo modello visione-linguaggio-azione (VLA) che impara sia dai dati web che dai dati robotici, e traduce questa conoscenza in istruzioni generalizzate per il controllo robotico, mantenendo allo stesso tempo le capacità di scala web.

Questo lavoro si basa su Robotic Transformer 1 (RT-1), un modello addestrato su dimostrazioni multi-task, che può imparare combinazioni di compiti e oggetti presenti nei dati robotici. In particolare, il nostro lavoro ha utilizzato dati di dimostrazione robotica di RT-1 raccolti con 13 robot nel corso di 17 mesi in un ambiente di cucina per ufficio.

- I migliori generatori d’arte basati su intelligenza artificiale AI nel 2023

- Incontra il modello GOAT-7B-Community un modello AI raffinato Fine-Tuned LLaMA-2 7B sul dataset raccolto dall’app GoatChat

- FraudGPT L’allarmante aumento degli strumenti di cybercrimine alimentati dall’IA

RT-2 mostra capacità di generalizzazione migliorate e comprensione semantica e visiva al di là dei dati robotici a cui è stato esposto. Ciò include l’interpretazione di nuovi comandi e la risposta ai comandi dell’utente eseguendo un ragionamento rudimentale, come il ragionamento sulle categorie degli oggetti o le descrizioni di alto livello.

Dimostriamo anche che l’incorporazione del ragionamento a catena di pensiero consente a RT-2 di eseguire un ragionamento semantico multi-stadio, come decidere quale oggetto potrebbe essere usato come martello improvvisato (una pietra), o quale tipo di bevanda è migliore per una persona stanca (una bevanda energetica).

Adattamento dei VLM per il controllo robotico

RT-2 si basa sui VLM che prendono in input una o più immagini e producono una sequenza di token che, convenzionalmente, rappresentano testo in linguaggio naturale. Tali VLM sono stati addestrati con successo su dati di scala web per svolgere compiti come rispondere a domande visive, creare didascalie per immagini o riconoscere oggetti. Nel nostro lavoro, adattiamo il modello Pathways Language and Image (PaLI-X) e il modello Pathways Language model Embodied (PaLM-E) per fungere da base per RT-2.

Per controllare un robot, è necessario addestrarlo a produrre azioni in output. Affrontiamo questa sfida rappresentando le azioni come token nell’output del modello – simili ai token linguistici – e descrivendo le azioni come stringhe che possono essere elaborate da normali tokenizzatori di linguaggio naturale, come mostrato qui:

La stringa inizia con un flag che indica se continuare o terminare l’episodio corrente, senza eseguire i comandi successivi, e prosegue con i comandi per cambiare la posizione e la rotazione dell’effettore terminale, nonché l’estensione desiderata della pinza del robot.

Utilizziamo la stessa versione discretizzata delle azioni del robot come in RT-1, e dimostriamo che convertirla in una rappresentazione di stringa rende possibile addestrare modelli VLM sui dati robotici, in quanto gli spazi di input e output di tali modelli non devono essere modificati.

Generalizzazione e abilità emergenti

Abbiamo effettuato una serie di esperimenti qualitativi e quantitativi sui nostri modelli RT-2, su oltre 6.000 prove robotiche. Esplorando le capacità emergenti di RT-2, abbiamo prima cercato compiti che richiedessero la combinazione di conoscenze provenienti da dati di scala web e dall’esperienza del robot, e poi abbiamo definito tre categorie di abilità: comprensione dei simboli, ragionamento e riconoscimento umano.

Ogni compito richiedeva la comprensione di concetti visivo-semantici e la capacità di controllare il robot per operare su questi concetti. Comandi come “prendi la borsa che sta per cadere dal tavolo” o “sposta la banana alla somma di due più uno” – in cui al robot viene chiesto di eseguire un compito di manipolazione su oggetti o situazioni mai visti nei dati robotici – richiedevano conoscenze tradotte da dati basati sul web per poter operare.

In tutte le categorie, abbiamo osservato un miglioramento delle prestazioni di generalizzazione (più del triplo) rispetto a basi precedenti, come modelli RT-1 precedenti e modelli come Visual Cortex (VC-1), che sono stati pre-allenati su grandi dataset visivi.

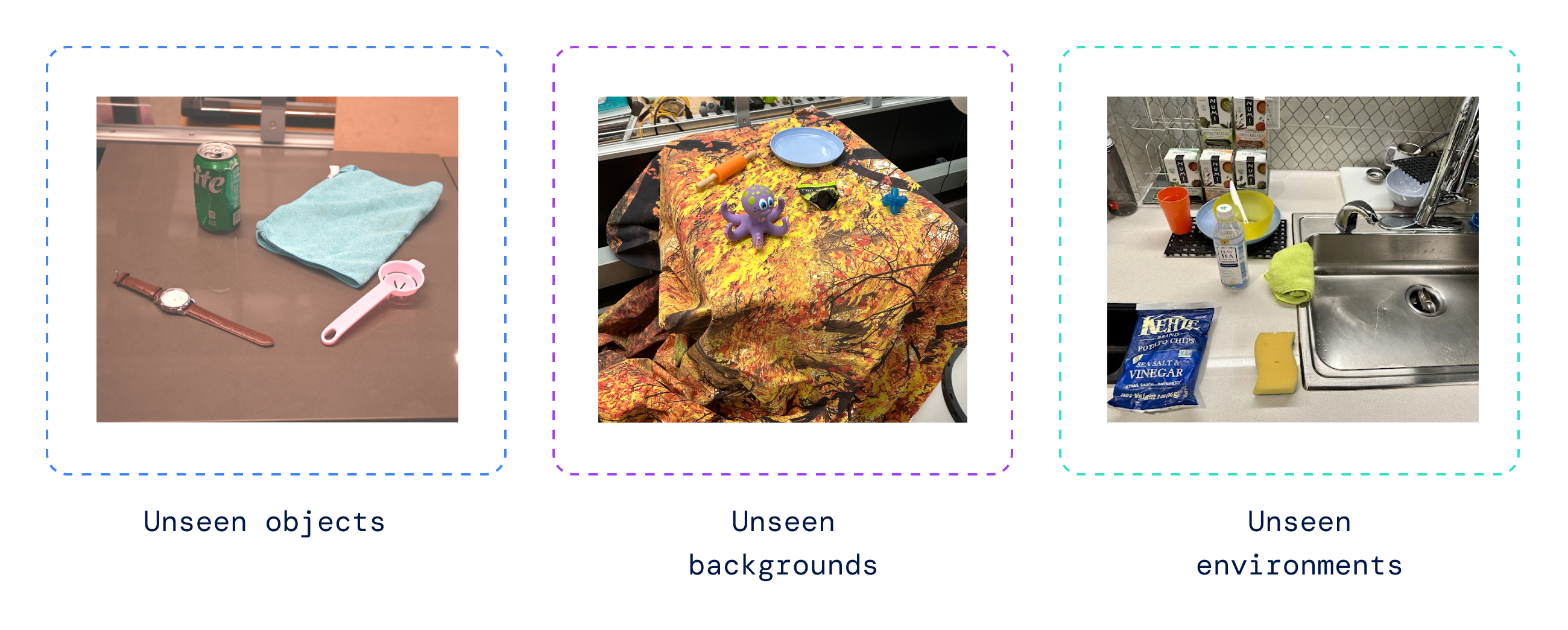

Abbiamo anche effettuato una serie di valutazioni quantitative, a partire dai compiti originali di RT-1, per i quali abbiamo degli esempi nei dati del robot, e abbiamo continuato con gradi variabili di oggetti, sfondi e ambienti precedentemente non visti dal robot, che richiedevano al robot di imparare la generalizzazione dal pre-training di VLM.

RT-2 ha mantenuto le prestazioni sui compiti originali presenti nei dati del robot e ha migliorato le prestazioni su scenari precedentemente non visti dal robot, passando dal 32% di RT-1 al 62%, mostrando i considerevoli vantaggi del pre-training su larga scala.

Inoltre, abbiamo osservato miglioramenti significativi rispetto a basi pre-allenate su compiti solo visivi, come VC-1 e R3M (Rappresentazioni Riutilizzabili per la Manipolazione Robotica), e algoritmi che utilizzano VLM per l’identificazione degli oggetti, come MOO (Manipolazione di Oggetti nel Mondo Aperto).

Valutando il nostro modello sulla suite di compiti robotici open-source Language Table, abbiamo ottenuto un tasso di successo del 90% nella simulazione, migliorando notevolmente rispetto alle basi precedenti, tra cui BC-Z (72%), RT-1 (74%) e LAVA (77%).

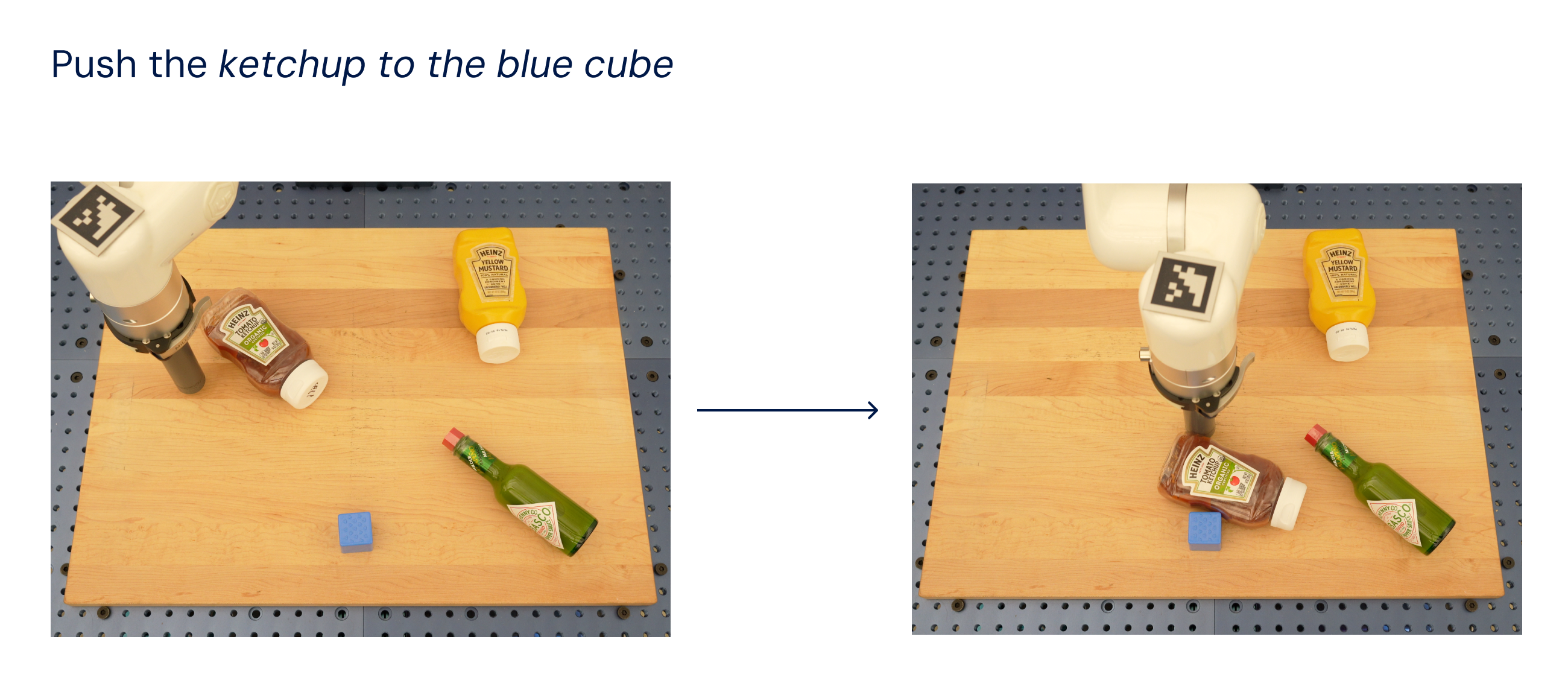

In seguito abbiamo valutato lo stesso modello nel mondo reale (dato che era stato addestrato su dati di simulazione e reali) e abbiamo dimostrato la sua capacità di generalizzare a oggetti nuovi, come mostrato di seguito, dove nessuno degli oggetti tranne il cubo blu era presente nel dataset di addestramento.

Ispirati dai metodi di prompting di catena di pensiero utilizzati negli LLM, abbiamo sondato i nostri modelli per combinare il controllo robotico con il ragionamento di catena di pensiero per consentire di apprendere la pianificazione a lungo termine e le competenze a basso livello all’interno di un singolo modello.

In particolare, abbiamo ottimizzato una variante di RT-2 per alcune centinaia di passi di gradiente per aumentare la sua capacità di utilizzare il linguaggio e le azioni in modo congiunto. Poi abbiamo ampliato i dati per includere un passaggio “Piano” aggiuntivo, descrivendo prima lo scopo dell’azione che il robot sta per compiere in linguaggio naturale, seguito da “Azione” e dai token di azione. Qui mostriamo un esempio di tale ragionamento e il comportamento risultante del robot:

Con questo processo, RT-2 può eseguire comandi più complessi che richiedono il ragionamento sulle fasi intermedie necessarie per completare un’istruzione dell’utente. Grazie alla sua struttura di base VLM, RT-2 può anche pianificare sia da comandi di immagini che di testo, consentendo una pianificazione basata su immagini, mentre approcci attuali di pianificazione e azione come SayCan non possono vedere il mondo reale e si affidano interamente al linguaggio.

Avanzamento del controllo robotico

RT-2 mostra che i modelli visione-linguaggio (VLM) possono essere trasformati in potenti modelli visione-linguaggio-azione (VLA), in grado di controllare direttamente un robot combinando il pre-addestramento VLM con i dati robotici.

Con due istanziazioni di VLA basate su PaLM-E e PaLI-X, RT-2 produce politiche robotiche altamente migliorate e, cosa più importante, porta a prestazioni di generalizzazione significativamente migliori e a capacità emergenti, ereditate dal pre-addestramento VLM su larga scala.

RT-2 non è solo una semplice ed efficace modifica rispetto ai modelli VLM esistenti, ma mostra anche la promessa di costruire un robot fisico a uso generale in grado di ragionare, risolvere problemi e interpretare informazioni per svolgere una vasta gamma di compiti nel mondo reale.

Leggi il nostro articolo: https://robotics-transformer2.github.io/assets/rt2.pdf

Scopri di più su Keyword: https://blog.google/technology/ai/google-deepmind-rt2-robotics-vla-model/