Incontra AnomalyGPT un nuovo approccio di IAD basato su modelli visione-linguaggio di grande dimensione (LVLM) per rilevare anomalie industriali.

Incontra AnomalyGPT un nuovo approccio di IAD basato su LVLM per rilevare anomalie industriali.

In vari compiti di Elaborazione del Linguaggio Naturale (NLP), i grandi modelli di linguaggio (LLM) come GPT-3.5 e LLaMA hanno mostrato prestazioni eccezionali. La capacità dei LLM di interpretare informazioni visive è stata recentemente ampliata da tecniche all’avanguardia come MiniGPT-4, BLIP-2 e PandaGPT, mediante l’allineamento degli aspetti visivi con le caratteristiche del testo, aprendo così la strada a un’enorme trasformazione nel campo dell’intelligenza artificiale generale (AGI). Il potenziale dei LVLM in compiti di IAD è limitato nonostante siano stati preaddestrati su grandi quantità di dati ottenuti da Internet. Inoltre, la loro conoscenza specifica del dominio è solo moderatamente sviluppata e hanno bisogno di una maggiore sensibilità alle caratteristiche locali all’interno degli oggetti. L’assegnazione di IAD cerca di individuare e individuare anomalie nelle fotografie di prodotti industriali.

I modelli devono essere addestrati solo su campioni normali per identificare campioni anomali che si discostano dai campioni normali, poiché gli esempi del mondo reale sono rari e imprevedibili. La maggior parte dei sistemi IAD attuali offre solo punteggi di anomalia per i campioni di prova e richiede la definizione manuale dei criteri per distinguere le istanze normali da quelle anomale per ciascuna classe di oggetti, rendendoli inadatti per le impostazioni di produzione effettive. I ricercatori dell’Accademia Cinese delle Scienze, dell’Università dell’Accademia Cinese delle Scienze, della Objecteye Inc. e del Wuhan AI Research presentano AnomalyGPT, una metodologia IAD unica basata su LVLM, come mostrato nella Figura 1, poiché né gli approcci IAD esistenti né i LVLM possono gestire adeguatamente il problema IAD. Senza richiedere regolazioni manuali della soglia, AnomalyGPT può identificare anomalie e le relative posizioni.

Inoltre, il loro approccio può offrire informazioni sull’immagine e promuovere l’interazione interattiva, consentendo agli utenti di porre domande di approfondimento in base alle loro esigenze e risposte. Con solo alcuni campioni normali, AnomalyGPT può anche apprendere nel contesto, consentendo un rapido adattamento ai nuovi oggetti. Ottimizzano il LVLM utilizzando dati sintetizzati anomali visivo-testuali e incorporando competenze IAD. Tuttavia, è necessario migliorare l’addestramento diretto utilizzando dati IAD. La scarsità di dati è il primo problema. Preaddestrato su 160.000 foto con relative conversazioni a più turni, inclusi tecniche come LLaVA e PandaGPT. Tuttavia, le dimensioni dei campioni delle attuali raccolte di dati IAD rendono l’addestramento diretto vulnerabile all’overfitting e all’oblio catastrofico.

- Questo articolo di ricerca sull’IA presenta un’ampia panoramica del Deep Learning per la localizzazione visuale e la mappatura

- Sfrutta il potere di LLM Prompting senza shot e con pochi shot

- L’icona dell’horror Stephen King non ha paura dell’IA

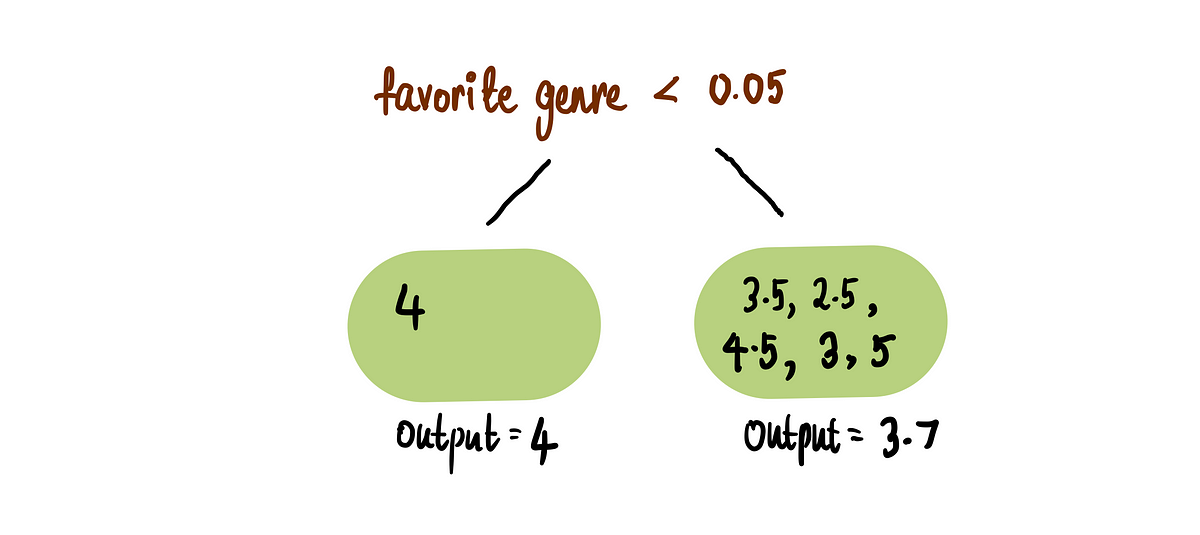

Per risolvere questo problema, raffinano il LVLM utilizzando embedding delle istruzioni anziché il raffinamento dei parametri. Dopo gli input dell’immagine, vengono inseriti ulteriori embedding delle istruzioni, aggiungendo ulteriori informazioni IAD al LVLM. Il secondo problema riguarda la semantica dettagliata. Suggeriscono un decoder basato sul confronto di caratteristiche visivo-testuali semplice per ottenere risultati di localizzazione delle anomalie a livello di pixel. Le uscite del decoder sono rese disponibili al LVLM e alle immagini di prova originali tramite embedding delle istruzioni. Ciò consente al LVLM di utilizzare sia l’immagine grezza che le uscite del decoder per identificare anomalie, aumentando la precisione delle sue valutazioni. Effettuano esperimenti completi sui database MVTec-AD e VisA.

Raggiungono un’accuratezza del 93,3%, un’area sotto la curva (AUC) a livello di immagine del 97,4% e un’area sotto la curva (AUC) a livello di pixel del 93,1% con addestramento non supervisionato sul dataset MVTec-AD. Raggiungono un’accuratezza del 77,4%, un’area sotto la curva (AUC) a livello di immagine dell’87,4% e un’area sotto la curva (AUC) a livello di pixel del 96,2% quando un singolo campione viene trasferito al dataset VisA. D’altra parte, il trasferimento di un singolo campione dal dataset VisA al dataset MVTec-AD seguendo l’addestramento non supervisionato produce un’accuratezza dell’86,1%, un’area sotto la curva (AUC) a livello di immagine del 94,1% e un’area sotto la curva (AUC) a livello di pixel del 95,3%.

Di seguito è riassunto il loro contributo:

• Presentano l’uso innovativo di LVLM per gestire il servizio di IAD. Il loro approccio facilita discussioni a più round e rileva e localizza anomalie senza regolazioni manuali delle soglie. Il decodificatore del loro lavoro, leggero e basato sul matching di caratteristiche visive e testuali, affronta la limitazione di LLM nella distinzione di semantica dettagliata. Allevia il vincolo dell’abilità limitata di LLM di generare output di testo. Secondo la loro conoscenza, sono i primi a utilizzare LVLM con successo per la rilevazione di anomalie industriali.

• Per preservare le capacità intrinseche di LVLM e consentire conversazioni a più turni, allenano il loro modello contemporaneamente ai dati utilizzati durante il pre-training di LVLM e utilizzano embedding di prompt per il fine-tuning.

• Il loro approccio mantiene una forte trasferibilità ed è in grado di apprendere in pochi esempi contestuali su nuovi set di dati, ottenendo risultati eccellenti.