Il team di hacker etici di Google rendere l’IA più sicura

Il team di hacker etici di Google rende l'IA più sicura.

Il mese scorso abbiamo introdotto il Framework AI Sicuro (SAIF), progettato per contribuire ad affrontare i rischi dei sistemi AI e guidare gli standard di sicurezza per la tecnologia in modo responsabile.

Per sfruttare questo slancio, oggi pubblichiamo un nuovo rapporto per esplorare una capacità critica che implementiamo per supportare SAIF: il red teaming. Crediamo che il red teaming avrà un ruolo decisivo nella preparazione di ogni organizzazione agli attacchi ai sistemi AI e non vediamo l’ora di lavorare insieme per aiutare tutti a utilizzare l’AI in modo sicuro. Il rapporto esamina il nostro lavoro per creare un dedicato AI Red Team e include tre importanti aree: 1) cosa è il red teaming nel contesto dei sistemi AI e perché è importante; 2) quali tipi di attacchi simulano i red team AI; e 3) lezioni che abbiamo imparato e che possiamo condividere con gli altri.

Cosa è il red teaming?

Il Red Team di Google è composto da un gruppo di hacker che simulano una varietà di avversari, che vanno da nazioni e gruppi noti di minacce persistenti avanzate (APT) ad attivisti hacker, criminali individuali o addirittura insidie maliziose. Il termine deriva dal mondo militare e descrive attività in cui un team designato assume un ruolo avversario (il “Red Team”) contro il team “di casa”.

10:25

10:25

- Utilizzare un Keras Tuner per l’ottimizzazione degli iperparametri di un modello TensorFlow

- Meta rilascia LLaMA 2 Gratuito per uso commerciale

- Svelando il potere del Llama 2 di Meta Un salto in avanti nell’IA generativa?

Per uno sguardo più approfondito al Red Team di sicurezza di Google, guarda il video sopra.

Nell’ultimo decennio abbiamo evoluto il nostro approccio per tradurre il concetto di red teaming nelle ultime innovazioni tecnologiche, inclusa l’AI. L’AI Red Team è strettamente allineato ai red team tradizionali, ma possiede anche la necessaria competenza oggetto dell’AI per eseguire attacchi tecnici complessi ai sistemi AI. Per assicurarsi di simulare attività avversarie realistiche, il nostro team si avvale delle ultime conoscenze dei rinomati team di intelligence sulle minacce di Google, come Mandiant e il Threat Analysis Group (TAG), del red teaming sugli abusi dei contenuti all’interno della Trust & Safety e della ricerca sugli ultimi attacchi da parte di Google DeepMind.

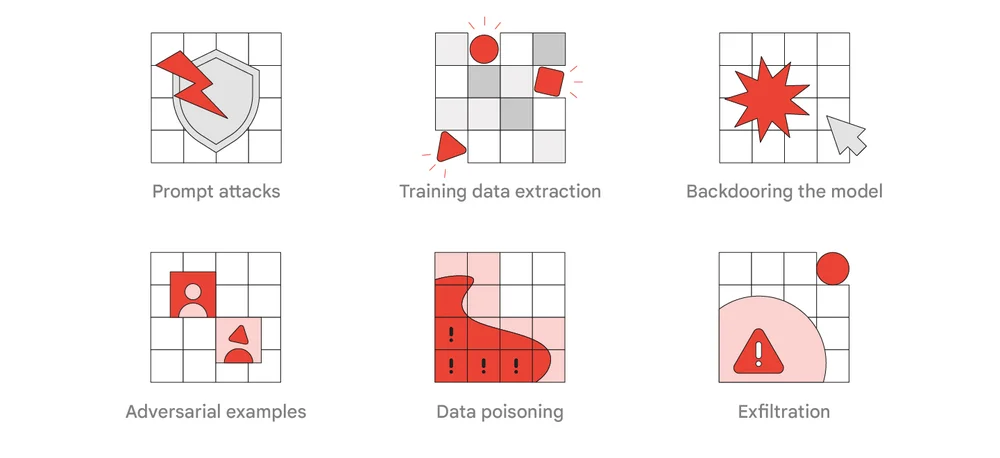

Tipi comuni di attacchi del red team ai sistemi AI

Una delle principali responsabilità del Red Team AI di Google è prendere ricerche pertinenti e adattarle per funzionare contro prodotti e funzionalità reali che utilizzano l’AI per comprendere il loro impatto. Gli esercizi possono rivelare risultati in termini di sicurezza, privacy e discipline di abuso, a seconda di dove e come la tecnologia viene utilizzata. Per identificare queste opportunità di miglioramento della sicurezza, sfruttiamo le tattiche, le tecniche e le procedure (TTP) degli aggressori per testare una serie di difese del sistema. Nel rapporto odierno è presente un elenco di TTP che riteniamo più rilevanti e realistici per avversari del mondo reale e per esercitazioni di red teaming. Essi includono attacchi rapidi, estrazione dei dati di addestramento, inserimento di backdoor nel modello, esempi avversari, contaminazione dei dati e esfiltrazione.

Lezioni apprese

Abbiamo già visto segnali precoci che gli investimenti nell’esperienza e nelle capacità dell’AI in simulazioni avversarie sono molto efficaci. Ad esempio, gli impegni del red team hanno evidenziato vulnerabilità e debolezze potenziali, che hanno contribuito a prevedere alcuni degli attacchi che ora vediamo sui sistemi AI. Ecco le principali lezioni che elenchiamo nel rapporto.

- I red team tradizionali sono un buon punto di partenza, ma gli attacchi ai sistemi AI diventano rapidamente complessi e traggono vantaggio dalla competenza oggetto dell’AI.

- Affrontare le scoperte del red team può essere una sfida e alcuni attacchi potrebbero non avere soluzioni semplici, quindi incoraggiamo le organizzazioni a incorporare il red teaming nei loro flussi di lavoro per alimentare gli sforzi di ricerca e sviluppo dei prodotti.

- Controlli di sicurezza tradizionali come assicurarsi che i sistemi e i modelli siano correttamente protetti possono ridurre significativamente il rischio.

- Molti attacchi ai sistemi AI possono essere rilevati nello stesso modo degli attacchi tradizionali.

Prospettive future

Dal suo inizio oltre un decennio fa, il Red Team di Google si è adattato a un panorama delle minacce in costante evoluzione ed è stato un affidabile partner di sparring per i team di difesa di Google. Speriamo che questo rapporto aiuti altre organizzazioni a comprendere come stiamo utilizzando questo team critico per proteggere i sistemi AI e che funga da richiamo all’azione per lavorare insieme per promuovere SAIF e innalzare gli standard di sicurezza per tutti. Raccomandiamo che ogni organizzazione conduca regolari esercitazioni del red team per garantire la sicurezza delle implementazioni critiche dell’AI nei grandi sistemi pubblici. Puoi consultare ulteriori informazioni sull’implementazione di SAIF, sulla protezione delle pipeline AI e puoi anche dare un’occhiata al mio intervento di quest’anno al DEF CON AI Village.