Google AI introduce Symbol Tuning un semplice metodo di fine-tuning che può migliorare l’apprendimento in contesto enfatizzando le corrispondenze input-etichetta

Google AI introduce Symbol Tuning, a simple fine-tuning method that can improve learning by emphasizing input-label matches.

I modelli di linguaggio sono tarati su coppie input-label presentate in un contesto in cui le etichette di linguaggio naturale vengono riassegnate a simboli arbitrari. Per una data attività, il modello deve dipendere dai mapping input-label nel contesto per ragionare e rivelare l’attività. In un nuovo articolo di ricerca, il team di Google AI introduce una semplice procedura di fine-tuning che migliora significativamente la capacità del modello di linguaggio di ragionare e apprendere dai mapping input-label per una data attività nel contesto. Lo chiamano “Sybol Tuning”. Il team di ricerca utilizza una miscela di 22 set di dati NLP con vari simboli arbitrari come etichette e sperimenta l’uso di diversi modelli Flan-PaL.

Le prestazioni dei modelli di base su attività di apprendimento in contesto non viste possono essere migliorate utilizzando il symbol tuning. Questi modelli si basano su esemplari di fine-tuning in cui le etichette semanticamente non correlate sostituiscono le etichette di linguaggio naturale. Sarebbero necessari più esemplari in contesto per definire l’attività, poiché l’attività non è chiara guardando solo un singolo esemplare in contesto. In media, il symbol tuning produce un miglioramento delle prestazioni del +11,1% su undici attività di valutazione per Flan-cont-PaLM-62B.

I modelli sintonizzati sui simboli includono solo dati di linguaggio naturale anziché dati numerici e algoritmici. Ciò fa sì che questi modelli siano più performanti nelle attività di ragionamento algoritmico. Per verificare ciò, i ricercatori sperimentano con un insieme di attività funzionali su elenchi in cui il modello deve identificare una funzione di trasformazione tra elenco di input e elenco di output contenenti numeri interi non negativi. Utilizzano concetti di Turing semplici in cui il modello utilizza il ragionamento con stringhe binarie per mappare un input su un output. Trovano che il symbol tuning porta a un miglioramento medio delle prestazioni su tutte le attività del 18,2% per Flan-PaLM-8B, 11,1% per Flan-PaLM-62B, 15,5% per Flan-cont-PaLM-62B e 3,6% per Flan-PaLM-540B.

- 5 semplici funzionalità di Python che puoi iniziare a utilizzare oggi per scrivere codice migliore

- 3 utili consigli su Pandas per lavorare con dati di tipo data e ora

- 10 Migliori Generatori di Presentazioni AI

Rispetto ai modelli sintonizzati sulle istruzioni, i modelli sintonizzati sui simboli sono molto migliori nel seguire le etichette invertite presentate in contesto. Le prestazioni dei modelli sintonizzati sulle istruzioni sono molto inferiori al caso del semplice indovinare, in quanto non possono invertire le previsioni per seguire le etichette invertite. D’altro canto, il symbol tuning costringe i modelli a considerare l’etichetta presentata in contesto come un simbolo arbitrario. Ciò riduce l’utilizzo da parte del modello di conoscenze precedenti che contraddicono le etichette invertite. I ricercatori trovano che dopo il symbol tuning, c’è un miglioramento medio su tutti i set di dati del 26,5% per Flan-PaLM-8B, del 33,7% per Flan-PaLM-62B e del 34,0% per Flan-PaLM-540B.

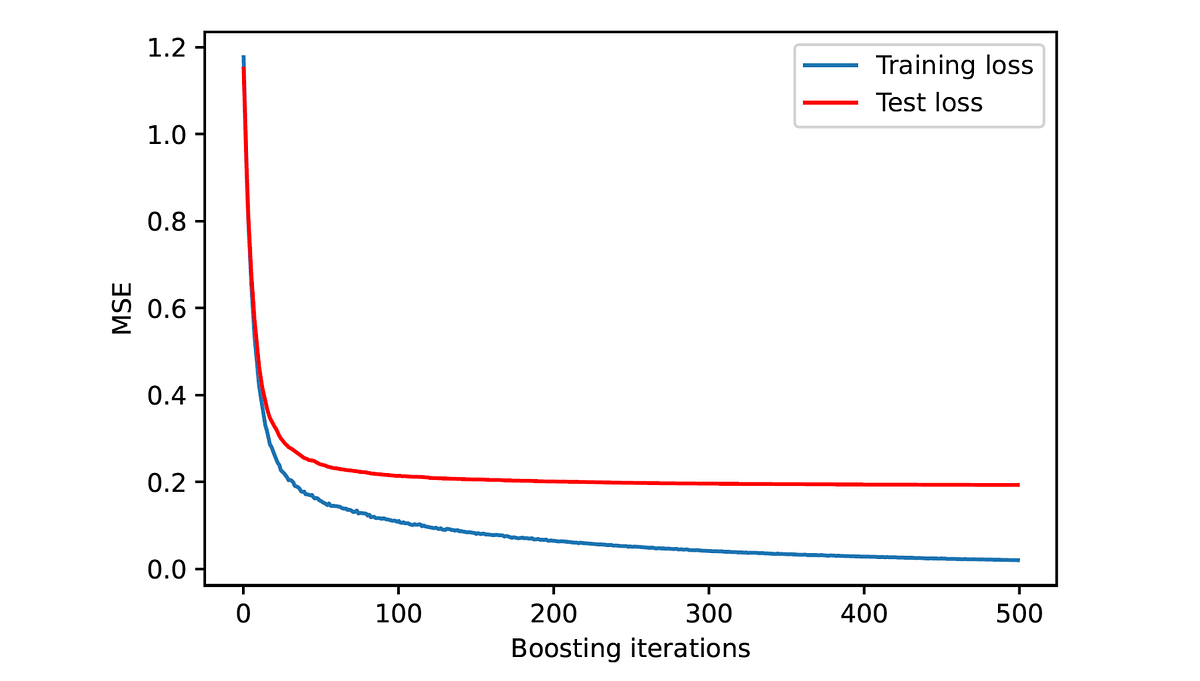

I ricercatori affermano che il symbol tuning non richiede molti passaggi di fine-tuning per qualsiasi modello con piccoli set di dati. Le prestazioni osservate rimangono relativamente costanti dopo un picco nel cambio di prestazioni nei primi 1k-2k passaggi. Poiché le prestazioni rimangono relativamente costanti, si può ipotizzare che modelli più grandi richiedano un insieme più diversificato o più ampio di dati per il symbol tuning.

I ricercatori trovano che dopo i passaggi iniziali, le proporzioni più elevate di dati di symbol tuning non influenzano le prestazioni del modello. Di conseguenza, il modello riesce ad avere successo nelle impostazioni ICL. Finché vengono utilizzati dati di symbol tuning non banali, la proporzione dei dati utilizzati è irrilevante. Il team ha trovato una forte correlazione tra una maggiore miscela di dati di symbol tuning e la probabilità che il modello segua le etichette invertite. Ciò migliora la capacità del modello di sovrascrivere le conoscenze precedenti con esemplari in contesto. Questo metodo ha successo solo se il modello generalizza la sua capacità di nuove attività a partire dall’insieme diversificato di attività quando viene inserito nel modello.