Esplorando le ultime tendenze in AI/DL dal Metaverse alla Quantum Computing

Esplorando le tendenze in AI/DL dal Metaverse alla Quantum Computing

Il campo dell’intelligenza artificiale (IA) è in costante evoluzione e diversi trend emergenti stanno plasmando il panorama, con il potenziale di influenzare notevolmente diverse industrie e la vita quotidiana. Una delle forze trainanti dietro i recenti progressi nell’IA è il Deep Learning (DL), anche conosciuto come reti neurali artificiali (ANNs). Il DL ha mostrato avanzamenti notevoli in aree come l’elaborazione del linguaggio naturale (NLP), la visione artificiale, l’apprendimento per rinforzo e le reti generative avversarie (GANs).

Ciò che rende il DL ancora più affascinante è la sua stretta connessione con la neuroscienza. I ricercatori spesso traggono spunti dalla complessità e dalla funzionalità del cervello umano per sviluppare tecniche e architetture di DL. Ad esempio, le reti neurali convoluzionali (CNN), le funzioni di attivazione e i neuroni artificiali nelle ANNs sono tutti ispirati alla struttura e al comportamento dei neuroni biologici nel cervello umano.

Mentre l’IA/DL e la neuroscienza stanno già facendo grandi progressi, c’è un’altra area che promette ancora di più di trasformare le nostre vite: la computazione quantistica. La computazione quantistica ha il potenziale per rivoluzionare la potenza di calcolo e sbloccare progressi senza precedenti in vari campi, incluso l’IA. La sua capacità di eseguire calcoli complessi e elaborare enormi quantità di dati contemporaneamente apre nuove frontiere di possibilità.

- L’interprete del codice ChatGPT è finalmente aperto. Come funziona esattamente? Ecco un tutorial

- Incontra LLM-AUGMENTER l’architettura di Microsoft Research per potenziare LLM con memoria, conoscenza e feedback esterno.

- Migliori piattaforme per trovare lavori da remoto nel 2023

Deep Learning

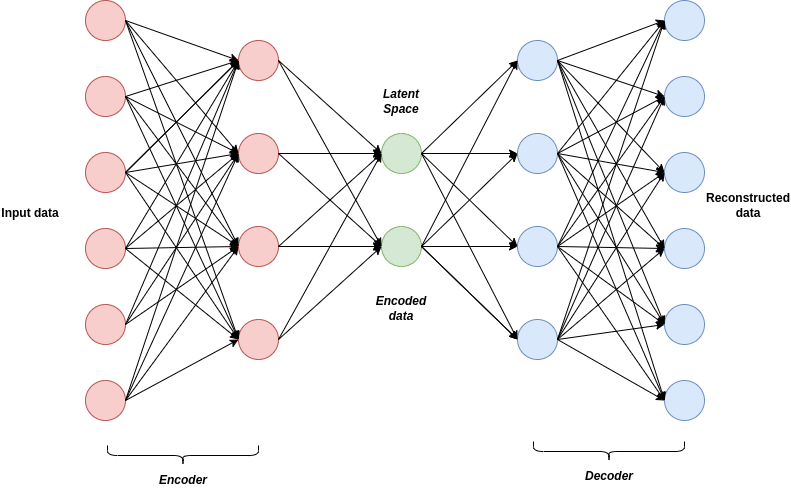

Le moderne reti neurali artificiali (ANNs) hanno guadagnato il nome di “deep learning” a causa della loro complessa architettura. Queste reti sono un tipo di modello di machine learning che trae ispirazione dalla struttura e dalla funzionalità del cervello umano. Composte da più strati interconnessi di neuroni, le ANNs elaborano e trasformano i dati mentre fluiscono attraverso la rete. Il termine “deep” si riferisce alla profondità della rete, determinata dal numero di strati nascosti nella sua architettura. Le ANNs tradizionali di solito hanno solo pochi strati nascosti, rendendole relativamente poco profonde. Al contrario, i modelli di deep learning possono avere decine o addirittura centinaia di strati nascosti, rendendoli significativamente più profondi. Questa maggiore profondità permette ai modelli di deep learning di catturare pattern intricati e caratteristiche gerarchiche dei dati, portando a elevate prestazioni in compiti di machine learning all’avanguardia.

Una nota applicazione del deep learning è la generazione di immagini testo-immagine e immagine-testo. Questi compiti si basano su tecniche di DL come le reti generative avversarie (GANs) o gli autoencoder variationali (VAEs) per apprendere le relazioni complesse tra testo e immagini da vasti dataset. Tali modelli trovano applicazione in vari campi, tra cui computer grafica, arte, pubblicità, moda, intrattenimento, realtà virtuale, esperienze di gioco, visualizzazione dei dati e narrazione.

Nonostante i significativi progressi, il deep learning incontra la sua parte di sfide e limitazioni. Gli ostacoli principali risiedono nelle Risorse Computazionali e nell’Efficienza Energetica. I modelli di DL spesso richiedono considerevoli risorse computazionali, come potenti GPU (Unità di Elaborazione Grafica) o hardware specializzato, per eseguire previsioni in modo efficiente. Questa dipendenza da un’infrastruttura informatica estesa può limitare l’accesso al deep learning per ricercatori o organizzazioni prive di risorse sufficienti. Inoltre, l’addestramento e l’esecuzione dei modelli di DL possono richiedere molte risorse computazionali, consumando una quantità considerevole di energia. Man mano che i modelli continuano a crescere di dimensioni ogni anno, le preoccupazioni sull’efficienza energetica diventano sempre più rilevanti.

Modelli Grandi

Oltre alle considerazioni tecniche riguardanti i modelli linguistici e visivi di grandi dimensioni, c’è una sfida inaspettata che sorge dai governi di tutto il mondo. Questi organismi governativi stanno spingendo per regolamentazioni sui modelli di intelligenza artificiale e richiedendo trasparenza da parte dei proprietari dei modelli, comprese piattaforme come ChatGPT, per spiegare il funzionamento interno dei loro modelli. Tuttavia, né entità importanti come OpenAI, Microsoft o Google, né la comunità scientifica dell’IA, hanno risposte concrete a queste domande. Ammettono di avere una comprensione generale, ma non sono in grado di spiegare perché i modelli forniscono una risposta piuttosto che un’altra. Incidenti recenti, come il divieto di ChatGPT in Italia e le accuse di Elon Musk a Microsoft riguardo all’uso non autorizzato dei dati di Twitter da parte di ChatGPT, sono solo l’inizio di un problema più ampio. Sembra che una nuova battaglia stia prendendo forma tra importanti aziende IT, riguardo a chi può vantare la “più grande modello” e quali dati possono essere utilizzati per tali modelli.

In un recente post sul blog intitolato “L’era dell’IA è iniziata”, il co-fondatore di Microsoft Bill Gates ha elogiato ChatGPT e gli sviluppi correlati dell’IA come “rivoluzionari”. Gates ha sottolineato la necessità di soluzioni “rivoluzionarie” per affrontare le sfide attuali. Di conseguenza, ciò comporta una rivalutazione di concetti come “diritti d’autore”, “test universitari e collegiali” e persino indagini filosofiche sulla stessa natura dell'”apprendimento”.

Neuroscienze

Nel suo recente libro “The Thousand Brains Theory”, J. Hawkins presenta una prospettiva innovativa ed evolutiva su come il cervello umano elabora le informazioni e genera comportamenti intelligenti. La Thousand Brains Theory propone che il cervello funzioni come una rete di migliaia di mini-cervelli individuali, ciascuno responsabile dell’elaborazione dell’input sensoriale e della produzione dell’output motorio contemporaneamente. Secondo questa teoria, il neocortex, lo strato esterno del cervello associato alle funzioni cognitive di livello superiore, è composto da numerose colonne funzionalmente indipendenti che possono essere paragonate a mini-cervelli.

La teoria suggerisce che ogni colonna all’interno del neocortex apprende e modella l’input sensoriale ricevuto dall’ambiente circostante, facendo previsioni sull’input sensoriale futuro. Queste previsioni vengono quindi confrontate con l’effettivo input sensoriale e eventuali disparità vengono utilizzate per aggiornare i modelli interni all’interno delle colonne. Questo processo continuo di previsione e confronto costituisce la base di come il neocortex elabora le informazioni e genera comportamenti intelligenti.

Secondo la Thousand Brains Theory, l’input sensoriale proveniente da varie modalità, come la visione, l’udito e il tatto, viene elaborato in modo indipendente in colonne separate. I risultati di queste colonne vengono successivamente combinati per creare una percezione unificata del mondo. Questa notevole capacità consente al cervello di integrare informazioni provenienti da diverse modalità sensoriali e formare una rappresentazione coerente dell’ambiente circostante.

Un concetto chiave nella Thousand Brains Theory è la “Rappresentazione Sparra”. Questa nozione sottolinea l’idea che solo un sottoinsieme di neuroni nel cervello umano è attivo o si attiva in un determinato momento, mentre gli altri neuroni rimangono relativamente inattivi o silenziosi. La codifica sparra consente un elaborazione ed una codifica efficiente delle informazioni nel cervello, riducendo l’attività neurale ridondante o non necessaria. Un importante vantaggio della rappresentazione sparra è la sua capacità di consentire aggiornamenti selettivi nel cervello. In questo processo, solo i neuroni o i percorsi neurali attivi vengono aggiornati o modificati in risposta a nuove informazioni o esperienze.

Questo meccanismo di aggiornamento selettivo consente al cervello di adattarsi ed apprendere in modo efficiente, concentrando le proprie risorse sulle informazioni o compiti più rilevanti, anziché aggiornare tutti i neuroni contemporaneamente. L’aggiornamento selettivo dei neuroni svolge un ruolo vitale nella plasticità neurale, che si riferisce alla capacità del cervello di cambiare ed adattarsi attraverso l’apprendimento e l’esperienza. Consente al cervello di perfezionare le sue rappresentazioni e connessioni in base alle richieste cognitive e comportamentali in corso, conservando energia e risorse computazionali.

Le applicazioni pratiche della teoria Numenta sono già evidenti. Ad esempio, la recente collaborazione con Intel ha facilitato significativi miglioramenti delle prestazioni in vari casi d’uso, come l’elaborazione del linguaggio naturale e la visione artificiale. Grazie a questa partnership, i clienti possono ottenere miglioramenti delle prestazioni che vanno da 10 a oltre 100 volte.

Metaverso

Mentre molti concentrano la loro attenzione sui Large Language Models, Meta adotta un approccio distintivo. In un articolo dal titolo “Robot che imparano da video di attività umane e interazioni simulate”, il team di Meta AI sottolinea un concetto intrigante noto come “paradosso di Moravec”. Secondo questa tesi, i problemi più complessi nell’ambito dell’IA riguardano le abilità sensorimotorie piuttosto che il pensiero astratto o il ragionamento. A sostegno di questa affermazione, il team ha annunciato due importanti progressi nel campo degli agenti di IA general-purpose con un corpo.

- Innanzitutto, hanno introdotto la corteccia visiva artificiale, nota come VC-1. Questo modello di percezione rivoluzionario è il primo a fornire supporto per una vasta gamma di abilità sensorimotorie, ambienti e corpi.

- Inoltre, il team di Meta ha sviluppato un approccio innovativo chiamato coordinamento adattivo delle abilità (sensorimotorie) (ASC). Questo approccio raggiunge un tasso di successo del 98% nella complessa attività della manipolazione mobile robotica. Coinvolge il navigare verso un oggetto, prenderlo, spostarsi in un’altra posizione, posizionare l’oggetto e ripetere queste azioni, il tutto all’interno di ambienti fisici.

Questi progressi di Meta rappresentano una deviazione dal prevalente focus sui grandi modelli linguistici. Priorizzando le abilità sensorimotorie e l’IA incarnata, contribuiscono allo sviluppo di agenti in grado di interagire con il mondo in modo più completo e sfumato.

I modelli ChatGPT hanno suscitato un notevole hype e ricevuto una sproporzionata attenzione pubblica, nonostante siano principalmente basati su approcci statistici. Al contrario, i recenti progressi di Meta rappresentano significativi avanzamenti scientifici. Questi risultati stanno gettando le basi per una rivoluzionaria espansione nei campi della realtà virtuale (VR) e della robotica. Consigliamo vivamente di leggere l’articolo completo per ottenere approfondimenti e prepararsi adeguatamente all’imminente ondata di innovazione nell’ambito dell’IA, poiché promette di plasmare il futuro di questi settori in modi straordinari.

Robotica

Attualmente, due robot di spicco nel campo sono Atlas e Spot (robodog), entrambi facilmente disponibili per l’acquisto online. Questi robot rappresentano imprese ingegneristiche notevoli, ma le loro capacità sono ancora limitate dall’assenza di “cervelli” avanzati. È qui che entra in gioco la corteccia visiva artificiale di Meta come potenziale elemento rivoluzionario. Integrando la robotica con l’IA, ha il potere di rivoluzionare numerosi settori e industrie, tra cui la manifattura, la sanità, il trasporto, l’agricoltura e l’intrattenimento, tra gli altri. La corteccia visiva artificiale di Meta promette di potenziare le capacità di questi robot e aprire la strada a progressi senza precedenti nel campo della robotica.

Nuove Interfacce per gli Esseri Umani: Interfacce Cervello-Computer/Computer-Cervello

Pur potendo sorgere preoccupazioni riguardo a essere superati dall’IA, il cervello umano possiede un vantaggio cruciale che manca all’IA moderna: la neuroplasticità. La neuroplasticità, nota anche come plasticità cerebrale, si riferisce alla notevole capacità del cervello di cambiare e adattarsi sia nella struttura che nella funzione in risposta alle esperienze, all’apprendimento e ai cambiamenti ambientali. Tuttavia, nonostante questo vantaggio, i cervelli umani sono ancora privi di metodi avanzati di comunicazione con altri cervelli umani o sistemi di intelligenza artificiale. Per superare queste limitazioni, lo sviluppo di nuove interfacce per il cervello è imperativo.

I metodi tradizionali di comunicazione come la visione, l’udito o la digitazione non riescono a competere con i modelli di intelligenza artificiale moderni a causa della loro limitata velocità di comunicazione. Per affrontare questo problema, si stanno perseguendo nuove interfacce basate su attività neurali dirette del cervello. Entra nel campo delle moderne Interfacce Cervello-Computer (BCI), tecnologie all’avanguardia che consentono la comunicazione e l’interazione dirette tra il cervello e dispositivi o sistemi esterni, bypassando la necessità di percorsi tradizionali del sistema nervoso periferico. Le BCI trovano applicazioni in settori come la neuroprotesi, la neuroriabilitazione, la comunicazione, il controllo per individui con disabilità, il potenziamento cognitivo e la ricerca neuroscientifica. Inoltre, le BCI si sono recentemente avventurate nel campo dell’intrattenimento in realtà virtuale, con dispositivi come ‘Galea’ all’orizzonte, che potrebbero diventare parte della nostra realtà quotidiana.

Un altro esempio intrigante è Kernel Flow, un dispositivo in grado di catturare sia dati EEG che dati simili a fMRI che coprono l’intera testa dal cervello. Con tali capacità, è concepibile che possiamo eventualmente creare mondi virtuali direttamente dai nostri sogni.

A differenza delle BCI non invasive come ‘Galea’ e ‘Kernel’, Neuralink, fondata da Elon Musk, adotta un approccio diverso, promuovendo un impianto cerebrale invasivo. Alcuni lo hanno definito come una “presa per il mondo esterno”, offrendo canali di comunicazione molto più ampi rispetto a qualsiasi BCI non invasiva moderna. Un ulteriore vantaggio significativo delle BCI invasive è il potenziale per la comunicazione bidirezionale. Immaginate un futuro in cui le informazioni non richiedono più i nostri occhi o le nostre orecchie, ma possono essere trasmesse direttamente al nostro neocortex.

Calcolo Quantistico

Se la Neuroscienza e il cervello umano non fossero già abbastanza intriganti, c’è ancora un argomento che fa impazzire la mente da esplorare: i Computer Quantistici. Queste straordinarie macchine hanno il potenziale di superare i computer classici in determinati compiti computazionali. Sfruttando le sovrapposizioni e gli intrecci quantistici, all’avanguardia della fisica moderna, i computer quantistici possono eseguire calcoli paralleli e risolvere problemi specifici in modo più efficiente. Esempi di questi includono la scomposizione di numeri grandi, la risoluzione di problemi di ottimizzazione complessi, la simulazione di sistemi quantistici e il concetto futuristico della teletrasportazione quantistica. Questi progressi sono destinati a rivoluzionare settori come la crittografia, la scoperta di farmaci, la scienza dei materiali e la modellazione finanziaria. Per vivere un’esperienza diretta di programmazione quantistica, puoi visitare www.quantumplayground.net e scrivere il tuo primo script quantistico in pochi minuti.

Mentre il futuro è intrinsecamente incerto, una cosa rimane chiara: la traiettoria del futuro dell’umanità sarà plasmata dalle scelte e dalle azioni di individui, comunità, istituzioni e governi. È cruciale che ci sforziamo collettivamente per un cambiamento positivo, affrontiamo questioni globali urgenti, promuoviamo l’inclusività e la sostenibilità e lavoriamo insieme per creare un futuro migliore per tutta l’umanità. Ihar Rubanau è un Data Scientist Senior presso Sigma Software Group.