RLHF per la presa di decisioni ad alte prestazioni strategie e ottimizzazione

RLHF for high-performance decision-making strategies and optimization.

Introduzione

Il Reinforcement Learning from Human Factors/feedback (RLHF) è un campo emergente che combina i principi del RL con il feedback umano. Verrà progettato per ottimizzare la presa di decisioni e migliorare le prestazioni nei sistemi complessi del mondo reale. RLHF per l’alta performance si concentra sulla comprensione del comportamento umano, della cognizione, del contesto, della conoscenza e dell’interazione, tramite l’utilizzo di modelli computazionali e approcci basati sui dati, per migliorare la progettazione, l’usabilità e la sicurezza di vari settori.

RLHF mira a colmare il divario tra l’ottimizzazione centrata sulla macchina e il design centrato sull’essere umano integrando algoritmi RL con i principi dei fattori umani. I ricercatori cercano di creare sistemi intelligenti che si adattino alle esigenze, alle preferenze e alle capacità umane, migliorando così l’esperienza utente. In RLHF, i modelli computazionali simulano, predicono e prescrivono le risposte umane, consentendo ai ricercatori di comprendere come le persone prendono decisioni informate e interagiscono con ambienti complessi. Immagina di combinare questi modelli con gli algoritmi di apprendimento per rinforzo! RLHF mira a ottimizzare i processi decisionali, migliorare le prestazioni del sistema e potenziare la collaborazione tra uomo e macchina nei prossimi anni.

Obiettivi di Apprendimento

- Comprendere i fondamenti del RLHF e la sua importanza nel design centrato sull’essere umano è il primo e principale passo.

- Esplorare le applicazioni del RLHF nell’ottimizzazione della presa di decisioni e delle prestazioni in vari settori.

- Identificare argomenti chiave correlati a RLHF, tra cui l’apprendimento per rinforzo, l’ingegneria dei fattori umani e le interfacce adattive.

- Riconoscere il ruolo dei grafi di conoscenza nel facilitare l’integrazione dei dati e delle intuizioni nella ricerca e nelle applicazioni di RLHF.

RLHF: Rivoluzionando i Domini Centrati sull’Essere Umano

Il Reinforcement Learning with Human Factors (RLHF) ha il potenziale per trasformare vari settori in cui i fattori umani sono cruciali. Sfrutta la comprensione dei limiti cognitivi umani, dei comportamenti e delle interazioni per creare interfacce adattive, sistemi di supporto decisionale e tecnologie assistive personalizzate alle esigenze individuali. Ciò porta a un miglioramento dell’efficienza, della sicurezza e della soddisfazione dell’utente, favorendo l’adozione su larga scala nell’industria.

- Incontra ResFields un nuovo approccio di intelligenza artificiale per superare le limitazioni dei campi neurali spaziotemporali nel modellare efficacemente segnali temporali lunghi e complessi.

- Svelare i segreti delle prestazioni catalitiche con Deep Learning Un’analisi approfondita della rete neurale convoluzionale ‘Globale + Locale’ per una selezione ad alta precisione dei catalizzatori eterogenei

- Una nuova ricerca sull’IA di Apple ed Equall AI scopre ridondanze nell’architettura del trasformatore come ottimizzare la rete di alimentazione in avanti aumenta efficienza e precisione

Nell’evoluzione in corso del RLHF, i ricercatori stanno esplorando nuove applicazioni e affrontando le sfide dell’integrazione dei fattori umani negli algoritmi di apprendimento per rinforzo. Unendo modelli computazionali, approcci basati sui dati e design centrato sull’essere umano, RLHF sta aprendo la strada a una collaborazione avanzata tra uomo e macchina e a sistemi intelligenti che ottimizzano la presa di decisioni e migliorano le prestazioni in diverse situazioni del mondo reale.

Perché RLHF?

RLHF è estremamente prezioso per vari settori, come la sanità, la finanza, il trasporto, il gaming, la robotica, la supply chain, i servizi per i clienti, ecc. RLHF consente ai sistemi di intelligenza artificiale di apprendere in modo più allineato alle intenzioni e alle necessità umane, rendendo l’uso comodo, sicuro ed efficace in una vasta gamma di applicazioni per i loro casi d’uso e le sfide complesse del mondo reale.

Perché RLHF è Valore Aggiunto?

- Consentire l’IA in Ambienti Complessi è ciò di cui è capace RLHF. In molti settori, gli ambienti in cui operano i sistemi di intelligenza artificiale sono solitamente complessi e difficili da modellare con precisione. RLHF consente invece ai sistemi di IA di imparare dai fattori umani e di adattarsi a questi scenari complessi, in cui l’approccio tradizionale fallisce in termini di efficienza e precisione.

- RLHF promuove un comportamento dell’IA responsabile in linea con i valori, l’etica e la sicurezza umana. Il feedback continuo dell’essere umano a questi sistemi aiuta a prevenire azioni indesiderate. D’altro canto, RLHF offre un modo alternativo per guidare il percorso di apprendimento di un agente, incorporando fattori umani, giudizi, priorità e preferenze.

- Aumentare l’efficienza e ridurre i costi. La necessità di ampi tentativi ed errori mediante l’utilizzo di grafi di conoscenza o l’addestramento dei sistemi di IA può essere adottata rapidamente in scenari specifici, entrambi possono essere adattamenti rapidi in situazioni dinamiche.

- Abilitare RPA e automazione per l’adattamento in tempo reale, dove la maggior parte delle industrie si trova già nell’RPA o con alcuni sistemi di automazione, che richiedono agli agenti di IA di adattarsi rapidamente alle situazioni in cambiamento. RLHF aiuta questi agenti ad apprendere “al volo” con il feedback umano, migliorando le prestazioni e la precisione anche in situazioni incerte. Chiamiamo questo “SISTEMA DI INTELLIGENZA DECISIONALE”, in cui RDF (resource development framework) può persino portare informazioni semantiche sul web allo stesso sistema, aiutando nelle decisioni informate.

- Digitalizzazione delle Conoscenze Esperte: In ogni settore industriale, l’esperienza è fondamentale. Con l’aiuto di RLHF, i sistemi di IA possono imparare dalle conoscenze degli esperti. Allo stesso modo, i grafi di conoscenza e RDF ci consentono di digitalizzare queste conoscenze dalle dimostrazioni degli esperti, dai processi, dai fatti di risoluzione dei problemi e dalle capacità di giudizio. RLHF può persino trasferire efficacemente le conoscenze agli agenti.

- Personalizzazione in base alle esigenze: Il miglioramento continuo è una delle considerazioni più importanti che i sistemi di IA operano di solito per scenari del mondo reale, in cui possono raccogliere feedback continuo dagli utenti e dagli esperti, facendo sì che l’IA migliori continuamente in base al feedback e alle decisioni.

Come Funziona RLHF?

RLHF colma le lacune tra l’apprendimento automatico e l’esperienza umana, fondendo la conoscenza umana con le tecniche di apprendimento per rinforzo, in modo che i sistemi di intelligenza artificiale diventino più adattabili con una maggiore precisione ed efficienza.

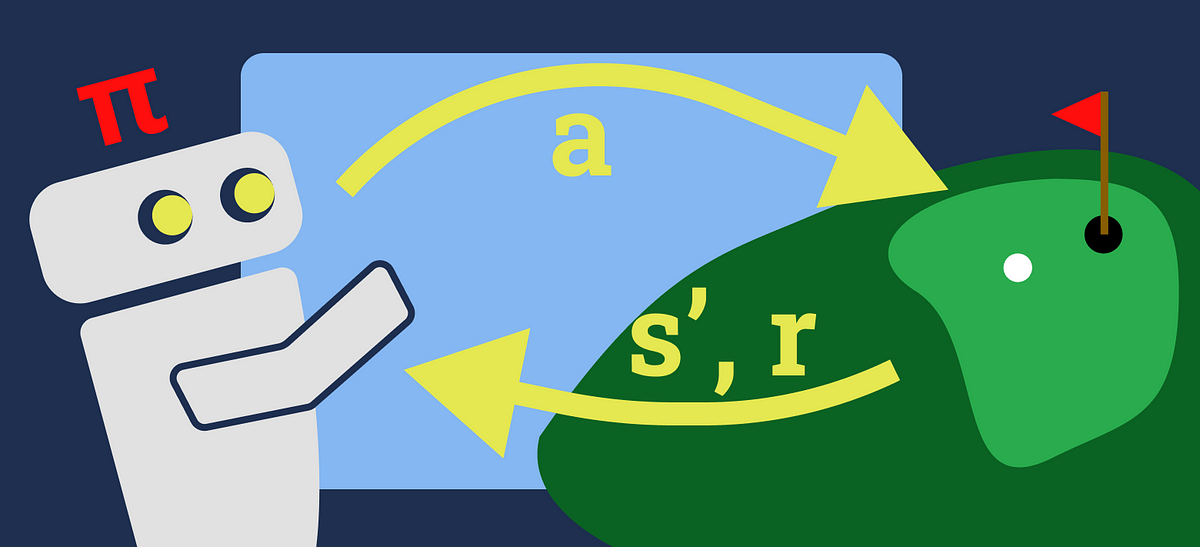

Reinforcement Learning from Human Feedback (RLHF) è un approccio di apprendimento automatico che migliora la formazione degli agenti di intelligenza artificiale integrando il feedback fornito dagli esseri umani nel processo di apprendimento. RLHF affronta sfide in cui l’apprendimento per rinforzo convenzionale fatica a causa di segnali di ricompensa poco chiari, ambienti complessi o della necessità di allineare i comportamenti dell’intelligenza artificiale con i valori umani.

In RLHF, un agente di intelligenza artificiale interagisce con un ambiente e riceve un feedback di ricompensa. Tuttavia, queste ricompense potrebbero essere inadeguate, rumorose o difficili da definire con precisione. Il feedback umano diventa cruciale per guidare efficacemente l’apprendimento dell’agente. Questo feedback può assumere forme diverse, come ricompense esplicite, dimostrazioni di comportamenti desiderati, confronti, classifiche o valutazioni qualitative.

L’agente incorpora il feedback umano nell’apprendimento regolando la sua politica, la funzione di ricompensa o le rappresentazioni interne. Questa fusione di feedback e apprendimento consente all’agente di perfezionare il suo comportamento, apprendere dall’esperienza umana e allinearsi agli esiti desiderati. La sfida sta nel bilanciare l’esplorazione (provare nuove azioni) e lo sfruttamento (scegliere azioni conosciute) per apprendere in modo efficace rispettando le preferenze umane.

RLHF Comprende Diverse Tecniche

- Shaping delle Ricompense: Il feedback umano modella le ricompense dell’agente, focalizzando il suo apprendimento su comportamenti desiderati.

- Apprendimento per Imitazione: Gli agenti apprendono dalle dimostrazioni umane, imitando comportamenti corretti e generalizzando a situazioni simili.

- Classificazione e Confronto: Gli esseri umani classificano le azioni o confrontano le politiche, guidando l’agente nella selezione di azioni che si allineano alle preferenze umane.

- Feedback di Preferenza: Gli agenti utilizzano informazioni di preferenza fornite dagli esseri umani per prendere decisioni che riflettono i valori umani.

- Feedback dei Critici: Gli esseri umani agiscono come critici, valutando le prestazioni dell’agente e offrendo suggerimenti per il miglioramento.

Il processo è iterativo, poiché l’agente perfeziona il suo comportamento nel tempo attraverso l’interazione continua, l’integrazione del feedback e l’aggiustamento delle politiche. Le prestazioni dell’agente vengono valutate utilizzando metriche tradizionali di apprendimento per rinforzo e metriche che misurano l’allineamento con i valori umani.

“Suggerisco di utilizzare database grafici, grafi di conoscenza e RDF per avere un impatto maggiore rispetto ai database tradizionali per RLHF”.

Utilizzo Diffuso di RLHF nell’Industria

RLHF ha un vasto potenziale per rivoluzionare la presa di decisioni e migliorare le prestazioni in diversi settori. Di seguito sono elencati alcuni dei principali casi di utilizzo nelle industrie:

- Manifatturiero e Temi Industria 4.0, 5.0: Considera un sistema o processo di produzione complesso. Integrando i fattori umani e il feedback, RLHF può far parte del percorso di trasformazione digitale migliorando la sicurezza sul lavoro, la produttività, l’ergonomia o addirittura la sostenibilità nella riduzione dei rischi. RLHF può essere utilizzato per ottimizzare la manutenzione, la pianificazione e l’allocazione delle risorse in complessi ambienti industriali reali.

- BFSI: Il settore dei servizi finanziari continua a migliorare la gestione del rischio, l’esperienza del cliente e la presa di decisioni. Immagina il feedback umano e fattori come il comportamento dell’utente, le interfacce utente, il comportamento degli investitori e i bias cognitivi come l’information bias e il confirmation bias. Questi attributi aziendali possono fornire raccomandazioni finanziarie personalizzate, ottimizzare le strategie di trading e migliorare i sistemi di rilevamento delle frodi. Ad esempio: “Immagina che un investitore individuale sia molto più propenso a vendere un’azione che ha guadagnato valore ma decida di tenere un’azione che ha perso valore.” RLHF può fornire raccomandazioni o decisioni strategicamente informate che risolvono rapidamente problemi aziendali.

- Farmaceutico e Sanità: Integrando RLHF nell’azienda, RLHF può aiutare i professionisti a formulare raccomandazioni di trattamento personalizzate e a prevedere gli esiti dei pazienti. RLHF sarà una grande opzione per ottimizzare la presa di decisioni cliniche, la pianificazione del trattamento, gli eventi avversi dei farmaci e la produzione di API.

- Supply chain e logistica: RLHF può svolgere un ruolo importante e cruciale nel migliorare i sistemi di supply chain, il trasporto e le operazioni logistiche. Considera i fattori umani come il comportamento del conducente e il carico cognitivo coinvolto nella presa di decisioni. Dalla produzione alla consegna nella supply chain, RLHF può essere utilizzato per ottimizzare l’inventario con raccomandazioni nella pianificazione della domanda e della distribuzione, l’ottimizzazione del percorso e la gestione della flotta. D’altra parte, i ricercatori stanno lavorando per migliorare i sistemi di assistenza alla guida, i veicoli autonomi e il controllo del traffico aereo utilizzando RLHF, il che può portare a reti di trasporto più sicure ed efficienti.

Conclusion

Il Reinforcement Learning in Human Factors (RLHF) combina l’apprendimento di rinforzo con l’ingegneria dei fattori umani per migliorare la presa di decisioni e le prestazioni in vari ambiti. Mette in evidenza i knowledge graph per avanzare nella ricerca. La versatilità del RLHF si adatta a domini che coinvolgono la presa di decisioni umane e l’ottimizzazione, offrendo approfondimenti precisi sui dati.

RLHF + Graph tech elimina la frammentazione dei dati, migliorando le informazioni per gli algoritmi. Questo articolo fornisce una visione olistica del RLHF, del suo potenziale e del ruolo dei knowledge graph nell’ottimizzazione di campi diversi.