Google Research presenta SPAE un autoencoder per la generazione multimodale con modelli di linguaggio di grandi dimensioni (LLM) congelati.

Google Research presenta SPAE, un autoencoder per la generazione multimodale con LLM congelati.

I modelli linguistici di grandi dimensioni (LLM) hanno guadagnato rapidamente enorme popolarità grazie alle loro straordinarie capacità nel campo del Natural Language Processing e del Natural Language Understanding. Questo recente sviluppo nel campo dell’Intelligenza Artificiale ha rivoluzionato il modo in cui gli esseri umani e i computer interagiscono tra loro. Il recente modello sviluppato da OpenAI, che è stato protagonista di numerosi titoli, è il noto ChatGPT. Basato sull’architettura trasformatore di GPT, questo modello è famoso per imitare gli esseri umani in quanto è in grado di condurre conversazioni realistiche e svolge attività che vanno dalla risposta alle domande alla generazione di contenuti, al completamento del codice, alla traduzione automatica e alla sintesi del testo.

I LLM sono eccezionali nel catturare una conoscenza concettuale profonda del mondo attraverso i loro embedding lessicali. Tuttavia, i ricercatori stanno ancora facendo sforzi per rendere i LLM congelati in grado di completare compiti di modalità visiva quando vengono fornite le giuste rappresentazioni visive come input. I ricercatori hanno suggerito di utilizzare un quantizzatore vettoriale che mappa un’immagine nello spazio dei token di un LLM congelato, il che tradurrebbe l’immagine in un linguaggio che il LLM può comprendere, consentendo l’utilizzo delle capacità generative del LLM per eseguire compiti di comprensione e generazione dell’immagine condizionali senza la necessità di allenarsi su coppie immagine-testo.

Per affrontare questo problema e agevolare questo compito cross-modale, un team di ricercatori di Google Research e della Carnegie Mellon University ha introdotto Semantic Pyramid AutoEncoder (SPAE), un autoencoder per la generazione multimodale con grandi modelli linguistici congelati. SPAE produce una sequenza di parole lessicali che trasporta semantiche ricche mantenendo al contempo dettagli precisi per la ricostruzione del segnale. In SPAE, il team ha combinato un’architettura di autoencoder con una struttura piramidale gerarchica, e a differenza degli approcci precedenti, SPAE codifica le immagini in uno spazio latente discreto interpretabile, ossia parole.

- Trasformazioni delle Caratteristiche Un Tutorial su PCA e LDA

- Come l’IA sta sconvolgendo la governance dei dati?

- Rischi dell’IA ed Estinzione Il Futuro Precario dell’Umanità in Mezzo alla Rivoluzione dell’IA

La rappresentazione a forma di piramide dei token SPAE ha diverse scale, con i livelli inferiori della piramide che privilegiano rappresentazioni di aspetto che catturano dettagli precisi per la ricostruzione dell’immagine e i livelli superiori della piramide che contengono nozioni semanticamente centrali. Questo sistema consente l’adattamento dinamico della lunghezza dei token per adattarsi a compiti diversi, utilizzando meno token per compiti che richiedono conoscenza e più token per lavori che richiedono generazione. Questo modello è stato addestrato in modo indipendente, senza retropropagare attraverso alcun modello linguistico.

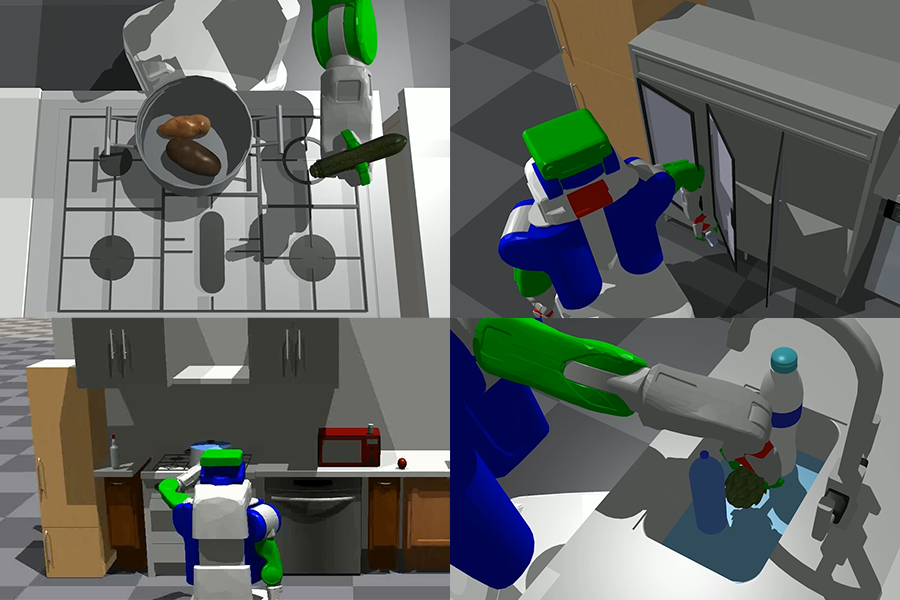

Per valutare l’efficacia di SPAE, il team ha condotto esperimenti su compiti di comprensione dell’immagine, tra cui classificazione dell’immagine, didascalia dell’immagine e risposta alle domande visive. I risultati hanno dimostrato quanto bene i LLM possano gestire le modalità visive e alcune grandi applicazioni come la generazione di contenuti, il supporto alla progettazione e la narrazione interattiva. I ricercatori hanno anche utilizzato metodi di denoising in contesto per illustrare le capacità di generazione di immagini dei LLM.

Il team ha riassunto il contributo come segue:

- Questo lavoro fornisce un ottimo metodo per generare direttamente contenuti visivi utilizzando l’apprendimento in contesto con un modello linguistico congelato che è stato addestrato solo su token linguistici.

- È stato proposto Semantic Pyramid AutoEncoder (SPAE) per generare rappresentazioni interpretabili di concetti semantici e dettagli fini. I token linguistici multilingue generati dal tokenizer hanno lunghezze personalizzabili, conferendo maggiore flessibilità e adattabilità nella cattura e comunicazione delle sottigliezze delle informazioni visive.

- È stato introdotto anche un metodo progressivo di prompting, che consente l’integrazione senza soluzione di continuità delle modalità linguistica e visiva, consentendo la generazione di sequenze cross-modali complete e coerenti con una qualità e un’accuratezza migliorate.

- L’approccio supera l’accuratezza di classificazione delle immagini a pochi esempi di ultima generazione nelle stesse condizioni in contesto di un margine assoluto del 25%.

In conclusione, SPAE rappresenta una significativa svolta nel colmare il divario tra i modelli linguistici e la comprensione visiva. Mostra il notevole potenziale dei LLM nella gestione di compiti cross-modali.