Newsletter Etica e Società #1

Newsletter #1

Ciao, mondo!

Nasce come un’azienda open-source, Hugging Face è stata fondata su alcuni valori etici chiave nel campo della tecnologia: collaborazione, responsabilità e trasparenza. Codificare in un ambiente aperto significa avere il proprio codice – e le scelte al suo interno – visibili al mondo, associate al proprio account e disponibili per essere criticate e aggiunte dagli altri. Quando la comunità di ricerca ha iniziato a utilizzare l’Hugging Face Hub per ospitare modelli e dati, la riproducibilità è stata direttamente integrata come un altro valore fondamentale dell’azienda. E con l’aumento del numero di set di dati e modelli su Hugging Face, coloro che lavorano presso Hugging Face hanno implementato requisiti di documentazione e corsi gratuiti e istruttivi, rispondendo ai nuovi valori emergenti definiti dalla comunità di ricerca con valori complementari legati all’auditabilità e alla comprensione della matematica, del codice, dei processi e delle persone che portano alla tecnologia attuale.

Come operazionalizzare l’etica nell’IA è un’area di ricerca aperta. Sebbene la teoria e la ricerca sull’etica applicata e sull’intelligenza artificiale esistano da decenni, le pratiche applicate e testate per l’etica nello sviluppo dell’IA sono iniziate solo negli ultimi 10 anni. Questo è in parte una risposta ai modelli di apprendimento automatico – i mattoni fondamentali dei sistemi di intelligenza artificiale – che hanno superato i benchmark utilizzati per misurarne il progresso, portando all’adozione diffusa di sistemi di apprendimento automatico in una serie di applicazioni pratiche che influenzano la vita quotidiana. Per coloro di noi interessati ad avanzare nell’IA informata dall’etica, unirsi a un’azienda di apprendimento automatico fondata in parte su principi etici, proprio mentre sta crescendo e proprio mentre le persone in tutto il mondo iniziano ad affrontare questioni etiche legate all’IA, è un’opportunità per plasmare fondamentalmente ciò che l’IA del futuro sarà. È un nuovo tipo di esperimento di IA di oggi: come appare una società tecnologica con l’etica in mente fin dall’inizio? Concentrandosi su un’ottica etica sull’apprendimento automatico, cosa significa democratizzare un buon apprendimento automatico?

A tal fine, condividiamo alcune delle nostre riflessioni e del nostro lavoro recenti nella nuova newsletter Hugging Face Ethics and Society, che verrà pubblicata ogni stagione, all’equinozio e al solstizio. Ecco qui! È realizzata da noi, i “regolari di etica e società”, un gruppo aperto di persone all’interno dell’azienda che si uniscono come pari per lavorare sul contesto più ampio dell’apprendimento automatico nella società e sul ruolo che Hugging Face svolge. Riteniamo che sia fondamentale che non siamo un team dedicato: affinché un’azienda possa prendere decisioni basate sui valori durante tutto il suo lavoro e i suoi processi, è necessaria una responsabilità e un impegno condivisi da tutte le parti coinvolte per riconoscere e apprendere gli aspetti etici del nostro lavoro.

- SetFit Apprendimento Efficienti a Pochi Esempi Senza Promemoria

- Come 🤗 Accelerate esegue modelli molto grandi grazie a PyTorch

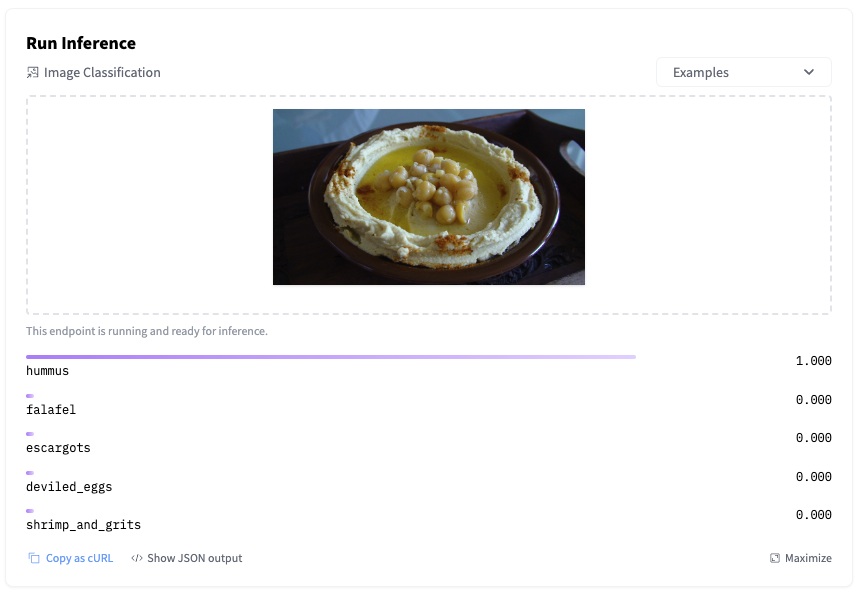

- Classificazione delle immagini con AutoTrain

Stiamo continuamente cercando pratiche e studi sul significato di un buon apprendimento automatico, cercando di fornire alcuni criteri che potrebbero definirlo. Essendo un processo in corso, ci impegniamo in questo sguardo alle diverse possibili future dell’IA, creando ciò che possiamo nel presente per arrivare a un punto che armonizzi i diversi valori che abbiamo come individui e la comunità più ampia dell’apprendimento automatico. Fondiamo questo approccio sui principi fondamentali di Hugging Face:

-

Cerchiamo di collaborare con la comunità open-source. Questo include fornire strumenti modernizzati per la documentazione e la valutazione, insieme a discussioni della comunità, Discord e supporto individuale per i contributori che desiderano condividere il loro lavoro in modo informato da diversi valori.

-

Cerchiamo di essere trasparenti riguardo al nostro pensiero e ai nostri processi mentre li sviluppiamo. Ciò include la condivisione di scritti sui valori specifici del progetto all’inizio di un progetto e del nostro pensiero sulla politica dell’IA. Trarremo anche vantaggio dai feedback della comunità su questo lavoro, come risorsa per apprendere di più su cosa fare.

-

Poniamo le basi della creazione di questi strumenti e artefatti nella responsabilità per gli impatti di ciò che facciamo ora e in futuro. Dare priorità a questo ha portato a progetti che rendono i sistemi di apprendimento automatico più verificabili e comprensibili – anche per persone con competenze al di fuori dell’apprendimento automatico – come il progetto di educazione e i nostri strumenti sperimentali per l’analisi dei dati dell’apprendimento automatico che non richiedono la programmazione.

Partendo da queste basi, stiamo adottando un approccio all’operazionalizzazione dei valori che ponga al centro la natura specifica del contesto dei nostri progetti e gli effetti prevedibili che possono avere. Pertanto, non offriamo qui un elenco globale di valori o principi; invece, continuiamo a condividere riflessioni specifiche del progetto, come questa newsletter, e condivideremo di più man mano che capiamo di più. Poiché riteniamo che la discussione della comunità sia fondamentale per identificare i diversi valori in gioco e chi ne è influenzato, abbiamo recentemente aperto l’opportunità per chiunque possa connettersi all’Hugging Face Hub online di fornire un feedback diretto su modelli, dati e Spazi. Oltre agli strumenti per la discussione aperta, abbiamo creato un Codice di Condotta e linee guida per i contenuti per aiutare a guidare le discussioni lungo dimensioni che riteniamo importanti per uno spazio comunitario inclusivo. Abbiamo sviluppato un Hub Privato per lo sviluppo sicuro di apprendimento automatico, una libreria per la valutazione per facilitare agli sviluppatori la valutazione rigorosa dei loro modelli, codice per analizzare i dati per distorsioni e bias e strumenti per il monitoraggio delle emissioni di carbonio durante l’addestramento di un modello. Stiamo inoltre sviluppando nuove licenze di intelligenza artificiale aperte e responsabili, una forma moderna di licenza che affronta direttamente i danni che i sistemi di intelligenza artificiale possono causare. E questa settimana, abbiamo reso possibile “segnalare” repository di modelli e Spazi per segnalare problemi etici e legali.

Nelle prossime settimane, stiamo preparando diversi articoli su valori, tensioni e operazionalizzazione dell’etica. Accogliamo (e vogliamo!) i vostri feedback su tutto il nostro lavoro e speriamo di continuare ad interagire con la comunità di AI attraverso un approccio tecnico e informato sui valori.

Grazie per la lettura! 🤗

~ Meg, a nome dei regolari dell’Etica e della Società